- Yapay zeka halüsinasyonu, modellerin güvenle yanlış veya uydurma bilgiler üretmesiyle ortaya çıkar; bunun nedeni genellikle düşük veri kalitesi, aşırı öğrenme ya da belirsiz istemlerdir.

- Halüsinasyonlar, gerçek hatalardan tamamen uydurma içeriklere kadar uzanır ve güveni zedeleyebilir, işletmelere milyarlarca dolara mal olabilir veya zararlı yanlış bilgilerin yayılmasına yol açabilir.

- Önlem olarak güvenilir yapay zeka platformları seçmek, bilgiye dayalı üretim (RAG) eklemek, net istemler hazırlamak ve insan denetimini dahil etmek önemlidir.

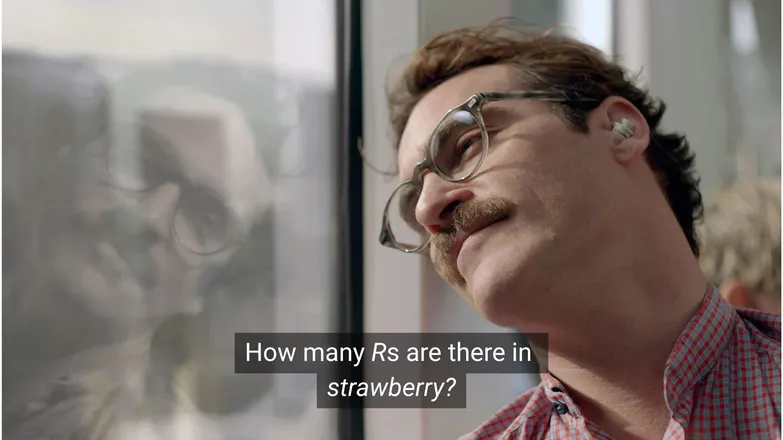

Sence Joaquin Phoenix, Scarlett Johansson’a R harfinden strawberry kelimesinde kaç tane olduğunu sorsaydı ona aşık olur muydu? LinkedIn’deyseniz, cevabın 3 olduğunu biliyorsunuzdur. (Ya da, okumayı biliyorsanız.)

Ama yapay zeka sohbet botları için işler her zaman bu kadar basit değil.

Muhtemelen yapay zeka halüsinasyonlarının saçmalığıyla dalga geçen insanları görmüşsünüzdür. Ve dürüst olmak gerekirse, neredeyse sonsuz bilgiye, insan benzeri akıl yürütme becerilerine ve yıldırım hızında görev yapabilen bir yapay zekanın anaokulu seviyesinde bir matematik sorusunda başarısız olması gerçekten de biraz tuhaf.

Ama bu eğlencenin arkasında daha ciddi — ve potansiyel olarak tehlikeli — bir gerçek yatıyor.

Bu yazıda, yapay zeka halüsinasyonlarından bahsedeceğim: nedir, neden olur, neden önemlidir ve nasıl önlenebilir?

Yapay zeka halüsinasyonu nedir?

Yapay zeka halüsinasyonu, bir yapay zeka modelinin yanlış, yanıltıcı veya tamamen uydurma bilgiler sunmasıdır. Bu yanlış bilgiler çoğu zaman inandırıcı görünebilir ve çoğu durumda fark edilmeyebilir.

LLM’lerin yaygın kullanımı nedeniyle, halüsinasyonlar genellikle üretken metin modelleri bağlamında anılır. Oysa gerçekte, Üretken Yapay Zeka uygulamalarının her türü için risk oluştururlar.

Yapay zekada halüsinasyona ne sebep olur?

Yapay zeka halüsinasyonu, modeller yanlış kalıplar öğrendiğinde ortaya çıkar.

Yapay zekada kalıplar, modelin tekil eğitim örneklerini kullanarak genelleme yapabilme yeteneğini ifade eder. Bu, bir metnin devamını oluşturmak için kelime dizileri ya da bir köpeğe karşılık gelen görüntü piksellerinin dağılımı olabilir.

LLM halüsinasyonunda, model bir dizi kelimeyi kullanıcının istemine en olası yanıt olarak seçer, ancak bu yanıt yanlıştır.

Bunun bir ya da birkaç nedeni olabilir:

Düşük Kaliteli Eğitim Verisi

ChatGPT ve benzeri LLM’ler çok büyük miktarda veriyle eğitilir. Ancak bu veriler, miktarı ne kadar fazla olursa olsun, şu nedenlerle kusurludur:

- Bazı konularda eksiklikler

- Gerçek dünyadaki önyargıların yansıtılması

- Kasıtlı yanlış bilgi veya işaretlenmemiş mizah/satira

- Dengesiz, yani “tek taraflı” veriler.

Modelin, tüm Yunan tanrıları hakkında bilgiyle eğitildiği ama bir tanesi hariç tutulduğu bir senaryoyu düşünün.

Modelin Yunan mitolojisiyle ilgili konular — aşk, etik, ihanet — arasında istatistiksel bağlantılar kurabilmesi, istatistiksel modeline göre “muhtemel” gördüğü uydurma bir mitoloji oluşturmasına yol açabilir.

Bu durum, çoğu kadın karakter isteminde aşırı cinselleştirilmiş görsellerin üretildiği görüntü oluşturma alanında da görülür. Belirli bir tasvir türüne olan önyargı, üretilen görsellerin şekillenmesini etkiler.

Strawberry kelimesinin yazılışı, muhtemelen eğitim verilerinde çift R harfiyle ilgili tartışmalarda yer almıştır; bu, ana dili İngilizce olmayanlar için bilinen bir zorluktur. Bu durumda, 2 sayısı veya “çift” kelimesi muhtemelen kelimenin yazılışıyla bağlantılı olarak geçmiştir.

Öte yandan, verilerde 3 tane R olduğundan bahsedilmesi pek olası değildir.

Çıktı saçma çünkü istem de saçma: Birisi bir kelimeyi yazıp sonra nasıl yazıldığını neden sorsun?

Model Mimarisi ve Üretim Yöntemi

Modeller, son derece karmaşık sinir ağı mimarilerinden oluşur. Küçük farklılıklar, modellerin eğitim verisi ve istemlerle nasıl etkileşime girdiğini etkiler. Bir modelin halüsinasyonu azaltma kapasitesi, kademeli geliştirme, yoğun araştırma ve test ile artırılabilir.

Bunun üzerine, üretimin nasıl uygulandığı da önemlidir. Kelime kelime (aslında kelime-parçası) olarak, modeller bir sonraki en olası kelimeyi tahmin eder. Yani:

“The quick brown fox jumps over the lazy ___.”

Bir sonraki kelimenin “dog” olma olasılığı en yüksektir. Ama başka kelimeler de mümkündür. Sadece en olası kelimeyi seçmek, sıkıcı ve tahmin edilebilir sonuçlar doğurur.

Bu yüzden, yanıtları hem ilginç hem de tutarlı tutmak için yaratıcı örnekleme yöntemleri kullanılır. Ancak bu süreçte, doğruluk bazen gözden kaçabilir.

Aşırı Öğrenme (Overfitting)

Aşırı öğrenme, modelin veriye o kadar sıkı uyum sağlamasıdır ki, yeni girdilere genelleyemez.

Yani, ben bir model olsaydım (annemin dediği gibi), köpekleri şöyle tanıyorsam iyi eğitilmiş olurdum:

Tüylü, sarkık kulaklı, oyuncu ve küçük kahverengi bir buruna sahip.

Ama sadece şunları tanıyorsam aşırı öğrenmiş olurdum:

Çenesinin altında kahverengi bir nokta olan, “Frank” ismine cevap veren ve iyi Nike ayakkabılarımı tamamen kemiren.

LLM bağlamında, bu genellikle eğitim verisinde gördüğü bilgileri tekrar etmek ve bilmediği yerde yanıt vermemek yerine bunları aynen aktarmak şeklinde görülür.

Bir sohbet botuna bir şirketin iade politikasını sorduğunuzu düşünün. Bilmiyorsa, bunu belirtmelidir. Ama aşırı öğrenmişse, benzer bir şirketin politikasını döndürebilir.

Kötü İstemler

Şirketler, yapay zekanın girdileri kadar iyi olduğunu bilerek istem mühendisliği sertifikaları veriyor.

İyi hazırlanmış bir istem, açıkça ifade edilir, niş terimlerden kaçınır ve gerekli tüm bağlamı sunar.

Çünkü halüsinasyon, çoğu zaman düşük olasılıklı çıktılar arasında ortaya çıkar.

Diyelim ki “shark girl’ün konusu nedir?” diye sordunuz. Bir insan “hmm, shark girl.” diye düşünür. İstatistiksel olarak olasılıklar şunlardır:

- The Adventures of Sharkboy and Lavagirl – 2005’te çıkan, benzer isimli popüler bir çocuk filmi.

- 2024 yapımı bir korku/gerilim filmi olan Shark Girl – daha az bilinen ama daha yeni ve doğru.

- Bu yılın başında çıkan aynı isimli bir çocuk kitabı – model bunu indekslemiş de olabilir, olmayabilir de.

Bunların hiçbiri açık bir seçenek değildir; bu da “daha düz” bir olasılık dağılımı ile tek bir konuya veya anlatıya odaklanmayı zorlaştırır. Daha etkili bir istem, kullanıcının hangi örneği kastettiğini açıkça belirtmelidir.

Bu belirsizlik ve dolaylı alaka karışımı, köpekbalığıyla ilgili uydurma bir hikaye özeti gibi bir yanıt üretebilir.

Halüsinasyon riskini azaltmak, belirsizliği azaltmakla ilgilidir.

Yapay Zeka Halüsinasyon Türleri

Şimdiye kadar halüsinasyonlardan genel olarak bahsettim. Gerçekte ise, bu konu yapay zekanın neredeyse tüm alanlarına dokunuyor. Ancak açıklık açısından, farklı kategorilere ayırmak en iyisidir.

Olgu Hataları

Burada çilek örneği devreye giriyor. Genellikle doğru olan ifadelerdeki detaylarda hatalar olur. Bunlar, bir olayın yılı, bir ülkenin başkenti veya bir istatistiğin sayısı gibi şeyler olabilir.

Genel olarak iyi bir yanıttaki küçük detaylar, özellikle insanların genellikle hatırlamadığı tam sayılar gibi konularda, oldukça yanıltıcı olabilir.

Uydurma İçerik

2023 yılında, Google’ın Bard’ı yanlış bir şekilde James Webb teleskobunun ötegezegenlerin ilk fotoğraflarını çektiğini iddia etti. Bu teknik bir hata değil, tamamen yanlış bir bilgiydi.

Bunlar yukarıdaki gibi iddialı yanlışlar olabileceği gibi, çoğunlukla bir yere çıkmayan URL’ler ya da uydurma kod kütüphaneleri ve fonksiyonlar şeklinde karşımıza çıkar.

Gerçek hatalar ile tamamen uydurma içerikler arasındaki çizginin her zaman net olmadığını belirtmekte fayda var.

Diyelim ki bir araştırmacıdan bahsediyoruz. Onun bir makalesini kaynak gösterip yılı yanlış verirsek bu bir bilgi hatasıdır. Peki ya ismini yanlış yazarsak? Ya da hem ismini hem de yılını yanlış verirsek?

Yanlış Bilgi

Bu, önceki iki kategoriye de girebilir, ancak kaynağın daha şeffaf olduğu yanlış bilgiler için kullanılır.

Google AI’ın tutkal sürülmüş pizza ve taş yeme önerisi bunun iyi bir örneği; kaynak materyal açıkça mizahi ve zararsız – The Onion tarafından yazılmış Reddit yorumları, fakat modelin eğitimi bunu hesaba katmamıştı.

AI Halüsinasyonlarının Riskleri

1. Güven Kaybı

Görevlerimizi AI’a devretmenin rahatlığını seviyoruz, ancak bu güvenimizi kaybetmek pahasına olmamalı.

Cursor AI’ın yakın zamanda yaşadığı bir sorun – müşteri hizmetleri botunun kısıtlayıcı bir politika uydurması – birçok kullanıcının aboneliğini iptal etmesine ve güvenilirliğini sorgulamasına yol açtı.

2. Maliyet

AI, birçok işletmede ön plana çıktı ve bu olumlu bir gelişme olsa da, yapılacak bir hata pahalıya mal olabilir.

Google’ın James Webb halüsinasyonu, Alphabet’in hisselerinde birkaç saat içinde 100 milyar dolarlık bir düşüşe neden oldu. Üstelik bu, modellerin yeniden eğitilmesinin maliyeti hariç.

3. Zararlı Yanlış Bilgi

Tutkal sürülmüş pizza saçmalığına gülebiliriz, peki ya yanlış tıbbi dozajlar?

Uyarı dolu küçük yazıları okumak yerine AI’dan hızlıca cevap almayı ilk tercih eden ben olurum. Ama ya cevap yanlışsa? Muhtemelen tüm tıbbi durumları hesaba katmayacaktır.

3. Güvenlik ve Kötü Amaçlı Yazılım

Daha önce de belirtildiği gibi, AI sıkça uydurma kod kütüphaneleri isimleri üretir. Var olmayan bir kütüphaneyi yüklemeye çalışırsanız, hiçbir şey olmaz.

Şimdi bir hacker’ın, kötü amaçlı yazılımı koda gömüp, sıkça uydurulan bir kütüphane adıyla yüklediğini düşünün. Kütüphaneyi yüklersiniz ve 💨hop💨: hacklendiniz.

Bu gerçekten var ve adına slopsquatting deniyor.

İsmi kötü olsa da, ne yüklediğiniz konusunda eleştirel olmak ve kulağa garip gelen kütüphane isimlerini iki kez kontrol etmekte fayda var.

AI Halüsinasyonlarını Önleme Adımları

Modelleri siz eğitmiyorsanız, veri ve mimari tarafında yapabileceğiniz çok az şey var.

İyi haber şu ki, yine de alabileceğiniz önlemler var ve bunlar, halüsinasyonsuz bir AI sunmak için büyük fark yaratabilir.

Güvenebileceğiniz Bir Model ve Platform Seçin

Yalnız değilsiniz. AI şirketleri için güveni korumak çok önemli ve bu da halüsinasyonlara yer olmaması anlamına gelir.

AI ile ne yapıyor olursanız olun, genellikle birkaç seçeneğiniz olur ve iyi bir AI platformu bunu erişilebilir kılar. Bu platformlar, halüsinasyonları nasıl önlediklerini şeffaf şekilde açıklamalı.

RAG (Retrieval-Augmented Generation) Kullanın

Modelin yalnızca kendi bilgisine dayanmasını istemeyin. Modelinizi RAG ile donatmak, bilginin mevcut olduğunu ve nerede bulunacağını netleştirir.

AI’ı, etkili RAG nasıl uygulanır konusunda basit talimatlar sunan bir platformda çalıştırmak en iyisidir.

Ayrıntılı Talimatlar Ekleyin

Bunu bir kez değil, bin kez duymuşsunuzdur: ne girerseniz onu alırsınız.

“Kullanıcının sorusunu yanıtla” demek başarıyı garanti etmez. Ancak şöyle bir şey:

# Instructions

Please refer exclusively to the FAQ document. If the answer does not appear there:

* Politely inform the user that the information is unavailable.

* Offer to escalate the conversation to a human agent.ajanınızı kontrol altında tutar. Net ve sağlam yönlendirmeler, başıboş bir ajana karşı en iyi savunmanızdır.

İnsan Doğrulaması

Gelişme durumunda, AI’nın eksiklerini inceleyip değerlendirecek ve düzeltecek birinin hazır olması önemlidir.

Görüşmeleri yükseltme veya sonradan doğrulama imkanı, neyin işe yaradığını ve neyin halüsinasyon riski taşıdığını anlamanızı sağlar. İnsan-döngüde – AI tabanlı iş akışlarında insan denetimi – burada olmazsa olmaz.

Bugün Halüsinasyonsuz AI Kullanın

AI’ın güvenilirliği konusundaki belirsizlik, işletmelerin dijital dönüşümden uzak durmasına neden olabilir.

Botpress’in RAG yetenekleri, insan-döngüde entegrasyonu ve kapsamlı güvenlik sistemleri, AI’ı güvenli ve güvenilir kılar. Ajanınız sizin için çalışır, tersi değil.

Hemen oluşturmaya başlayın. Ücretsiz.

Sıkça Sorulan Sorular

1. Bir konuda önceden bilgim yoksa, bir AI yanıtının halüsinasyon olup olmadığını nasıl anlayabilirim?

Bir AI yanıtının halüsinasyon olup olmadığını anlamak için, aşırı spesifik iddialar, aşırı kendinden emin bir dil veya bağımsız olarak doğrulanamayan isimler, istatistikler ya da kaynaklar gibi işaretlere bakın. Emin değilseniz, AI’dan kaynak göstermesini isteyin veya güvenilir dış kaynaklarla karşılaştırın.

2. Büyük dil modellerinde (LLM’lerde) AI halüsinasyonları ne kadar yaygın?

AI halüsinasyonları büyük dil modellerinde yaygındır, çünkü bu modeller metni olasılıklara göre üretir, gerçekleri doğrulamaz.

3. Halüsinasyonlar, metin tabanlı olmayan AI modellerinde (ör. görsel üreteçler) de olabilir mi?

Evet, halüsinasyonlar görsel üretim modellerinde de görülür; genellikle çıktıda gerçekçi olmayan veya anlamsız unsurlar – fazladan uzuvlar ya da yanlış kültürel temsiller gibi – olarak ortaya çıkar. Bunlar, eğitim verisindeki önyargı veya eksikliklerden kaynaklanır.

4. Eğitim verisindeki önyargılar nedeniyle bazı dillerde veya kültürlerde halüsinasyonlar daha mı yaygın?

Halüsinasyonlar, az temsil edilen dillerde veya Batı dışı kültürel bağlamlarda daha yaygındır; çünkü çoğu LLM, öncelikle İngilizce ve Batı merkezli verilerle eğitilir ve bu da kültürel açıdan daha az hassas yanıtlar üretir.

5. Hangi sektörler AI halüsinasyonlarının sonuçlarından en çok etkilenme riski taşır?

Sağlık, finans, hukuk ve müşteri hizmetleri gibi sektörler, AI halüsinasyonlarından en çok etkilenen alanlardır; çünkü bu alanlarda yanlış çıktılar, uyum ihlallerine, maddi kayba, hukuki hatalara veya kullanıcı güveni ve marka itibarının zedelenmesine yol açabilir.

.webp)