- Ảo giác AI xảy ra khi các mô hình tự tin tạo ra thông tin sai lệch hoặc bịa đặt, nguyên nhân do chất lượng dữ liệu kém, quá khớp hoặc câu lệnh không rõ ràng.

- Ảo giác có thể từ lỗi thực tế đến nội dung bịa đặt và có thể làm mất lòng tin, gây thiệt hại hàng tỷ đô la cho doanh nghiệp hoặc lan truyền thông tin sai lệch nguy hại.

- Các bước phòng tránh chính gồm chọn nền tảng AI đáng tin cậy, bổ sung truy xuất thông tin (RAG), xây dựng câu lệnh chính xác và có sự giám sát của con người.

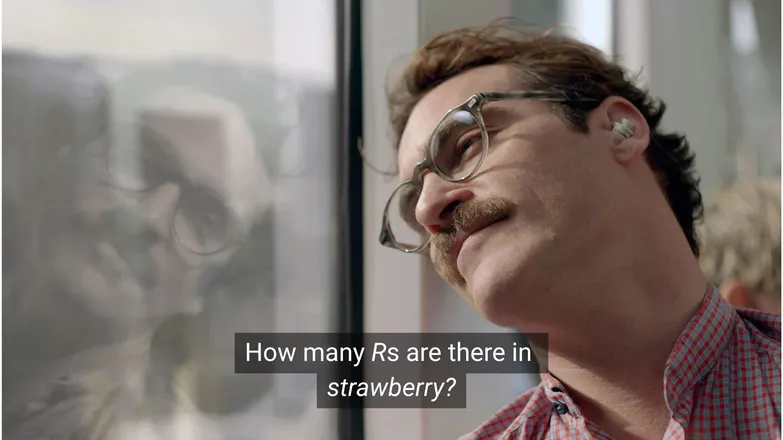

Bạn nghĩ Joaquin Phoenix có phải đã yêu Scarlett Johansson nếu anh ấy hỏi cô ấy có bao nhiêu chữ R trong từ strawberry không? Nếu bạn dùng LinkedIn, bạn sẽ biết đáp án là 3. (Hoặc, bạn biết đấy, nếu bạn biết đọc.)

Nhưng với chatbot AI, mọi thứ không phải lúc nào cũng đơn giản như vậy.

Có lẽ bạn đã thấy mọi người chế giễu sự vô lý của các ảo giác AI. Thực ra, một mô hình AI với kiến thức tưởng như vô tận, khả năng suy luận như con người và tốc độ xử lý cực nhanh lại thất bại ở một bài toán mẫu giáo thì đúng là... khá buồn cười.

Nhưng đằng sau những trò đùa đó là một thực tế nghiêm trọng — và có thể nguy hiểm.

Trong bài viết này, tôi sẽ nói về ảo giác AI – nó là gì, nguyên nhân, tại sao nó quan trọng và các biện pháp phòng tránh.

Ảo giác AI là gì?

Ảo giác AI là khi một mô hình AI đưa ra thông tin không chính xác, gây hiểu lầm hoặc hoàn toàn bịa đặt. Thông tin sai này có thể nghe hợp lý và trong nhiều trường hợp, không bị phát hiện.

Do LLM được sử dụng rộng rãi, ảo giác thường được nhắc đến trong bối cảnh các mô hình sinh văn bản. Thực tế, chúng có thể xuất hiện ở bất kỳ ứng dụng Generative AI nào.

Nguyên nhân gây ra ảo giác trong AI là gì?

Ảo giác AI xảy ra khi mô hình học các mẫu sai.

Mẫu trong AI là khả năng sử dụng các ví dụ huấn luyện riêng lẻ để khái quát hóa trên dữ liệu chưa từng thấy. Điều này có thể là chuỗi từ để tạo tiếp nối văn bản, hoặc phân bố điểm ảnh tương ứng với một con chó.

Trong trường hợp ảo giác LLM, mô hình cho rằng một chuỗi từ là phần tiếp theo hợp lý nhất cho câu hỏi của người dùng, dù nó sai.

Điều này có thể do một hoặc nhiều nguyên nhân sau:

Dữ liệu huấn luyện chất lượng thấp

ChatGPT và các LLM tương tự được huấn luyện trên lượng lớn dữ liệu. Tuy nhiên, dữ liệu này vẫn không hoàn hảo do:

- Thiếu sót ở một số chủ đề

- Phản ánh định kiến ngoài đời thực

- Thông tin sai lệch cố ý hoặc châm biếm không được đánh dấu

- Thiên lệch, tức dữ liệu mất cân bằng hoặc "lệch hẳn" về một phía.

Hãy tưởng tượng mô hình được huấn luyện về tất cả các vị thần Hy Lạp trừ một vị.

Khả năng liên kết thống kê giữa các chủ đề kiểu thần thoại Hy Lạp – tình yêu, đạo đức, phản bội – có thể khiến nó tự tạo ra một thần thoại mới mà nó cho là "hợp lý" dựa trên mô hình thống kê của mình.

Điều này cũng dễ thấy ở sinh ảnh, khi hầu hết các câu lệnh về nhân vật nữ đều tạo ra hình ảnh gợi cảm quá mức. Thiên lệch về một kiểu mô tả nhất định ảnh hưởng đến loại hình ảnh được tạo ra.

Cách viết từ strawberry có thể đã xuất hiện trong dữ liệu huấn luyện khi bàn về chữ R kép, một điểm khó với người học tiếng Anh. Trong trường hợp này, số 2 hoặc từ “double” có thể đã xuất hiện liên quan đến cách đánh vần từ này.

Ngược lại, dữ liệu khó có thể đề cập đến việc từ này có 3 chữ R.

Kết quả trở nên vô lý vì câu hỏi là: trong hoàn cảnh nào ai đó lại viết một từ rồi hỏi cách đánh vần nó?

Kiến trúc mô hình và phương pháp sinh

Các mô hình được xây dựng từ các kiến trúc mạng nơ-ron cực kỳ phức tạp. Chỉ một thay đổi nhỏ cũng ảnh hưởng đến cách mô hình tương tác với dữ liệu huấn luyện và câu lệnh đầu vào. Khả năng giảm ảo giác của mô hình được cải thiện dần nhờ nghiên cứu và kiểm thử nghiêm ngặt.

Ngoài ra còn là cách sinh văn bản. Từng từ một (thực ra là word-piece), mô hình dự đoán từ tiếp theo có khả năng cao nhất. Ví dụ:

“The quick brown fox jumps over the lazy ___.”

Mô hình sẽ chọn từ tiếp theo có khả năng cao nhất là “dog”. Nhưng các từ khác cũng có thể xuất hiện. Nếu chỉ dựa vào xác suất cao nhất cho mỗi từ, kết quả sẽ nhàm chán và dễ đoán.

Vì vậy, cần dùng các phương pháp lấy mẫu sáng tạo để giữ cho phản hồi vừa thú vị vừa hợp lý. Tuy nhiên, đôi khi tính chính xác lại bị bỏ qua.

Quá khớp

Quá khớp là khi mô hình được huấn luyện sát với dữ liệu đến mức không thể khái quát cho dữ liệu mới.

Nếu tôi là một mô hình (như mẹ tôi vẫn nói), tôi sẽ được huấn luyện đúng nếu nhận biết chó qua:

Lông xù, tai cụp, nghịch ngợm và mũi nâu nhỏ.

Nhưng tôi sẽ bị quá khớp nếu chỉ nhận ra chó là:

Có một chấm nâu dưới cằm, tên là “Frank”, và đã nhai nát đôi giày Nike xịn của tôi.

Với LLM, điều này thường thể hiện ở việc lặp lại thông tin đã thấy trong dữ liệu huấn luyện, thay vì dừng lại khi không biết câu trả lời.

Ví dụ bạn hỏi chatbot về chính sách đổi trả của một công ty. Nếu không biết, nó nên thông báo cho bạn. Nhưng nếu bị quá khớp, nó có thể trả lời bằng chính sách của một công ty tương tự.

Câu lệnh kém chất lượng

Nhiều công ty đang cấp chứng chỉ về kỹ thuật xây dựng câu lệnh vì AI chỉ tốt khi đầu vào tốt.

Một câu lệnh tốt cần rõ ràng, tránh thuật ngữ chuyên ngành và cung cấp đầy đủ ngữ cảnh cần thiết.

Bởi vì ảo giác thường xảy ra ở ranh giới của nhiều đầu ra xác suất thấp.

Ví dụ bạn hỏi “cốt truyện của shark girl là gì?” Người bình thường sẽ nghĩ “hả, shark girl.” Trong thế giới thống kê, các khả năng là:

- The Adventures of Sharkboy and Lavagirl – phim thiếu nhi khá nổi tiếng năm 2005 có tên gần giống.

- Một phim kinh dị/giật gân năm 2024 tên Shark Girl – ít nổi tiếng hơn nhưng mới và đúng tên hơn.

- Một cuốn sách thiếu nhi cùng tên xuất bản đầu năm nay – mà mô hình có thể đã hoặc chưa biết đến.

Không có lựa chọn nào là rõ ràng, dẫn đến phân bố xác suất “phẳng” hơn và mô hình không nghiêng hẳn về chủ đề nào. Một câu lệnh hiệu quả hơn sẽ cung cấp ngữ cảnh, ví dụ chỉ rõ người dùng hỏi về trường hợp nào.

Sự mơ hồ và liên quan lỏng lẻo này có thể tạo ra một phản hồi cũng như vậy: một cốt truyện chung chung về cá mập được bịa ra.

Giảm khả năng gặp ảo giác là giảm sự bất định.

Các loại ảo giác AI

Tôi vừa nói về ảo giác một cách tổng quát. Thực tế, nó ảnh hưởng đến hầu hết các khía cạnh của AI. Tuy nhiên, để rõ ràng, tốt nhất nên phân loại chúng.

Lỗi thực tế

Đây là trường hợp ví dụ về từ strawberry. Có lỗi ở chi tiết của những phát biểu vốn đúng. Ví dụ như năm diễn ra một sự kiện, thủ đô của một quốc gia, hoặc số liệu thống kê.

Những chi tiết nhỏ trong một câu trả lời nhìn chung tốt có thể rất nguy hiểm, nhất là với các thông tin con người thường không nhớ, như số liệu chính xác.

Nội dung bịa đặt

Năm 2023, Bard của Google đã sai sự thật khi khẳng định kính viễn vọng James Webb được dùng để chụp những bức ảnh đầu tiên về ngoại hành tinh. Đây không chỉ là vấn đề sai sót kỹ thuật – mà hoàn toàn là thông tin sai.

Những trường hợp này có thể là các tuyên bố táo bạo như trên, nhưng thường xuất hiện dưới dạng các URL không tồn tại, hoặc tên thư viện và hàm lập trình được bịa ra.

Cũng cần lưu ý rằng ranh giới giữa lỗi thực tế và nội dung bịa đặt không phải lúc nào cũng rõ ràng.

Giả sử chúng ta đang nói về một nhà nghiên cứu. Nếu trích dẫn bài báo của họ nhưng ghi sai năm thì đó là lỗi thực tế. Nếu ghi sai tên thì sao? Còn nếu sai cả tên và năm thì thế nào?

Thông tin sai lệch

Điều này có thể thuộc một trong hai loại trên, nhưng đề cập đến thông tin sai mà nguồn gốc lại khá rõ ràng.

AI của Google nổi tiếng với việc gợi ý pizza dán keo và ăn đá là ví dụ điển hình; nguồn gốc rõ ràng là hài hước và vô hại – bình luận Reddit do The Onion viết, nhưng mô hình lại chưa được huấn luyện để nhận biết điều đó.

Rủi ro của ảo giác AI

1. Mất niềm tin

Chúng ta thích giao việc cho AI, nhưng không phải đánh đổi bằng sự tin tưởng.

Sự cố gần đây của Cursor AI – chatbot hỗ trợ khách hàng tự bịa ra chính sách hạn chế – đã khiến nhiều người dùng hủy đăng ký, nghi ngờ về độ tin cậy của nó.

2. Chi phí

AI đang giữ vai trò trung tâm ở nhiều doanh nghiệp, và dù đó là điều tốt, một sai sót cũng có thể gây thiệt hại lớn.

Sự cố ảo giác James Webb của Google đã khiến cổ phiếu Alphabet mất 100 tỷ đô chỉ trong vài giờ. Đó là chưa kể chi phí huấn luyện lại mô hình.

3. Thông tin sai lệch gây hại

Chúng ta có thể cười về chuyện pizza dán keo, nhưng còn liều lượng thuốc sai lệch thì sao?

Tôi sẵn sàng đổi việc đọc những cảnh báo dài dòng lấy câu trả lời nhanh từ AI. Nhưng nếu nó sai thì sao? Gần như chắc chắn AI sẽ không tính hết mọi tình trạng y tế có thể xảy ra.

4. An ninh và phần mềm độc hại

Như đã đề cập, AI thường bịa ra tên thư viện lập trình. Khi bạn thử cài một thư viện không tồn tại, sẽ không có gì xảy ra.

Nhưng hãy tưởng tượng hacker nhúng mã độc vào một thư viện và tải lên với tên giống như những thư viện thường bị AI bịa ra. Bạn cài thư viện đó, và 💨biến mất💨: bạn đã bị hack.

Điều này đã tồn tại, và nó được gọi là slopsquatting.

Bỏ qua cái tên khó nghe, bạn nên luôn cẩn trọng với những gì mình cài đặt, và kiểm tra kỹ các tên thư viện lạ.

Các bước phòng tránh ảo giác AI

Nếu bạn không trực tiếp huấn luyện mô hình, bạn khó can thiệp vào dữ liệu và kiến trúc.

Tin tốt là bạn vẫn có thể thực hiện một số biện pháp phòng ngừa, và chúng có thể tạo ra sự khác biệt lớn để đảm bảo AI không bị ảo giác.

Chọn mô hình và nền tảng đáng tin cậy

Bạn không đơn độc. Các công ty AI rất quan tâm đến việc duy trì niềm tin, đồng nghĩa với việc không để xảy ra ảo giác.

Tùy vào mục đích sử dụng AI, bạn gần như luôn có vài lựa chọn, và một nền tảng AI tốt sẽ giúp bạn dễ dàng tiếp cận. Các nền tảng này nên minh bạch về cách họ giảm thiểu ảo giác.

Sử dụng RAG (Tạo sinh tăng cường truy xuất)

Đừng để mô hình chỉ dựa vào kiến thức của nó. Trang bị cho mô hình RAG giúp thông tin rõ ràng và biết được nguồn gốc.

Tốt nhất nên sử dụng AI trên nền tảng có hướng dẫn đơn giản về cách triển khai RAG hiệu quả.

Thêm hướng dẫn chi tiết

Nếu bạn từng nghe một lần thì chắc đã nghe cả ngàn lần: đầu vào rác thì đầu ra cũng rác.

“Trả lời câu hỏi của người dùng” không đảm bảo thành công. Tuy nhiên, một hướng dẫn như:

# Instructions

Please refer exclusively to the FAQ document. If the answer does not appear there:

* Politely inform the user that the information is unavailable.

* Offer to escalate the conversation to a human agent.sẽ giúp kiểm soát tác vụ của agent. Đặt câu hỏi rõ ràng với giới hạn chặt chẽ là cách tốt nhất để tránh agent hoạt động sai lệch.

Xác minh bởi con người

Về vấn đề kiểm tra, nên có người sẵn sàng xem xét, đánh giá và khắc phục các thiếu sót của AI.

Khả năng chuyển tiếp hoặc xác minh lại các cuộc hội thoại giúp bạn nhận ra điều gì hiệu quả và điều gì có nguy cơ gây ra ảo giác. Human-in-the-loop – giám sát của con người trong quy trình AI – là bắt buộc ở đây.

Sử dụng AI không ảo giác ngay hôm nay

Sự không chắc chắn về độ tin cậy của AI có thể khiến doanh nghiệp ngần ngại chuyển đổi số.

Khả năng RAG của Botpress, tích hợp human-in-the-loop và hệ thống bảo mật toàn diện giúp AI an toàn và đáng tin cậy. Agent của bạn làm việc cho bạn, không phải ngược lại.

Bắt đầu xây dựng ngay hôm nay. Miễn phí.

Câu hỏi thường gặp

1. Làm sao tôi biết phản hồi của AI có phải là ảo giác không nếu tôi không biết trước về chủ đề đó?

Để nhận biết phản hồi của AI có phải là ảo giác khi bạn không biết trước chủ đề, hãy chú ý các dấu hiệu như tuyên bố quá cụ thể, ngôn ngữ quá tự tin, hoặc tên, số liệu, trích dẫn không thể kiểm chứng độc lập. Khi không chắc chắn, hãy yêu cầu AI trích dẫn nguồn hoặc kiểm tra chéo với các nguồn đáng tin cậy bên ngoài.

2. Ảo giác AI có phổ biến trong các mô hình ngôn ngữ lớn (LLM) không?

Ảo giác AI rất phổ biến trong các mô hình ngôn ngữ lớn vì chúng tạo ra văn bản dựa trên xác suất, không phải xác minh thực tế. Ngay cả các mô hình tiên tiến như GPT-4o và Claude 3.5 cũng có thể tạo ra kết quả không chính xác, đặc biệt khi được hỏi về chủ đề hiếm hoặc trong bối cảnh ít thông tin.

3. Ảo giác có xảy ra ở các mô hình AI không dựa trên văn bản như tạo ảnh không?

Có, ảo giác cũng xuất hiện ở các mô hình tạo ảnh, thường là các yếu tố phi thực tế hoặc vô lý trong kết quả – như thừa chi, hoặc thể hiện sai văn hóa – do thiên lệch hoặc thiếu hụt dữ liệu huấn luyện.

4. Ảo giác có phổ biến hơn ở một số ngôn ngữ hoặc văn hóa do thiên lệch dữ liệu huấn luyện không?

Ảo giác phổ biến hơn ở các ngôn ngữ ít được đại diện hoặc bối cảnh văn hóa ngoài phương Tây vì hầu hết LLM được huấn luyện chủ yếu bằng tiếng Anh và dữ liệu thiên về phương Tây, dẫn đến phản hồi kém phù hợp về mặt văn hóa.

5. Ngành nào chịu rủi ro lớn nhất từ hậu quả của ảo giác AI?

Các ngành như y tế, tài chính, pháp lý và dịch vụ khách hàng chịu rủi ro lớn nhất từ ảo giác AI, vì kết quả không chính xác trong các lĩnh vực này có thể dẫn đến vi phạm quy định, thiệt hại tài chính, sai sót pháp lý hoặc mất niềm tin của người dùng và uy tín thương hiệu.

.webp)