- L’hallucination dell’AI si verifica quando i modelli producono con sicurezza informazioni false o inventate, a causa di scarsa qualità dei dati, overfitting o prompt ambigui.

- Le allucinazioni vanno dagli errori fattuali ai contenuti inventati e possono danneggiare la fiducia, costare miliardi alle aziende o diffondere disinformazione.

- Le principali misure preventive includono la scelta di piattaforme AI affidabili, l’aggiunta della generazione aumentata dal recupero (RAG), la creazione di prompt precisi e la supervisione umana.

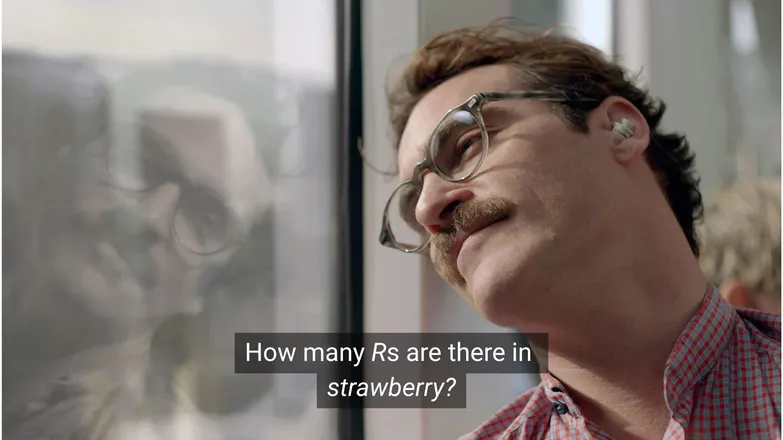

Pensi che Joaquin Phoenix si sarebbe innamorato di Scarlett Johansson se le avesse chiesto quante R ci sono in strawberry? Se usi LinkedIn, sai che la risposta è 3. (O, semplicemente, se sai leggere.)

Ma per gli AI chatbots, non è sempre così semplice.

Probabilmente hai visto persone scherzare sull’assurdità delle allucinazioni dell’IA. E in effetti, un modello IA apparentemente onnisciente, con capacità di ragionamento umano e rapidità nell’esecuzione dei compiti, che sbaglia un problema di matematica da scuola materna è, beh, piuttosto assurdo.

Ma dietro il divertimento e i giochi si nasconde una realtà più seria — e potenzialmente insidiosa.

In questo articolo parlerò delle allucinazioni AI: cosa sono, cosa le causa, perché sono importanti e quali misure puoi adottare per prevenirle.

Cos'è un'allucinazione AI?

L’hallucination AI si verifica quando un modello di intelligenza artificiale presenta informazioni inesatte, fuorvianti o completamente inventate. Queste informazioni false possono sembrare plausibili e, in molti casi, passare inosservate.

A causa della diffusione degli LLM, le allucinazioni vengono spesso menzionate nel contesto dei modelli generativi di testo. In realtà, rappresentano un rischio per qualsiasi applicazione di IA generativa.

Cosa causa le allucinazioni nell’AI?

L’hallucination dell’AI si verifica quando i modelli apprendono schemi errati.

Pattern, nel contesto dell’AI, si riferisce alla capacità di utilizzare esempi di addestramento individuali per generalizzare su dati mai visti. Può trattarsi di una sequenza di parole per formare la continuazione di un testo, oppure della distribuzione dei pixel di un’immagine che corrispondono a un cane.

Nel caso di allucinazione di un LLM, il modello considera una sequenza di parole come la più probabile risposta al prompt dell’utente, anche se è falsa.

Questo potrebbe essere dovuto a una o più delle seguenti ragioni:

Dati di addestramento di bassa qualità

ChatGPT e LLM simili sono addestrati su enormi quantità di dati. Questi dati, per quanto abbondanti, sono imperfetti a causa di:

- Lacune su alcuni argomenti

- Riflettere i pregiudizi del mondo reale

- Disinformazione intenzionale o satira non segnalata

- Distorto, come in dati sbilanciati o “squilibrati”.

Considera uno scenario in cui il modello è stato addestrato su informazioni riguardanti tutti i dèi greci tranne uno.

La sua capacità di collegare statisticamente argomenti simili a quelli della mitologia greca – amore, etica, tradimento – potrebbe portarlo a mettere insieme una mitologia inventata che considera “probabile” secondo il suo modello statistico.

Questo è evidente anche nella generazione di immagini, dove la maggior parte dei prompt su soggetti femminili produce immagini ipersessualizzate. Il pregiudizio verso un certo tipo di rappresentazione influenza le immagini generate.

La scrittura di strawberry è probabilmente apparsa nei dati di addestramento in contesti che parlano del doppio R, un noto ostacolo per chi non è madrelingua inglese. In questo caso, il numero 2 o la parola “double” sono probabilmente emersi in relazione all’ortografia della parola.

D'altra parte, è improbabile che nei dati si menzioni che abbia 3 R.

Il risultato è assurdo perché il prompt è: in quale circostanza qualcuno scriverebbe una parola e poi chiederebbe come si scrive?

Architettura del modello e metodo di generazione

I modelli sono costruiti su architetture di reti neurali estremamente complesse. Piccole variazioni influenzano il modo in cui i modelli interagiscono con i loro dati di addestramento e i prompt in ingresso. La capacità di un modello di ridurre le allucinazioni può migliorare progressivamente grazie a ricerca e test rigorosi.

Inoltre, conta anche come viene generato il testo. Parola per parola (in realtà word-piece), i modelli prevedono la parola più probabile che segue. Quindi:

“La volpe marrone salta sopra il pigro ___.”

Determinerà che la parola successiva più probabile sia “cane”. Ma sono possibili anche altre parole. E generare testo scegliendo solo la parola più probabile porta a risultati poco interessanti e prevedibili.

Questo significa che bisogna usare metodi di campionamento creativi per mantenere le risposte interessanti ma coerenti. Così facendo, a volte la precisione dei fatti può risentirne.

Overfitting

L'overfitting si verifica quando il modello viene addestrato a prevedere i dati in modo così preciso da non riuscire più a generalizzare su nuovi input.

Quindi, se fossi un modello (come dice mia madre che dovrei essere), sarei ben addestrato se riconoscessi i cani come:

Pelosetto, con orecchie cadenti, giocherellone e un piccolo naso marrone a bottone.

Ma sarei troppo specializzato se li riconoscessi solo come:

Ha un punto marrone sotto il mento, risponde al nome “Frank” e ha completamente rosicchiato il mio buon paio di Nike.

Nel contesto di un LLM, di solito significa ripetere informazioni già viste nei dati di addestramento, invece di ammettere quando non conosce la risposta.

Supponiamo che tu chieda a un chatbot la politica di reso di un'azienda. Se non la conosce, dovrebbe informarti. Se invece è sovra-addestrato, potrebbe restituire la politica di un'azienda simile.

Prompting inefficace

Le aziende rilasciano certificati in prompt engineering, consapevoli che l’IA è valida solo quanto i suoi input.

Un prompt ben formulato è espresso con precisione, evita termini troppo tecnici e fornisce tutto il contesto necessario.

Questo perché l’allucinazione avviene ai margini di molte uscite a bassa probabilità.

Supponiamo che tu chieda “qual è la trama di shark girl?” Ora, una persona pensa “eh, shark girl.” Nel mondo delle statistiche, le possibilità sono:

- The Adventures of Sharkboy and Lavagirl – un film per bambini piuttosto popolare del 2005 con un nome simile.

- Un horror/thriller del 2024 chiamato Shark Girl – meno popolare ma più recente e accurato.

- Un libro per bambini con lo stesso nome pubblicato all’inizio di quest’anno – che il modello potrebbe aver indicizzato o meno.

Nessuna di queste è la scelta ovvia, portando a una distribuzione di probabilità più "piatta" e meno orientata verso un argomento o una narrazione specifica. Un prompt più efficace fornirebbe contesto, cioè chiarirebbe a quale esempio si riferisce l'utente.

Questa confusione di ambiguità e rilevanza marginale può produrre una risposta che è proprio questo: una trama generica inventata su una storia di squali.

Ridurre il rischio di allucinazioni significa ridurre l’incertezza.

Tipi di allucinazioni dell’IA

Finora ho parlato delle allucinazioni in termini generali. In realtà, questo fenomeno riguarda quasi tutti gli aspetti dell'IA. Tuttavia, per chiarezza, è meglio considerare le diverse categorie.

Errori fattuali

Ed è qui che entra in gioco l’esempio della fragola. Ci sono errori nei dettagli di affermazioni altrimenti corrette. Questi possono riguardare l’anno di un evento, la capitale di un paese o i numeri di una statistica.

Dettagli minimi in una risposta altrimenti corretta possono essere particolarmente insidiosi, soprattutto quando si tratta di informazioni che le persone spesso non ricordano, come numeri esatti.

Contenuti inventati

Nel 2023, Bard di Google ha affermato erroneamente che il telescopio James Webb fosse stato usato per scattare le prime foto di esopianeti. Non si trattava di una semplice imprecisione tecnica: era proprio falso.

Queste possono essere affermazioni audaci come quelle sopra, ma più spesso si presentano come URL che non portano a nulla, o librerie di codice e funzioni inventate.

Vale la pena notare che il confine tra errori fattuali e contenuti inventati non è sempre netto.

Supponiamo di parlare di un ricercatore. Se citiamo un suo articolo ma sbagliamo l’anno, è un errore fattuale. Se sbagliamo il nome, invece? E se sbagliamo sia il nome che l’anno?

Disinformazione

Questo può rientrare in una delle due categorie precedenti, ma si riferisce a informazioni false dove la fonte è più trasparente.

Il caso di Google AI che raccomanda la pizza con la colla o di mangiare sassi è un ottimo esempio: la fonte era chiaramente satirica e innocua – commenti Reddit scritti da The Onion – ma il modello non era stato addestrato per riconoscerlo.

Rischi delle allucinazioni IA

1. Perdita di fiducia

Apprezziamo la libertà di delegare i nostri compiti all’AI, ma non a scapito della fiducia.

Il recente errore di Cursor AI – un bot di assistenza clienti che ha inventato una politica restrittiva – ha portato molti utenti a cancellare l’abbonamento, mettendo in dubbio la sua affidabilità.

2. Costo

L’AI è ormai centrale in molte aziende e, sebbene sia positivo, un errore può costare caro.

L’allucinazione di James Webb di Google ha causato una perdita di 100 miliardi di dollari nel valore delle azioni Alphabet in poche ore. E questo prima ancora dei costi di riaddestramento dei modelli.

3. Disinformazione dannosa

Ridere della pizza con la colla è facile, ma che dire di dosaggi medici fuorvianti?

Preferisco di gran lunga una risposta rapida dall’IA piuttosto che leggere pagine di avvertenze. Ma se fosse sbagliata? Di certo non coprirà tutte le possibili condizioni mediche.

3. Sicurezza e Malware

Come accennato, l’AI spesso inventa i nomi delle librerie di codice. Quando provi a installare una libreria inesistente, non succede nulla.

Ora immagina che un hacker inserisca un malware in un codice e lo carichi con il nome di una libreria spesso ‘allucinata’. Tu installi la libreria e 💨puff💨: sei stato hackerato.

Questo esiste, e si chiama slopsquatting.

Nome discutibile a parte, è sempre bene essere critici su ciò che si installa e ricontrollare i nomi delle librerie più esotiche.

Passi per prevenire le allucinazioni dell’IA

Se non stai addestrando i modelli, puoi fare ben poco dal lato dei dati e dell’architettura.

La buona notizia è che ci sono ancora precauzioni che puoi adottare, e possono fare la differenza nel fornire un’IA priva di allucinazioni.

Scegli un modello e una piattaforma di cui ti puoi fidare

Non sei solo. Le aziende AI hanno tutto l’interesse a mantenere la fiducia, e questo significa niente allucinazioni.

A seconda di ciò che vuoi fare con l’AI, hai quasi sempre diverse opzioni, e una buona piattaforma AI rende tutto accessibile. Queste piattaforme dovrebbero essere trasparenti su come gestiscono le allucinazioni.

Usa RAG (Retrieval-Augmented Generation)

Non far affidare il modello solo alle proprie conoscenze. Dotare il tuo modello di RAG rende chiaro che le informazioni sono disponibili e dove trovarle.

È meglio eseguire l’AI su una piattaforma con istruzioni semplici su come implementare un RAG efficace.

Aggiungi istruzioni dettagliate

Se l’hai sentito una volta, l’hai sentito mille volte: spazzatura in ingresso, spazzatura in uscita.

“Rispondi alla domanda dell’utente” non garantisce il successo. Tuttavia, qualcosa come:

# Instructions

Please refer exclusively to the FAQ document. If the answer does not appear there:

* Politely inform the user that the information is unavailable.

* Offer to escalate the conversation to a human agent.terrà sotto controllo il tuo agente. Una richiesta chiara con limiti precisi è la miglior difesa contro un agente fuori controllo.

Verifica umana

Sul tema dell’escalation, è importante avere una persona pronta a verificare, valutare e correggere le carenze dell’AI.

La possibilità di intervenire o verificare retroattivamente le conversazioni ti permette di capire cosa funziona e cosa rischia di generare allucinazioni. Human-in-the-loop – supervisione umana dei flussi di lavoro guidati dall’IA – è fondamentale in questo contesto.

Usa subito l'AI senza allucinazioni

L’incertezza sull’affidabilità dell’IA potrebbe frenare la trasformazione digitale delle aziende.

Le capacità RAG di Botpress, l’integrazione human-in-the-loop e i sistemi di sicurezza approfonditi rendono l’IA sicura e affidabile. Il tuo agente lavora per te, non il contrario.

Inizia a costruire oggi. È gratis.

Domande frequenti

1. Come posso capire se una risposta AI è un'allucinazione senza avere conoscenze pregresse sull’argomento?

Per capire se una risposta AI è una allucinazione senza conoscenze pregresse, cerca segnali come affermazioni estremamente specifiche, linguaggio troppo sicuro o nomi, statistiche o citazioni che non possono essere verificate in modo indipendente. In caso di dubbio, chiedi all'AI di citare le fonti o verifica con fonti esterne affidabili.

2. Quanto sono comuni le allucinazioni AI nei grandi modelli linguistici (LLM)?

Le allucinazioni dell'IA sono comuni nei grandi modelli linguistici perché generano testo in base a probabilità, non a una verifica dei fatti. Anche i modelli avanzati come GPT-4o e Claude 3.5 possono produrre risultati imprecisi, soprattutto su argomenti di nicchia o in situazioni con poco contesto.

3. Le allucinazioni possono verificarsi anche in modelli AI non testuali, come i generatori di immagini?

Sì, anche nei modelli di generazione di immagini si verificano allucinazioni, spesso sotto forma di elementi irrealistici o senza senso nel risultato – come arti extra o rappresentazioni culturali errate – causate da bias o lacune nei dati di addestramento.

4. Le allucinazioni sono più comuni in alcune lingue o culture a causa dei bias nei dati di addestramento?

Le allucinazioni sono più frequenti nelle lingue poco rappresentate o in contesti culturali non occidentali, perché la maggior parte degli LLM è addestrata principalmente su dati in inglese e occidentali, portando a risposte meno sfumate culturalmente.

5. Quali settori sono più a rischio per le conseguenze delle allucinazioni AI?

Settori come sanità, finanza, diritto e assistenza clienti sono i più a rischio di allucinazioni AI, perché risposte imprecise possono portare a violazioni di conformità, perdite finanziarie, errori legali o danni alla fiducia degli utenti e alla reputazione del brand.

.webp)