- L’hallucination de l’IA se produit lorsque les modèles produisent avec assurance des informations fausses ou inventées, en raison d’une mauvaise qualité des données, d’un surapprentissage ou de consignes ambiguës.

- Les hallucinations vont des erreurs factuelles à la création de contenus fictifs. Elles peuvent nuire à la confiance, coûter des milliards aux entreprises ou propager de fausses informations dangereuses.

- Pour les éviter, il faut choisir des plateformes d’IA fiables, ajouter la génération augmentée par récupération (RAG), rédiger des consignes précises et prévoir une supervision humaine.

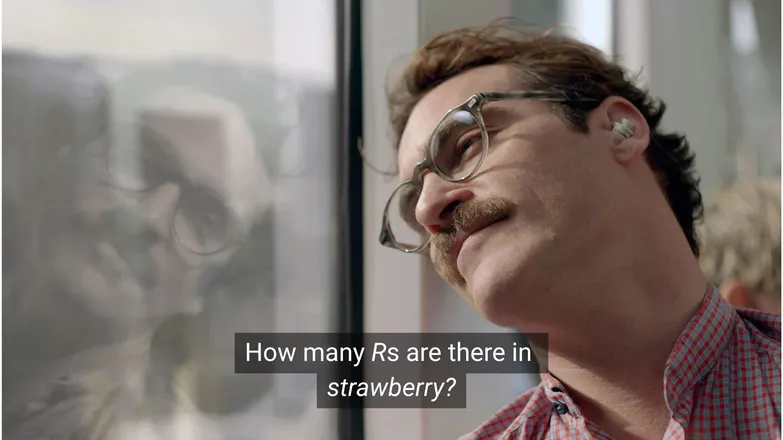

Pensez-vous que Joaquin Phoenix serait tombé amoureux de Scarlett Johansson s’il lui avait demandé combien de R il y a dans strawberry ? Si vous êtes sur LinkedIn, vous savez que la réponse est 3. (Ou alors, si vous savez lire.)

Mais pour les chatbots IA, ce n’est pas toujours aussi simple.

Vous avez sûrement vu des gens se moquer des absurdités des hallucinations de l’IA. Il faut dire qu’un modèle d’IA censé tout savoir, doté d’un raisonnement quasi humain et capable d’exécuter des tâches à la vitesse de l’éclair, qui échoue sur un problème de maths de maternelle, c’est plutôt absurde.

Mais derrière ces situations amusantes se cache une réalité plus sérieuse — et parfois insidieuse.

Dans cet article, je vais parler des hallucinations de l’IA : ce que c’est, ce qui les provoque, pourquoi elles sont importantes et comment les éviter.

Qu’est-ce qu’une hallucination de l’IA ?

Une hallucination de l’IA, c’est lorsqu’un modèle présente des informations inexactes, trompeuses ou totalement inventées. Ces fausses informations peuvent sembler crédibles et, dans de nombreux cas, passer inaperçues.

Avec l’adoption massive des LLM, on parle surtout d’hallucinations dans le contexte des modèles génératifs de texte. En réalité, elles représentent un risque pour toute application de l’IA générative.

Qu’est-ce qui provoque les hallucinations dans l’IA ?

L’hallucination de l’IA survient lorsque les modèles apprennent de faux schémas.

Les schémas, dans le contexte de l’IA, désignent la capacité à utiliser des exemples d’entraînement pour généraliser sur de nouvelles données. Cela peut être une suite de mots pour poursuivre un texte, ou la distribution des pixels d’une image correspondant à un chien.

Dans le cas d’une hallucination d’un LLM, le modèle considère une suite de mots comme la réponse la plus probable à la consigne de l’utilisateur, même si elle est fausse.

Cela peut être dû à une ou plusieurs des raisons suivantes :

Données d’entraînement de mauvaise qualité

ChatGPT et d’autres LLM sont entraînés sur d’énormes quantités de données. Mais ces données, aussi abondantes soient-elles, sont imparfaites à cause de :

- Des lacunes sur certains sujets

- La reproduction de préjugés du monde réel

- La désinformation délibérée ou la satire non identifiée

- Des biais, c’est-à-dire des données déséquilibrées ou « biaisées ».

Imaginez que le modèle ait été entraîné sur des informations concernant tous les dieux grecs sauf un.

Sa capacité à établir des liens statistiques entre des sujets liés à la mythologie grecque — amour, éthique, trahison — pourrait l’amener à inventer une mythologie qu’il juge « probable » selon son modèle statistique.

On le constate aussi dans la génération d’images, où la plupart des requêtes concernant un personnage féminin produisent des images hypersexualisées. Le biais vers un certain type de représentation conditionne les images générées.

L’orthographe de strawberry a probablement été vue dans les données d’entraînement dans le contexte d’une discussion sur le double R, un vrai casse-tête pour les non-anglophones. Dans ce cas, le chiffre 2 ou le mot « double » sont probablement associés à l’orthographe du mot.

En revanche, il est peu probable que les données mentionnent qu’il y a 3 R.

Le résultat est absurde parce que la consigne est : dans quelle situation quelqu’un écrirait-il un mot puis demanderait-il comment il s’écrit ?

Architecture du modèle et méthode de génération

Les modèles sont construits à partir d’architectures de réseaux neuronaux extrêmement complexes. De légères variations influencent la façon dont les modèles interagissent avec leurs données d’entraînement et les consignes reçues. La capacité d’un modèle à limiter les hallucinations s’améliore progressivement grâce à une recherche et des tests rigoureux.

À cela s’ajoute la façon dont la génération est implémentée. Mot par mot (en réalité morceau de mot), les modèles prédisent le mot le plus probable à suivre. Donc :

« Le renard brun rapide saute par-dessus le chien paresseux ___.»

Le modèle déterminera que le mot suivant le plus probable est « chien ». Mais d’autres mots sont possibles. Et une génération basée uniquement sur le mot le plus probable donne des résultats prévisibles et peu intéressants.

Cela signifie qu’il faut utiliser des méthodes d’échantillonnage créatives pour rendre les réponses à la fois cohérentes et variées. Mais cela peut parfois nuire à la véracité des réponses.

Surapprentissage

Le surapprentissage, c’est quand le modèle colle tellement aux données d’entraînement qu’il n’arrive plus à généraliser sur de nouvelles entrées.

Donc, si j’étais un modèle (comme ma mère me le conseille), je serais bien entraîné si je reconnaissais les chiens comme :

Poilus, avec des oreilles tombantes, joueurs, et un petit nez marron.

Mais je serais surentraîné si je ne les reconnaissais que comme :

Ayant un point marron sous le menton, répondant au nom de « Frank » et ayant complètement mâchouillé ma bonne paire de Nikes.

Dans le contexte d’un LLM, cela se traduit souvent par la répétition d’informations vues pendant l’entraînement, au lieu de reconnaître qu’il ne connaît pas la réponse.

Si vous demandez à un chatbot la politique de retour d’une entreprise et qu’il ne sait pas, il devrait vous le dire. Mais s’il est surentraîné, il pourrait vous donner la politique d’une entreprise similaire.

Mauvaise formulation des consignes

Les entreprises délivrent des certificats en ingénierie de consignes, car une IA n’est aussi performante que ses entrées.

Une consigne bien formulée est précise, évite le jargon trop spécifique et fournit tout le contexte nécessaire.

Car l’hallucination survient souvent à la frontière de nombreuses sorties peu probables.

Si vous demandez « quel est le scénario de shark girl ? » Un humain se dirait « tiens, shark girl. » Statistiquement, les possibilités sont :

- The Adventures of Sharkboy and Lavagirl — un film pour enfants assez connu de 2005 au nom proche.

- Un film d’horreur/thriller de 2024 intitulé Shark Girl — moins connu mais plus récent et pertinent.

- Un livre pour enfants du même nom sorti plus tôt cette année — que le modèle a peut-être indexé ou non.

Aucune de ces options n’est évidente, ce qui donne une distribution de probabilité plus « plate » et moins d’engagement sur un sujet ou une histoire. Une consigne plus efficace préciserait le contexte, c’est-à-dire de quel exemple il s’agit.

Ce mélange d’ambiguïté et de pertinence approximative peut donner une réponse inventée, comme un scénario générique sur une histoire de requin.

Réduire le risque d’hallucinations, c’est réduire l’incertitude.

Types d’hallucinations de l’IA

Jusqu’ici, j’ai parlé des hallucinations de façon générale. En réalité, elles touchent presque tous les aspects de l’IA. Pour plus de clarté, il vaut mieux distinguer les différentes catégories.

Erreurs factuelles

C’est là que l’exemple de la fraise s’applique. Il s’agit d’erreurs dans les détails d’énoncés par ailleurs corrects. Cela peut concerner l’année d’un événement, la capitale d’un pays ou des chiffres statistiques.

Des détails mineurs dans une bonne réponse peuvent être particulièrement trompeurs, surtout pour des informations que les humains retiennent rarement, comme des chiffres exacts.

Contenu inventé

En 2023, Bard de Google a faussement affirmé que le télescope James Webb avait pris les premières images d’exoplanètes. Ce n’était pas une simple imprécision technique, c’était tout simplement faux.

Il peut s’agir d’affirmations audacieuses comme ci-dessus, mais le plus souvent, ce sont des URL qui ne mènent nulle part, ou des bibliothèques et fonctions de code inventées.

Il est important de noter que la frontière entre erreur factuelle et contenu inventé n’est pas toujours nette.

Imaginons qu’on parle d’un chercheur. Si on cite un de ses articles mais qu’on se trompe d’année, c’est une erreur factuelle. Mais si on se trompe de nom, alors quoi ? Et si on se trompe à la fois de nom et d’année ?

Désinformation

Cela peut relever de l’une ou l’autre des deux catégories précédentes, mais désigne une fausse information dont la source est plus transparente.

L’exemple célèbre de l’IA de Google recommandant de mettre de la colle sur une pizza ou de manger des cailloux en est une bonne illustration : la source était manifestement satirique et sans danger – des commentaires Reddit écrits par The Onion, mais le modèle n’avait pas été entraîné à le reconnaître.

Risques liés aux hallucinations de l’IA

1. Perte de confiance

Nous apprécions de pouvoir déléguer nos tâches à l’IA, mais pas au détriment de la confiance.

La récente erreur de Cursor AI – un bot de service client inventant une politique restrictive – a poussé de nombreux utilisateurs à résilier leur abonnement, doutant de sa fiabilité.

2. Coût

L’IA occupe une place centrale dans de nombreuses entreprises, et même si c’est positif, une erreur peut coûter cher.

L’hallucination de Google sur James Webb a entraîné une chute de 100 milliards de dollars de la valeur d’Alphabet en quelques heures. Et cela, avant même le coût du ré-entraînement des modèles.

3. Désinformation dangereuse

On rit de l’absurdité de la pizza à la colle, mais qu’en est-il des doses médicales erronées ?

Je préfère mille fois une réponse rapide de l’IA à la lecture de longues mises en garde. Mais si la réponse est fausse ? L’IA ne prendra presque jamais en compte toutes les conditions médicales possibles.

3. Sécurité et logiciels malveillants

Comme mentionné, l’IA invente souvent des noms de bibliothèques de code. Si vous essayez d’installer une bibliothèque qui n’existe pas, il ne se passe rien.

Imaginez maintenant qu’un pirate intègre un malware dans un code et le publie sous le nom d’une bibliothèque souvent inventée par l’IA. Vous l’installez et 💨pouf💨 : vous êtes piraté.

Ce phénomène existe, et s’appelle le slopsquatting.

Nom peu ragoûtant mis à part, il vaut toujours mieux rester critique sur ce que l’on installe et vérifier les noms de bibliothèques qui semblent exotiques.

Comment éviter les hallucinations de l’IA

Si vous n’entraînez pas les modèles vous-même, vous avez peu de prise sur les données et l’architecture.

La bonne nouvelle, c’est qu’il existe tout de même des précautions à prendre, et elles peuvent faire toute la différence pour livrer une IA sans hallucinations.

Choisissez un modèle et une plateforme de confiance

Vous n’êtes pas seul. Les entreprises d’IA ont tout intérêt à préserver la confiance, donc à éviter les hallucinations.

Selon votre usage de l’IA, vous avez presque toujours plusieurs options, et une bonne plateforme d’IA rend cela accessible. Ces plateformes doivent être transparentes sur leurs méthodes pour limiter les hallucinations.

Utilisez le RAG (génération augmentée par récupération)

Ne laissez pas le modèle s’appuyer uniquement sur ses connaissances internes. En équipant votre modèle du RAG, vous indiquez clairement où trouver l’information et qu’elle est disponible.

Il est préférable d’utiliser une plateforme d’IA qui propose des instructions simples sur la mise en place efficace du RAG.

Ajoutez des instructions précises

Vous l’avez sûrement déjà entendu : si l’entrée est mauvaise, la sortie le sera aussi.

« Répondez à la question de l’utilisateur » ne suffit pas. En revanche, une consigne comme :

# Instructions

Please refer exclusively to the FAQ document. If the answer does not appear there:

* Politely inform the user that the information is unavailable.

* Offer to escalate the conversation to a human agent.permettra de garder votre agent sous contrôle. Des instructions claires et des garde-fous stricts sont votre meilleure protection contre un agent imprévisible.

Vérification humaine

En matière d’escalade, il est important d’avoir une personne prête à inspecter, évaluer et corriger les lacunes de l’IA.

La possibilité d’escalader ou de vérifier a posteriori les conversations permet d’identifier ce qui fonctionne et ce qui risque de générer des hallucinations. L’humain dans la boucle – la supervision humaine des processus pilotés par l’IA – est ici indispensable.

Utilisez dès aujourd’hui une IA sans hallucinations

L’incertitude autour de la fiabilité de l’IA freine peut-être la transformation numérique des entreprises.

Les capacités RAG de Botpress, l’intégration de l’humain dans la boucle et des systèmes de sécurité robustes rendent l’IA fiable et sécurisée. Votre agent travaille pour vous, pas l’inverse.

Commencez à créer dès aujourd’hui. C’est gratuit.

FAQ

1. Comment savoir si une réponse d’IA est une hallucination sans connaître le sujet ?

Pour repérer une hallucination sans connaissance préalable, surveillez les signes comme des affirmations très précises, un ton trop sûr de lui, ou des noms, chiffres ou sources impossibles à vérifier. En cas de doute, demandez à l’IA de citer ses sources ou vérifiez auprès de références fiables.

2. À quelle fréquence les hallucinations surviennent-elles dans les grands modèles de langage (LLM) ?

Les hallucinations sont fréquentes dans les grands modèles de langage, car ils génèrent du texte selon des probabilités, sans vérification factuelle. Même des modèles avancés comme GPT-4o ou Claude 3.5 peuvent produire des résultats inexacts, surtout sur des sujets pointus ou avec peu de contexte.

3. Les hallucinations existent-elles aussi dans les modèles d’IA non textuels, comme les générateurs d’images ?

Oui, les générateurs d’images peuvent aussi halluciner, souvent sous la forme d’éléments irréalistes ou absurdes – membres en trop, représentations culturelles erronées – causés par des biais ou des lacunes dans les données d’entraînement.

4. Les hallucinations sont-elles plus fréquentes dans certaines langues ou cultures à cause des biais des données d’entraînement ?

Les hallucinations sont plus courantes dans les langues peu représentées ou les contextes culturels non occidentaux, car la plupart des LLM sont principalement entraînés sur des données en anglais et centrées sur l’Occident, ce qui limite la nuance culturelle.

5. Quels secteurs sont les plus exposés aux conséquences des hallucinations de l’IA�?

Des secteurs comme la santé, la finance, le droit ou le service client sont particulièrement exposés aux hallucinations de l’IA, car des réponses inexactes peuvent entraîner des violations de conformité, des pertes financières, des erreurs juridiques ou nuire à la confiance des utilisateurs et à la réputation de la marque.

.webp)