- Nangyayari ang AI hallucination kapag tiwala ang mga modelo sa pagbibigay ng maling o gawa-gawang impormasyon, dulot ng mababang kalidad ng datos, overfitting, o malabong mga prompt.

- Maaaring magmula ang hallucinations sa simpleng maling detalye hanggang sa ganap na imbentong nilalaman at maaaring makasira ng tiwala, magdulot ng malaking pagkalugi sa negosyo, o magpalaganap ng mapanirang maling impormasyon.

- Mahalagang hakbang para maiwasan ito ang pagpili ng mapagkakatiwalaang AI platform, pagdagdag ng retrieval-augmented generation (RAG), paggawa ng malinaw na mga prompt, at pagsama ng human oversight.

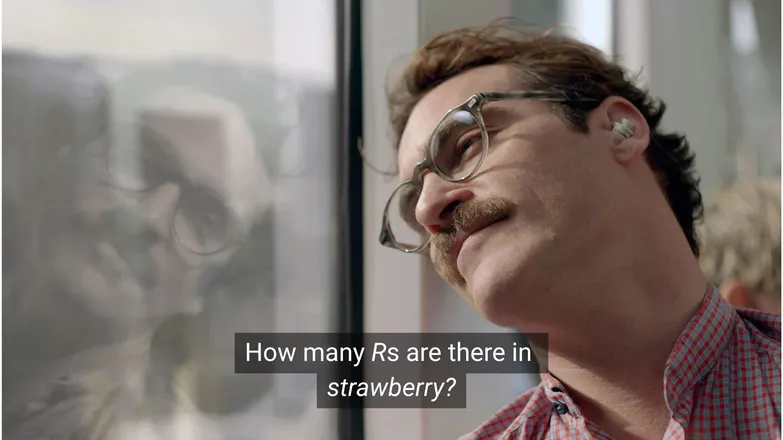

Sa tingin mo ba maiinlove si Joaquin Phoenix kay Scarlett Johansson kung tinanong niya kung ilang R ang nasa strawberry? Kung nasa LinkedIn ka, alam mong ang sagot ay 3. (O, alam mo, kung marunong kang magbasa.)

Pero para sa mga AI chatbot, hindi ito laging ganoon kasimple.

Malamang nakita mo na ang mga tao na pinagtatawanan ang kakaibang AI hallucinations. At sa totoo lang, nakakatawang isipin na ang isang AI model na tila walang hanggan ang kaalaman, parang tao kung mag-isip, at napakabilis magtrabaho ay pumapalpak sa simpleng math problem na pambata lang.

Pero sa likod ng katuwaan, may mas seryoso—at posibleng mapanganib—na katotohanan.

Sa artikulong ito, pag-uusapan ko ang tungkol sa AI hallucinations—ano ito, ano ang sanhi, bakit ito mahalaga, at mga hakbang na puwede mong gawin para maiwasan ito.

Ano ang AI hallucination?

Ang AI hallucination ay kapag naglalabas ang AI model ng impormasyon na mali, nakaliligaw, o ganap na imbento. Maaaring mukhang totoo ang maling impormasyong ito at kadalasan, hindi agad napapansin.

Dahil sa malawakang paggamit ng LLMs, kadalasang tinutukoy ang hallucinations sa konteksto ng generative text models. Sa realidad, panganib ito sa kahit anong aplikasyon ng Generative AI.

Ano ang sanhi ng hallucination sa AI?

Nangyayari ang AI hallucination kapag natututo ang mga modelo ng maling pattern.

Ang pattern, sa konteksto ng AI, ay tumutukoy sa kakayahan nitong gamitin ang mga indibidwal na halimbawa sa training para magpangkalahatan sa hindi pa nakikitang datos. Maaaring ito ay serye ng mga salita para bumuo ng pagpapatuloy ng teksto, o pagkakabahagi ng mga pixel ng larawan na tumutukoy sa isang aso.

Sa kaso ng LLM hallucination, pinili ng modelo ang isang serye ng mga salita bilang pinaka-malamang na kasunod ng prompt ng user, kahit na mali ito.

Maaaring dulot ito ng isa o higit pa sa mga sumusunod:

Mababang Kalidad ng Training Data

Ang ChatGPT at mga katulad na LLM ay sinanay gamit ang napakaraming datos. Kahit marami ito, hindi perpekto ang datos dahil sa:

- Mga puwang sa ilang paksa

- Pagpapakita ng tunay na pagkiling sa lipunan

- Sinadyang maling impormasyon o hindi natukoy na satire

- Bias, ibig sabihin hindi balanse o “tagilid” ang datos.

Isipin ang sitwasyon na sinanay ang modelo sa impormasyon tungkol sa lahat ng Greek god maliban sa isa.

Ang kakayahan nitong mag-ugnay ng mga paksa tungkol sa Greek mythology—pag-ibig, etika, pagtataksil—ay maaaring magbunga ng imbentong kwento na sa tingin ng modelo ay “malamang”, base sa estadistika nito.

Makikita rin ito sa image generation, kung saan karamihan ng prompt para sa babaeng paksa ay nagreresulta sa labis na sekswal na mga larawan. Ang bias sa isang uri ng paglalarawan ay nagkokondisyon sa mga larawang nililikha.

Malamang na lumitaw sa training data ang baybay ng strawberry sa konteksto ng usapan tungkol sa dobleng R, na madalas pahirapan ng mga hindi katutubong Ingles. Sa kasong ito, malamang na lumitaw ang bilang na 2 o ang salitang “double” kaugnay ng baybay ng salita.

Sa kabilang banda, malabong nabanggit sa datos na may 3 R ito.

Kaya nakakatawa ang sagot dahil sa prompt: kailan ba may magsusulat ng salita at saka magtatanong kung paano ito baybayin?

Model Architecture at Paraan ng Pagbuo

Ang mga modelo ay binubuo ng napakakomplikadong neural network na arkitektura. Kahit maliit na pagbabago ay nakakaapekto sa paraan ng pakikisalamuha ng mga modelo sa kanilang training data at input na prompt. Ang kakayahan ng isang modelo na pigilin ang hallucination ay unti-unting napapabuti sa pamamagitan ng masusing pananaliksik at pagsusuri.

Bukod pa rito, mahalaga rin kung paano ginagawa ang generation. Salitang-salita (o word-piece talaga), hinuhulaan ng mga modelo ang pinaka-malamang na kasunod na salita. Kaya:

“The quick brown fox jumps over the lazy ___.”

Malalaman ng modelo na ang pinaka-malamang na kasunod ay “dog”. Pero posible rin ang ibang salita. At kung puro pinaka-malamang na salita lang ang pipiliin, nagiging paulit-ulit at hindi kawili-wili ang resulta.

Ibig sabihin, kailangang gumamit ng mas malikhaing paraan ng pagpili para maging mas kawili-wili at makabuluhan ang sagot. Pero sa ganitong paraan, minsan nadudulas ang katotohanan.

Overfitting

Ang overfitting ay kapag sobrang tinutukan ng modelo ang datos sa training kaya hindi na ito makapagpangkalahatan sa bagong input.

Kaya, kung ako ay isang modelo (sabi ng nanay ko dapat daw), magiging maayos ang training ko kung makikilala ko ang mga aso bilang:

Mabalahibo, may malalambot na tainga, malikot, at may maliit na kayumangging ilong na parang pindutan.

Pero magiging overfit ako kung makikilala ko lang sila bilang:

May kayumangging tuldok sa ilalim ng baba, sumasagot sa pangalang “Frank”, at kinain ang paborito kong sapatos na Nikes.

Sa konteksto ng isang LLM, kadalasan itong lumalabas bilang pag-uulit ng impormasyong nakita sa training data, sa halip na aminin kung hindi alam ang sagot.

Halimbawa, kung tinanong mo ang chatbot tungkol sa return policy ng isang kumpanya. Kung hindi nito alam, dapat sabihin nito. Pero kung overfit ito, baka ibigay nito ang policy ng ibang kumpanyang halos pareho.

Hindi Maayos na Prompting

Nagbibigay na ng sertipiko ang mga kumpanya sa prompt engineering dahil alam nilang ang AI ay kasing-husay lang ng input nito.

Ang maayos na prompt ay malinaw ang pagkakalahad, iniiwasan ang masyadong teknikal na termino, at nagbibigay ng sapat na konteksto.

Dahil nangyayari ang hallucination sa mga sitwasyong maraming mababang posibilidad na sagot.

Halimbawa, tinanong mo “ano ang kwento ng shark girl?” Ngayon, ang tao ay mag-iisip ng “hmm, shark girl.” Sa mundo ng estadistika, ang mga posibilidad ay:

- The Adventures of Sharkboy and Lavagirl – isang sikat na pelikula ng mga bata noong 2005 na halos kapangalan.

- Isang horror/thriller noong 2024 na tinawag na Shark Girl – hindi gaanong sikat pero mas bago at mas akma.

- Isang aklat pambata na may parehong pangalan mula ngayong taon – na maaaring hindi pa na-index ng modelo.

Wala sa mga ito ang halatang sagot, kaya nagkakaroon ng “pantay-pantay” na probability distribution na walang matibay na pagpili ng paksa o kwento. Mas epektibo ang prompt kung may konteksto, halimbawa, nililinaw kung alin ang tinutukoy ng user.

Ang sabaw ng kalabuan at hindi direktang kaugnayan ay maaaring magbunga ng sagot na ganoon din: imbentong kwento tungkol sa paksang may kinalaman sa pating.

Ang pagbawas ng tsansa ng hallucination ay tungkol sa pagbawas ng kawalang-katiyakan.

Mga Uri ng AI Hallucinations

Hanggang ngayon, malawak ang usapan ko tungkol sa hallucinations. Sa totoo lang, halos lahat ng aspeto ng AI ay apektado nito. Pero para maging malinaw, mas mainam na hatiin ito sa iba’t ibang kategorya.

Mga Mali sa Katotohanan

Dito pumapasok ang halimbawa ng strawberry. May mga pagkakamali sa detalye ng kung hindi man tama ang pahayag. Maaaring kabilang dito ang taon ng isang pangyayari, kabisera ng isang bansa, o bilang ng isang estadistika.

Ang maliliit na detalye sa isang maayos na sagot ay maaaring maging mapanlinlang, lalo na kung tungkol ito sa mga bagay na madalang tandaan ng tao, gaya ng eksaktong bilang.

Gawang-gawang Nilalaman

Noong 2023, maling sinabi ng Bard ng Google na ginamit ang James Webb telescope para kunan ng unang larawan ng mga exoplanet. Hindi ito usapin ng teknikal na pagkakamali—talagang mali lang ito.

Maaaring matitinding pahayag ang mga ito tulad ng nasa itaas, pero mas madalas lumalabas bilang mga URL na walang patutunguhan, o mga imbentong code library at function.

Mahalagang tandaan na hindi laging malinaw ang hangganan ng factual error at gawang-gawang nilalaman.

Halimbawa, pinag-uusapan natin ang isang mananaliksik. Kung nabanggit natin ang isang papel niya pero mali ang taon, factual error iyon. Paano kung mali ang pangalan? Paano kung parehong pangalan at taon ang mali?

Maling Impormasyon

Maaaring pumasok ito sa alinman sa dalawang naunang kategorya, pero tumutukoy ito sa maling impormasyon na mas lantad ang pinagmulan.

Sikat na halimbawa dito ang payo ng Google AI na lagyan ng glue ang pizza at kumain ng bato; malinaw na satirical at di naman nakakasama ang pinagmulan—mga Reddit comment na gawa ng The Onion, pero hindi ito na-account sa training ng modelo.

Mga Panganib ng AI Hallucinations

1. Kawalan ng Tiwala

Pinapahalagahan natin ang kaginhawaan ng pag-aasa sa AI, pero hindi kapalit ng tiwala natin.

Ang kamakailang pagkakamali ng Cursor AI—isang customer service bot na nag-imbento ng mahigpit na patakaran—nagresulta sa pagkansela ng maraming user sa kanilang subscription, at nagdulot ng pagdududa sa pagiging maaasahan nito.

2. Gastos

Nangunguna na ang AI sa maraming negosyo, at bagamat maganda ito, maaaring magdulot ng malaking gastos ang isang pagkakamali.

Ang James Webb hallucination ng Google ay nagdulot ng $100 bilyon na pagbagsak sa stock ng Alphabet sa loob lang ng ilang oras. At hindi pa kasama rito ang gastos sa muling pag-train ng mga modelo.

3. Mapanganib na Maling Impormasyon

Nakakatawa man ang glue pizza, paano naman ang nakalilitong dosis ng gamot?

Ako na ang unang papalit ng pagbabasa ng mahahabang babala para lang sa mabilis na sagot mula sa AI. Pero paano kung mali ito? Halos tiyak na hindi nito maisasaalang-alang ang lahat ng posibleng kondisyon sa kalusugan.

3. Seguridad at Malware

Gaya ng nabanggit, madalas mag-imbento ang AI ng pangalan ng code library. Kapag sinubukan mong i-install ang hindi umiiral na library, walang mangyayari.

Ngayon, isipin mong may hacker na naglalagay ng malware sa code at ina-upload ito gamit ang pangalan ng karaniwang na-ha-hallucinate na library. I-install mo ang library, at 💨ayun, tapos ka na💨: na-hack ka na.

Umiiral ito, at tinatawag na slopsquatting.

Pangit man ang pangalan, hindi masamang maging mapanuri sa mga ini-install mo, at doblehin ang pag-check sa mga kakaibang pangalan ng library.

Mga Hakbang para Maiwasan ang AI Hallucinations

Kung hindi ikaw ang nagte-train ng mga modelo, kakaunti ang magagawa mo sa bahagi ng data at arkitektura.

Ang magandang balita, may mga pag-iingat pa ring puwedeng gawin, at malaking tulong ito para makapaglabas ng AI na walang hallucination.

Pumili ng Model at Platform na Maaasahan

Hindi ka nag-iisa. Interesado ang mga AI company na mapanatili ang tiwala, at ibig sabihin nito ay walang hallucination.

Depende sa paggamit mo ng AI, kadalasan ay may ilang pagpipilian ka, at ang isang mahusay na AI platform ay ginagawang madali ito. Dapat malinaw ang mga platform na ito tungkol sa paano nila pinipigilan ang hallucination.

Gamitin ang RAG (Retrieval-Augmented Generation)

Huwag hayaang umasa lang ang modelo sa sarili nitong kaalaman. Sa paglalagay ng RAG sa modelo mo, malinaw kung anong impormasyon ang meron at saan ito makikita.

Pinakamainam na gamitin ang AI sa platform na may malinaw na gabay kung paano magpatupad ng epektibong RAG.

Magdagdag ng Malinaw na Instruksyon

Kung narinig mo na ito minsan, narinig mo na ito ng libo-libo: basura ang ipinasok, basura rin ang lalabas.

“Sagutin ang tanong ng user” ay hindi garantiya ng tagumpay. Pero ang ganito:

# Instructions

Please refer exclusively to the FAQ document. If the answer does not appear there:

* Politely inform the user that the information is unavailable.

* Offer to escalate the conversation to a human agent.ay makakatulong para manatili sa tamang landas ang agent mo. Malinaw na prompt na may matibay na gabay ang pinakamabisang depensa laban sa pasaway na agent.

Pagbe-verify ng Tao

Tungkol sa pag-eskalate, mahalagang may taong handang sumuri, magtasa, at itama ang kakulangan ng AI.

Ang kakayahang mag-eskalate, o balikan at i-verify ang mga usapan, ay nagbibigay-daan para matukoy kung ano ang gumagana at alin ang posibleng magdulot ng hallucination. Human-in-the-loop—taong nagbabantay sa AI workflow—ay kinakailangan dito.

Gamitin ang AI na Walang Hallucination Ngayon

Ang kawalang-katiyakan sa pagiging maaasahan ng AI ay maaaring pumigil sa mga negosyo na magbago tungo sa digital na paraan.

Ang RAG capabilities ng Botpress, human-in-the-loop integration, at matibay na sistema ng seguridad ay ginagawang ligtas at maaasahan ang AI. Ang agent mo ay gumagana para sa iyo, hindi baliktad.

Simulan ang paggawa ngayon. Libre ito.

FAQs

1. Paano ko malalaman kung hallucination ang sagot ng AI kahit wala akong alam sa paksa?

Para malaman kung hallucination ang sagot ng AI kahit wala kang alam, hanapin ang mga palatandaan gaya ng sobrang tiyak na pahayag, labis na kumpiyansang pananalita, o pangalan, estadistika, o sanggunian na hindi mapapatunayan. Kung nagdududa, hilingin sa AI na ilahad ang pinagmulan nito o i-cross-check sa mapagkakatiwalaang sanggunian.

2. Gaano kadalas ang AI hallucinations sa malalaking language model (LLM)?

Karaniwan ang AI hallucinations sa malalaking language model dahil bumubuo sila ng teksto batay sa posibilidad, hindi sa aktwal na beripikasyon. Kahit ang mga advanced na modelo tulad ng GPT-4o at Claude 3.5 ay maaaring maglabas ng maling sagot, lalo na kung tungkol sa kakaibang paksa o kulang ang konteksto.

3. Maaari bang mangyari ang hallucination sa AI model na hindi text-based, tulad ng image generator?

Oo, nangyayari rin ang hallucination sa mga image-generation model, kadalasan bilang hindi makatotohanan o walang saysay na bahagi sa output—tulad ng sobrang mga braso o maling representasyon ng kultura—na dulot ng bias o kakulangan sa training data.

4. Mas madalas ba ang hallucination sa ilang wika o kultura dahil sa bias sa training data?

Mas madalas ang hallucination sa mga wikang hindi gaanong kinakatawan o sa di-Kanluraning konteksto dahil karamihan sa LLM ay sinanay sa English at Kanluraning datos, kaya kulang sa mas angkop na tugon para sa ibang kultura.

5. Aling mga industriya ang pinaka-nanganganib sa epekto ng AI hallucinations?

Ang mga industriya tulad ng pangkalusugan, pananalapi, batas, at serbisyo sa kostumer ang pinaka-nanganganib sa mga epekto ng AI hallucinations, dahil ang maling resulta sa mga larangang ito ay maaaring magdulot ng paglabag sa regulasyon, pagkalugi, pagkakamali sa batas, o pagkasira ng tiwala ng gumagamit at reputasyon ng tatak.

.webp)