- AI-hallucinatie treedt op wanneer modellen vol vertrouwen onjuiste of verzonnen informatie geven, veroorzaakt door slechte datakwaliteit, overfitting of vage prompts.

- Hallucinaties variëren van feitelijke fouten tot verzonnen inhoud en kunnen het vertrouwen schaden, bedrijven miljarden kosten of schadelijke desinformatie verspreiden.

- Belangrijke preventiestappen zijn het kiezen van betrouwbare AI-platforms, het toevoegen van retrieval-augmented generation (RAG), het opstellen van nauwkeurige prompts en het inschakelen van menselijke controle.

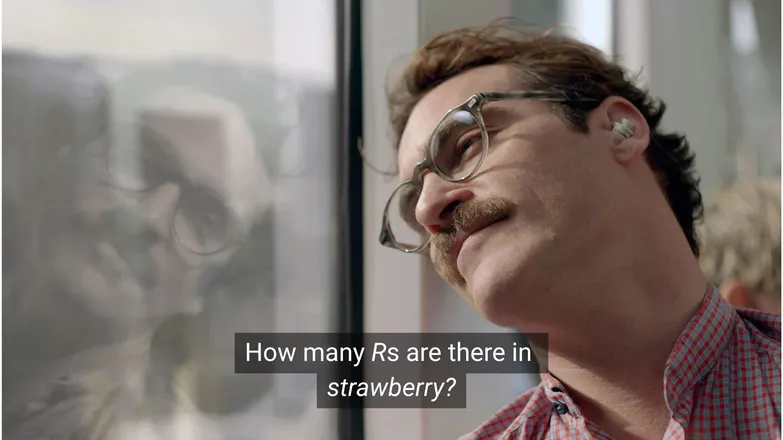

Denk je dat Joaquin Phoenix verliefd zou zijn geworden op Scarlett Johansson als hij haar had gevraagd hoeveel R's er in strawberry zitten? Als je op LinkedIn zit, weet je dat het antwoord 3 is. (Of, je weet het, als je kunt lezen.)

Maar voor AI-chatbots is het niet altijd zo eenvoudig.

Je hebt vast mensen gezien die de spot drijven met de absurditeit van AI-hallucinaties. En eerlijk is eerlijk, het is best absurd als een AI-model met schijnbaar eindeloze kennis, mensachtige redeneervaardigheden en razendsnelle uitvoering faalt bij een rekensom op kleuterniveau.

Maar achter het vermaak schuilt een serieuzere — en mogelijk verraderlijke — realiteit.

In dit artikel bespreek ik AI-hallucinaties: wat ze zijn, waardoor ze ontstaan, waarom ze belangrijk zijn en welke maatregelen je kunt nemen om ze te voorkomen.

Wat is een AI-hallucinatie?

AI-hallucinatie is wanneer een AI-model informatie presenteert die onjuist, misleidend of volledig verzonnen is. Deze onjuiste informatie kan geloofwaardig lijken en blijft in veel gevallen onopgemerkt.

Door de brede toepassing van LLM's worden hallucinaties meestal besproken in de context van generatieve tekstmodellen. In werkelijkheid vormen ze een risico voor elke toepassing van Generative AI.

Waardoor ontstaan hallucinaties bij AI?

AI-hallucinatie ontstaat wanneer modellen valse patronen aanleren.

Patronen verwijzen in de AI-context naar het vermogen om individuele trainingsvoorbeelden te gebruiken om te generaliseren naar onbekende data. Dit kan een reeks woorden zijn om de voortzetting van een tekst te vormen, of de verdeling van beeldpixels die bij een hond horen.

Bij LLM-hallucinatie heeft het model een reeks woorden als het meest waarschijnlijke vervolg op de prompt van de gebruiker gekozen, ook al is het onjuist.

Dit kan komen door een of meer van de volgende redenen:

Training met lage datakwaliteit

ChatGPT en vergelijkbare LLM's worden getraind op enorme hoeveelheden data. Deze data is, hoe overvloedig ook, niet perfect door:

- Hiaten in bepaalde onderwerpen

- Weerspiegeling van vooroordelen uit de echte wereld

- Opzettelijke desinformatie of niet-gemarkeerde satire

- Vooringenomenheid, zoals onevenwichtige of "scheve" data.

Stel je voor dat het model getraind is op informatie over alle Griekse goden behalve één.

Het vermogen om statistische verbanden te leggen tussen onderwerpen uit de Griekse mythologie—liefde, ethiek, verraad—kan ertoe leiden dat het model een verzonnen mythe samenstelt die volgens zijn statistisch model "waarschijnlijk" is.

Dit zie je ook bij beeldgeneratie, waar de meeste prompts voor een vrouwelijk onderwerp hyperseksuele beelden opleveren. De voorkeur voor één bepaald type afbeelding stuurt de soort beelden die worden gegenereerd.

De spelling van strawberry is waarschijnlijk in de trainingsdata voorgekomen in de context van een discussie over de dubbele R, een bekend struikelblok voor niet-native speakers. In dat geval zijn het getal 2 of het woord “double” waarschijnlijk genoemd bij de spelling.

Aan de andere kant is het onwaarschijnlijk dat in de data wordt vermeld dat het woord 3 R's bevat.

Het antwoord is absurd omdat de prompt is: onder welke omstandigheden zou iemand een woord opschrijven en dan vragen hoe het gespeld wordt?

Modelarchitectuur en generatie-methode

De modellen zijn opgebouwd uit extreem complexe neurale netwerk-architecturen. Kleine variaties beïnvloeden hoe modellen interacteren met hun trainingsdata en input-prompts. Het vermogen van een model om hallucinaties te beperken wordt stapsgewijs verbeterd door grondig onderzoek en testen.

Daarbovenop komt de manier waarop generatie wordt uitgevoerd. Woord voor woord (eigenlijk woorddeel) voorspellen modellen het meest waarschijnlijke volgende woord. Dus:

“The quick brown fox jumps over the lazy ___.”

Het model zal bepalen dat het meest waarschijnlijke volgende woord “dog” is. Maar andere woorden zijn mogelijk. En generatie die alleen kijkt naar het meest waarschijnlijke volgende woord levert saaie, voorspelbare resultaten op.

Dat betekent dat er creatieve sampling-methoden nodig zijn om antwoorden interessant én samenhangend te houden. Daarbij gaat feitelijkheid soms verloren.

Overfitting

Overfitting betekent dat het model zo nauwkeurig op de trainingsdata is afgestemd dat het niet meer goed generaliseert naar nieuwe input.

Dus, als ik een model was (zoals mijn moeder vindt dat ik zou moeten zijn), dan zou ik goed getraind zijn als ik honden zou herkennen als:

Harig, hangende oren, speels en een klein bruin knoopneusje.

Maar ik zou overfit zijn als ik ze alleen zou herkennen als:

Met een bruine vlek onder de kin, luistert naar de naam “Frank” en heeft mijn goede paar Nikes helemaal kapot gekauwd.

In de context van een LLM betekent dit meestal dat het model informatie uit de trainingsdata letterlijk herhaalt, in plaats van toe te geven als het het antwoord niet weet.

Stel je vraagt een chatbot naar het retourbeleid van een bedrijf. Als het dat niet weet, zou het dat moeten melden. Maar als het overfit is, geeft het misschien het beleid van een vergelijkbaar bedrijf.

Slechte prompting

Bedrijven geven certificaten uit in prompt engineering, omdat AI maar zo goed is als de input die het krijgt.

Een goede prompt is duidelijk geformuleerd, vermijdt vakjargon en geeft alle benodigde context.

Dit komt doordat hallucinaties ontstaan aan de rand van veel outputs met lage waarschijnlijkheid.

Stel je vraagt: “wat is het plot van shark girl?” Een mens denkt dan: “huh, shark girl.” In de statistiek zijn de mogelijkheden:

- The Adventures of Sharkboy and Lavagirl – een vrij populaire kinderfilm uit 2005 met een vergelijkbare naam.

- Een horror/thriller uit 2024 genaamd Shark Girl – minder bekend, maar recenter en accurater.

- Een kinderboek met dezelfde naam van eerder dit jaar – dat het model mogelijk wel of niet heeft geïndexeerd.

Geen van deze opties is duidelijk de juiste, wat leidt tot een “vlakkere” waarschijnlijkheidsverdeling met minder focus op één onderwerp of verhaallijn. Een effectievere prompt zou context geven, dus aangeven over welk voorbeeld de gebruiker het heeft.

Deze mix van vaagheid en zijdelingse relevantie kan een antwoord opleveren dat precies dat is: een verzonnen, algemeen plot van een verhaal over een haai.

De kans op hallucinaties verkleinen betekent onzekerheid verkleinen.

Soorten AI-hallucinaties

Tot nu toe heb ik hallucinaties in grote lijnen besproken. In werkelijkheid raakt het bijna alle aspecten van AI. Voor de duidelijkheid is het goed om de verschillende categorieën te onderscheiden.

Feitelijke fouten

Hier past het aardbei-voorbeeld bij. Er zijn fouten in details van verder feitelijke uitspraken. Dit kan gaan om het jaar waarin een gebeurtenis plaatsvond, de hoofdstad van een land of cijfers van een statistiek.

Kleine details in een verder goed antwoord kunnen verraderlijk zijn, vooral als het gaat om zaken die mensen zich vaak niet precies herinneren, zoals exacte cijfers.

Verzonnen inhoud

In 2023, claimde Google’s Bard onterecht dat de James Webb-telescoop de eerste foto’s van exoplaneten had gemaakt. Dit was geen technisch foutje – het was gewoon onwaar.

Dit kunnen grote beweringen zijn zoals hierboven, maar vaker zijn het bijvoorbeeld niet-bestaande URL’s of verzonnen codebibliotheken en functies.

Het is belangrijk te beseffen dat het verschil tussen feitelijke fouten en verzonnen inhoud niet altijd duidelijk is.

Stel dat we het over een onderzoeker hebben. Noemen we een publicatie van hen maar met het verkeerde jaartal, dan is dat een feitelijke fout. Maar wat als we de naam verkeerd hebben? En wat als zowel de naam als het jaartal niet kloppen?

Misleiding

Dit kan onder een van de twee vorige categorieën vallen, maar verwijst naar onjuiste informatie waarbij de bron duidelijker is.

Een bekend voorbeeld hiervan is Google AI die lijmpizza en stenen eten aanbeveelt; het bronmateriaal is duidelijk satirisch en onschuldig – Reddit-reacties geschreven door The Onion, maar het model was daar niet op getraind.

Risico’s van AI-hallucinaties

1. Vertrouwensverlies

We waarderen het gemak waarmee AI taken overneemt, maar niet als dat ten koste gaat van ons vertrouwen.

De recente fout van Cursor AI – een klantenservicebot die een strenge regel verzon – zorgde ervoor dat veel gebruikers hun abonnement opzegden en de betrouwbaarheid in twijfel trokken.

2. Kosten

AI speelt een steeds grotere rol in bedrijven, en dat is positief, maar een misstap kan duur uitpakken.

De James Webb-hallucinatie van Google leidde tot een waardedaling van $100 miljard van het Alphabet-aandeel in slechts een paar uur. En dat is nog vóór de kosten van het opnieuw trainen van de modellen.

3. Schadelijke misinformatie

We lachen om het idee van lijmpizza, maar wat als het gaat om verkeerde medische doseringen?

Ik ruil graag het lezen van kleine lettertjes vol waarschuwingen in voor een snel AI-antwoord. Maar wat als dat antwoord fout is? Het houdt vrijwel zeker geen rekening met alle mogelijke medische situaties.

3. Beveiliging en malware

Zoals genoemd verzint AI vaak namen van codebibliotheken. Probeer je een niet-bestaande bibliotheek te installeren, dan gebeurt er niets.

Stel je nu voor dat een hacker malware in code stopt en deze upload onder de naam van een vaak verzonnen bibliotheek. Jij installeert de bibliotheek, en 💨weg ben je💨: je bent gehackt.

Dit bestaat echt, en heet slopsquatting.

Afgezien van de rare naam, is het altijd verstandig kritisch te zijn op wat je installeert en exotisch klinkende bibliotheeknamen extra te controleren.

Stappen om AI-hallucinaties te voorkomen

Als je zelf geen modellen traint, kun je weinig doen aan de data of architectuur.

Het goede nieuws is dat er toch voorzorgsmaatregelen zijn die je kunt nemen, en die maken het verschil voor AI zonder hallucinaties.

Kies een model en platform dat je vertrouwt

Je staat er niet alleen voor. AI-bedrijven hebben er alle belang bij om vertrouwen te behouden, en dat betekent: geen hallucinaties.

Afhankelijk van wat je met AI doet, heb je bijna altijd meerdere opties, en een goed AI-platform maakt dit toegankelijk. Deze platforms moeten transparant zijn over hoe ze hallucinaties tegengaan.

Gebruik RAG (Retrieval-Augmented Generation)

Laat het model niet alleen op zijn eigen kennis vertrouwen. Door je model uit te rusten met RAG wordt duidelijk welke informatie beschikbaar is en waar die te vinden is.

Het is het beste om AI te draaien op een platform met eenvoudige instructies over hoe je effectieve RAG implementeert.

Geef duidelijke instructies

Je hebt het vast vaker gehoord: rommel erin, rommel eruit.

“Beantwoord de vraag van de gebruiker” garandeert geen succes. Maar iets als:

# Instructions

Please refer exclusively to the FAQ document. If the answer does not appear there:

* Politely inform the user that the information is unavailable.

* Offer to escalate the conversation to a human agent.zal je agent binnen de perken houden. Duidelijke prompts met strakke kaders zijn je beste verdediging tegen een ontsporende agent.

Menselijke verificatie

Als het om escalatie gaat, is het belangrijk dat er iemand klaarstaat om AI-resultaten te controleren, beoordelen en bij te sturen.

De mogelijkheid om gesprekken te escaleren of achteraf te controleren helpt je te bepalen wat werkt en waar risico op hallucinatie is. Human-in-the-loop – menselijke controle over AI-processen – is hier essentieel.

Gebruik vandaag nog AI zonder hallucinaties

Onzekerheid over de betrouwbaarheid van AI kan bedrijven tegenhouden bij digitale transformatie.

De RAG-functionaliteit, human-in-the-loop-integratie en sterke beveiliging van Botpress maken AI veilig en betrouwbaar. Jouw agent werkt voor jou, niet andersom.

Begin vandaag nog met bouwen. Het is gratis.

Veelgestelde vragen

1. Hoe kan ik herkennen of een AI-antwoord een hallucinatie is als ik geen voorkennis heb over het onderwerp?

Om te bepalen of een AI-antwoord een hallucinatie is zonder voorkennis, let op signalen zoals extreem specifieke beweringen, overdreven zelfverzekerde taal, of namen, statistieken of bronnen die niet onafhankelijk te verifiëren zijn. Twijfel je, vraag de AI om bronnen te noemen of controleer het antwoord bij betrouwbare externe bronnen.

2. Hoe vaak komen AI-hallucinaties voor bij grote taalmodellen (LLM’s)?

AI-hallucinaties komen vaak voor bij grote taalmodellen omdat ze tekst genereren op basis van waarschijnlijkheden, niet op feitelijke controle. Zelfs geavanceerde modellen als GPT-4o en Claude 3.5 kunnen onjuiste antwoorden geven, vooral bij niche-onderwerpen of weinig context.

3. Kunnen hallucinaties ook voorkomen bij niet-tekstgebaseerde AI-modellen zoals beeldgeneratoren?

Ja, hallucinaties komen ook voor bij beeldgeneratiemodellen, vaak als onrealistische of onzinnige elementen in het resultaat – zoals extra ledematen of foutieve culturele weergaven – veroorzaakt door vooroordelen of hiaten in de trainingsdata.

4. Komen hallucinaties vaker voor in bepaalde talen of culturen door vooroordelen in de trainingsdata?

Hallucinaties komen vaker voor in ondervertegenwoordigde talen of niet-westerse culturen, omdat de meeste LLM’s vooral getraind zijn op Engels en westers-georiënteerde data, wat leidt tot minder cultureel genuanceerde antwoorden.

5. Welke sectoren lopen het meeste risico door de gevolgen van AI-hallucinaties?

Sectoren als gezondheidszorg, financiën, recht en klantenservice lopen het meeste risico door AI-hallucinaties, omdat onjuiste antwoorden hier kunnen leiden tot nalevingsproblemen, financiële schade, juridische fouten of verlies van vertrouwen en reputatie.

.webp)