- 当模型自信地生成错误或捏造的信息时,就会出现人工智能幻觉,这是由数据质量差、过度拟合或模棱两可的提示造成的。

- 幻觉的范围从事实错误到捏造内容不等,可能会损害信任,使企业损失数十亿美元,或传播有害的错误信息。

- 关键的预防步骤包括选择可靠的人工智能平台、增加检索增强生成(RAG)、制作精确的提示以及纳入人工监督。

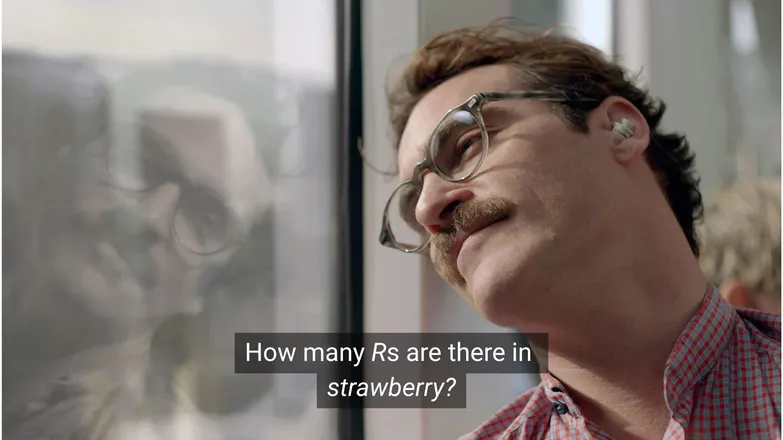

如果华金-菲尼克斯(Joaquin Phoenix)问斯嘉丽-约翰逊(Scarlett Johansson)草莓里有几个R,你觉得他会爱上她吗?如果你在 LinkedIn 上,你就会知道答案是 3(或者,你知道,如果你识字的话)。

但对于人工智能聊天机器人来说,事情并不总是那么简单。

你可能见过有人嘲笑人工智能幻觉的荒谬性。平心而论,一个拥有看似无穷无尽的知识、类似人类的推理能力和快如闪电的任务执行能力的人工智能模型,却在一个幼儿园水平的数学问题上失败了,这确实有点荒谬。

但是,在欢乐和游戏的背后,却隐藏着一个更严重、更隐蔽的现实。

在这篇文章中,我将谈谈人工智能幻觉--它们是什么、产生幻觉的原因、为什么会产生幻觉以及可以采取哪些措施来预防幻觉。

什么是人工智能幻觉?

人工智能幻觉是指人工智能模型呈现出不准确、误导性或完全捏造的信息。这些虚假信息看似可信,在很多情况下不会被发现。

由于LLMs被广泛采用,幻觉最常在生成文本模型中被提及。实际上,它们对生成式人工智能的任何应用都构成风险。

人工智能产生幻觉的原因是什么?

当模型学习到错误的模式时,人工智能就会产生幻觉。

就人工智能而言,模式指的是利用单个训练实例在未见数据中进行归纳的能力。这可以是一系列单词组成的文本续篇,也可以是对应于一只狗的图像像素分布。

在LLM 幻觉的案例中,模型认为用户提示后最有可能出现的是一连串单词,尽管这是假的。

这可能是以下一个或多个原因造成的:

低质量训练数据

ChatGPT和类似的LLMs 是在大量数据的基础上训练出来的。这些数据虽多,但并不完美,原因如下

- 某些专题存在空白

- 反映现实世界的偏见

- 蓄意误导或无标记讽刺

- 偏差,指数据不平衡或 "一边倒"。

假设模型是根据除一个希腊神之外的所有其他神的信息训练出来的。

它有能力在类似希腊神话的主题--爱情、伦理、背叛--之间建立统计联系,这可能会导致它根据自己的统计模型,将一些它认为 "有可能 "的虚构神话串联起来。

这一点在图像生成中也很明显,大多数以女性为主题的提示都会生成过度性化的图像。对某一特定描绘类型的偏爱 决定了生成的图像类型。

草莓的拼写很可能是在讨论双R 时出现在训练数据中的,而双R 是非英语母语者众所周知的痛点。在这种情况下,数字2或单词 "double "很可能与该单词的拼写有关。

另一方面,数据也不太可能提到它有 3 个R。

输出结果是荒谬的,因为提示是:在什么情况下会有人写一个单词,然后询问它是如何拼写的?

模型结构和生成方法

这些模型由极其复杂的神经网络架构构建而成。细微的变化会影响模型与训练数据和输入提示的 交互方式。通过严格的研究和测试,模型缓解幻觉的能力会逐步提高。

其次是如何实现生成。模型会逐字(实际上是逐词)预测最有可能出现的词。因此:

"敏捷的棕狐狸跳过懒惰的____"

将确定下一个词最有可能是 "狗"。但也有可能是其他词。而仅仅根据最有可能出现的下一个单词来进行生成,会产生无趣的、可预测的结果。

这就意味着必须采用创造性的取样方法,使回答既精彩又连贯。在这样做的过程中,事实性有时会被遗漏。

过度拟合

过度拟合是指模型被训练得非常接近于预测数据,以至于无法泛化到新的输入。

所以,如果我是一个模特(我妈妈说我应该是),那么我就会是一个训练有素的模特,如果我能认出狗来:

毛茸茸的,耳朵耷拉着,很顽皮,还有一个棕色的小纽扣鼻子。

但是,如果我只认识到他们是:

它的下巴下有一个棕色小点,名叫 "弗兰克",还把我的一双好耐克鞋咬坏了。

在 LLM的情况下,它通常会重复在训练数据中看到的信息,而不是在不知道答案的地方后退。

假如你向聊天机器人询问一家公司的退货政策。如果它不知道,就应该告诉你。但如果它不太合适,它可能会返回类似公司的政策。

提示不佳

公司正在颁发及时工程证书,因为他们知道,人工智能的好坏取决于其投入。

一个表述准确的提示应避免使用小众术语,并提供所有必要的背景。

这是因为幻觉发生在许多低概率输出的边缘。

如果你问 "鲨鱼女孩的情节是什么?"现在,人类会想 "啊,鲨鱼女孩"在统计世界里,可能性有:

- 鲨鱼男孩和岩浆女孩历险记》(The Adventures of Sharkboy and Lavagirl)--2005 年的一部颇受欢迎的儿童电影,名字也很相似。

- 一部名为《鲨鱼女孩》的 2024 年恐怖/惊悚片--不那么受欢迎,但更新颖、更准确。

- 今年早些时候的一本同名儿童读物--该书的范本可能已编入索引,也可能尚未编入索引。

这些都不是显而易见的选择,导致概率分布 "扁平化",对某一主题或叙述的承诺较少。更有效的提示方式是提供上下文,即阐明用户指的是哪个例子。

这种模棱两可和切题相关性的汤汁可能会产生这样的反应:为一个与鲨鱼有关的故事编造一个通用情节。

降低出现幻觉的几率就是降低不确定性。

人工智能幻觉的类型

到目前为止,我只是笼统地谈论了幻觉。实际上,它几乎涉及人工智能的所有方面。不过,为了清晰起见,最好还是考虑一下不同的类别。

事实错误

草莓的例子就说明了这一点。事实陈述的细节存在错误。这些错误可能包括某个事件发生的年份、某个国家的首都或某个统计数据的数字。

在一个原本很好的回复中,一些微小的细节可能特别隐蔽,尤其是当涉及到人类不常记住的细节时,比如精确的数字。

制作内容

2023 年,谷歌的 "巴德 "网站谎称詹姆斯-韦伯望远镜拍摄了第一张系外行星照片。这不是技术不准确的问题,而是纯粹的谎言。

这些可能是如上所述的大胆声明,但更多的是以不知去向的 URL 或编造的代码库和函数的形式出现。

值得注意的是,事实错误和编造内容之间的界限并不总是很明显。

假设我们在讨论一位研究人员。如果我们引用了他们的一篇论文,但弄错了年份,这就是事实错误。如果我们弄错了名字,那又怎样?那名字和 年份呢?

错误信息

这可能属于前两类中的任何一类,但指的是来源更加透明的虚假信息。

谷歌人工智能推荐用胶水粘披萨和吃石头就是一个很好的例子;源材料显然是讽刺性的,而且一般都是无害的--由《洋葱》撰写的 Reddit 评论,但模型的训练并没有考虑到这一点。

人工智能幻觉的风险

1.失去信任

我们欣赏将任务交给人工智能的自由,但不能以牺牲我们的信任为代价。

Cursor AI 最近的一次事故--客服机器人发明了一项限制性政策--导致许多用户取消订阅,质疑其可靠性。

2.费用

人工智能已在许多企业中占据前沿位置,这固然是件好事,但一不小心就会付出高昂的代价。

谷歌的詹姆斯-韦伯(James Webb)幻觉导致 Alphabet 的股票在几个小时内下跌了 1000 亿美元。这还不算重新训练模型的费用。

3.有害的错误信息

我们嘲笑胶水披萨的荒谬,但误导性的医疗剂量又如何呢?

我是第一个为了人工智能的快速回答而放弃阅读充满警告的详细说明的人。但如果它是错的呢?它几乎肯定不会考虑到所有可能的医疗状况。

3.安全和恶意软件

如前所述,人工智能经常会编造代码库的名称。当你试图安装一个不存在的库时,什么也不会发生。

现在想象一下,黑客将恶意软件嵌入代码,并以一个常见的库的名称上传。你安装了这个库,然后💨噗💨:你被黑了。

这就是所谓的 "泔水抢注"。

撇开这些恶心的名字不说,对你安装的软件进行严格的检查,并仔细核对任何听起来很奇特的库名,总不会有什么坏处。

预防人工智能幻觉的步骤

如果不对模型进行训练,在数据和架构方面就没什么可做的。

好消息是,您仍然可以采取一些预防措施,它们可以让您的人工智能无幻觉。

选择值得信赖的模式和平台

你并非孤立无援。人工智能公司非常希望保持信任,这就意味着不能出现幻觉。

根据您使用人工智能所做的工作,您几乎总是至少有几种选择,而一个好的人工智能平台可以让您获得这些选择。这些平台在如何减少幻觉方面应该是透明的。

使用 RAG(检索-增强生成)

不要让模型依赖自己的知识。为模型配备RAG,可以清楚地显示可用信息以及在哪里可以找到这些信息。

最好在一个平台上运行人工智能,该平台上有关于如何实施有效 RAG 的简单说明。

添加详细说明

如果你听过一次,你就会听过无数次:垃圾进,垃圾出。

"回答用户的问题 "并不能保证成功。然而,类似于

# 说明

请专门参阅常见问题文档。如果答案不在这里:

* 礼貌地告知用户该信息不可用。

* 主动将对话升级到人工代理。会让你的代理保持克制。明确的提示加上坚定的警戒线,是你抵御无赖代理的最好办法。

人类验证

关于升级的问题,要有专人随时检查、评估和消除人工智能的缺点。

升级或追溯验证对话的能力可以让你找出哪些是有效的,哪些是可能出现幻觉的。人工智能驱动的工作流程必须有 "人在回路中"(Human-in-the-loop)的监督。

立即使用无幻觉人工智能

人工智能可靠性的不确定性可能会阻碍企业进行数字化转型。

Botpress的 RAG 功能、人环集成和全面的安全系统使人工智能安全可靠。您的代理为您工作,而不是相反。

常见问题

1.在没有相关知识的情况下,如何判断人工智能的反应是否是幻觉?

要分辨人工智能的反应是否是事先不了解情况下的幻觉,要留意一些迹象,比如极其具体的说法、过于自信的语言,或者无法独立验证的名称、统计数据或引文。如果不确定,请提示人工智能引用其来源或与可靠的外部参考资料进行交叉核对。

2.人工智能幻觉在大型语言模型LLMs)中有多常见?

人工智能幻觉在大型语言模型中很常见,因为它们是根据概率而不是事实验证来生成文本的。即使是像GPT 和 Claude 3.5 这样的高级模型,也会产生不准确的输出,尤其是在被问及小众话题或低语境的情况下。

3.图像生成器等非文本人工智能模型会产生幻觉吗?

是的,在图像生成模型中也会出现幻觉,通常是由于训练数据中的偏差或空白导致输出中出现不现实或无意义的元素,如多余的肢体或不正确的文化表述。

4.由于训练数据的偏差,幻觉是否在某些语言或文化中更为常见?

幻觉在代表性不足的语言或非西方文化背景中更为常见,因为大多数LLMs 主要接受英语和以西方为中心的数据培训,导致他们做出的反应缺乏文化细微差别。

5.哪些行业最容易受到人工智能幻觉的影响?

医疗保健、金融、法律和客户服务等行业最容易受到人工智能幻觉的影响,因为在这些领域,不准确的输出可能会导致合规违规、经济损失、法律失误,或损害用户信任和品牌声誉。

.webp)

.webp)