- RAG 将可信数据检索与LLM 生成相结合,确保人工智能响应准确、相关,并以真实业务知识为基础。

- 与纯粹的LLMs 不同,RAG 通过将答案锚定在特定文件、数据库或经批准的内容上,从而减少幻觉。

- RAG 支持最新信息,使人工智能系统能够回答有关最近变化或利基主题的问题,而不局限于LLM的静态训练数据。

- RAG 系统的维护包括保持数据的新鲜度、监控输出和改进检索方法,以便随着时间的推移获得最佳性能。

与传统的LLM 使用方式相比,RAG 允许企业在风险较低的情况下使用人工智能。

随着越来越多的企业引入人工智能解决方案,检索增强一代正变得越来越流行。早期的企业聊天机器人曾出现过危险的错误和幻觉。

RAG 允许公司利用LLMs 的力量,同时将生成性产出建立在其特定业务知识的基础上。

什么是检索增强生成?

人工智能中的检索增强生成(RAG)是一种技术,它将 a) 检索相关外部信息和 b) 人工智能生成的响应结合起来,从而提高了准确性和相关性。

RAG 模型不依赖于大型语言模型(LLMs )的生成,而是根据人工智能代理构建者提供的知识库(如公司网页或人力资源政策文件)做出响应。

RAG 的运行分为两个主要步骤:

1.检索

该模型可从结构化或非结构化来源(如数据库、PDF、HTML 文件或其他文档)中搜索和检索相关数据。这些数据源可以是结构化的(如表格),也可以是非结构化的(如经过批准的网站)。

2.生成

检索完成后,信息被输入LLM 。LLM 利用这些信息生成自然语言回复,将核准的数据与自身的语言能力相结合,创建准确、类似人类和符合品牌的回复。

RAG 使用案例举例

RAG 有什么作用?它使组织能够提供相关、翔实和准确的产出。

RAG 是降低LLM 输出不准确或产生幻觉风险的直接方法。

示例 1:律师事务所

律师事务所可以在人工智能系统中使用 RAG,以便

- 在研究过程中,从文件数据库中搜索相关判例法、先例和法律裁决。

- 从案件卷宗和过去的裁决中提取关键事实,生成案件摘要。

- 自动为员工提供相关的监管更新。

示例 2:房地产中介

房地产公司可能会在人工智能系统中使用 RAG,以便

- 总结物业交易历史数据和社区犯罪统计数据。

- 引用当地的房地产法律法规,回答有关房地产交易的法律问题。

- 通过从财产状况报告、市场趋势和历史销售中提取数据,简化评估流程。

示例 3:电子商务商店

电子商务可以在人工智能系统中使用 RAG,以便

- 从公司数据库中收集产品信息、规格和评论,为个性化产品推荐提供依据。

- 检索订单历史记录,生成符合用户偏好的定制购物体验。

- 通过检索客户细分数据并将其与最近的购买模式相结合,生成有针对性的电子邮件营销活动。

RAG 的优点

查询过 ChatGPT或 Claude 的人都知道,LLMs 内置的保障措施少之又少。

如果没有适当的监督,它们可能会产生不准确甚至有害的信息,使其在实际部署中变得不可靠。

RAG 提供了一种解决方案,它以可信的最新数据源为基础进行响应,大大降低了这些风险。

防止幻觉和误差

传统的语言模型往往会产生幻觉,即听起来令人信服,但实际上不正确或不相关的回答。

RAG 通过将反应建立在可靠和高度相关的数据源基础上,减少了幻觉。

检索步骤可确保模型引用准确的最新信息,从而大大降低出现幻觉的几率,提高可靠性。

检索最新信息

虽然LLMs 是执行许多任务的强大工具,但它无法提供有关稀有或最新信息(包括定制的业务知识)的准确信息。

但 RAG 允许模型从任何来源获取实时信息,包括网站、表格或数据库。

这就确保了,只要真实信息源更新,模型就会响应最新信息。

在复杂环境中交流

传统LLM 使用的另一个弱点是会丢失上下文信息。

在冗长或复杂的对话中,LLMs 很难保持语境。这往往会导致回答不完整或支离破碎。

但是,RAG 模型可以直接从语义关联的数据源中提取信息,从而实现上下文感知。

有了专门针对用户需求的额外信息--比如配备了产品目录的销售聊天机器人--RAG 允许人工智能代理参与情境对话。

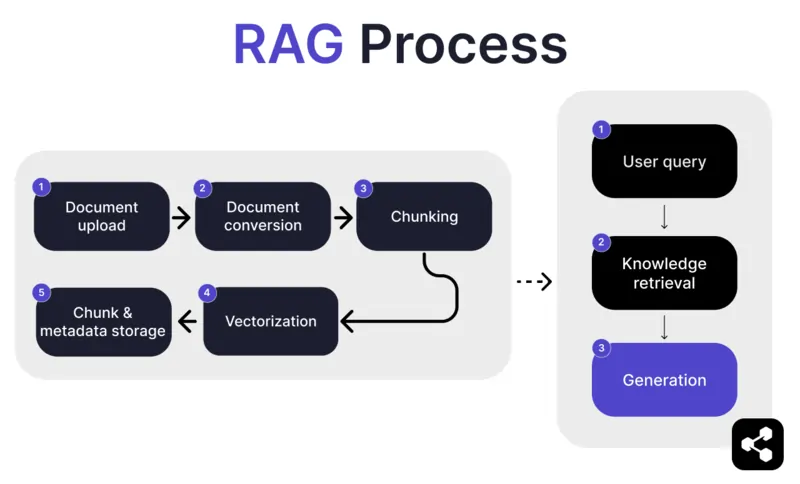

RAG 如何工作?

1.文件上传

首先,创建者将文档或文件上传到人工智能代理库中。文件可以是网页、PDF 或其他受支持的格式,这些文件构成了人工智能知识库的一部分。

2.文件转换

由于文件类型众多,如 PDF、网页等。- 系统会将这些文件转换成标准化的文本格式,使人工智能更容易处理和检索相关信息。

3.分块和存储

然后,转换后的文档会被分解成更小的、易于管理的片段或块。这些小块存储在数据库中,使人工智能代理能够在查询时有效地搜索和检索相关部分。

4.用户查询

建立知识库后,用户可以向人工智能代理提问。人工智能代理会使用自然语言处理技术(NLP)来处理查询,以理解用户的问题。

5.知识检索

人工智能代理会搜索存储的信息块,利用检索算法从上传的文件中找到与用户问题最相关的信息。

6.一代人

最后,人工智能代理将把检索到的信息与其语言模型能力结合起来,根据查询和检索到的数据,生成一个连贯的、符合上下文的准确答案。

高级 RAG 功能

如果您不是开发人员,您可能会惊讶地发现,并非所有的 RAG 都是一样的。

不同的系统会根据自己的需求、用例或技能能力建立不同的 RAG 模型。

有些人工智能平台会提供高级 RAG 功能,可进一步提高人工智能软件的准确性和可靠性。

语义分块与天真分块

裸分块是指将文档分割成固定大小的片段,如将文本切割成 500 个单词的部分,而不考虑意义或上下文。

语义分块则是根据内容将文档分成有意义的部分。

它考虑了自然分隔,如段落或主题,确保每个分块包含连贯的信息。

强制性引文

对于利用人工智能自动进行高风险对话的行业(如金融或医疗保健)来说,引用可以帮助用户在接收信息时建立信任。

开发人员可指示其 RAG 模型为发送的任何信息提供引文。

例如,如果员工向人工智能聊天机器人询问有关健康福利的信息,聊天机器人可以做出回应,并提供相关员工福利文件的链接。

定制 RAG 人工智能代理

将最新的LLMs 与您独特的企业知识相结合。

Botpress 是一个灵活且可无限扩展的人工智能聊天机器人平台。

它允许用户为任何用例构建任何类型的人工智能代理或聊天机器人,并提供市场上最先进的 RAG 系统。

将您的聊天机器人集成到任何平台或频道,或从我们预建的集成库中选择。从Botpress YouTube 频道的教程或Botpress Academy 的免费课程开始学习。

今天就开始建设。它是免费的。

常见问题

1.RAG 与微调LLM 有何不同?

RAG(检索增强生成)与微调不同,因为 RAG 保持原始LLM 不变,并在运行时通过检索相关文档注入外部知识。微调则是利用训练数据修改模型的权重,这需要更多的计算,而且每次更新都必须重复。

2.哪些数据源不适合 RAG?

不适合用于 RAG 的数据源包括非文本格式,如扫描文档、基于图像的 PDF、无文字记录的音频文件以及过时或相互冲突的内容。这些类型的数据会降低检索上下文的准确性。

3.RAG 与提示工程等情境学习技术相比有何优势?

RAG 与提示工程不同,它在查询时从一个大型索引知识库中检索相关内容,而不是依赖于提示中人工嵌入的静态示例。这使得 RAG 能够更好地扩展,并在无需重新培训的情况下保持最新知识。

4.我能将 RAG 与OpenAI、Anthropic 或 Mistral 等第三方LLMs 一起使用吗?

是的,您可以将 RAG 与OpenAI、Anthropic、Mistral 或其他LLMs 结合使用,方法是独立处理检索管道,并通过其 API 将检索到的上下文发送给LLM 。只要LLM 支持通过提示接收上下文输入,RAG 就与模型无关。

5.支持 RAG 的人工智能代理的持续维护是怎样的?

支持 RAG 的人工智能代理的持续维护包括用新文档或更正文档更新知识库、定期重新索引内容、评估检索质量、调整分块大小和嵌入方法,以及监控代理的响应是否存在漂移或幻觉问题。

.webp)

%20(1).webp)