- AI-Halluzination tritt auf, wenn Modelle selbstbewusst falsche oder erfundene Informationen liefern. Ursachen sind schlechte Datenqualität, Überanpassung oder unklare Eingaben.

- Halluzinationen reichen von sachlichen Fehlern bis hin zu erfundenen Inhalten und können das Vertrauen schädigen, Unternehmen Milliarden kosten oder schädliche Fehlinformationen verbreiten.

- Wichtige Maßnahmen zur Vermeidung sind die Auswahl zuverlässiger KI-Plattformen, der Einsatz von Retrieval-Augmented Generation (RAG), präzise formulierte Eingaben und menschliche Kontrolle.

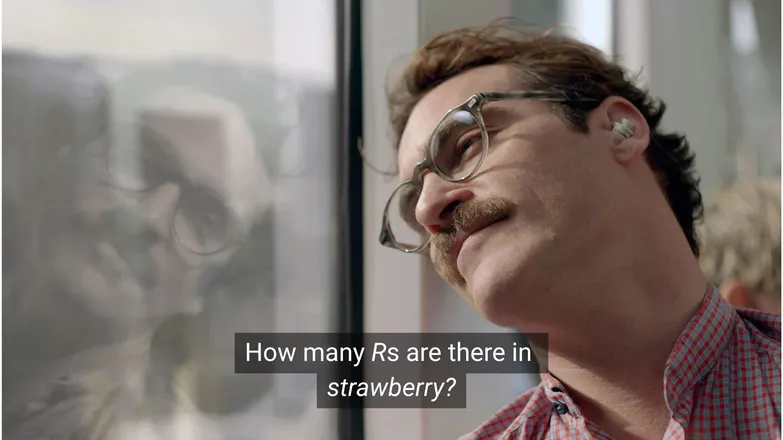

Glaubst du, Joaquin Phoenix hätte sich in Scarlett Johansson verliebt, wenn er sie gefragt hätte, wie viele R im Wort strawberry vorkommen? Wer auf LinkedIn ist, weiß, dass die Antwort 3 ist. (Oder, na ja, wer lesen kann.)

Für AI-Chatbots ist es jedoch nicht immer so einfach.

Wahrscheinlich hast du schon gesehen, wie sich Leute über die Absurdität von KI-Halluzinationen lustig machen. Und zugegeben: Es ist schon seltsam, wenn ein scheinbar allwissendes KI-Modell mit menschenähnlicher Logik und blitzschneller Ausführung an einer Matheaufgabe auf Kindergarten-Niveau scheitert.

Doch hinter dem Spaß steckt eine ernstere – und potenziell gefährliche – Realität.

In diesem Artikel spreche ich über KI-Halluzinationen: Was sie sind, wie sie entstehen, warum sie relevant sind und wie man sie verhindern kann.

Was ist eine KI-Halluzination?

Eine KI-Halluzination liegt vor, wenn ein KI-Modell Informationen präsentiert, die ungenau, irreführend oder komplett erfunden sind. Diese falschen Informationen können plausibel wirken und bleiben oft unentdeckt.

Durch die weite Verbreitung von LLMs werden Halluzinationen meist im Zusammenhang mit generativen Textmodellen genannt. Tatsächlich stellen sie jedoch bei jeder Anwendung von Generativer KI ein Risiko dar.

Was verursacht Halluzinationen bei KI?

KI-Halluzinationen entstehen, wenn Modelle falsche Muster erlernen.

Muster bezeichnen im KI-Kontext die Fähigkeit, anhand einzelner Trainingsbeispiele auf unbekannte Daten zu verallgemeinern. Das kann eine Wortreihe zur Fortsetzung eines Textes sein oder die Verteilung von Bildpixeln, die zu einem Hund gehören.

Bei Halluzinationen von LLMs hält das Modell eine bestimmte Wortfolge für die wahrscheinlichste Antwort auf die Nutzereingabe – auch wenn sie falsch ist.

Das kann aus einem oder mehreren der folgenden Gründe passieren:

Schlechte Trainingsdaten

ChatGPT und ähnliche LLMs werden mit riesigen Datenmengen trainiert. Diese Daten sind trotz ihrer Menge nicht perfekt, weil sie:

- Lücken bei bestimmten Themen haben

- Vorurteile aus der realen Welt widerspiegeln

- Absichtliche Fehlinformationen oder nicht gekennzeichnete Satire enthalten

- Voreingenommen sind, also unausgewogene oder „schiefe“ Daten darstellen.

Stell dir vor, das Modell wurde mit Informationen zu allen griechischen Göttern außer einem trainiert.

Seine Fähigkeit, statistische Zusammenhänge zwischen Themen der griechischen Mythologie – Liebe, Ethik, Verrat – herzustellen, könnte dazu führen, dass es eine erfundene Mythologie konstruiert, die es für „wahrscheinlich“ hält.

Das zeigt sich auch bei der Bildgenerierung, wo die meisten Prompts für weibliche Motive übersexualisierte Bilder erzeugen. Die Voreingenommenheit gegenüber einer bestimmten Darstellung beeinflusst, welche Bilder generiert werden.

Die Schreibweise von strawberry ist in den Trainingsdaten vermutlich im Zusammenhang mit der doppelten R aufgetaucht, einem bekannten Stolperstein für Nicht-Muttersprachler. In diesem Fall sind die Zahl 2 oder das Wort „double“ wahrscheinlich im Zusammenhang mit der Schreibweise des Wortes aufgetaucht.

Andererseits ist es unwahrscheinlich, dass in den Daten erwähnt wurde, dass es 3 R hat.

Das Ergebnis ist absurd, weil der Prompt lautet: Unter welchen Umständen schreibt jemand ein Wort und fragt dann nach dessen Schreibweise?

Modellarchitektur und Generierungsmethode

Die Modelle basieren auf äußerst komplexen neuronalen Netzwerk-Architekturen. Schon kleine Unterschiede beeinflussen, wie Modelle mit ihren Trainingsdaten und Eingaben interagieren. Die Fähigkeit eines Modells, Halluzinationen zu vermeiden, lässt sich durch schrittweise Verbesserungen und intensive Forschung sowie Tests steigern.

Hinzu kommt die Art der Generierung. Wort für Wort (genauer gesagt Wort-Teile) sagen Modelle das wahrscheinlichste nächste Wort voraus. Zum Beispiel:

„Der schnelle braune Fuchs springt über den faulen ___.“

Das wahrscheinlichste nächste Wort ist „Hund“. Aber auch andere Wörter sind möglich. Eine Generierung, die sich nur am wahrscheinlichsten nächsten Wort orientiert, liefert jedoch langweilige, vorhersehbare Ergebnisse.

Deshalb werden kreative Sampling-Methoden eingesetzt, um Antworten spannend und dennoch sinnvoll zu halten. Dabei kann die Faktentreue manchmal verloren gehen.

Überanpassung

Überanpassung bedeutet, dass das Modell die Trainingsdaten so exakt vorhersagt, dass es bei neuen Eingaben nicht mehr verallgemeinern kann.

Wenn ich also ein Modell wäre (wie meine Mutter meint, ich es sein sollte), wäre ich gut trainiert, wenn ich Hunde erkenne als:

Flauschig, mit Schlappohren, verspielt und einer kleinen braunen Knopfnase.

Aber ich wäre überangepasst, wenn ich sie nur erkenne als:

Mit einem braunen Punkt unter dem Kinn, hört auf den Namen „Frank“ und hat meine guten Nikes komplett zerbissen.

Bei einem LLM äußert sich das meist darin, dass es Informationen aus den Trainingsdaten wiederholt, statt zuzugeben, wenn es etwas nicht weiß.

Wenn du einen Chatbot nach der Rückgaberegelung eines Unternehmens fragst und er es nicht weiß, sollte er dich darauf hinweisen. Ist er jedoch überangepasst, gibt er vielleicht die Regelung eines ähnlichen Unternehmens aus.

Schlechte Prompts

Unternehmen vergeben inzwischen Zertifikate im Prompt Engineering, weil KI nur so gut ist wie ihre Eingaben.

Ein gut formulierter Prompt ist klar, vermeidet Fachjargon und liefert alle nötigen Informationen.

Denn Halluzinationen entstehen oft an den Rändern vieler wenig wahrscheinlicher Ausgaben.

Wenn du zum Beispiel fragst: „Worum geht es in shark girl?“ Ein Mensch denkt: „Hm, shark girl.“ Statistisch gesehen gibt es mehrere Möglichkeiten:

- The Adventures of Sharkboy and Lavagirl – ein ziemlich bekannter Kinderfilm von 2005 mit ähnlichem Namen.

- Ein Horror-/Thrillerfilm von 2024 namens Shark Girl – weniger bekannt, aber aktueller und zutreffender.

- Ein Kinderbuch mit demselben Namen aus diesem Jahr – das das Modell vielleicht kennt oder auch nicht.

Keine dieser Optionen ist eindeutig, was zu einer „flacheren“ Wahrscheinlichkeitsverteilung führt, bei der sich das Modell weniger auf ein Thema festlegt. Ein effektiverer Prompt würde Kontext liefern, also klarstellen, auf welches Beispiel sich der Nutzer bezieht.

Diese Mischung aus Unklarheit und Randbezug kann dazu führen, dass eine Antwort entsteht, die genau das ist: eine erfundene, generische Handlung zu einer Hai-Geschichte.

Die Wahrscheinlichkeit von Halluzinationen zu verringern bedeutet, Unsicherheiten zu reduzieren.

Arten von KI-Halluzinationen

Bisher habe ich Halluzinationen allgemein beschrieben. Tatsächlich betreffen sie fast alle Bereiche der KI. Zur besseren Übersicht ist es sinnvoll, verschiedene Kategorien zu betrachten.

Sachliche Fehler

Hier passt das Erdbeer-Beispiel. Es handelt sich um Fehler in Details ansonsten richtiger Aussagen – etwa das Jahr eines Ereignisses, die Hauptstadt eines Landes oder eine Statistik.

Kleine Details in ansonsten guten Antworten können besonders tückisch sein, vor allem bei Fakten, die Menschen selten im Kopf haben, wie genaue Zahlen.

Erfundene Inhalte

Im Jahr 2023 behauptete Google Bard fälschlicherweise, das James-Webb-Teleskop sei für die ersten Aufnahmen von Exoplaneten verwendet worden. Das war kein technischer Fehler – es war schlichtweg falsch.

Solche Aussagen können wie oben sehr gewagt sein, treten aber häufiger als nicht existierende URLs oder erfundene Code-Bibliotheken und Funktionen auf.

Es ist wichtig zu wissen, dass die Grenze zwischen sachlichen Fehlern und erfundenen Inhalten oft nicht eindeutig ist.

Nehmen wir an, wir sprechen über eine Forscherin. Wenn wir eine ihrer Veröffentlichungen zitieren, aber das Jahr falsch angeben, ist das ein sachlicher Fehler. Aber was, wenn wir den Namen falsch haben? Und was, wenn sowohl Name als auch Jahr nicht stimmen?

Falschinformationen

Das kann in eine der beiden vorherigen Kategorien fallen, bezieht sich aber auf falsche Informationen, bei denen die Quelle transparenter ist.

Ein bekanntes Beispiel ist, dass Google AI Kleber auf Pizza und das Essen von Steinen empfohlen hat; die Quelle war offensichtlich satirisch und harmlos – Reddit-Kommentare, geschrieben von The Onion, aber das Training des Modells hatte das nicht berücksichtigt.

Risiken von KI-Halluzinationen

1. Vertrauensverlust

Wir schätzen es, Aufgaben an KI abzugeben, aber nicht auf Kosten unseres Vertrauens.

Ein aktueller Vorfall bei Cursor AI – ein Kundenservice-Bot, der eine restriktive Richtlinie erfand – führte dazu, dass viele Nutzer ihr Abonnement kündigten und die Zuverlässigkeit infrage stellten.

2. Kosten

KI spielt in vielen Unternehmen eine zentrale Rolle, was grundsätzlich positiv ist – aber Fehler können teuer werden.

Die James-Webb-Halluzination von Google führte innerhalb weniger Stunden zu einem Wertverlust von 100 Milliarden Dollar bei Alphabet. Und das noch vor den Kosten für das erneute Training der Modelle.

3. Schädliche Falschinformationen

Wir lachen über absurde Dinge wie Kleber auf Pizza, aber wie sieht es mit irreführenden medizinischen Dosierungen aus?

Ich würde sofort den kleingedruckten Warnhinweisen den Rücken kehren und stattdessen eine schnelle Antwort von der KI bevorzugen. Aber was, wenn sie falsch ist? Sie wird mit hoher Wahrscheinlichkeit nicht alle medizinischen Bedingungen berücksichtigen.

3. Sicherheit und Schadsoftware

Wie erwähnt, denkt sich KI oft Namen für Code-Bibliotheken aus. Wenn Sie versuchen, eine nicht existierende Bibliothek zu installieren, passiert nichts.

Stellen Sie sich nun vor, ein Hacker versteckt Schadsoftware in einem Code und lädt ihn unter dem Namen einer häufig halluzinierten Bibliothek hoch. Sie installieren die Bibliothek und 💨zack💨: Sie wurden gehackt.

Das gibt es tatsächlich und nennt sich slopsquatting.

Abgesehen vom unschönen Namen: Es schadet nie, kritisch zu sein, was man installiert, und exotisch klingende Bibliotheksnamen doppelt zu überprüfen.

Maßnahmen zur Vermeidung von KI-Halluzinationen

Wenn Sie die Modelle nicht selbst trainieren, können Sie an den Daten und der Architektur wenig ändern.

Die gute Nachricht: Es gibt dennoch Vorsichtsmaßnahmen, die Sie treffen können – und sie machen den Unterschied, wenn Sie KI ohne Halluzinationen einsetzen wollen.

Wählen Sie ein vertrauenswürdiges Modell und eine vertrauenswürdige Plattform

Sie sind nicht allein. KI-Anbieter haben ein großes Interesse daran, Vertrauen zu erhalten – das bedeutet: keine Halluzinationen.

Je nachdem, was Sie mit KI machen, haben Sie fast immer mehrere Optionen. Eine gute KI-Plattform macht diese zugänglich. Diese Plattformen sollten transparent darlegen, wie sie Halluzinationen verhindern.

Nutzen Sie RAG (Retrieval-Augmented Generation)

Lassen Sie das Modell nicht nur auf sein eigenes Wissen vertrauen. Mit RAG stellen Sie sicher, dass Informationen verfügbar sind und klar ist, wo sie zu finden sind.

Am besten nutzen Sie eine KI-Plattform mit einfachen Anleitungen, wie Sie RAG effektiv implementieren.

Geben Sie ausführliche Anweisungen

Sie haben es sicher schon tausendmal gehört: Garbage in, garbage out.

„Beantworte die Frage des Nutzers“ reicht nicht aus. Aber eine Anweisung wie:

# Instructions

Please refer exclusively to the FAQ document. If the answer does not appear there:

* Politely inform the user that the information is unavailable.

* Offer to escalate the conversation to a human agent.hält Ihren Agenten auf Kurs. Klare Prompts mit festen Leitplanken sind der beste Schutz vor einem aus dem Ruder laufenden Agenten.

Menschliche Überprüfung

Wenn es um Eskalation geht, sollte eine Person bereitstehen, um die Schwächen der KI zu prüfen, zu bewerten und zu beheben.

Die Möglichkeit, Gespräche zu eskalieren oder nachträglich zu überprüfen, hilft Ihnen zu erkennen, was funktioniert und wo Halluzinationsgefahr besteht. Human-in-the-loop – menschliche Kontrolle von KI-gestützten Abläufen – ist hier unverzichtbar.

Nutzen Sie heute schon halluzinationsfreie KI

Unsicherheit über die Zuverlässigkeit von KI hält Unternehmen möglicherweise von der digitalen Transformation ab.

Die RAG-Funktionen von Botpress, die Integration von Human-in-the-loop und umfassende Sicherheitsmechanismen machen KI sicher und zuverlässig. Ihr Agent arbeitet für Sie, nicht umgekehrt.

Jetzt loslegen. Kostenlos.

FAQs

1. Wie erkenne ich, ob eine KI-Antwort eine Halluzination ist, wenn ich mich mit dem Thema nicht auskenne?

Um zu erkennen, ob eine KI-Antwort eine Halluzination ist, achten Sie auf extrem spezifische Behauptungen, übertrieben selbstsichere Formulierungen oder Namen, Statistiken und Quellenangaben, die sich nicht unabhängig überprüfen lassen. Im Zweifel bitten Sie die KI, ihre Quellen zu nennen, oder gleichen Sie die Angaben mit zuverlässigen externen Quellen ab.

2. Wie häufig kommen Halluzinationen bei großen Sprachmodellen (LLMs) vor?

Halluzinationen sind bei großen Sprachmodellen häufig, da sie Texte auf Basis von Wahrscheinlichkeiten generieren und nicht auf Faktenprüfung. Selbst fortschrittliche Modelle wie GPT-4o und Claude 3.5 können ungenaue Antworten liefern, besonders bei Nischenthemen oder wenig Kontext.

3. Können Halluzinationen auch bei nicht-textbasierten KI-Modellen wie Bildgeneratoren auftreten?

Ja, auch bei Bildgeneratoren treten Halluzinationen auf – etwa in Form von unrealistischen oder unsinnigen Elementen im Bild, wie zusätzlichen Gliedmaßen oder falschen kulturellen Darstellungen, verursacht durch Verzerrungen oder Lücken in den Trainingsdaten.

4. Kommen Halluzinationen in bestimmten Sprachen oder Kulturen häufiger vor, bedingt durch Verzerrungen im Trainingsdatensatz?

Halluzinationen treten häufiger in unterrepräsentierten Sprachen oder nicht-westlichen Kulturen auf, da die meisten LLMs hauptsächlich mit englischen und westlich geprägten Daten trainiert werden. Das führt zu weniger kulturell differenzierten Antworten.

5. In welchen Branchen sind die Folgen von KI-Halluzinationen besonders riskant?

Branchen wie Gesundheitswesen, Finanzen, Recht und Kundenservice sind am stärksten von KI-Halluzinationen bedroht, da ungenaue Ausgaben in diesen Bereichen zu Compliance-Verstößen, finanziellen Verlusten, rechtlichen Fehltritten oder zu einem Verlust des Nutzervertrauens und des Markenrufs führen können.

.webp)