- AIのハルシネーションとは、モデルが自信満々に誤った情報や作り話を出力する現象で、データの質の低さ、過学習、曖昧なプロンプトなどが原因です。

- ハルシネーションは事実誤認から完全な捏造まで幅広く、信頼を損ねたり、企業に莫大な損失を与えたり、有害な誤情報を拡散する恐れがあります。

- 主な予防策としては、信頼できるAIプラットフォームの選択、RAG(検索拡張生成)の導入、正確なプロンプト作成、人による監督の追加などが挙げられます。

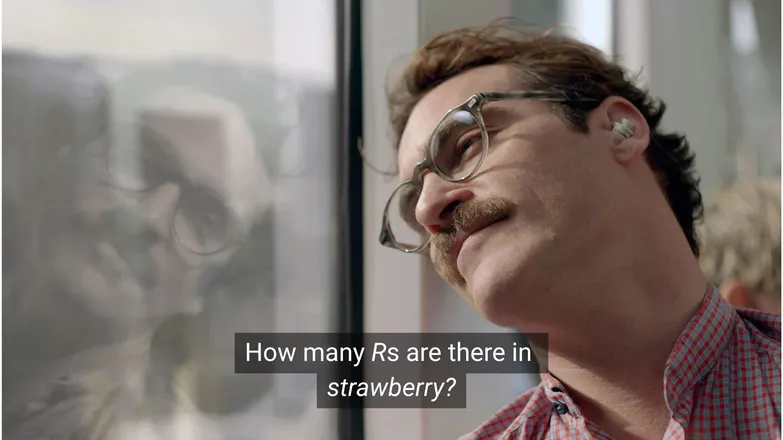

ホアキン・フェニックスがスカーレット・ヨハンソンに「strawberry(イチゴ)」の中にRがいくつあるか聞いていたら、彼は彼女に恋をしたでしょうか?LinkedInを使っている人なら答えは3だと知っています。(あるいは、普通に読めれば分かりますよね。)

しかし、AIチャットボットにとっては、必ずしもそう単純ではありません。

AIのハルシネーションの奇妙さを面白がる人も多いでしょう。確かに、膨大な知識と人間のような推論力、超高速な処理能力を持つAIモデルが、幼稚園レベルの算数問題で失敗するのは、ちょっと滑稽です。

ですが、その裏にはもっと深刻で、時に厄介な現実が潜んでいます。

この記事では、AIハルシネーションとは何か、その原因や重要性、そして防ぐための対策について解説します。

AIハルシネーションとは?

AIハルシネーションとは、AIモデルが不正確、誤解を招く、または完全に作り話の情報を提示する現象です。この誤情報は一見もっともらしく、多くの場合見抜くのが困難です。

LLMの普及により、ハルシネーションは主に生成系テキストモデルの文脈で語られることが多いですが、実際には生成AIのあらゆる応用でリスクとなります。

AIでハルシネーションが起こる原因は?

AIハルシネーションは、モデルが誤ったパターンを学習したときに発生します。

AIにおけるパターンとは、個々の学習例から未知のデータに一般化する能力を指します。これは、テキストの続きを生成したり、犬に該当する画像ピクセルの分布を見つけたりすることです。

LLMのハルシネーションの場合、モデルはユーザーのプロンプトに対して最も確からしい単語の並びを選びますが、それが誤りであることもあります。

これは、以下のような理由が一つまたは複数重なって起こります。

低品質な学習データ

ChatGPTなどのLLMは膨大なデータで学習されていますが、そのデータにも以下のような不完全さがあります。

- 特定分野の情報の欠落

- 現実世界の偏見の反映

- 意図的な誤情報や未分類の風刺

- 偏り、つまりバランスの悪いデータ。

例えば、ギリシャ神話の神々のうち一柱だけ情報が抜けているデータで学習した場合を考えてみましょう。

モデルはギリシャ神話に関連する愛や倫理、裏切りといったテーマ間の統計的なつながりを見つけ、統計的に「ありそう」と判断した架空の神話を作り出すかもしれません。

これは画像生成でも同様で、女性をテーマにしたプロンプトの多くが過度に性的な画像を生み出す傾向があります。特定の描写へのバイアスが、生成される画像の傾向を決定づけてしまうのです。

strawberryのスペルは、学習データ内で二重のRに関する話題、つまり英語非ネイティブにとっての難所として登場している可能性が高いです。この場合、数字の2や「double」という単語がスペルの話題と結びついているでしょう。

一方で、3つのRがあるという話題は、データ内に登場する可能性は低いでしょう。

この出力が不自然なのは、そもそも誰かが単語を書いてからスペルを尋ねるという状況自体が不自然だからです。

モデルの構造と生成手法

モデルは非常に複雑なニューラルネットワーク構造で構築されています。わずかな違いでも、モデルが学習データや入力プロンプトとどう関わるかに影響します。ハルシネーションを抑制する能力は、厳密な研究とテストによる段階的な改善によって高められます。

さらに、生成の仕組みも重要です。モデルは単語ごと(実際にはワードピース単位)に次に来る確率が最も高い単語を予測します。例えば:

「The quick brown fox jumps over the lazy ___.」

次に来る単語として「dog(犬)」が最も確率が高いと判断されますが、他の単語もあり得ます。最も確率の高い単語だけを選び続けると、単調で予測可能な結果になってしまいます。

そのため、より創造的なサンプリング手法が必要となり、応答を面白く一貫性のあるものにしますが、その過程で事実性が損なわれることもあります。

過学習

過学習とは、モデルが学習データに過度に適合しすぎて、新しい入力に一般化できなくなる状態です。

もし私がモデルだったら(母はそうなれと言いますが)、犬を次のように認識できれば適切に学習できていると言えます:

毛がふさふさしていて、垂れ耳で、遊び好き、そして小さな茶色の鼻がある。

しかし、過学習していると、犬を次のようにしか認識できません:

あごの下に茶色い点があり、「フランク」と呼ぶと反応し、私のナイキの靴をボロボロにしたやつ。

LLMの場合、これは学習データで見た情報をそのまま繰り返す形で現れ、答えが分からない場合に黙ることができなくなります。

例えば、チャットボットにある企業の返品ポリシーを尋ねたとします。知らなければ「分かりません」と答えるべきですが、過学習していると、似た別の企業のポリシーを返してしまうかもしれません。

不適切なプロンプト

企業は、AIが入力次第でしか機能しないことを踏まえ、プロンプトエンジニアリングの認定証を発行しています。

良いプロンプトは明確に表現され、専門用語を避け、必要な文脈をすべて含んでいます。

これは、ハルシネーションが多くの低確率な出力の境界で発生するためです。

例えば「shark girl(サメの女の子)のあらすじは?」と尋ねた場合、人間なら「ん?shark girl?」と考えます。統計的には、次のような可能性があります:

- シャークボーイ&マグマガール ― 2005年公開の、似た名前の有名な子供向け映画。

- 2024年公開のホラー/スリラー映画Shark Girl ― あまり有名ではないが、より新しく正確。

- 今年初めに出版された同名の児童書 ― モデルがインデックスしているかは不明。

どれも決定的な選択肢ではなく、「平坦な」確率分布となり、特定の話題やストーリーに絞りきれません。より効果的なプロンプトは、どの例を指しているのか文脈を明示することです。

この曖昧さと関連性の薄い情報の混在が、サメに関する架空の一般的なあらすじを生み出す原因となります。

ハルシネーションの発生確率を下げるには、不確実性を減らすことが重要です。

AIハルシネーションの種類

ここまで、ハルシネーションについて大まかに説明してきました。実際にはAIのほぼすべての側面に関わる問題ですが、分かりやすくするためにいくつかのカテゴリーに分けて考えます。

事実誤認

これはイチゴの例が当てはまります。基本的には正しい内容の中に、細部の誤りが含まれている場合です。例えば、ある出来事が起きた年、国の首都、統計の数字などが該当します。

一見良い回答の中の細かな誤りは特に厄介で、特に人間が正確に覚えていない数字などの場合に顕著です。

捏造された内容

2023年、GoogleのBardが誤ってジェームズ・ウェッブ望遠鏡が初めて系外惑星の写真を撮影したと主張しました。これは技術的な誤りというより、完全な虚偽でした。

こうした主張は上記のような大胆なものもありますが、多くの場合は存在しないURLや、架空のコードライブラリや関数として現れます。

事実誤認と捏造された内容の境界線は、必ずしも明確ではないことに注意が必要です。

例えば、ある研究者について議論しているとします。その人の論文を引用する際に発表年を間違えた場合は事実誤認です。しかし、名前を間違えた場合はどうでしょうか?名前と年の両方を間違えたら?

誤情報

これは前述の2つのカテゴリのいずれかに該当しますが、情報源がより明確な虚偽情報を指します。

Google AIがピザに接着剤を塗ることや石を食べることを勧めたのは有名な例です。情報源は明らかに風刺的で無害なもの(The Onionが書いたRedditのコメント)ですが、モデルの学習にはそれが考慮されていませんでした。

AIハルシネーションのリスク

1. 信頼の喪失

私たちはAIに仕事を任せられる自由を歓迎しますが、それは信頼を損なわないことが前提です。

Cursor AIで最近起きた問題――カスタマーサービスボットが存在しない厳しいポリシーを作り出したことで、多くのユーザーが信頼性に疑問を持ち、サブスクリプションを解約しました。

2. コスト

AIは多くのビジネスで中心的な役割を担っていますが、ミスが高くつくこともあります。

Googleのジェームズ・ウェッブ望遠鏡に関する誤情報は、数時間でAlphabetの株価を1,000億ドル下落させました。これはモデルの再学習コストが発生する前の話です。

3. 有害な誤情報

ピザに接着剤という話は笑い話ですが、誤った医薬品の用量だったらどうでしょうか?

注意書きだらけの細かい文字を読むより、AIから素早く答えを得たいと思うのは私も同じです。しかし、その答えが間違っていたら?AIはすべての医療条件を考慮できるとは限りません。

3. セキュリティとマルウェア

前述の通り、AIはしばしば存在しないコードライブラリの名前を作り出します。存在しないライブラリをインストールしようとしても何も起こりません。

しかし、ハッカーがマルウェアをコードに仕込み、よくハルシネーションされるライブラリ名でアップロードしたらどうでしょうか。そのライブラリをインストールした瞬間、💨一瞬で💨ハッキングされてしまいます。

これは実際に存在し、「slopsquatting」と呼ばれています。

不快な名前はさておき、インストールするものには常に慎重になり、聞き慣れないライブラリ名は必ず再確認しましょう。

AIハルシネーションを防ぐためのステップ

モデルのトレーニングをしていない場合、データやアーキテクチャ面でできることは限られています。

良いニュースとして、取れる対策はまだあり、それによってハルシネーションのないAIを提供できるかが大きく変わります。

信頼できるモデルとプラットフォームを選ぶ

あなたは一人ではありません。AI企業も信頼維持に全力を注いでおり、それはハルシネーションを防ぐことを意味します。

AIで何をするかによりますが、ほとんどの場合いくつかの選択肢があり、優れたAIプラットフォームなら誰でも利用できます。これらのプラットフォームはハルシネーション対策について透明性を持つべきです。

RAG(検索拡張生成)を活用する

モデル自身の知識だけに頼らせないこと。RAGを導入すれば、どんな情報が利用でき、どこにあるかが明確になります。

効果的なRAGの実装方法を簡単に案内しているプラットフォームでAIを運用するのが理想的です。

詳細な指示を加える

「入力が悪ければ、出力も悪い」という言葉を何度も聞いたことがあるでしょう。

「ユーザーの質問に答えてください」だけでは成功は保証できません。しかし、例えば:

# Instructions

Please refer exclusively to the FAQ document. If the answer does not appear there:

* Politely inform the user that the information is unavailable.

* Offer to escalate the conversation to a human agent.のようにすれば、エージェントの暴走を防げます。明確なプロンプトとしっかりしたガードレールが、暴走エージェントへの最良の防御策です。

人による検証

エスカレーションの観点からも、人がAIの問題点を確認・評価・修正できる体制が重要です。

会話をエスカレーションしたり、後から検証できる仕組みがあれば、何がうまくいき、何がハルシネーションのリスクかを把握できます。Human-in-the-loop(人によるAIワークフローの監督)は必須です。

ハルシネーションのないAIを今すぐ使おう

AIの信頼性への不安が、企業のデジタル化を妨げているかもしれません。

BotpressのRAG機能、人による監督の統合、徹底したセキュリティシステムにより、AIは安全かつ信頼できます。あなたのエージェントはあなたのために働きます。逆ではありません。

今すぐ構築を始めましょう。無料です。

よくある質問

1. テーマについて事前知識がなくても、AIの回答がハルシネーションかどうか見分けるには?

事前知識がなくてもAIの回答がハルシネーションかどうか見分けるには、極端に具体的な主張や自信過剰な表現、独自に検証できない名前・統計・引用などに注意しましょう。不安な場合は、AIに出典を示すよう促したり、信頼できる外部情報と照合してください。

2. 大規模言語モデル(LLM)でAIハルシネーションはどれくらい一般的ですか?

AIハルシネーションは大規模言語モデルでよく見られます。なぜなら、これらは事実確認ではなく確率に基づいてテキストを生成するからです。GPT-4oやClaude 3.5のような先進モデルでも、特にニッチな話題や文脈が少ない場合は不正確な出力をすることがあります。

3. 画像生成などテキスト以外のAIモデルでもハルシネーションは起こりますか?

はい、画像生成モデルでもハルシネーションは発生します。例えば、出力画像に不自然な要素(余分な手足や誤った文化的表現など)が現れることがあり、これは学習データの偏りや不足が原因です。

4. 学習データの偏りにより、特定の言語や文化でハルシネーションが多くなりますか?

十分に学習されていない言語や非西洋文化圏では、ハルシネーションがより多く発生します。多くのLLMは主に英語や西洋中心のデータで訓練されているため、文化的なニュアンスに欠けた応答になりがちです。

5. どの業界がAIハルシネーションの影響を最も受けやすいですか?

医療、金融、法律、カスタマーサービスなどの業界はAIハルシネーションの影響を特に受けやすいです。これらの分野で不正確な出力があると、コンプライアンス違反や経済的損失、法的トラブル、ユーザーの信頼やブランドイメージの損失につながる可能性があります。

.webp)