- Alucinação de IA ocorre quando modelos produzem com confiança informações falsas ou inventadas, causadas por baixa qualidade de dados, overfitting ou prompts ambíguos.

- As alucinações vão de erros factuais a conteúdos fabricados e podem prejudicar a confiança, causar prejuízos bilionários a empresas ou espalhar desinformação perigosa.

- As principais medidas de prevenção incluem escolher plataformas de IA confiáveis, adicionar geração aumentada por recuperação (RAG), criar prompts precisos e incluir supervisão humana.

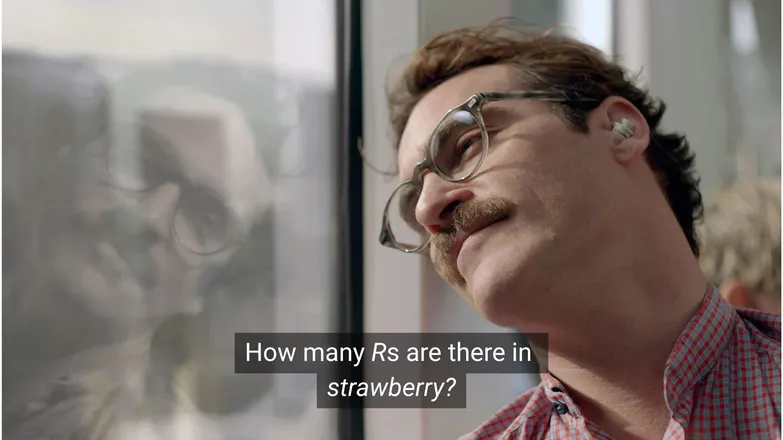

Você acha que Joaquin Phoenix teria se apaixonado por Scarlett Johansson se tivesse perguntado quantos Rs tem em strawberry? Se você está no LinkedIn, sabe que a resposta é 3. (Ou, bom, se você sabe ler.)

Mas para chatbots de IA, nem sempre é tão simples assim.

Você provavelmente já viu pessoas tirando sarro das alucinações absurdas da IA. E, para ser justo, um modelo de IA com conhecimento aparentemente infinito, raciocínio quase humano e execução de tarefas em velocidade relâmpago errando uma conta de matemática de jardim de infância é, de fato, meio absurdo.

Mas por trás da diversão e dos jogos existe uma realidade mais séria — e potencialmente insidiosa.

Neste artigo, vou falar sobre alucinações de IA: o que são, o que as causa, por que são importantes e como preveni-las.

O que é alucinação de IA?

Alucinação de IA é quando um modelo apresenta informações imprecisas, enganosas ou totalmente inventadas. Essas informações falsas podem parecer plausíveis e, muitas vezes, passam despercebidas.

Devido à ampla adoção dos LLMs, as alucinações são mais citadas no contexto de modelos generativos de texto. Na prática, elas representam risco para qualquer aplicação de IA Generativa.

O que causa alucinação em IA?

A alucinação de IA acontece quando modelos aprendem padrões falsos.

Padrões, no contexto de IA, referem-se à capacidade de usar exemplos de treinamento para generalizar sobre dados nunca vistos. Isso pode ser uma sequência de palavras para formar a continuação de um texto ou a distribuição de pixels de uma imagem que representa um cachorro.

No caso de alucinação em LLM, o modelo considera uma sequência de palavras como a continuação mais provável para o prompt do usuário, mesmo que seja falsa.

Isso pode acontecer por um ou mais dos seguintes motivos:

Dados de Treinamento de Baixa Qualidade

ChatGPT e LLMs similares são treinados com grandes volumes de dados. Esses dados, por mais abundantes que sejam, são imperfeitos devido a:

- Lacunas em determinados assuntos

- Reprodução de preconceitos do mundo real

- Desinformação deliberada ou sátiras não identificadas

- Tendencioso, como dados desbalanceados ou "parciais".

Considere um cenário em que o modelo foi treinado sobre todos os deuses gregos, exceto um.

Sua capacidade de fazer conexões estatísticas entre temas típicos da mitologia grega — amor, ética, traição — pode levá-lo a inventar alguma mitologia que ele considera “provável”, segundo seu modelo estatístico.

Isso também aparece na geração de imagens, onde a maioria dos prompts para personagens femininas resulta em imagens hipersexualizadas. O viés para um tipo específico de representação condiciona o tipo de imagem gerada.

A grafia de strawberry provavelmente apareceu nos dados de treinamento em discussões sobre o duplo R, uma dificuldade notória para quem não é nativo em inglês. Nesse caso, o número 2 ou a palavra “duplo” provavelmente apareceram junto da grafia da palavra.

Por outro lado, é improvável que os dados mencionem que há 3 Rs.

A resposta é absurda porque o prompt é: em que situação alguém escreveria uma palavra e depois perguntaria como se soletra?

Arquitetura do Modelo e Método de Geração

Os modelos são construídos a partir de arquiteturas de redes neurais extremamente complexas. Pequenas variações impactam a forma como os modelos interagem com seus dados de treinamento e prompts de entrada. A capacidade de um modelo de reduzir alucinações depende de melhorias incrementais por meio de pesquisa e testes rigorosos.

Além disso, há a forma como a geração é implementada. Palavra por palavra (na verdade, fragmento de palavra), os modelos preveem qual é a palavra mais provável a seguir. Então:

“A rápida raposa marrom pula sobre o ___ preguiçoso.”

Vai determinar que a próxima palavra mais provável é “cachorro”. Mas outras palavras são possíveis. E gerar apenas com base na palavra mais provável resulta em respostas previsíveis e sem graça.

Por isso, métodos criativos de amostragem são usados para tornar as respostas interessantes e coerentes. Com isso, a precisão factual pode ser deixada de lado.

Overfitting

Overfitting ocorre quando o modelo é treinado para prever os dados tão de perto que não consegue generalizar para novas entradas.

Então, se eu fosse um modelo (como minha mãe diz que eu deveria ser), eu seria bem treinado se reconhecesse cachorros como:

Peludo, com orelhas caídas, brincalhão e um focinho marrom pequeno.

Mas eu estaria com overfitting se só os reconhecesse como:

Tendo uma pinta marrom no queixo, atende pelo nome “Frank” e já destruiu meu melhor par de tênis.

No contexto de um LLM, geralmente isso se manifesta repetindo informações vistas nos dados de treinamento, em vez de admitir quando não sabe a resposta.

Por exemplo, se você perguntar a um chatbot sobre a política de devolução de uma empresa. Se ele não souber, deveria avisar. Mas se estiver com overfitting, pode devolver a política de uma empresa parecida.

Prompting Ruim

Empresas estão emitindo certificados em engenharia de prompts, sabendo que a IA só é tão boa quanto suas entradas.

Um bom prompt é claro, evita termos muito específicos e fornece todo o contexto necessário.

Isso porque a alucinação acontece na borda de muitas saídas de baixa probabilidade.

Por exemplo, se você perguntar “qual é a história de shark girl?” Agora, um humano pensa “ué, shark girl.” No mundo das estatísticas, as possibilidades são:

- As Aventuras de Sharkboy e Lavagirl – um filme infantil bem conhecido de 2005 com nome parecido.

- Um terror/suspense de 2024 chamado Shark Girl – menos famoso, mas mais recente e preciso.

- Um livro infantil com o mesmo nome lançado no início deste ano – que o modelo pode ou não ter indexado.

Nenhuma dessas é uma escolha óbvia, resultando em uma distribuição de probabilidade “achatada”, com menos certeza sobre um tema ou narrativa. Um prompt mais eficaz forneceria contexto, ou seja, deixaria claro a qual exemplo o usuário se refere.

Essa mistura de ambiguidade e relevância tangencial pode gerar uma resposta assim: um enredo genérico inventado sobre uma história com tubarão.

Reduzir a chance de alucinações é reduzir a incerteza.

Tipos de Alucinações de IA

Até agora falei de alucinações de forma geral. Na prática, elas afetam quase todos os aspectos da IA. Para facilitar, é melhor considerar as diferentes categorias.

Erros factuais

É aqui que entra o exemplo do morango. São erros em detalhes de afirmações que, de resto, seriam corretas. Isso pode incluir o ano de um evento, a capital de um país ou números de uma estatística.

Detalhes pequenos em uma resposta que, no geral, é boa podem ser especialmente traiçoeiros, especialmente quando se trata de detalhes que as pessoas raramente lembram, como números exatos.

Conteúdo Fabricado

Em 2023, o Bard do Google afirmou falsamente que o telescópio James Webb foi usado para tirar as primeiras fotos de exoplanetas. Não se tratava de uma imprecisão técnica – era simplesmente falso.

Essas podem ser afirmações ousadas como a acima, mas geralmente aparecem como URLs que não levam a lugar nenhum, ou bibliotecas e funções de código inventadas.

Vale lembrar que a linha entre erros factuais e conteúdo fabricado nem sempre é clara.

Digamos que estamos falando sobre um pesquisador. Se citarmos um artigo dele, mas errarmos o ano, é um erro factual. Se errarmos o nome, e aí? E se errarmos o nome e o ano?

Desinformação

Isso pode se encaixar em qualquer uma das duas categorias anteriores, mas se refere a informações falsas em que a fonte é mais transparente.

O famoso caso da IA do Google recomendando pizza com cola e comer pedras é um ótimo exemplo disso; o material de origem é obviamente satírico e geralmente inofensivo – comentários do Reddit escritos pelo The Onion, mas o treinamento do modelo não levou isso em conta.

Riscos das Alucinações de IA

1. Perda de confiança

Apreciamos a liberdade de delegar tarefas à IA, mas não à custa da nossa confiança.

O recente erro da Cursor AI – um bot de atendimento ao cliente inventando uma política restritiva – fez muitos usuários cancelarem suas assinaturas, questionando sua confiabilidade.

2. Custo

A IA assumiu papel central em muitos negócios e, embora isso seja positivo, um deslize pode sair caro.

A alucinação do James Webb pelo Google causou uma queda de US$ 100 bilhões nas ações da Alphabet em poucas horas. E isso antes do custo de re-treinamento dos modelos.

3. Desinformação prejudicial

Rimos do absurdo da pizza com cola, mas e quanto a dosagens médicas incorretas?

Eu seria o primeiro a trocar a leitura de letras miúdas cheias de alertas por uma resposta rápida da IA. Mas e se ela estiver errada? Com certeza não vai considerar todas as condições médicas possíveis.

3. Segurança e Malware

Como mencionado, a IA frequentemente inventa nomes de bibliotecas de código. Quando você tenta instalar uma biblioteca inexistente, nada acontece.

Agora imagine um hacker inserindo malware em um código e publicando com o nome de uma biblioteca que a IA costuma inventar. Você instala a biblioteca e 💨puf💨: foi hackeado.

Isso existe e se chama slopsquatting.

Nome estranho à parte, nunca é demais ser crítico com o que você instala e sempre conferir nomes de bibliotecas que soam exóticas.

Como Prevenir Alucinações de IA

Se você não está treinando os modelos, há pouco o que fazer em relação aos dados e arquitetura.

A boa notícia é que ainda existem precauções que você pode tomar, e elas fazem toda a diferença para entregar uma IA sem alucinações.

Escolha um Modelo e Plataforma Confiáveis

Você não está sozinho. Empresas de IA têm total interesse em manter a confiança, e isso significa evitar alucinações.

Dependendo do que você faz com IA, quase sempre há algumas opções, e uma boa plataforma de IA facilita esse acesso. Essas plataformas devem ser transparentes sobre como mitigam alucinações.

Use RAG (Geração Aumentada por Recuperação)

Não faça o modelo depender apenas do próprio conhecimento. Equipar seu modelo com RAG deixa claro onde encontrar as informações e que elas estão disponíveis.

O ideal é usar IA em uma plataforma com instruções simples sobre como implementar RAG de forma eficaz.

Adicione Instruções Detalhadas

Se você já ouviu isso uma vez, ouviu mil vezes: lixo entra, lixo sai.

“Responda à pergunta do usuário” não garante sucesso. Porém, algo como:

# Instructions

Please refer exclusively to the FAQ document. If the answer does not appear there:

* Politely inform the user that the information is unavailable.

* Offer to escalate the conversation to a human agent.vai manter seu agente sob controle. Instruções claras com limites bem definidos são sua melhor defesa contra um agente descontrolado.

Verificação Humana

Falando em escalonamento, ter uma pessoa pronta para inspecionar, avaliar e corrigir falhas da IA.

A possibilidade de escalar ou verificar conversas depois permite identificar o que funciona e o que está sujeito a alucinações. Human-in-the-loop – supervisão humana em fluxos de trabalho com IA – é essencial aqui.

Use IA sem Alucinações Hoje

A incerteza sobre a confiabilidade da IA pode estar impedindo empresas de avançar na transformação digital.

Os recursos de RAG da Botpress, integração human-in-the-loop e sistemas de segurança robustos tornam a IA segura e confiável. Seu agente trabalha para você, não o contrário.

Comece a construir hoje. É grátis.

Perguntas frequentes

1. Como posso saber se uma resposta de IA é uma alucinação sem ter conhecimento prévio do assunto?

Para identificar se uma resposta de IA é uma alucinação sem conhecimento prévio, procure sinais como afirmações muito específicas, linguagem excessivamente confiante ou nomes, estatísticas ou citações que não podem ser verificadas de forma independente. Quando estiver em dúvida, peça para a IA citar as fontes ou confira com referências externas confiáveis.

2. Quão comuns são as alucinações de IA em grandes modelos de linguagem (LLMs)?

Alucinações de IA são comuns em grandes modelos de linguagem porque eles geram texto com base em probabilidades, não em verificação de fatos. Mesmo modelos avançados como GPT-4o e Claude 3.5 podem produzir respostas imprecisas, especialmente sobre temas de nicho ou em situações com pouco contexto.

3. Alucinações podem ocorrer em modelos de IA que não são baseados em texto, como geradores de imagens?

Sim, alucinações também ocorrem em modelos de geração de imagens, geralmente como elementos irreais ou sem sentido no resultado – como membros extras ou representações culturais incorretas – causadas por vieses ou lacunas nos dados de treinamento.

4. Alucinações são mais comuns em certos idiomas ou culturas devido a vieses nos dados de treinamento?

Alucinações são mais comuns em idiomas pouco representados ou contextos culturais não ocidentais porque a maioria dos LLMs é treinada principalmente em inglês e dados centrados no Ocidente, levando a respostas menos sensíveis a outras culturas.

5. Quais setores estão mais expostos às consequências das alucinações de IA?

Setores como saúde, finanças, direito e atendimento ao cliente estão mais expostos às alucinações de IA, pois respostas imprecisas nessas áreas podem causar violações de conformidade, prejuízos financeiros, erros jurídicos ou danos à confiança do usuário e à reputação da marca.

.webp)