- Halusinasi AI berlaku apabila model AI dengan yakin menghasilkan maklumat palsu atau rekaan, yang berpunca daripada kualiti data yang rendah, overfitting, atau arahan yang tidak jelas.

- Halusinasi boleh berkisar daripada kesilapan fakta hingga kandungan rekaan dan boleh menjejaskan kepercayaan, menyebabkan kerugian berbilion ringgit kepada perniagaan, atau menyebarkan maklumat salah yang berbahaya.

- Langkah utama pencegahan termasuk memilih platform AI yang boleh dipercayai, menambah penjanaan berasaskan pengambilan (RAG), merangka arahan yang tepat, dan melibatkan pengawasan manusia.

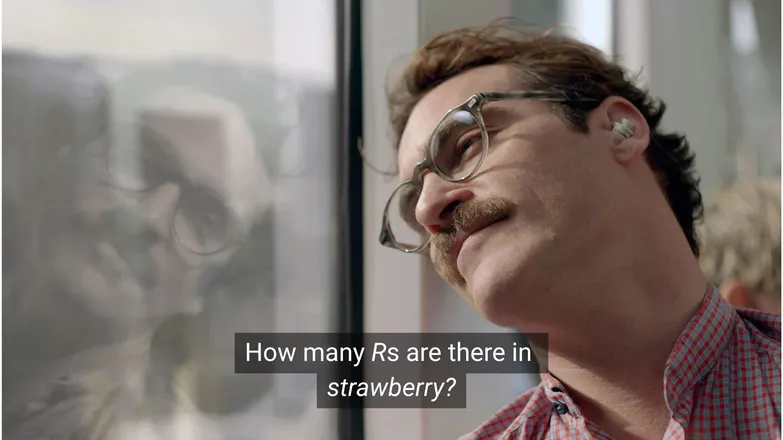

Adakah anda fikir Joaquin Phoenix akan jatuh cinta dengan Scarlett Johansson jika dia bertanya berapa banyak R dalam strawberry? Jika anda aktif di LinkedIn, anda tahu jawapannya ialah 3. (Atau, anda tahu, jika anda boleh membaca.)

Tetapi bagi chatbot AI, ia tidak selalunya semudah itu.

Anda mungkin pernah melihat orang mempermainkan keanehan halusinasi AI. Dan secara adilnya, model AI yang kelihatan serba tahu, berfikir seperti manusia dan pantas menyelesaikan tugasan tetapi gagal dalam masalah matematik tahap tadika memang agak lucu.

Namun di sebalik gurauan itu, terdapat realiti yang lebih serius — dan mungkin berbahaya.

Dalam artikel ini, saya akan membincangkan tentang halusinasi AI– apa itu, puncanya, kenapa ia penting, dan langkah-langkah yang boleh diambil untuk mencegahnya.

Apa itu halusinasi AI?

Halusinasi AI berlaku apabila model AI memberikan maklumat yang tidak tepat, mengelirukan, atau sepenuhnya rekaan. Maklumat palsu ini boleh kelihatan meyakinkan, dan dalam banyak kes, tidak disedari.

Disebabkan penggunaan LLM yang meluas, halusinasi paling kerap dirujuk dalam konteks model teks generatif. Sebenarnya, ia boleh berlaku dalam mana-mana aplikasi AI Generatif.

Apakah punca halusinasi dalam AI?

Halusinasi AI berlaku apabila model mempelajari corak yang salah.

Corak, dalam konteks AI, merujuk kepada keupayaannya menggunakan contoh latihan individu untuk menggeneralisasi kepada data yang belum pernah dilihat. Ini boleh jadi satu siri perkataan untuk membentuk sambungan teks, atau taburan piksel imej yang mewakili seekor anjing.

Dalam kes halusinasi LLM, model menganggap satu siri perkataan sebagai sambungan paling mungkin kepada arahan pengguna, walaupun ia salah.

Ini boleh berlaku kerana satu atau lebih sebab berikut:

Data Latihan Berkualiti Rendah

ChatGPT dan LLM serupa dilatih menggunakan sejumlah besar data. Walaupun data ini banyak, ia tidak sempurna kerana:

- Kekurangan maklumat dalam topik tertentu

- Mencerminkan prasangka dunia sebenar

- Maklumat palsu yang disengajakan atau sindiran yang tidak ditanda

- Berat sebelah, iaitu data yang tidak seimbang atau "condong".

Bayangkan situasi di mana model dilatih dengan maklumat tentang semua dewa Yunani kecuali satu.

Keupayaannya membuat hubungan statistik antara topik berkaitan mitologi Yunani– cinta, etika, pengkhianatan– boleh menyebabkan ia mereka mitos baru yang dianggap "mungkin", berdasarkan model statistiknya.

Ini juga jelas dalam penjanaan imej, di mana kebanyakan arahan untuk subjek wanita menghasilkan imej yang terlalu seksual. Berat sebelah terhadap satu jenis gambaran mempengaruhi jenis imej yang dihasilkan.

Ejaan strawberry mungkin kerap muncul dalam data latihan dalam konteks perbincangan tentang R berganda, satu isu terkenal bagi penutur bukan asli bahasa Inggeris. Dalam kes ini, nombor 2 atau perkataan “double” mungkin sering dikaitkan dengan ejaan perkataan tersebut.

Sebaliknya, tidak mungkin data menyebut bahawa ia mempunyai 3 R.

Hasilnya kelihatan pelik kerana arahannya: dalam keadaan apa seseorang menulis satu perkataan dan kemudian bertanya bagaimana ia dieja?

Seni Bina Model dan Kaedah Penjanaan

Model dibina daripada seni bina rangkaian neural yang sangat kompleks. Perubahan kecil mempengaruhi cara model berinteraksi dengan data latihan dan arahan yang diterima. Keupayaan model untuk mengurangkan halusinasi boleh ditambah baik secara berperingkat melalui penyelidikan dan ujian yang teliti.

Selain itu, cara penjanaan dilaksanakan juga penting. Perkataan demi perkataan (sebenarnya word-piece), model meramalkan perkataan paling mungkin yang akan menyusul. Jadi:

“The quick brown fox jumps over the lazy ___.”

Model akan menentukan perkataan seterusnya yang paling mungkin ialah “dog”. Tetapi perkataan lain juga boleh muncul. Dan penjanaan yang hanya berdasarkan ramalan satu perkataan paling mungkin menghasilkan jawapan yang membosankan dan boleh dijangka.

Ini bermakna kaedah pensampelan kreatif perlu digunakan untuk memastikan respons menarik tetapi masih masuk akal. Dalam proses ini, fakta kadang-kadang terlepas pandang.

Overfitting

Overfitting berlaku apabila model dilatih terlalu rapat dengan data sehingga gagal menggeneralisasi kepada input baru.

Jadi, jika saya adalah model (seperti yang ibu saya kata saya patut jadi), saya akan dianggap terlatih dengan baik jika saya mengenali anjing sebagai:

Berbulu, bertelinga labuh, suka bermain, dan hidung kecil berwarna coklat.

Tetapi saya akan dianggap overfit jika saya hanya mengenali anjing sebagai:

Ada titik coklat di bawah dagu, menjawab nama “Frank”, dan telah mengunyah habis sepasang kasut Nike saya yang bagus.

Dalam konteks LLM, ini biasanya bermaksud mengulangi maklumat yang pernah dilihat dalam data latihan, bukannya mengaku tidak tahu apabila tidak pasti.

Contohnya, jika anda bertanya chatbot tentang polisi pemulangan syarikat. Jika ia tidak tahu, ia sepatutnya memberitahu anda. Tetapi jika ia overfit, ia mungkin memberikan polisi syarikat lain yang serupa.

Arahan (Prompt) yang Lemah

Syarikat kini mengeluarkan sijil dalam kejuruteraan prompt kerana mereka tahu AI hanya sebaik input yang diterima.

Prompt yang baik dirangka dengan jelas, mengelakkan istilah khusus, dan menyediakan semua konteks yang diperlukan.

Ini kerana halusinasi berlaku di pinggir banyak output berkemungkinan rendah.

Contohnya anda bertanya “apa plot shark girl?” Sekarang, manusia akan fikir “huh, shark girl.” Dalam dunia statistik, kemungkinannya ialah:

- The Adventures of Sharkboy and Lavagirl – filem kanak-kanak yang agak popular dari 2005 dengan nama hampir sama.

- Sebuah filem seram/thriller 2024 berjudul Shark Girl – kurang popular tetapi lebih baru dan tepat.

- Sebuah buku kanak-kanak dengan nama sama dari awal tahun ini – yang mungkin atau mungkin tidak diindeks oleh model.

Tiada satu pun pilihan yang jelas, menghasilkan taburan kebarangkalian yang “rata” dengan kurang kecenderungan kepada satu topik atau naratif. Prompt yang lebih berkesan akan memberikan konteks, iaitu menjelaskan contoh mana yang dimaksudkan pengguna.

Kekaburan dan kaitan tidak langsung ini boleh menghasilkan jawapan yang juga begitu: plot rekaan generik berkaitan ikan jerung.

Mengurangkan risiko halusinasi bermakna mengurangkan ketidakpastian.

Jenis-jenis Halusinasi AI

Setakat ini saya telah membincangkan halusinasi secara umum. Sebenarnya, ia melibatkan hampir semua aspek AI. Namun, untuk lebih jelas, adalah baik untuk melihat kategori yang berbeza.

Kesilapan Fakta

Inilah di mana contoh strawberi sesuai. Terdapat kesilapan dalam butiran pada kenyataan yang sebaliknya betul. Ini boleh termasuk tahun sesuatu peristiwa berlaku, ibu negara sesebuah negara, atau angka statistik.

Butiran kecil dalam jawapan yang baik boleh menjadi sangat mengelirukan, terutamanya untuk maklumat yang manusia jarang ingat, seperti nombor yang tepat.

Kandungan Rekaan

Pada tahun 2023, Bard Google secara salah mendakwa bahawa teleskop James Webb digunakan untuk mengambil gambar pertama eksoplanet. Ini bukan isu ketidaktepatan teknikal—ia memang tidak benar.

Kadang-kadang ia berupa dakwaan besar seperti di atas, tetapi lebih kerap muncul sebagai URL yang tidak wujud, atau pustaka dan fungsi kod yang direka-reka.

Perlu diingat bahawa garis pemisah antara kesilapan fakta dan kandungan rekaan tidak selalu jelas.

Katakan kita sedang membincangkan seorang penyelidik. Jika kita menyebut kertas kerja mereka tetapi tersalah tahun, itu adalah kesilapan fakta. Jika kita tersalah nama, bagaimana pula? Bagaimana jika nama dan tahun juga salah?

Maklumat Palsu

Ini boleh termasuk dalam dua kategori sebelum ini, tetapi merujuk kepada maklumat palsu di mana sumbernya lebih jelas.

Satu contoh terkenal ialah Google AI mencadangkan pizza gam dan makan batu; sumber asalnya jelas bersifat satira dan umumnya tidak berbahaya—komen Reddit yang ditulis oleh The Onion, tetapi latihan model tidak mengambil kira perkara itu.

Risiko Halusinasi AI

1. Kehilangan Kepercayaan

Kita suka menyerahkan tugas kepada AI, tetapi bukan dengan mengorbankan kepercayaan kita.

Insiden terkini Cursor AI—bot khidmat pelanggan mereka mencipta polisi yang ketat—telah menyebabkan ramai pengguna membatalkan langganan dan mempersoalkan kebolehpercayaannya.

2. Kos

AI kini menjadi keutamaan dalam banyak perniagaan, dan walaupun itu sesuatu yang baik, kesilapan boleh membawa kerugian besar.

Halusinasi James Webb oleh Google menyebabkan kejatuhan $100 bilion dalam saham Alphabet dalam beberapa jam sahaja. Itu belum termasuk kos melatih semula model-model tersebut.

3. Maklumat Palsu yang Berbahaya

Kita mungkin ketawa dengan idea pizza gam, tetapi bagaimana pula dengan dos ubat yang mengelirukan?

Saya sendiri lebih suka mendapat jawapan pantas daripada AI berbanding membaca cetakan halus penuh amaran. Tapi bagaimana jika jawapannya salah? Ia hampir pasti tidak mengambil kira semua keadaan perubatan yang mungkin.

3. Keselamatan dan Perisian Hasad

Seperti disebutkan, AI sering mereka-reka nama pustaka kod. Jika anda cuba memasang pustaka yang tidak wujud, tiada apa yang berlaku.

Bayangkan pula jika penggodam memasukkan perisian hasad ke dalam kod dan memuat naiknya dengan nama pustaka yang sering dihalusinasikan. Anda memasang pustaka itu, dan 💨poof💨: anda digodam.

Perkara ini memang wujud, dan ia dipanggil slopsquatting.

Walaupun namanya kurang menyenangkan, sentiasa berhati-hati dengan apa yang anda pasang, dan semak semula nama pustaka yang kedengaran pelik.

Langkah-langkah Mencegah Halusinasi AI

Jika anda bukan yang melatih model, tidak banyak yang boleh dilakukan dari segi data dan seni bina.

Berita baiknya, masih ada langkah berjaga-jaga yang boleh diambil, dan ia boleh membuat perbezaan besar dalam memastikan AI anda bebas halusinasi.

Pilih Model dan Platform yang Boleh Dipercayai

Anda tidak bersendirian. Syarikat AI sangat mementingkan kepercayaan, dan itu bermakna tiada halusinasi.

Bergantung pada apa yang anda lakukan dengan AI, anda hampir sentiasa mempunyai beberapa pilihan, dan platform AI yang baik memudahkan perkara ini. Platform ini sepatutnya telus tentang bagaimana mereka mengurangkan halusinasi.

Gunakan RAG (Retrieval-Augmented Generation)

Jangan biarkan model hanya bergantung pada pengetahuannya sendiri. Melengkapkan model anda dengan RAG memastikan maklumat jelas tersedia dan diketahui sumbernya.

Sebaiknya gunakan AI di platform yang menyediakan arahan mudah tentang cara melaksanakan RAG yang berkesan.

Berikan Arahan yang Jelas dan Terperinci

Jika anda pernah mendengarnya sekali, anda pasti pernah mendengarnya beribu kali: sampah masuk, sampah keluar.

"Jawab soalan pengguna" tidak menjamin kejayaan. Tetapi sesuatu seperti:

# Instructions

Please refer exclusively to the FAQ document. If the answer does not appear there:

* Politely inform the user that the information is unavailable.

* Offer to escalate the conversation to a human agent.akan memastikan ejen anda terkawal. Arahan yang jelas dengan garis panduan yang tegas adalah pertahanan terbaik anda daripada ejen yang bertindak di luar kawalan.

Pengesahan Manusia

Bercakap tentang eskalasi, pastikan ada individu yang bersedia untuk menyemak, menilai, dan membetulkan kekurangan AI.

Keupayaan untuk mengeskalasi, atau menyemak semula perbualan membolehkan anda mengenal pasti apa yang berkesan dan apa yang berisiko menyebabkan halusinasi. Human-in-the-loop—pengawasan manusia dalam aliran kerja AI—adalah wajib di sini.

Gunakan AI Bebas Halusinasi Hari Ini

Ketidakpastian tentang kebolehpercayaan AI mungkin menghalang perniagaan daripada beralih ke digital.

Keupayaan RAG Botpress, integrasi human-in-the-loop, dan sistem keselamatan yang menyeluruh menjadikan AI selamat dan boleh dipercayai. Ejen anda bekerja untuk anda, bukan sebaliknya.

Mula bina hari ini. Ia percuma.

Soalan Lazim

1. Bagaimana saya boleh tahu jika respons AI adalah halusinasi tanpa pengetahuan awal tentang topik tersebut?

Untuk mengenal pasti sama ada respons AI adalah halusinasi tanpa pengetahuan awal, perhatikan tanda-tanda seperti dakwaan yang terlalu spesifik, bahasa yang terlalu yakin, atau nama, statistik, atau rujukan yang tidak dapat disahkan secara bebas. Jika ragu-ragu, minta AI nyatakan sumbernya atau semak silang dengan rujukan luar yang boleh dipercayai.

2. Sejauh mana halusinasi AI biasa berlaku dalam model bahasa besar (LLM)?

Halusinasi AI adalah perkara biasa dalam model bahasa besar kerana ia menjana teks berdasarkan kebarangkalian, bukan pengesahan fakta. Malah model canggih seperti GPT-4o dan Claude 3.5 boleh menghasilkan output yang tidak tepat, terutamanya untuk topik khusus atau dalam situasi kurang konteks.

3. Bolehkah halusinasi berlaku dalam model AI bukan berasaskan teks seperti penjana imej?

Ya, halusinasi juga berlaku dalam model penjanaan imej, selalunya dalam bentuk elemen yang tidak realistik atau tidak masuk akal dalam hasil—seperti anggota badan tambahan atau gambaran budaya yang salah—disebabkan oleh bias atau kekurangan data latihan.

4. Adakah halusinasi lebih kerap berlaku dalam bahasa atau budaya tertentu akibat bias data latihan?

Halusinasi lebih kerap berlaku dalam bahasa yang kurang diwakili atau konteks budaya bukan Barat kerana kebanyakan LLM dilatih terutamanya menggunakan data berbahasa Inggeris dan berpusatkan Barat, menyebabkan respons kurang bernuansa budaya.

5. Industri manakah yang paling berisiko akibat halusinasi AI?

Industri seperti penjagaan kesihatan, kewangan, undang-undang, dan khidmat pelanggan paling berisiko akibat halusinasi AI, kerana output yang tidak tepat dalam bidang ini boleh menyebabkan pelanggaran pematuhan, kerugian kewangan, kesilapan undang-undang, atau kerosakan kepercayaan pengguna dan reputasi jenama.

.webp)