- การหลอนของ AI เกิดขึ้นเมื่อโมเดลสร้างข้อมูลที่ผิดหรือแต่งขึ้นอย่างมั่นใจ สาเหตุจากคุณภาพข้อมูลที่ไม่ดี การฝึกแบบเกิน หรือคำสั่งที่คลุมเครือ

- การหลอนมีตั้งแต่ข้อผิดพลาดด้านข้อเท็จจริงไปจนถึงเนื้อหาที่แต่งขึ้น ซึ่งอาจทำลายความเชื่อมั่น สร้างความเสียหายทางธุรกิจมหาศาล หรือกระจายข้อมูลผิด ๆ ที่เป็นอันตราย

- ขั้นตอนสำคัญในการป้องกัน ได้แก่ เลือกแพลตฟอร์ม AI ที่เชื่อถือได้ เพิ่มการสร้างข้อมูลด้วยการค้นคืน (RAG) ตั้งคำสั่งให้ชัดเจน และมีการตรวจสอบโดยมนุษย์

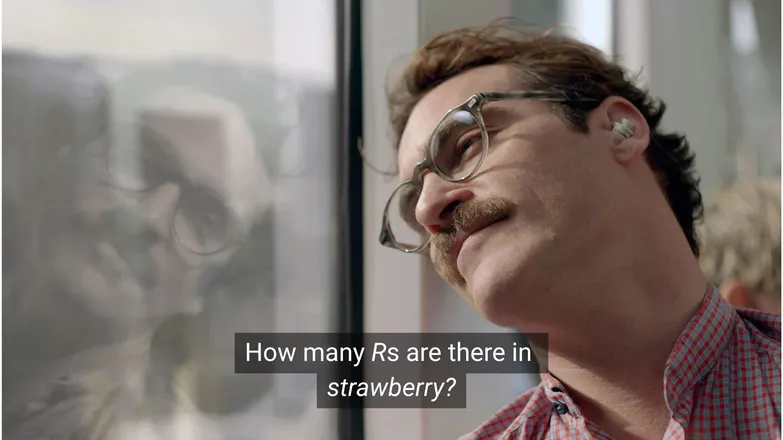

คุณคิดว่า Joaquin Phoenix จะตกหลุมรัก Scarlett Johansson ไหม ถ้าเขาถามเธอว่าคำว่า R ใน strawberry มีกี่ตัว? ถ้าคุณเล่น LinkedIn คุณคงรู้ว่าคำตอบคือ 3 (หรือถ้าคุณอ่านออก)

แต่สำหรับ แชทบอท AI มันไม่ได้ง่ายแบบนั้นเสมอไป

คุณอาจเคยเห็นคนล้อเลียนความแปลกของการหลอนของ AI และก็จริงที่ว่า โมเดล AI ที่ดูเหมือนจะรู้ทุกอย่าง มีเหตุผลแบบมนุษย์ และทำงานไวสุด ๆ แต่กลับแก้โจทย์คณิตศาสตร์ระดับอนุบาลไม่ได้ มันก็ดูตลกดี

แต่เบื้องหลังความขำขันนั้น มีความจริงที่จริงจังและอาจเป็นอันตรายซ่อนอยู่

ในบทความนี้ ผมจะพูดถึงการหลอนของ AI—ว่าคืออะไร เกิดจากอะไร สำคัญอย่างไร และเราจะป้องกันได้อย่างไร

AI Hallucination คืออะไร?

AI hallucination คือเมื่อโมเดล AI นำเสนอข้อมูลที่ไม่ถูกต้อง ชวนให้เข้าใจผิด หรือแต่งขึ้นทั้งหมด ข้อมูลผิดนี้อาจดูน่าเชื่อถือ และบ่อยครั้งก็ไม่มีใครสังเกตเห็น

เพราะ LLM ถูกใช้อย่างแพร่หลาย การหลอนจึงมักพูดถึงในบริบทของโมเดลสร้างข้อความ แต่จริง ๆ แล้ว มันเป็นความเสี่ยงสำหรับ การใช้งาน Generative AI ทุกรูปแบบ

อะไรทำให้ AI เกิดการหลอน?

AI hallucination เกิดขึ้นเมื่อโมเดลเรียนรู้รูปแบบที่ผิด

รูปแบบ ในบริบทของ AI หมายถึงความสามารถในการใช้ตัวอย่างฝึกเพื่อ สรุปกับข้อมูลที่ไม่เคยเห็นมาก่อน เช่น การเรียงคำเพื่อ ต่อข้อความ หรือ การกระจายของพิกเซลภาพที่ตรงกับสุนัข

ในกรณีการหลอนของ LLM โมเดลจะเลือกชุดคำที่คิดว่าน่าจะเป็นคำตอบต่อคำสั่งของผู้ใช้มากที่สุด แม้ว่าจะผิดก็ตาม

สาเหตุอาจเกิดจากหนึ่งหรือหลายข้อดังนี้:

ข้อมูลฝึกคุณภาพต่ำ

ChatGPT และ LLM ที่คล้ายกันถูกฝึกด้วยข้อมูลจำนวนมหาศาล ซึ่งถึงแม้จะมาก แต่ก็ไม่สมบูรณ์เพราะ:

- มีช่องว่างในบางหัวข้อ

- สะท้อนอคติในโลกจริง

- ข้อมูลผิดโดยเจตนาหรือเสียดสีที่ไม่ได้ระบุ

- อคติ เช่น ข้อมูลไม่สมดุลหรือ "เอียง" ไปด้านใดด้านหนึ่ง

ลองนึกถึงกรณีที่โมเดลถูกฝึกด้วยข้อมูลเทพเจ้ากรีกทุกองค์ ยกเว้นหนึ่งองค์

ความสามารถในการเชื่อมโยงหัวข้อเกี่ยวกับเทพนิยายกรีก เช่น ความรัก ศีลธรรม การทรยศ อาจทำให้มันแต่งเรื่องใหม่ขึ้นมาเองที่ดู "น่าจะเป็นไปได้" ตามโมเดลสถิติของมัน

สิ่งนี้เห็นได้ชัดในงานสร้างภาพ ที่คำสั่งเกี่ยวกับผู้หญิงมักได้ภาพที่เน้นเรื่องเพศ อคติที่มีต่อการนำเสนอแบบหนึ่ง ส่งผลต่อภาพที่ถูกสร้างขึ้น

การสะกดคำว่า strawberry น่าจะเคยปรากฏในข้อมูลฝึกในบริบทที่พูดถึง R สองตัว ซึ่งเป็นปัญหาของคนที่ไม่ใช่เจ้าของภาษา ในกรณีนี้ เลข 2 หรือคำว่า “double” ก็น่าจะถูกพูดถึงร่วมกับการสะกดคำนี้

ในทางกลับกัน ข้อมูลไม่น่าจะพูดถึงว่ามี R สามตัว

ผลลัพธ์จึงดูแปลก เพราะคำสั่งคือ: ในสถานการณ์ไหนที่ใครจะเขียนคำหนึ่งแล้วถามว่าสะกดอย่างไร?

โครงสร้างโมเดลและวิธีการสร้างผลลัพธ์

โมเดลเหล่านี้สร้างจาก โครงข่ายประสาทเทียม ที่ซับซ้อนมาก ความแตกต่างเพียงเล็กน้อยมีผลต่อวิธีที่โมเดล โต้ตอบกับ ข้อมูลฝึก และ คำสั่ง ความสามารถของโมเดลในการ ลดการหลอน จะได้รับการ ปรับปรุงทีละน้อย ผ่าน การวิจัย และ การทดสอบ อย่างเข้มข้น

นอกจากนี้ วิธีการสร้างผลลัพธ์ก็มีผล โมเดลจะทำนายทีละคำ (จริง ๆ คือ word-piece) ว่าคำไหนน่าจะตามมา ดังนั้น:

“The quick brown fox jumps over the lazy ___.”

โมเดลจะเลือกคำที่น่าจะเป็นไปได้มากที่สุดคือ “dog” แต่ก็อาจเป็นคำอื่นได้ และถ้าสร้างผลลัพธ์โดยเลือกแต่คำที่น่าจะเป็นไปได้มากที่สุดเสมอ ก็จะได้คำตอบที่น่าเบื่อและคาดเดาได้ง่าย

ดังนั้นจึงต้องใช้วิธีสุ่มอย่างสร้างสรรค์เพื่อให้คำตอบน่าสนใจแต่ยังคงสมเหตุสมผล ซึ่งบางครั้งความถูกต้องก็อาจหลุดรอดไป

การฝึกแบบเกิน (Overfitting)

Overfitting คือเมื่อโมเดลถูกฝึกให้ทายข้อมูลได้เป๊ะเกินไปจนไม่สามารถสรุปกับข้อมูลใหม่ได้

ถ้าผมเป็นโมเดล (แม่ผมก็ว่าอย่างนั้น) ผมจะถูกฝึกมาดีถ้าผมรู้จักสุนัขว่า:

ขนฟู หูตก ร่าเริง และมีจมูกกลมสีน้ำตาลเล็ก ๆ

แต่ถ้าฝึกเกิน ผมจะรู้จักสุนัขแค่:

มีจุดสีน้ำตาลใต้คาง ชื่อ “Frank” และเคยกัดรองเท้า Nike คู่โปรดของผมจนพัง

ในบริบทของ LLM มักจะเห็นเป็นการท่องข้อมูลที่เคยเห็นในชุดฝึก แทนที่จะเว้นว่างเมื่อไม่รู้คำตอบ

เช่น ถ้าคุณถามแชทบอทเกี่ยวกับนโยบายคืนสินค้าของบริษัทหนึ่ง ถ้ามันไม่รู้ก็ควรบอก แต่ถ้าฝึกเกิน มันอาจตอบนโยบายของบริษัทที่คล้ายกันแทน

การตั้งคำสั่งที่ไม่ดี (Poor Prompting)

หลายบริษัทออกใบรับรองด้าน prompt engineering เพราะรู้ว่า AI ดีได้เท่ากับข้อมูลที่ป้อนเข้าไปเท่านั้น

คำสั่งที่ดีต้องชัดเจน หลีกเลี่ยงศัพท์เฉพาะ และให้บริบทที่จำเป็นครบถ้วน

เพราะการหลอนมักเกิดตรงขอบเขตของผลลัพธ์ที่มีความน่าจะเป็นต่ำ

เช่น ถ้าคุณถามว่า “what’s the plot of shark girl?” มนุษย์จะคิดว่า “หืม shark girl.” ในโลกสถิติ ความเป็นไปได้คือ:

- The Adventures of Sharkboy and Lavagirl – หนังเด็กยอดนิยมปี 2005 ที่ชื่อคล้ายกัน

- หนังสยองขวัญ/ระทึกขวัญปี 2024 ชื่อ Shark Girl – ไม่ดังเท่าแต่ใหม่กว่าและตรงกว่า

- หนังสือเด็กชื่อเดียวกัน ที่ออกเมื่อต้นปีนี้ – ซึ่งโมเดลอาจจะรู้หรือไม่รู้ก็ได้

ไม่มีตัวเลือกไหนเด่นชัด ทำให้เกิด การกระจายความน่าจะเป็นที่ “แบน” โดยโมเดลไม่เลือกเรื่องใดเรื่องหนึ่งชัดเจน คำสั่งที่มีประสิทธิภาพกว่าควรให้บริบท เช่น ระบุว่าหมายถึงตัวอย่างไหน

ความคลุมเครือและความเกี่ยวข้องแบบอ้อม ๆ นี้ อาจทำให้ได้คำตอบที่แต่งเรื่องปลาฉลามขึ้นมาเอง

การลดโอกาสเกิดการหลอนคือการลดความไม่แน่นอน

ประเภทของการหลอนของ AI

ที่ผ่านมาผมพูดถึงการหลอนแบบกว้าง ๆ ความจริงคือมันเกี่ยวข้องกับแทบทุกด้านของ AI เพื่อความชัดเจน ควรแยกประเภทออกมา

ข้อผิดพลาดด้านข้อเท็จจริง

ตัวอย่างสตรอว์เบอร์รี่ก็อยู่ในหมวดนี้ คือมีข้อผิดพลาดในรายละเอียดของข้อความที่ดูถูกต้อง เช่น ปีที่เหตุการณ์เกิดขึ้น เมืองหลวงของประเทศ หรือสถิติตัวเลข

รายละเอียดเล็ก ๆ ในคำตอบที่ดูดีอาจเป็นอันตรายโดยเฉพาะเมื่อเป็นข้อมูลที่มนุษย์ไม่ค่อยจำ เช่น ตัวเลขเป๊ะ ๆ

เนื้อหาที่แต่งขึ้น

ในปี 2023 Bard ของ Google ได้อ้างผิดว่ากล้องโทรทรรศน์ James Webb ใช้ถ่ายภาพแรกของดาวเคราะห์นอกระบบสุริยะ เรื่องนี้ไม่ใช่แค่ข้อมูลผิดพลาดทางเทคนิค—แต่เป็นข้อมูลเท็จโดยสิ้นเชิง

บางครั้งอาจเป็นการกล่าวอ้างใหญ่โตแบบข้างต้น แต่ส่วนใหญ่มักจะมาในรูปแบบของ URL ที่ไม่มีอยู่จริง หรือชื่อไลบรารีและฟังก์ชันโค้ดที่แต่งขึ้นมาเอง

ควรสังเกตว่าขอบเขตระหว่างข้อผิดพลาดทางข้อเท็จจริงกับเนื้อหาที่แต่งขึ้นมานั้นไม่ชัดเจนเสมอไป

สมมติว่าเรากำลังพูดถึงนักวิจัยคนหนึ่ง ถ้าเราอ้างอิงงานวิจัยของเขาแต่ปีผิด นั่นคือข้อผิดพลาดทางข้อเท็จจริง แต่ถ้าเราระบุชื่อผิดล่ะ? แล้วถ้าทั้งชื่อ และปีผิดล่ะ?

ข้อมูลผิดพลาด

เรื่องนี้อาจอยู่ในสองหมวดหมู่ก่อนหน้านี้ แต่หมายถึงข้อมูลเท็จที่แหล่งที่มาชัดเจนมากขึ้น

ตัวอย่างที่เห็นได้ชัดคือ Google AI แนะนำให้ใส่กาวบนพิซซ่าและกินหิน ซึ่งเนื้อหาต้นทางเป็นเรื่องล้อเลียนและไม่เป็นอันตราย—เป็นคอมเมนต์ใน Reddit ที่เขียนโดย The Onion แต่โมเดลไม่ได้รับการฝึกให้แยกแยะเรื่องนี้

ความเสี่ยงของ AI Hallucinations

1. สูญเสียความไว้วางใจ

เราชื่นชมอิสระในการมอบหมายงานให้ AI ช่วยจัดการ แต่ไม่ใช่ในราคาที่ต้องแลกกับความไว้วางใจ

เหตุการณ์ล่าสุดของ Cursor AI—บอทบริการลูกค้าคิดนโยบายที่เข้มงวดขึ้นมาเอง—ทำให้ผู้ใช้จำนวนมากยกเลิกการสมัครและตั้งคำถามถึงความน่าเชื่อถือ

2. ต้นทุน

AI กลายเป็นหัวใจหลักในหลายธุรกิจ แม้จะเป็นเรื่องดี แต่ความผิดพลาดเพียงครั้งเดียวอาจมีราคาสูง

เหตุการณ์ James Webb ของ Google ทำให้หุ้น Alphabet ร่วง 100,000 ล้านดอลลาร์ ภายในไม่กี่ชั่วโมง และนี่ยังไม่รวมต้นทุนในการฝึกโมเดลใหม่

3. ข้อมูลผิดพลาดที่เป็นอันตราย

เราอาจขำกับเรื่องพิซซ่ากาว แต่ถ้าเป็น ขนาดยาทางการแพทย์ที่ผิดพลาด ล่ะ?

ฉันเองก็อยากได้คำตอบจาก AI แทนการอ่านตัวหนังสือเล็กๆ เต็มไปด้วยคำเตือน แต่ถ้าคำตอบผิดล่ะ? มันแทบจะไม่สามารถคำนึงถึงเงื่อนไขทางการแพทย์ทั้งหมดได้เลย

3. ความปลอดภัยและมัลแวร์

อย่างที่กล่าวไป AI มักจะสร้างชื่อไลบรารีโค้ดขึ้นมาเอง หากคุณพยายามติดตั้งไลบรารีที่ไม่มีอยู่จริง ก็จะไม่มีอะไรเกิดขึ้น

แต่ลองนึกภาพว่ามีแฮกเกอร์ฝังมัลแวร์ไว้ในโค้ดแล้วอัปโหลดโดยใช้ชื่อไลบรารีที่ AI มักแต่งขึ้นมา คุณติดตั้งไลบรารีนั้น แล้ว 💨หายวับ💨: คุณโดนแฮกทันที

เรื่องนี้มีอยู่จริง เรียกว่า slopsquatting

แม้ชื่อจะดูแปลก แต่การตรวจสอบสิ่งที่คุณติดตั้งและตรวจสอบชื่อไลบรารีที่ดูแปลกตาอีกครั้งก็ไม่เสียหายอะไร

วิธีป้องกัน AI Hallucinations

ถ้าคุณไม่ได้ฝึกโมเดลเอง คุณอาจควบคุมข้อมูลและสถาปัตยกรรมได้น้อยมาก

ข่าวดีคือยังมีวิธีป้องกันที่คุณทำได้ และสิ่งเหล่านี้สามารถสร้างความแตกต่างให้กับ AI ที่ปราศจาก Hallucination ได้จริง

เลือกโมเดลและแพลตฟอร์มที่คุณไว้ใจได้

คุณไม่ได้อยู่คนเดียว บริษัท AI เองก็ต้องการรักษาความไว้วางใจ ซึ่งหมายถึงต้องไม่มี Hallucination

ขึ้นอยู่กับสิ่งที่คุณต้องการทำกับ AI คุณมักจะมีตัวเลือกอยู่เสมอ และ แพลตฟอร์ม AI ที่ดีจะช่วยให้เข้าถึงได้ง่าย แพลตฟอร์มเหล่านี้ควรเปิดเผย วิธีที่พวกเขาป้องกัน Hallucination อย่างชัดเจน

ใช้ RAG (Retrieval-Augmented Generation)

อย่าให้โมเดลต้องพึ่งพาความรู้ของตัวเอง การติดตั้ง RAG ให้โมเดลจะทำให้ข้อมูลที่ต้องการหาและแหล่งที่มาชัดเจน

ควรเลือกใช้ AI บนแพลตฟอร์มที่มีคำแนะนำง่ายๆ เกี่ยวกับ วิธีใช้ RAG อย่างมีประสิทธิภาพ

เพิ่มคำแนะนำที่ละเอียด

ถ้าเคยได้ยินก็คงได้ยินมานับครั้งไม่ถ้วน: ข้อมูลขยะ ผลลัพธ์ก็ขยะ

“ตอบคำถามของผู้ใช้” ไม่ได้การันตีความสำเร็จ แต่ถ้าเป็นแบบนี้:

# Instructions

Please refer exclusively to the FAQ document. If the answer does not appear there:

* Politely inform the user that the information is unavailable.

* Offer to escalate the conversation to a human agent.จะช่วยให้เอเจนต์ของคุณทำงานได้ถูกต้อง การตั้งคำถามที่ชัดเจนและมีขอบเขตแน่นอนคือวิธีป้องกันเอเจนต์ที่ทำงานผิดพลาดได้ดีที่สุด

การตรวจสอบโดยมนุษย์

ในเรื่องของการยกระดับปัญหา การมีบุคคลคอยตรวจสอบ ประเมิน และแก้ไขข้อบกพร่องของ AI เป็นสิ่งสำคัญ

ความสามารถในการส่งต่อหรือย้อนกลับไปตรวจสอบบทสนทนา ช่วยให้คุณรู้ว่าอะไรใช้ได้ผลและอะไรเสี่ยงต่อ Hallucination Human-in-the-loop—การมีมนุษย์คอยกำกับดูแลกระบวนการที่ขับเคลื่อนด้วย AI—เป็น สิ่งจำเป็น ในจุดนี้

ใช้ AI ที่ปราศจาก Hallucination ได้แล้ววันนี้

ความไม่แน่นอนเกี่ยวกับความน่าเชื่อถือของ AI อาจทำให้ธุรกิจลังเลที่จะเปลี่ยนผ่านสู่ดิจิทัล

Botpress มีความสามารถ RAG การผสาน Human-in-the-loop และระบบความปลอดภัยที่รัดกุม ทำให้ AI ปลอดภัยและเชื่อถือได้ เอเจนต์ของคุณทำงาน เพื่อคุณ ไม่ใช่ในทางกลับกัน

คำถามที่พบบ่อย

1. จะรู้ได้อย่างไรว่าคำตอบของ AI เป็น Hallucination หากไม่มีความรู้ในหัวข้อนั้นมาก่อน?

หากต้องการตรวจสอบว่าคำตอบของ AI เป็น Hallucination หรือไม่โดยที่ไม่มีความรู้มาก่อน ให้สังเกตสัญญาณ เช่น การอ้างอิงที่เฉพาะเจาะจงมาก ภาษาที่มั่นใจเกินไป หรือชื่อ สถิติ หรือแหล่งอ้างอิงที่ตรวจสอบไม่ได้ หากไม่แน่ใจ ให้ขอให้ AI ระบุแหล่งที่มาหรือเปรียบเทียบกับข้อมูลจากแหล่งที่เชื่อถือได้ภายนอก

2. AI Hallucinations พบได้บ่อยแค่ไหนในโมเดลภาษา (LLMs) ขนาดใหญ่?

AI Hallucinations พบได้บ่อยในโมเดลภาษา (LLMs) ขนาดใหญ่ เพราะโมเดลเหล่านี้สร้างข้อความจากความน่าจะเป็น ไม่ใช่การตรวจสอบข้อเท็จจริง แม้แต่โมเดลขั้นสูงอย่าง GPT-4o และ Claude 3.5 ก็ยังให้ผลลัพธ์ที่ผิดได้ โดยเฉพาะเมื่อถูกถามเรื่องเฉพาะทางหรือในบริบทที่ข้อมูลน้อย

3. Hallucinations เกิดขึ้นได้กับ AI ที่ไม่ใช่ข้อความ เช่น โมเดลสร้างภาพหรือไม่?

ใช่ Hallucinations ก็เกิดกับโมเดลสร้างภาพได้เช่นกัน มักจะเห็นเป็นองค์ประกอบที่ไม่สมจริงหรือไร้เหตุผลในภาพ เช่น แขนขาเกินจำนวน หรือการแสดงวัฒนธรรมผิด เพราะมีอคติหรือช่องว่างในข้อมูลฝึกสอน

4. Hallucinations พบได้บ่อยในบางภาษา หรือบางวัฒนธรรมมากกว่าหรือไม่ เพราะอคติในข้อมูลฝึก?

Hallucinations พบได้บ่อยในภาษาที่มีผู้ใช้น้อย หรือบริบทวัฒนธรรมที่ไม่ใช่ตะวันตก เพราะ LLM ส่วนใหญ่ฝึกจากข้อมูลภาษาอังกฤษและเนื้อหาตะวันตกเป็นหลัก ทำให้ตอบสนองต่อวัฒนธรรมอื่นได้น้อย

5. อุตสาหกรรมใดเสี่ยงต่อผลกระทบจาก AI Hallucinations มากที่สุด?

อุตสาหกรรมอย่างการแพทย์ การเงิน กฎหมาย และบริการลูกค้า เสี่ยงต่อ AI Hallucinations มากที่สุด เพราะผลลัพธ์ที่ผิดในสาขาเหล่านี้อาจนำไปสู่การละเมิดกฎระเบียบ ความเสียหายทางการเงิน ข้อผิดพลาดทางกฎหมาย หรือทำลายความเชื่อมั่นและชื่อเสียงของแบรนด์

.webp)