- El prompting de cadena de pensamiento guía a los modelos de IA para que razonen paso a paso, ayudándoles a resolver tareas complejas con mayor precisión que solo prediciendo la siguiente palabra.

- Es más útil para problemas de varios pasos, como matemáticas, acertijos lógicos o tareas procedimentales, pero innecesario para consultas simples o de un solo paso.

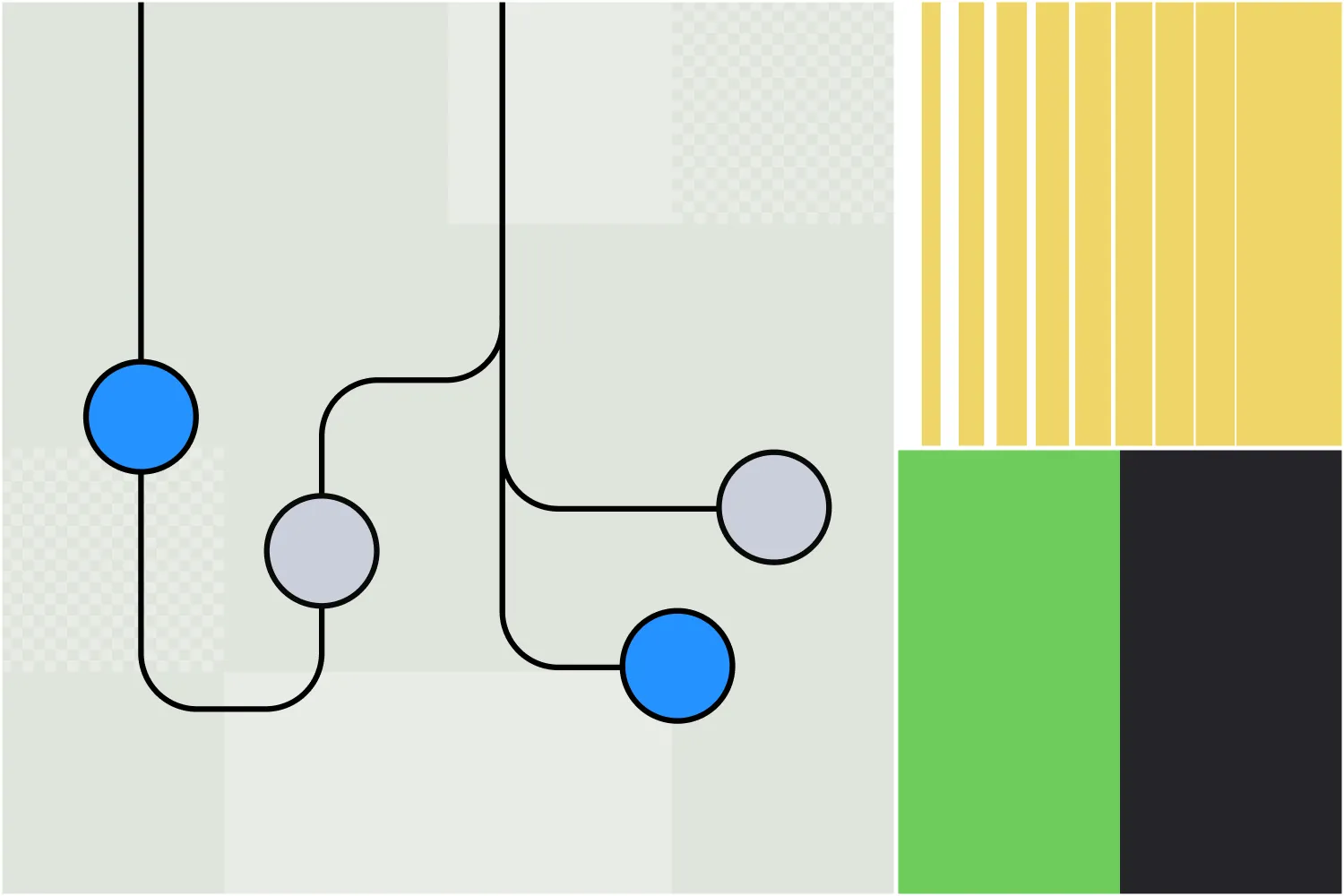

- El encadenamiento de prompts se diferencia del chain-of-thought porque divide una tarea en varios prompts separados, mientras que el chain-of-thought permanece en un solo flujo de pregunta-respuesta.

Si has usado un chatbot GPT como ChatGPT, probablemente hayas notado la variada calidad de las respuestas.

A veces te da justo lo que necesitas. Otras veces sospechas que la ‘inteligencia’ de la IA es un poco una farsa.

Puedes mejorar tu experiencia con ChatGPT afinando la forma en que lo usas. Los prompts en cadena animan a los agentes LLM a razonar paso a paso antes de generar una respuesta.

Los modelos de IA más recientes y sus funciones empiezan a incorporar el razonamiento en cadena directamente, de modo que los modelos razonan automáticamente sobre el problema sin necesidad de indicaciones adicionales.

¿Qué es el chain-of-thought prompting?

El 'chain-of-thought prompting' es una técnica de ingeniería de prompts en IA que instruye a los modelos a descomponer tareas complejas, razonando cada paso antes de responder.

También puedes escuchar el término ‘razonamiento en cadena’. Esto se refiere al proceso paso a paso que el modelo seguirá para razonar la tarea en cuestión.

Los modelos OpenAI o1 no requieren prompts en cadena, porque ya tienen razonamiento en cadena integrado. Pero puedes usar prompts en cadena en cualquier chatbot basado en LLM.

¿Cómo funciona el razonamiento en cadena?

El razonamiento en cadena consiste en dividir un problema en pasos lógicos más pequeños para que el chatbot de IA los resuelva en secuencia.

Primero, la IA identifica las partes clave del problema. Luego procesa cada parte en secuencia, considerando cómo un paso lleva al siguiente. Cada paso se basa en el anterior, permitiendo que la IA avance metódicamente hacia una conclusión lógica.

Ejemplos de chain-of-thought prompting

El famoso prompt de la ‘fresa’

ChatGPT y otros LLM tienen debilidades bien documentadas. Una es su incapacidad para identificar correctamente cuántas 'R' hay en la palabra ‘strawberry’. (Probablemente la famosa limitación detrás del nombre en clave de los modelos o1: Strawberry.)

ChatGPT-4o no utiliza razonamiento en cadena. En su lugar, hace referencia a sus datos de entrenamiento y genera una respuesta según la probabilidad de que cada palabra siga a la anterior. Aunque suene correcto la mayoría de las veces, solo genera para imitar el lenguaje humano, no para razonar o investigar.

Cuando le haces a ChatGPT-4o la famosa pregunta de la fresa, no puede dar la respuesta correcta:

Sin embargo, puedes utilizar la técnica de indicaciones en cadena de pensamiento para ayudar al chatbot impulsado por LLM a llegar a la respuesta correcta:

La última versión de ChatGPT, impulsada por OpenAI o1-preview, es el primer gran LLM que utiliza razonamiento en cadena sin indicaciones adicionales.

Resuelve el problema al primer intento, porque se le ha indicado que siga automáticamente el mismo proceso que en el segundo prompt de ChatGPT-4o anterior. La única diferencia es que realiza este proceso sin indicaciones adicionales.

Matemáticas

Si le preguntabas a una versión anterior de ChatGPT una pregunta de matemáticas de un libro de primaria, no siempre la respondía correctamente.

Los problemas matemáticos de varios pasos requieren razonamiento, algo que no estaba presente en los primeros LLMs. Podías desglosar cada paso del problema, pero si no conocías los pasos correctos, un LLM no podía ayudarte.

ChatGPT-4o puede razonar la respuesta a la pregunta desglosando la serie de pasos del problema:

Agentes de IA conectados a Hubspot

Para un caso real, tomemos un agente de IA impulsado por LLM que se ha integrado en Hubspot. Un equipo de ventas utiliza este agente para procesar nuevos leads que llegan desde diferentes canales.

Escenario

Un vendedor envía un nuevo lead al agente de IA y le pide que lo registre en Hubspot y envíe un primer correo de contacto, pero que no lo registre si el lead trabaja en una empresa que ya es prospecto.

LLM sin razonamiento en cadena

El agente de IA potenciado por LLM registra el lead y envía el correo sin verificar si la empresa ya es un prospecto, omitiendo una condición clave.

LLM con razonamiento en cadena

El agente de IA impulsado por LLM verifica si la empresa ya es un prospecto antes de actuar. Si ya lo es, omite el registro y el envío de correo; si no, registra el lead y envía el correo, siguiendo las instrucciones del vendedor al pie de la letra.

¿Cuándo debo usar el chain of thought prompting?

El encadenamiento de razonamientos es ideal para escenarios que requieren pasos lógicos secuenciales.

Las tareas ideales son aquellas que implican deducciones lógicas, problemas matemáticos, tareas procedimentales o cualquier situación que requiera respuestas de varios pasos.

Pero espera: el razonamiento suena genial, ¿por qué no usarlo siempre?

Buena pregunta. No todas las preguntas requieren razonamiento. Por ejemplo:

- Preguntas simples de hechos, como ‘¿Cuál es la capital de Canadá?’

- Problemas de un solo paso, como ‘¿Cuánto es 145 + 37?’

- Tareas de generación de contenido, como 'Escribe un correo educado de 3 frases para preguntar a mi colega si ya terminó su proyecto'.

Encadenamiento de prompts vs chain-of-thought prompting

Aunque sus nombres son similares, prompt chaining y el prompt de cadena de pensamiento son estrategias diferentes para mejorar la generación de IA.

Prompts de cadena de pensamiento

Con el prompting de cadena de pensamiento, un usuario guía a la IA para que explique el razonamiento detrás de su respuesta en una sola interacción. Esto hace que la IA recorra cada paso del proceso de resolución de problemas, pero todo se logra en un solo mensaje y respuesta.

Por ejemplo, un prompt de chain-of-thought se puede hacer en un solo mensaje:

"Un equipo de RRHH debe revisar 5 evaluaciones de desempeño de empleados. Cada una tomará 30 minutos y necesitan 15 minutos de preparación previa. Las evaluaciones de empleados senior requerirán 10 minutos extra cada una. ¿Cuánto tiempo tomará completar 5 evaluaciones senior y 25 junior? Desglosa tu razonamiento paso a paso."

Encadenamiento de prompts

Con el encadenamiento de prompts, la tarea se divide en pasos separados con varios prompts, cada uno basado en el resultado anterior. Esto ayuda a estructurar y guiar a la IA a través de una tarea compleja que probablemente requiera razonamiento.

El primer prompt podría ser:

Prompt 1: Identifica los principales desafíos que puede enfrentar una empresa al pasar al trabajo remoto.

Salida:

- Brechas en la comunicación

- Mantener la productividad

- Infraestructura tecnológica

- Compromiso de los empleados

Los siguientes prompts pueden profundizar en estos conceptos. Por ejemplo:

Prompt 2: Por favor, dime cómo una empresa puede encontrar soluciones a los problemas de comunicación al pasar al trabajo remoto.

Después de la siguiente ronda de respuestas, el siguiente eslabón de la cadena podría ser:

Prompt 3: ¿Cuáles son los desafíos comunes que enfrentan las empresas al adoptar estas soluciones?

Así que, aunque son similares, cada uno toma un enfoque diferente para extraer el contenido más relevante y profundo de las herramientas de IA generativa.

Chain-of-thought prompting en Botpress

Los usuarios de Botpress ya conocen una función que utiliza razonamiento en cadena.

El Autonomous Node debutó en julio de 2024 en Botpress, una plataforma para crear agentes de IA. El Autonomous Node es capaz de automatizar flujos de trabajo de varios pasos y tomar decisiones de forma autónoma.

Puedes crear y configurar un Autonomous Node con una simple línea de texto, como: 'Tu objetivo es generar clientes potenciales calificados. Crea leads en Salesforce cuando un usuario muestre intención de compra.'

El agente de IA que crees usando este Nodo Autónomo tomará diversas acciones para lograr su objetivo, de forma independiente a los flujos diseñados por humanos. También puede alternar entre diferentes LLMs según sea necesario, decidiendo priorizar velocidad o potencia.

Crea un agente autónomo personalizado

Botpress es la única plataforma de agentes de IA que te permite crear agentes realmente autónomos.

El Botpress Studio, abierto y flexible, permite casos de uso ilimitados en cualquier industria, desde RRHH hasta generación de leads. Nuestra biblioteca de integraciones preconstruidas y tutoriales extensos permiten a los usuarios crear agentes de IA desde cero fácilmente.

Empieza a construir hoy. Es gratis.

O bien, contacta a nuestro equipo de ventas.

Preguntas frecuentes

1. ¿El razonamiento en cadena de pensamiento solo es útil para modelos de IA, o también refleja cómo resuelven problemas los humanos?

El chain-of-thought prompting es útil tanto para los modelos de IA como para las personas, ya que imita la forma en que resolvemos problemas complejos razonando paso a paso.

2. ¿En qué se diferencia el razonamiento de cadena de pensamiento de simplemente “pensar paso a paso”?

Aunque "pensar paso a paso" es un enfoque general, el razonamiento de cadena de pensamiento es más estructurado y deliberado, alentando al modelo de IA a expresar explícitamente los pasos intermedios del razonamiento en lugar de saltar directamente a conclusiones.

3. ¿Por qué algunos LLM no utilizan el razonamiento en cadena de pensamiento por defecto?

Algunos LLMs, especialmente los modelos más antiguos o pequeños, no utilizan razonamiento de cadena de pensamiento por defecto porque no fueron ajustados para producir respuestas de varios pasos y, en cambio, se centran en predecir respuestas probables según los patrones de los datos de entrenamiento.

4. ¿El chain-of-thought prompting es una forma de “entrenar” el modelo durante la inferencia?

No, el chain-of-thought prompting no es una forma de entrenamiento; no modifica los pesos ni el conocimiento del modelo. En cambio, guía el comportamiento de salida del modelo durante la inferencia fomentando el razonamiento estructurado mediante el prompt.

5. ¿El prompting de cadena de pensamiento siempre mejora la precisión?

El prompt de cadena de pensamiento no siempre mejora la precisión. Suele ayudar en tareas que requieren razonamiento de varios pasos, pero en tareas simples puede añadir complejidad innecesaria e incluso reducir el rendimiento.

.webp)