- O chain-of-thought prompting orienta modelos de IA a raciocinar passo a passo, ajudando-os a resolver tarefas complexas com mais precisão do que apenas prever a próxima palavra.

- É mais indicado para problemas em várias etapas, como matemática, quebra-cabeças lógicos ou tarefas processuais, mas é desnecessário para perguntas simples ou de resposta única.

- Prompt chaining é diferente de chain-of-thought prompting porque divide uma tarefa em vários prompts separados, enquanto o chain-of-thought permanece em um único fluxo de pergunta e resposta.

Se você já usou um chatbot GPT como o ChatGPT, provavelmente percebeu que a qualidade das respostas varia bastante.

Às vezes ele entrega exatamente o que você precisa. Outras vezes, você desconfia que a ‘inteligência’ da IA é meio duvidosa.

Você pode melhorar seu uso do ChatGPT aprimorando seus prompts. O prompt em cadeia de pensamento incentiva agentes LLM a raciocinar sobre uma tarefa passo a passo antes de gerar uma resposta.

Modelos de IA mais recentes e recursos novos estão começando a incorporar o raciocínio em cadeia diretamente, fazendo com que os modelos analisem o problema automaticamente, sem necessidade de instruções extras.

O que é o prompting de cadeia de pensamento?

O chain-of-thought prompting é uma técnica de engenharia de prompts em IA que orienta os modelos a dividir tarefas complexas, raciocinando sobre cada etapa antes de responder.

Você também pode ouvir o termo ‘raciocínio em cadeia’. Isso se refere ao processo passo a passo que o modelo segue para analisar a tarefa em questão.

Os modelos OpenAI o1 não exigem prompts em cadeia de pensamento, pois já têm esse raciocínio embutido. Mas você pode usar prompts em cadeia de pensamento em qualquer chatbot com LLM.

Como funciona o chain-of-thought reasoning?

O raciocínio em cadeia de pensamento consiste em dividir um problema em etapas menores e lógicas para que o chatbot de IA resolva em sequência.

Primeiro, a IA identifica as partes principais do problema. Depois, processa cada parte em sequência, considerando como um passo leva ao próximo. Cada etapa se baseia na anterior, permitindo que a IA avance metodicamente até uma conclusão lógica.

Exemplos de prompting em cadeia de pensamento

O famoso prompt do ‘morango’

O ChatGPT e outros LLMs têm limitações bem documentadas. Uma delas é a incapacidade de identificar corretamente quantos 'R's há na palavra ‘strawberry’. (Provavelmente a famosa limitação por trás do codinome dos modelos o1: Strawberry.)

O ChatGPT-4o não utiliza raciocínio em cadeia. Ele consulta seus dados de treinamento e gera respostas com base na probabilidade de cada palavra vir após a anterior. Embora soe correto na maioria das vezes, ele apenas simula a linguagem humana — não está realmente raciocinando ou pesquisando.

Quando você faz a famosa pergunta do morango ao ChatGPT-4o, ele não consegue dar a resposta correta:

No entanto, você pode usar uma técnica de prompting em cadeia de pensamento para ajudar o chatbot baseado em LLM a chegar à resposta correta:

A versão mais recente do ChatGPT, movida pelo OpenAI o1-preview, é o primeiro grande LLM a usar chain-of-thought reasoning sem prompts adicionais.

Ele acerta a resposta na primeira tentativa, porque foi instruído a seguir automaticamente o mesmo processo do segundo prompt do ChatGPT-4o acima. A única diferença é que faz isso sem prompts adicionais.

Matemática

Se você perguntasse a uma versão antiga do ChatGPT uma questão de matemática de um livro do ensino fundamental, ela nem sempre acertaria.

Problemas matemáticos de múltiplas etapas exigem raciocínio, algo que não estava presente nos primeiros LLMs. Você poderia dividir cada etapa do problema, mas se não soubesse os passos corretos, um LLM não conseguiria ajudar.

O ChatGPT-4o consegue chegar à resposta da pergunta ao dividir o problema em etapas:

Agentes de IA conectados ao Hubspot

Para um exemplo prático, vamos considerar um agente de IA com LLM integrado ao Hubspot. Uma equipe de vendas usa esse agente para processar novos leads à medida que são captados em vários canais.

Cenário

Um vendedor envia um novo lead para o agente de IA e pede para registrá-lo no Hubspot e enviar um e-mail de primeiro contato, mas não preencher se o lead trabalha em uma empresa que já é prospect.

LLM sem raciocínio em cadeia

O agente de IA com LLM registra o lead e envia o e-mail sem verificar se a empresa já é um prospect, deixando de cumprir uma condição importante.

LLM com raciocínio em cadeia

O agente de IA com LLM verifica se a empresa já é um prospect antes de agir. Se já for, ele pula o cadastro e o envio do e-mail; se não for, cadastra o lead e envia o e-mail, seguindo as instruções do vendedor com precisão.

Quando devo usar prompting com cadeia de pensamento?

O chain-of-thought prompting é melhor utilizado em cenários que exigem raciocínio passo a passo.

Candidatos ideais são tarefas que envolvem deduções lógicas, problemas matemáticos, tarefas procedimentais ou qualquer situação que exija respostas em várias etapas.

Mas espere: raciocínio parece ótimo – por que não usar isso o tempo todo?

Boa pergunta. Nem todas as perguntas exigem raciocínio. Por exemplo:

- Perguntas factuais simples, como ‘Qual é a capital do Canadá?’

- Problemas de um passo só, como ‘Quanto é 145 + 37?’

- Tarefas de geração de conteúdo, como ‘Escreva um e-mail educado de 3 frases perguntando ao colega se ele já terminou o projeto’.

Prompting dinâmico vs prompting em cadeia de pensamento

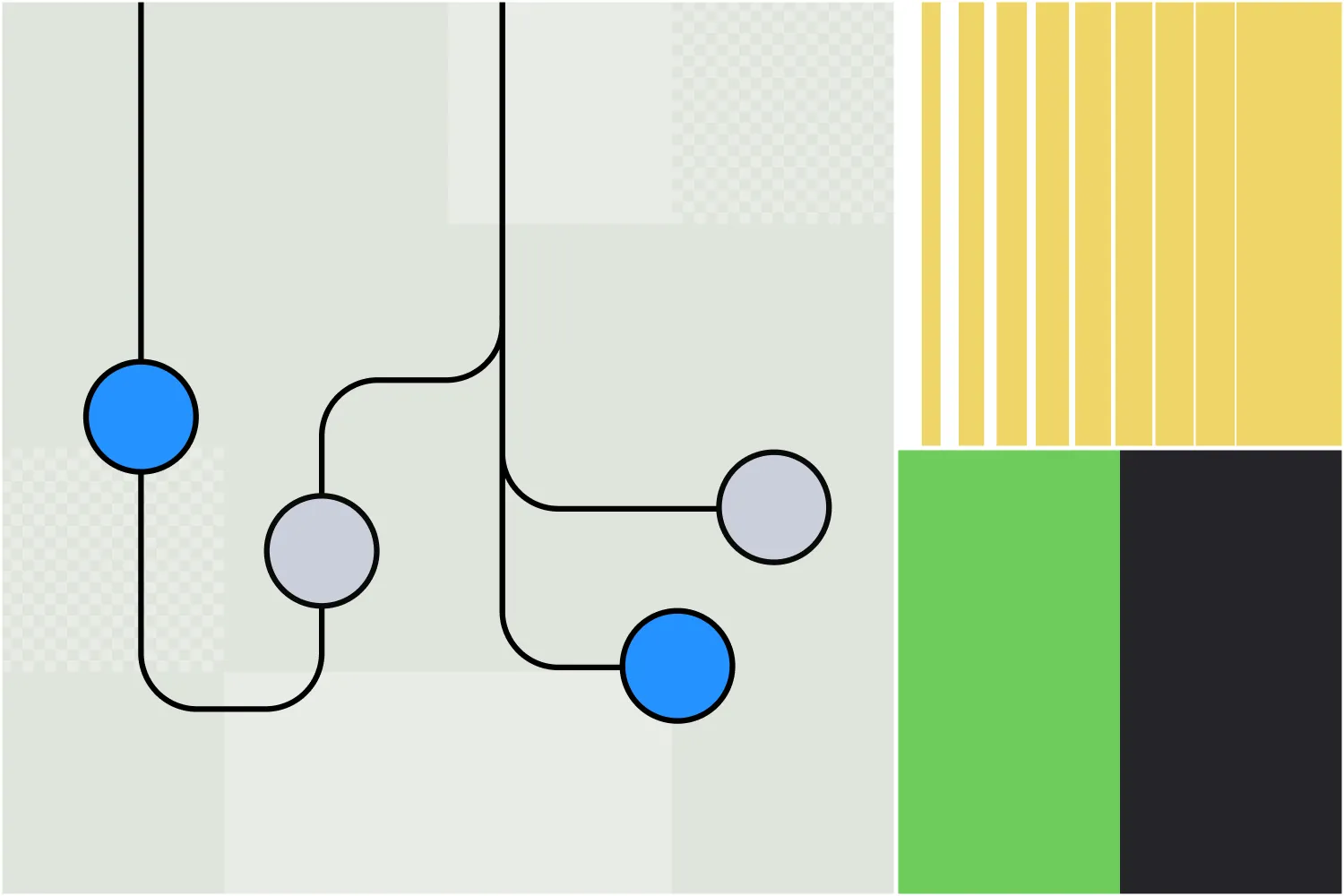

Apesar dos nomes parecidos, prompt chaining e chain-of-thought prompting são estratégias diferentes para melhorar a geração de respostas em IA.

Chain-of-thought prompting

Com o chain-of-thought prompting, o usuário orienta a IA a explicar o raciocínio por trás da resposta em uma única interação. Isso faz com que a IA percorra cada etapa do processo de resolução do problema, mas tudo em um único comando e resposta.

Por exemplo, um prompt chain-of-thought pode ser feito em uma mensagem só:

"Uma equipe de RH precisa revisar 5 avaliações de desempenho de funcionários. Cada uma leva 30 minutos e eles precisam de 15 minutos de preparação antes. Avaliações de funcionários seniores exigem 10 minutos extras cada. Quanto tempo levará para concluir 5 avaliações de seniores e 25 de juniores? Explique seu raciocínio passo a passo."

Encadeamento de prompts

No encadeamento de prompts, a tarefa é dividida em etapas separadas com vários prompts, cada um aproveitando o resultado anterior. Isso ajuda a estruturar e guiar a IA em tarefas complexas que normalmente envolvem raciocínio.

O primeiro prompt pode ser assim:

Prompt 1: Identifique os principais desafios que uma empresa pode enfrentar ao migrar para o trabalho remoto.

Saída:

- Lacunas de comunicação

- Manutenção da produtividade

- Infraestrutura tecnológica

- Engajamento dos funcionários

Os próximos prompts podem aprofundar esses conceitos. Por exemplo:

Prompt 2: Por favor, diga como uma empresa pode encontrar soluções para falhas de comunicação ao migrar para o trabalho remoto.

Após a próxima rodada de respostas, o próximo elo da cadeia pode ser:

Prompt 3: Quais são os desafios mais comuns que as empresas enfrentam ao adotar essas soluções?

Portanto, embora sejam parecidos, eles adotam abordagens diferentes para extrair o conteúdo mais relevante e aprofundado das ferramentas de IA generativa.

Chain-of-thought prompting no Botpress

Usuários do Botpress já conhecem um recurso que utiliza raciocínio em cadeia.

O Autonomous Node foi lançado em julho de 2024 no Botpress, uma plataforma para criação de agentes de IA. O Autonomous Node é capaz de automatizar fluxos de trabalho com várias etapas e tomar decisões de forma autônoma.

Um Nó Autônomo pode ser criado e orientado com uma simples linha de texto, como: 'Seu objetivo é gerar leads qualificados. Crie leads no Salesforce quando um usuário demonstrar intenção de compra.'

O agente de IA que você cria usando este Nó Autônomo tomará diversas ações para atingir seu objetivo, independentemente dos fluxos criados por humanos. Ele também pode alternar entre diferentes LLMs conforme necessário, decidindo priorizar velocidade ou desempenho.

Crie um agente autônomo personalizado

A Botpress é a única plataforma de agentes de IA que permite criar agentes realmente autônomos.

O Botpress Studio, aberto e flexível, permite infinitos casos de uso em diversos setores, de RH à geração de leads. Nossa biblioteca de integrações prontas e tutoriais completos permitem que qualquer usuário crie agentes de IA do zero com facilidade.

Comece a construir hoje mesmo. É grátis.

Ou fale com nosso time de vendas.

Perguntas frequentes

1. O chain-of-thought prompting é útil apenas para modelos de IA ou também reflete a resolução de problemas humana?

O chain-of-thought prompting é útil tanto para modelos de IA quanto para humanos, pois imita a forma como as pessoas naturalmente resolvem problemas complexos, raciocinando passo a passo.

2. Como o raciocínio chain-of-thought é diferente de apenas 'pensar passo a passo'?

Embora "pensar passo a passo" seja uma abordagem geral, o chain-of-thought reasoning é mais estruturado e deliberado, incentivando o modelo de IA a articular explicitamente os passos intermediários do raciocínio em vez de pular direto para a conclusão.

3. Por que alguns LLMs não utilizam o raciocínio em cadeia de pensamento por padrão?

Alguns LLMs, especialmente modelos mais antigos ou menores, não usam chain-of-thought reasoning por padrão porque não foram ajustados para produzir respostas em múltiplas etapas, focando apenas em prever respostas prováveis com base nos padrões dos dados de treinamento.

4. Prompting em cadeia é uma forma de “treinar” o modelo durante a inferência?

Não, o chain-of-thought prompting não é uma forma de treinamento; ele não altera os pesos ou o conhecimento do modelo. Em vez disso, orienta o comportamento da saída do modelo durante a inferência, incentivando o raciocínio estruturado por meio do prompt.

5. O chain-of-thought prompting sempre melhora a precisão?

O uso de chain-of-thought prompting nem sempre melhora a precisão. Ele tende a ajudar em tarefas que exigem raciocínio em várias etapas, mas em tarefas simples pode adicionar complexidade desnecessária e até reduzir o desempenho.

.webp)