- Le chain-of-thought prompting amène les modèles d’IA à raisonner étape par étape, ce qui les aide à résoudre des tâches complexes plus précisément que s’ils se contentaient de prédire le mot suivant.

- Ils sont particulièrement adaptés aux problèmes en plusieurs étapes, comme les calculs, les énigmes logiques ou les tâches procédurales, mais inutiles pour les questions factuelles simples ou les requêtes à une seule étape.

- Le prompt chaining se distingue du chain-of-thought en découpant une tâche en plusieurs prompts distincts, alors que le chain-of-thought reste dans un seul flux question-réponse.

Si vous avez déjà utilisé un chatbot GPT comme ChatGPT, vous avez sûrement remarqué la qualité variable des réponses.

Parfois, il fournit exactement ce qu’il faut. D’autres fois, on se demande si l’« intelligence » de l’IA n’est pas un peu surfaite.

Vous pouvez améliorer vos résultats avec ChatGPT en soignant vos instructions. Le chain-of-thought prompting encourage les agents LLM à raisonner étape par étape avant de générer une réponse.

Les modèles et fonctionnalités d’IA les plus récents intègrent désormais le raisonnement en chaîne directement, ce qui permet au modèle de raisonner automatiquement sans instructions supplémentaires.

Qu’est-ce que le chain-of-thought prompting ?

Le chain-of-thought prompting est une technique d’ingénierie de prompt en IA qui consiste à demander au modèle de décomposer une tâche complexe, en raisonnant étape par étape avant de répondre.

Vous entendrez peut-être aussi parler de « raisonnement en chaîne ». Cela désigne le processus étape par étape que le modèle suit pour résoudre la tâche.

Les modèles OpenAI o1 n’ont pas besoin de raisonnement en chaîne dans les prompts, car ils l’intègrent déjà. Mais vous pouvez utiliser ce type de prompt avec n’importe quel chatbot basé sur un LLM.

Comment fonctionne le raisonnement en chaîne ?

Le raisonnement en chaîne consiste à décomposer un problème en étapes logiques plus petites, que le chatbot IA résout dans l’ordre.

D’abord, l’IA identifie les éléments clés du problème. Ensuite, elle traite chaque partie dans l’ordre, en tenant compte de l’enchaînement logique. Chaque étape s’appuie sur la précédente, ce qui permet à l’IA d’avancer méthodiquement vers une conclusion logique.

Exemples de prompting en chaîne de pensée

Le fameux prompt « fraise »

ChatGPT et d’autres LLM présentent des faiblesses bien connues. L’une d’elles est leur incapacité à compter correctement le nombre de « R » dans le mot « strawberry ». (C’est probablement la fameuse limite à l’origine du nom de code des modèles o1 : Strawberry.)

ChatGPT-4o n’utilise pas le raisonnement en chaîne. Il se base sur ses données d’entraînement et génère une réponse selon la probabilité d’apparition de chaque mot. Même si cela semble correct la plupart du temps, il ne fait qu’imiter le langage humain — il ne raisonne pas et ne fait pas de recherche.

Lorsque vous posez à ChatGPT-4o la fameuse question sur la fraise, il n’est pas capable de donner la bonne réponse :

Cependant, vous pouvez utiliser la technique du raisonnement en chaîne pour aider le chatbot basé sur un LLM à trouver la bonne réponse :

La dernière version de ChatGPT, propulsée par OpenAI o1-preview, est le premier grand LLM à utiliser le raisonnement en chaîne sans instructions supplémentaires.

Il trouve la bonne réponse du premier coup, car il a été programmé pour suivre automatiquement le même processus que le second prompt ChatGPT-4o ci-dessus. La seule différence, c’est qu’il applique ce processus sans instructions supplémentaires.

Mathématiques

Si vous posiez une question de mathématiques tirée d’un manuel de primaire à une ancienne version de ChatGPT, la réponse n’était pas toujours correcte.

Les problèmes de maths à plusieurs étapes nécessitent du raisonnement, ce que les anciens modèles LLM ne savaient pas faire. On pouvait décomposer chaque étape, mais sans connaître la bonne méthode, un LLM ne pouvait pas aider.

ChatGPT-4o parvient à trouver la réponse à la question en décomposant les différentes étapes du problème :

Agents IA connectés à Hubspot

Pour un exemple concret, prenons un agent IA propulsé par LLM et intégré à Hubspot. Une équipe commerciale utilise cet agent pour traiter les nouveaux prospects collectés sur différents canaux.

Scénario

Un commercial transmet un nouveau prospect à l’agent IA et lui demande de l’enregistrer dans Hubspot et d’envoyer un premier email de contact, mais de ne pas le faire si le prospect travaille dans une entreprise déjà prospectée.

LLM sans raisonnement par chaîne de pensée

L’agent IA propulsé par LLM enregistre le prospect et envoie l’email sans vérifier si l’entreprise est déjà dans la base, oubliant une condition essentielle.

LLM avec raisonnement en chaîne

L’agent IA propulsé par LLM vérifie si l’entreprise est déjà un prospect avant d’agir. Si c’est le cas, il passe l’étape d’enregistrement et d’envoi d’email ; sinon, il enregistre le lead et envoie l’email, en suivant précisément les instructions du commercial.

Quand utiliser le prompting en chaîne de pensée ?

Le chain-of-thought prompting est particulièrement adapté aux situations qui nécessitent un raisonnement étape par étape.

Les tâches idéales sont celles qui impliquent des déductions logiques, des problèmes mathématiques, des tâches procédurales ou toute situation nécessitant une réponse en plusieurs étapes.

Mais attendez : le raisonnement semble formidable ; pourquoi ne pas l’utiliser tout le temps ?

Bonne question. Toutes les questions ne nécessitent pas de raisonnement. Par exemple :

- Des questions factuelles simples, comme « Quelle est la capitale du Canada ? »

- Problèmes à une seule étape, comme « Quel est le résultat de 145 + 37 ? »

- Tâches de génération de contenu, comme « Rédige un email poli de 3 phrases pour demander à mon collègue s’il a terminé son projet ».

Prompting classique vs prompting en chaîne de pensée

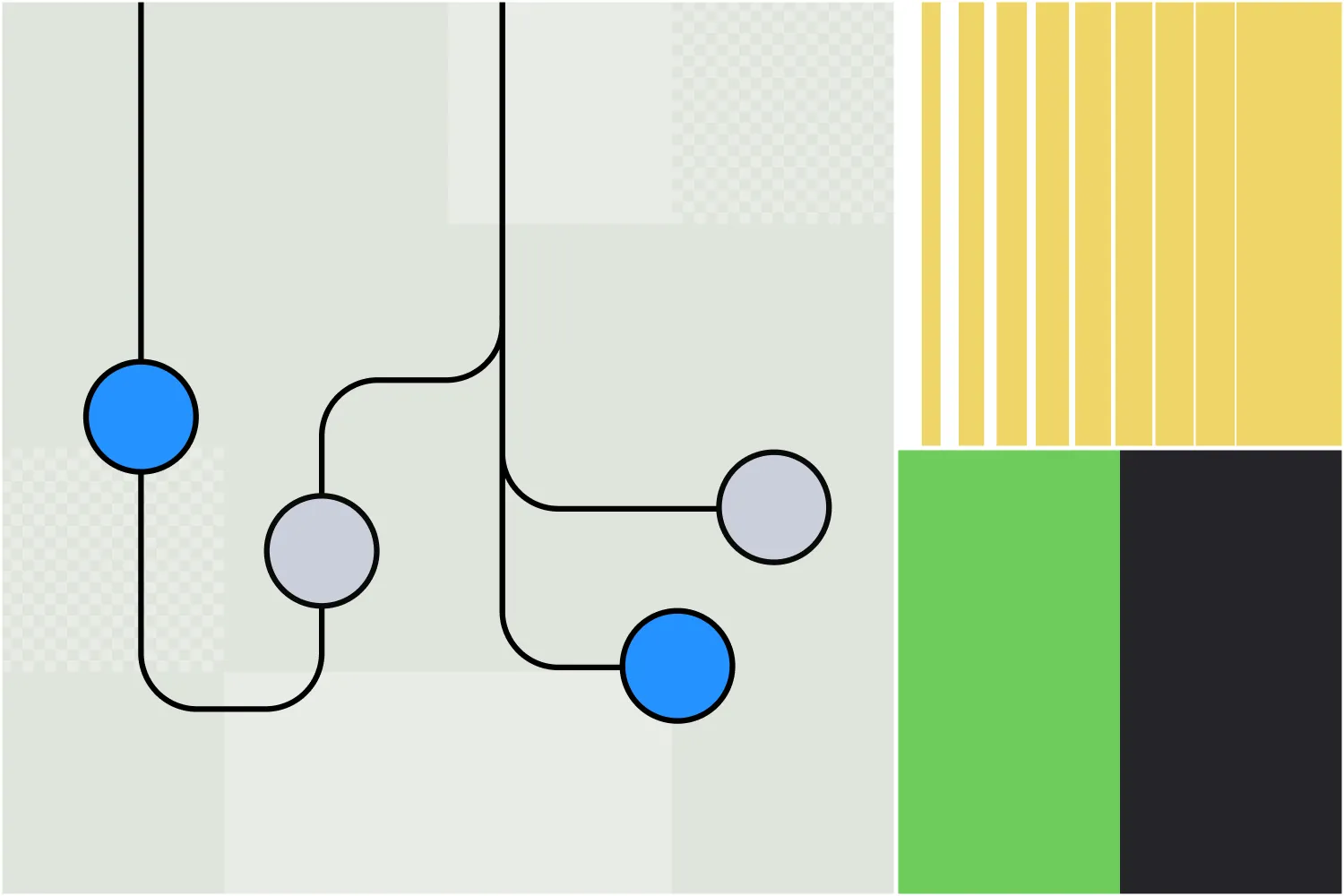

Bien que leurs noms soient proches, le chaînage de prompts et le chaînage de pensée sont deux stratégies différentes pour améliorer les résultats de l’IA générative.

Chaînage de pensée

Avec le chain-of-thought prompting, l’utilisateur demande à l’IA d’expliquer son raisonnement dans une seule réponse. L’IA détaille alors chaque étape du processus de résolution, mais tout est fait en une seule question et une seule réponse.

Par exemple, un prompt chain-of-thought peut être traité en un seul message :

« Une équipe RH doit examiner 5 évaluations de performance. Chaque évaluation prend 30 minutes et il faut 15 minutes de préparation. Les évaluations seniors nécessitent 10 minutes supplémentaires chacune. Combien de temps faudra-t-il pour traiter 5 évaluations seniors et 25 juniors ? Décomposez votre raisonnement étape par étape. »

Chaînage de prompts

Avec l’enchaînement de prompts, la tâche est divisée en étapes distinctes avec plusieurs prompts, chacun s’appuyant sur le résultat précédent. Cela permet de structurer et de guider l’IA dans une tâche complexe qui demande du raisonnement.

Le premier prompt pourrait être :

Prompt 1 : Identifiez les principaux défis qu’une entreprise peut rencontrer lors du passage au travail à distance.

Sortie :

- Problèmes de communication

- Maintenir la productivité

- Infrastructure technologique

- Engagement des employés

Les prompts suivants peuvent approfondir ces notions. Par exemple :

Prompt 2 : Expliquez comment une entreprise peut combler les lacunes de communication lors du passage au télétravail.

Après la prochaine série de réponses, la suite de la chaîne pourrait être :

Prompt 3 : Quels sont les défis courants rencontrés par les entreprises lors de l’adoption de ces solutions ?

Ainsi, même si les deux approches sont proches, elles diffèrent dans la façon d’obtenir des réponses détaillées et pertinentes des outils d’IA générative.

Le chaînage de pensée sur Botpress

Les utilisateurs de Botpress connaissent déjà une fonctionnalité qui utilise le raisonnement en chaîne de pensée.

L’Autonomous Node a été lancé en juillet 2024 sur Botpress, une plateforme de création d’agents IA. L’Autonomous Node est capable d’automatiser des workflows multi-étapes et de prendre des décisions de façon autonome.

Un Autonomous Node peut être créé et paramétré avec une simple ligne de texte, comme « Votre objectif est de générer des leads qualifiés. Créez des leads dans Salesforce lorsqu’un utilisateur manifeste une intention d’achat. »

L’agent IA que vous créez avec ce nœud autonome prendra différentes actions pour atteindre son objectif, indépendamment des workflows conçus par des humains. Il peut aussi basculer entre différents LLM selon les besoins, en choisissant de privilégier la rapidité ou la puissance.

Créer un agent autonome personnalisé

Botpress est la seule plateforme d’agents IA qui permet de créer de véritables agents autonomes.

La flexibilité et l’ouverture de Botpress Studio permettent des cas d’usage infinis, de la gestion RH à la génération de leads. Notre bibliothèque d’intégrations prêtes à l’emploi et nos nombreux tutoriels facilitent la création d’agents IA sur mesure.

Commencez à créer dès aujourd’hui. C’est gratuit.

Ou contactez notre équipe commerciale.

FAQ

1. Le raisonnement par chaîne de pensées est-il utile uniquement pour les modèles IA, ou reflète-t-il aussi la façon dont les humains résolvent les problèmes ?

Le chaînage de pensée est utile aussi bien pour les modèles d’IA que pour les humains, car il reproduit la façon dont nous résolvons naturellement des problèmes complexes en raisonnant étape par étape.

2. En quoi le raisonnement chain-of-thought est-il différent du simple « raisonnement étape par étape » ?

Si « réfléchir étape par étape » est une approche générale, le raisonnement en chaîne est plus structuré et intentionnel. Il pousse le modèle IA à expliciter chaque étape de son raisonnement au lieu de sauter directement à la conclusion.

3. Pourquoi certains LLM n'utilisent-ils pas par défaut le raisonnement en chaîne de pensées ?

Certains LLM, notamment les modèles plus anciens ou plus petits, n’utilisent pas le raisonnement en chaîne par défaut car ils n’ont pas été entraînés pour produire des réponses en plusieurs étapes, mais plutôt pour prédire la réponse la plus probable selon leurs données d’entraînement.

4. Le chain-of-thought prompting est-il une forme d’« apprentissage » du modèle lors de l’inférence ?

Non, le chain-of-thought prompting n’est pas une forme d’entraînement ; il ne modifie pas les poids ou les connaissances du modèle. Il oriente simplement le comportement du modèle lors de l’inférence, en encourageant un raisonnement structuré via le prompt.

5. Le chain-of-thought prompting améliore-t-il toujours la précision ?

Le chain-of-thought prompting n’améliore pas toujours la précision. Il est utile pour les tâches nécessitant un raisonnement en plusieurs étapes, mais peut ajouter de la complexité inutile, voire diminuer les performances sur des tâches simples.

.webp)