- Il chain-of-thought prompting guida i modelli AI a ragionare passo dopo passo, aiutandoli a risolvere compiti complessi con maggiore precisione rispetto alla semplice previsione della parola successiva.

- È ideale per problemi a più passaggi, come matematica, rompicapi logici o compiti procedurali, ma non serve per domande semplici o a risposta singola.

- Il prompt chaining si differenzia dal chain-of-thought perché suddivide un compito in più prompt separati, mentre il chain-of-thought resta in un unico flusso domanda-risposta.

Se hai usato un chatbot GPT come ChatGPT, avrai probabilmente notato la qualità variabile delle risposte.

A volte restituisce esattamente ciò che ti serve. Altre volte sospetti che l’‘intelligenza’ dell’IA sia un po’ una farsa.

Puoi migliorare le tue interazioni con ChatGPT ottimizzando i tuoi prompt. Il chain-of-thought prompting incoraggia gli agenti LLM a ragionare sul compito passo dopo passo prima di generare una risposta.

I modelli di IA più recenti e le nuove funzionalità stanno iniziando a integrare direttamente il ragionamento a catena, così che i modelli ragionino automaticamente sul problema senza bisogno di ulteriori prompt.

Che cos'è il prompting "chain-of-thought"?

Il chain-of-thought prompting è una tecnica di prompt engineering in AI che istruisce i modelli a suddividere compiti complessi, ragionando su ogni passaggio prima di rispondere.

Potresti anche sentire parlare di ‘chain-of-thought reasoning’. Si riferisce al processo passo-passo che il modello segue per ragionare sul compito da svolgere.

I modelli OpenAI o1 non richiedono il prompting chain-of-thought, perché hanno già il ragionamento chain-of-thought integrato. Tuttavia, puoi usare il prompting chain-of-thought su qualsiasi chatbot alimentato da LLM.

Come funziona il ragionamento chain-of-thought?

Il ragionamento a catena consiste nel suddividere un problema in passaggi logici più piccoli che il chatbot AI risolve in sequenza.

Prima l’IA identifica le parti chiave del problema. Poi elabora ogni parte in sequenza, considerando come ogni passaggio porta al successivo. Ogni passaggio si basa sul precedente, permettendo all’IA di arrivare metodicamente a una conclusione logica.

Esempi di prompting chain-of-thought

Il famoso prompt della ‘fragola’

ChatGPT e altri LLM hanno debolezze ben documentate. Una è l’incapacità di identificare correttamente quante 'R' ci sono nella parola ‘strawberry’. (Probabilmente la famosa limitazione dietro il nome in codice dei modelli o1: Strawberry.)

ChatGPT-4o non utilizza il ragionamento a catena. Invece, fa riferimento ai suoi dati di addestramento e genera una risposta in base alla probabilità che ogni parola segua la precedente. Anche se spesso può sembrare corretto, sta solo cercando di imitare il linguaggio umano – non sta ragionando né facendo ricerche.

Quando chiedi a ChatGPT-4o la famosa domanda sulla fragola, non riesce a dare la risposta corretta:

Tuttavia, puoi utilizzare una tecnica di chain-of-thought prompting per aiutare il chatbot basato su LLM ad arrivare alla risposta corretta:

L’ultima versione di ChatGPT, alimentata da OpenAI o1-preview, è il primo grande LLM a utilizzare il ragionamento chain-of-thought senza prompt aggiuntivi.

Trova la risposta al primo tentativo, perché è stato istruito a seguire automaticamente lo stesso processo del secondo prompt ChatGPT-4o sopra. L’unica differenza è che esegue questo processo senza ulteriori istruzioni.

Matematica

Se chiedevi a una vecchia versione di ChatGPT una domanda di matematica da un libro delle elementari, non sempre dava la risposta giusta.

I problemi matematici a più passaggi richiedono ragionamento, cosa che mancava nei primi LLM. Si poteva scomporre ogni passaggio, ma se non si conoscevano i passaggi corretti, un LLM non poteva aiutare.

ChatGPT-4o è in grado di ragionare sulla risposta alla domanda scomponendo la sequenza di passaggi del problema:

Agenti AI collegati a Hubspot

Per un’applicazione reale, prendiamo un agente AI alimentato da LLM integrato in Hubspot. Un team di vendita usa questo agente AI per gestire i nuovi lead raccolti su vari canali.

Scenario

Un commerciale invia un nuovo lead all’agente AI e gli chiede di registrarlo in Hubspot e inviare una prima email di contatto, ma di non inserirlo se il lead lavora in un’azienda già presente tra i potenziali clienti.

LLM senza ragionamento chain-of-thought

L’agente AI basato su LLM registra il lead e invia l’email senza verificare se l’azienda è già un potenziale cliente, saltando una condizione fondamentale.

LLM con ragionamento "chain-of-thought"

L'agente AI basato su LLM verifica se l'azienda è già un potenziale cliente prima di agire. Se lo è, salta la registrazione e l'invio dell'email; in caso contrario, registra il lead e invia l'email, seguendo accuratamente le istruzioni del commerciale.

Quando dovrei usare il chain of thought prompting?

Il prompting chain-of-thought è ideale in scenari che richiedono ragionamenti passo dopo passo.

Le attività ideali sono quelle che richiedono deduzioni logiche, problemi matematici, compiti procedurali o situazioni che necessitano risposte in più passaggi.

Ma aspetta: il ragionamento sembra ottimo – perché non usarlo sempre?

Ottima domanda. Non tutte le domande richiedono ragionamento. Ad esempio:

- Domande semplici di fatto, come ‘Qual è la capitale del Canada?’

- Problemi a singolo passaggio, come ‘Quanto fa 145 + 37?’

- Attività di generazione di contenuti, come ‘Scrivi un’email cortese di 3 frasi per chiedere a un collega se ha finito il progetto’.

Prompting changing vs chain-of-thought prompting

Anche se simili nel nome, prompt chaining e chain-of-thought prompting sono strategie di prompting diverse per migliorare i risultati dell’AI generativa.

Prompting chain-of-thought

Con il prompting chain-of-thought, l’utente guida l’AI a spiegare il ragionamento dietro la sua risposta in un’unica risposta. Questo spinge l’AI a illustrare ogni passaggio del processo di risoluzione, ma tutto avviene in un solo prompt e risposta.

Ad esempio, un prompt chain-of-thought può essere gestito in un solo messaggio:

"Un team HR deve valutare le performance di 5 dipendenti. Ogni valutazione richiede 30 minuti e servono 15 minuti di preparazione. Le valutazioni dei senior richiedono 10 minuti extra ciascuna. Quanto tempo serve per completare 5 valutazioni senior e 25 junior? Spiega il ragionamento passo dopo passo."

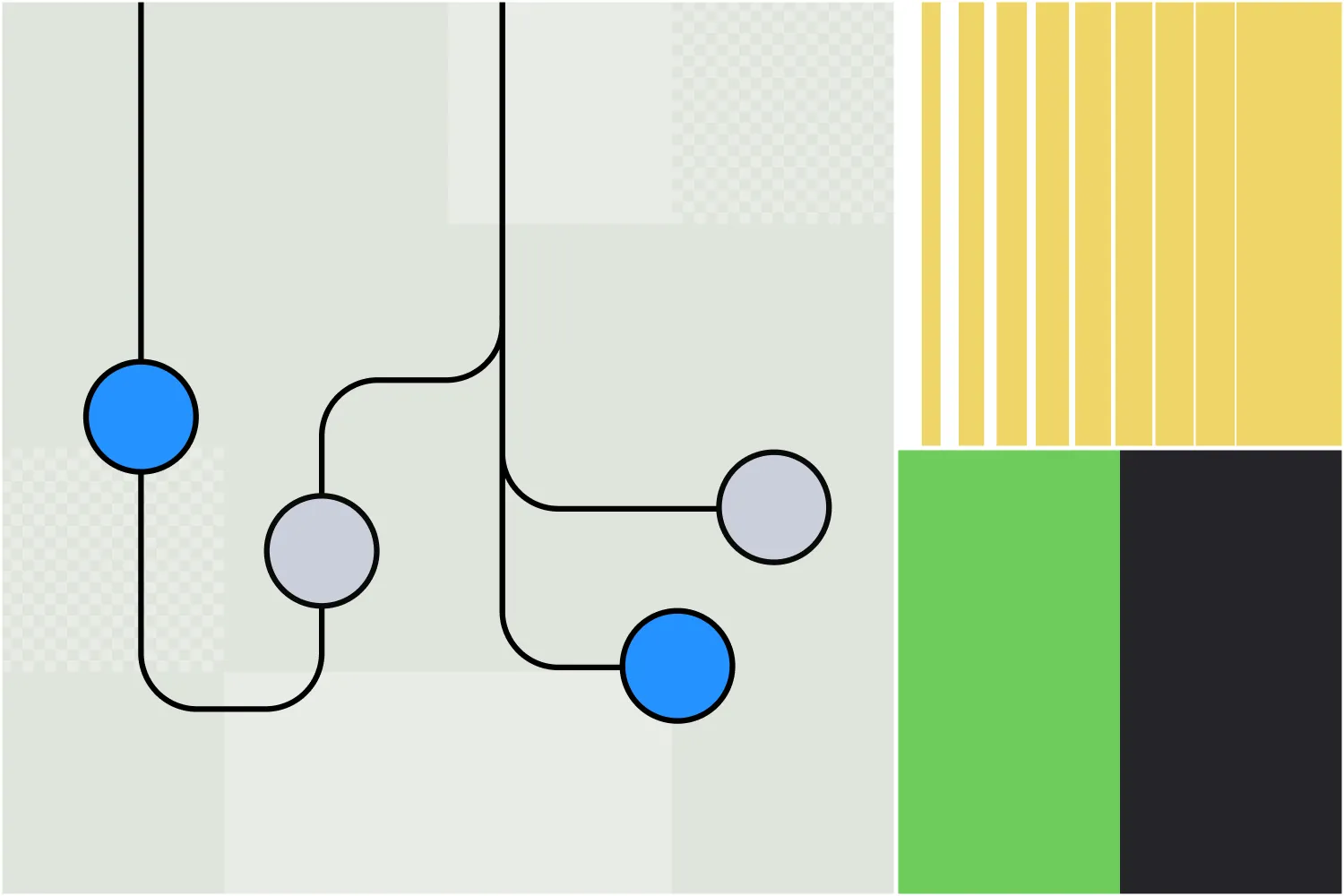

Collegamento di prompt

Con la prompt chaining, il compito viene suddiviso in più passaggi, ciascuno con un prompt che si basa sul risultato precedente. Questo aiuta a strutturare e guidare l'IA attraverso attività complesse che richiedono ragionamento.

Il primo prompt potrebbe essere:

Prompt 1: Identifica le principali sfide che un’azienda potrebbe incontrare nel passaggio al lavoro da remoto.

Output:

- Lacune nella comunicazione

- Mantenere la produttività

- Infrastruttura tecnologica

- Coinvolgimento dei dipendenti

Le prossime richieste potrebbero approfondire questi concetti. Ad esempio:

Prompt 2: Spiega come un’azienda può trovare soluzioni alle lacune comunicative durante la transizione al lavoro da remoto.

Dopo il prossimo output, il prossimo passaggio della catena potrebbe essere:

Prompt 3: Quali sono le sfide comuni che le aziende affrontano adottando queste soluzioni?

Quindi, anche se sono simili, adottano approcci diversi per estrarre i contenuti più approfonditi e rilevanti dagli strumenti di AI generativa.

Chain-of-thought prompting su Botpress

Gli utenti di Botpress conoscono già una funzione che utilizza il ragionamento a catena di pensieri.

L’Autonomous Node è stato lanciato a luglio 2024 su Botpress, una piattaforma per la creazione di agenti AI. L’Autonomous Node è in grado di automatizzare flussi di lavoro multi-step e prendere decisioni in autonomia.

Un Nodo Autonomo può essere creato e istruito con una semplice riga di testo, ad esempio: ‘Il tuo scopo è generare lead qualificati. Crea lead in Salesforce quando un utente manifesta intenzione di acquisto.’

L’agente IA che costruisci con questo Nodo Autonomo compirà una varietà di azioni per raggiungere il suo obiettivo, in modo indipendente dai flussi progettati dagli umani. Può anche passare tra diversi LLM secondo necessità, scegliendo se dare priorità a velocità o potenza.

Crea un agente autonomo personalizzato

Botpress è l’unica piattaforma di agenti AI che ti permette di creare agenti veramente autonomi.

Il Botpress Studio, aperto e flessibile, permette infiniti casi d’uso in tutti i settori, dalle risorse umane alla generazione di lead. La nostra libreria di integrazioni predefinite e i numerosi tutorial consentono agli utenti di creare facilmente agenti AI da zero.

Inizia a costruire oggi. È gratis.

Oppure contatta il nostro team commerciale.

Domande frequenti

1. Il chain-of-thought prompting è utile solo per i modelli IA o riflette anche il modo in cui risolvono i problemi gli esseri umani?

Il prompting chain-of-thought è utile sia per i modelli AI che per il ragionamento umano, perché imita il modo in cui le persone affrontano problemi complessi ragionando passo dopo passo.

2. In cosa si differenzia il ragionamento chain-of-thought dal semplice “pensare passo dopo passo”?

Anche se “pensare passo dopo passo” è un approccio generale, il ragionamento chain-of-thought è più strutturato e deliberato, e incoraggia il modello AI a esplicitare i passaggi intermedi invece di saltare subito alle conclusioni.

3. Perché alcuni LLM non utilizzano il ragionamento chain-of-thought di default?

Alcuni LLM, soprattutto i modelli più vecchi o piccoli, non usano il ragionamento chain-of-thought di default perché non sono stati ottimizzati per produrre output multi-step e si concentrano invece sul prevedere risposte probabili in base ai pattern dei dati di addestramento.

4. Il prompting chain-of-thought è una forma di “addestramento” del modello durante l’inferenza?

No, il prompting chain-of-thought non è una forma di training; non modifica i pesi o le conoscenze del modello. Piuttosto, guida il comportamento in output durante l’inferenza, incoraggiando un ragionamento strutturato tramite il prompt.

5. Il chain-of-thought prompting migliora sempre la precisione?

Il prompting chain-of-thought non migliora sempre l’accuratezza. Tende ad aiutare nei compiti che richiedono ragionamento a più passaggi, ma su compiti semplici può aggiungere complessità inutile e persino ridurre le prestazioni.

.webp)