- Chain-of-thought prompting prowadzi modele AI przez rozumowanie krok po kroku, co pozwala im rozwiązywać złożone zadania dokładniej niż przy zwykłym przewidywaniu kolejnych słów.

- Najlepiej sprawdza się przy zadaniach wieloetapowych, takich jak matematyka, zagadki logiczne czy procedury, ale jest zbędny przy prostych pytaniach faktograficznych lub jednowarstwowych.

- Prompt chaining różni się od chain-of-thought tym, że dzieli zadanie na kilka osobnych promptów, podczas gdy chain-of-thought pozostaje w jednym ciągu prompt-odpowiedź.

Jeśli korzystałeś z chatbota GPT takiego jak ChatGPT, pewnie zauważyłeś, że jakość odpowiedzi bywa różna.

Czasem AI daje dokładnie to, czego potrzebujesz. Innym razem masz wrażenie, że ta „inteligencja” to trochę fikcja.

Możesz poprawić swoje wyniki z ChatGPT, ulepszając sposób zadawania pytań. Technika chain-of-thought zachęca agentów LLM do rozwiązywania zadania krok po kroku przed wygenerowaniem odpowiedzi.

Nowsze modele AI i funkcje zaczynają wbudowywać chain-of-thought reasoning bezpośrednio, dzięki czemu modele automatycznie analizują problem krok po kroku bez dodatkowych poleceń.

Czym jest podpowiadanie metodą łańcucha myśli?

Chain-of-thought prompting to technika inżynierii promptów w AI, która polega na instruowaniu modeli, by rozkładały złożone zadania na etapy i analizowały każdy krok przed udzieleniem odpowiedzi.

Możesz też usłyszeć określenie 'chain-of-thought reasoning'. Odnosi się ono do procesu, w którym model krok po kroku analizuje zadanie do wykonania.

Modele OpenAI o1 nie wymagają podpowiedzi łańcuchowych, bo mają już wbudowane rozumowanie łańcuchowe. Ale możesz stosować podpowiedzi łańcuchowe w każdym chatbotcie opartym na LLM.

Jak działa chain-of-thought reasoning?

Rozumowanie chain-of-thought polega na rozbiciu problemu na mniejsze, logiczne kroki, które chatbot AI rozwiązuje po kolei.

Najpierw AI identyfikuje kluczowe elementy problemu. Następnie przetwarza je po kolei, analizując, jak jeden krok prowadzi do kolejnego. Każdy etap opiera się na poprzednim, co pozwala AI konsekwentnie dążyć do logicznego rozwiązania.

Przykłady promptowania z rozumowaniem krok po kroku

Słynny prompt „truskawka”

ChatGPT i inne LLM mają dobrze udokumentowane słabości. Jedną z nich jest nieumiejętność poprawnego policzenia, ile liter „R” jest w słowie „strawberry”. (To prawdopodobnie słynne ograniczenie, od którego pochodzi nazwa kodowa modeli o1: Strawberry.)

ChatGPT-4o nie stosuje rozumowania łańcuchowego. Zamiast tego korzysta z danych treningowych i generuje odpowiedź na podstawie prawdopodobieństwa kolejnych słów. Choć często brzmi poprawnie, jego celem jest naśladowanie ludzkiego języka – nie rozumowanie czy prowadzenie badań.

Gdy zapytasz ChatGPT-4o o słynne pytanie o truskawkę, nie potrafi udzielić poprawnej odpowiedzi:

Możesz jednak zastosować technikę podpowiadania łańcucha myśli, aby pomóc chatbotowi opartemu na LLM dojść do poprawnej odpowiedzi:

Najnowsza wersja ChatGPT, oparta na OpenAI o1-preview, to pierwszy duży LLM wykorzystujący chain-of-thought reasoning bez dodatkowych poleceń.

Uzyskuje poprawną odpowiedź za pierwszym razem, ponieważ został zaprogramowany, by automatycznie stosować ten sam proces co w drugim poleceniu ChatGPT-4o powyżej. Jedyna różnica polega na tym, że wykonuje ten proces bez dodatkowych instrukcji.

Matematyka

Jeśli zapytałeś starszą wersję ChatGPT o zadanie matematyczne z podręcznika szkoły podstawowej, nie zawsze udzielała poprawnej odpowiedzi.

Wielostopniowe zadania matematyczne wymagają rozumowania, którego wcześniejsze modele LLM nie posiadały. Można było rozbić problem na kroki, ale jeśli nie znałeś właściwych etapów, LLM nie był w stanie pomóc.

ChatGPT-4o potrafi rozwiązać to pytanie, rozbijając problem na kolejne kroki:

Agenci AI połączeni z Hubspot

Dla przykładu z życia weźmy agenta AI opartego na LLM, zintegrowanego z Hubspotem. Zespół sprzedaży korzysta z tego agenta AI do obsługi nowych leadów zbieranych z różnych kanałów.

Scenariusz

Handlowiec przekazuje nowego leada agentowi AI i prosi o zarejestrowanie go w Hubspot oraz wysłanie pierwszego maila, ale prosi, aby nie rejestrować go, jeśli lead pracuje w firmie, która już jest potencjalnym klientem.

LLM bez rozumowania krok po kroku

Agent AI oparty na LLM rejestruje lead i wysyła e-mail, nie sprawdzając, czy firma jest już potencjalnym klientem – pomija kluczowy warunek.

LLM z rozumowaniem łańcuchowym

Agent AI oparty na LLM sprawdza, czy firma jest już potencjalnym klientem. Jeśli tak, pomija rejestrację i wysyłkę maila; jeśli nie, rejestruje lead i wysyła mail zgodnie z instrukcjami handlowca.

Kiedy warto stosować promptowanie z rozumowaniem krok po kroku?

Podpowiedzi typu chain-of-thought najlepiej sprawdzają się w sytuacjach wymagających rozumowania krok po kroku.

Idealne zadania to te wymagające logicznego wnioskowania, rozwiązywania problemów matematycznych, zadań proceduralnych lub sytuacji wymagających wieloetapowych odpowiedzi.

Ale zaraz: rozumowanie brzmi świetnie – dlaczego nie używać go zawsze?

Dobre pytanie. Nie wszystkie pytania wymagają rozumowania. Na przykład:

- Proste pytania faktograficzne, np. „Jaka jest stolica Kanady?”

- Jednoetapowe zadania, np. „Ile to 145 + 37?”

- Zadania związane z generowaniem treści, np. „Napisz uprzejmy, 3-zdaniowy e-mail z pytaniem do kolegi, czy skończył już swój projekt.”

Zmiana promptowania vs promptowanie łańcuchowe

Mimo podobnych nazw, prompt chaining i chain-of-thought prompting to różne strategie promptowania, które mają poprawić wyniki generatywnej AI.

Chain-of-thought prompting

Dzięki chain-of-thought prompting użytkownik prosi AI o wyjaśnienie toku rozumowania w jednej odpowiedzi. AI przechodzi wtedy przez każdy etap rozwiązywania problemu, ale wszystko odbywa się w ramach jednego zapytania i odpowiedzi.

Na przykład, chain-of-thought prompt można zrealizować w jednej wiadomości:

"Zespół HR musi przeanalizować 5 ocen pracowniczych. Każda zajmie 30 minut, a przed rozpoczęciem potrzebują 15 minut na przygotowanie. Oceny starszych pracowników wymagają dodatkowych 10 minut każda. Ile czasu zajmie przeprowadzenie 5 ocen starszych i 25 ocen młodszych pracowników? Rozpisz rozumowanie krok po kroku."

Łączenie promptów

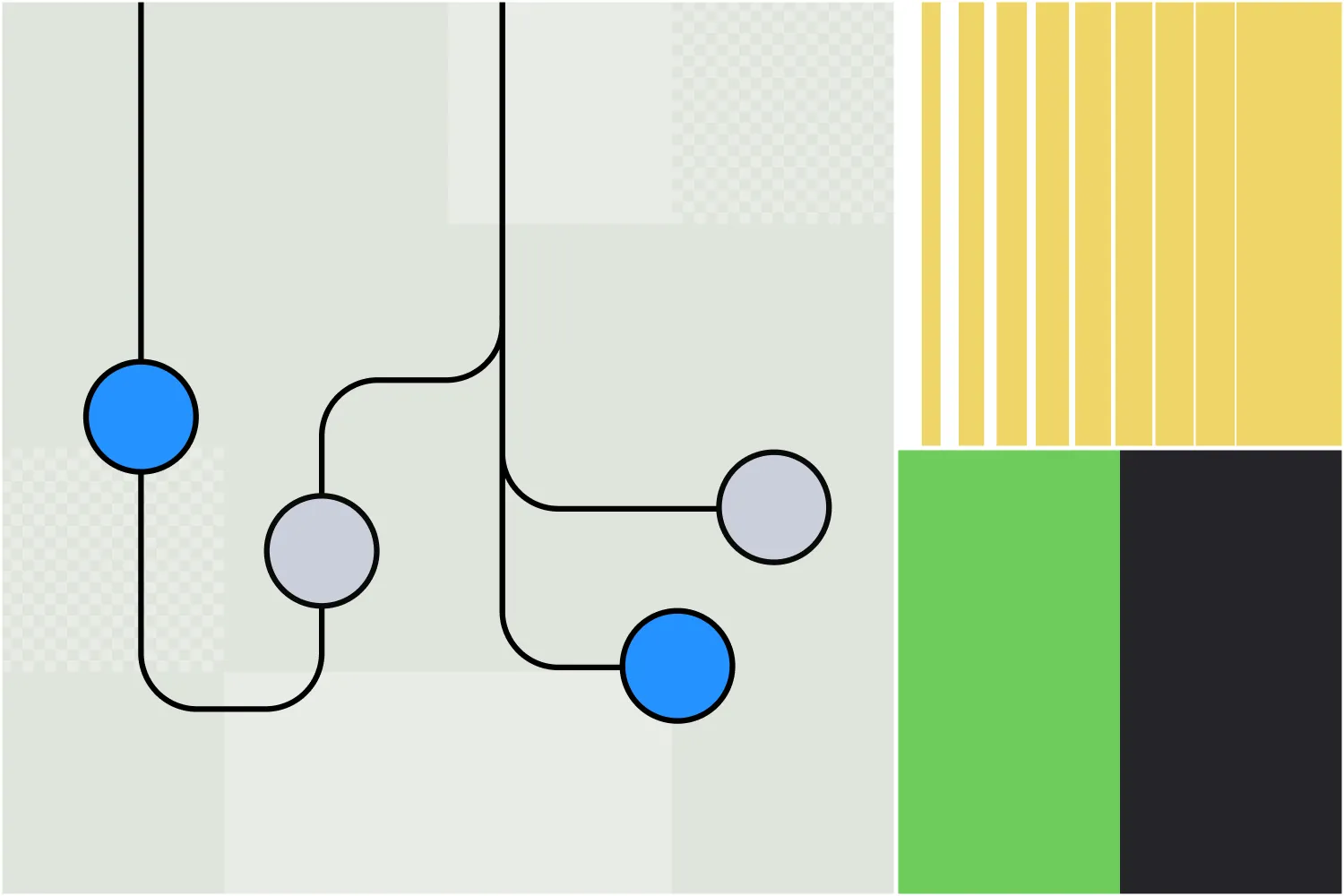

W łańcuchowaniu promptów zadanie jest rozbijane na osobne etapy z wieloma poleceniami, z których każde bazuje na poprzednim wyniku. To pomaga uporządkować i poprowadzić AI przez złożone zadanie, które często wymaga rozumowania.

Pierwszy prompt może wyglądać tak:

Prompt 1: Wskaż główne wyzwania, z jakimi może się zmierzyć firma podczas przechodzenia na pracę zdalną.

Wynik:

- Luki w komunikacji

- Utrzymanie produktywności

- Infrastruktura technologiczna

- Zaangażowanie pracowników

Kolejne polecenia mogą zagłębiać się w te zagadnienia. Na przykład:

Polecenie 2: Proszę opisz, jak firma może znaleźć rozwiązania problemów komunikacyjnych podczas przechodzenia na pracę zdalną.

Po kolejnej serii wyników następny etap łańcucha może być taki:

Polecenie 3: Jakie są najczęstsze wyzwania, z którymi mierzą się firmy wdrażające te rozwiązania?

Choć obie techniki są podobne, różnią się podejściem do uzyskiwania pogłębionych i trafnych treści z narzędzi generatywnej AI.

Chain-of-thought prompting w Botpress

Użytkownicy Botpress znają już funkcję wykorzystującą rozumowanie łańcuchowe.

Autonomous Node zadebiutował w lipcu 2024 roku na platformie Botpress, służącej do budowania agentów AI. Autonomous Node potrafi automatyzować wieloetapowe procesy i podejmować decyzje samodzielnie.

Autonomiczny Węzeł można utworzyć i skonfigurować za pomocą prostego polecenia, na przykład: „Twoim celem jest generowanie wykwalifikowanych leadów. Twórz leady w Salesforce, gdy użytkownik wykaże chęć zakupu.”

Agent AI zbudowany przy użyciu tego autonomicznego węzła będzie podejmował różne działania, by osiągnąć swój cel, niezależnie od zaprojektowanych przez ludzi przepływów. Może też przełączać się między różnymi LLM w zależności od potrzeb, decydując, czy ważniejsza jest szybkość, czy moc obliczeniowa.

Zbuduj własnego autonomicznego agenta

Botpress to jedyna platforma agentów AI, która pozwala tworzyć naprawdę autonomicznych agentów.

Otwarty i elastyczny Botpress Studio umożliwia realizację dowolnych scenariuszy w różnych branżach – od HR po generowanie leadów. Nasza biblioteka gotowych integracji i obszerne samouczki pozwalają użytkownikom łatwo budować agentów AI od podstaw.

Rozpocznij budowę już dziś. To nic nie kosztuje.

Lub skontaktuj się z naszym zespołem sprzedaży.

Najczęstsze pytania

1. Czy chain-of-thought prompting jest przydatne tylko dla modeli AI, czy odzwierciedla także ludzkie rozwiązywanie problemów?

Podpowiedzi typu chain-of-thought są przydatne zarówno dla modeli AI, jak i odzwierciedlają ludzkie rozwiązywanie problemów, bo naśladują naturalny sposób radzenia sobie z trudnymi zadaniami – krok po kroku.

2. Czym różni się chain-of-thought reasoning od zwykłego „myślenia krok po kroku”?

Choć "myślenie krok po kroku" to ogólne podejście, chain-of-thought reasoning jest bardziej uporządkowane i celowe – zachęca model AI do wyraźnego przedstawiania pośrednich etapów rozumowania zamiast przechodzenia od razu do wniosków.

3. Dlaczego niektóre LLM-y domyślnie nie korzystają z rozumowania łańcucha myśli?

Niektóre LLM-y, zwłaszcza starsze lub mniejsze modele, domyślnie nie stosują chain-of-thought reasoning, ponieważ nie były dostrojone do generowania wieloetapowych odpowiedzi i skupiają się na przewidywaniu najbardziej prawdopodobnych odpowiedzi na podstawie wzorców z danych treningowych.

4. Czy promptowanie łańcuchowe jest formą „trenowania” modelu podczas wnioskowania?

Nie, chain-of-thought prompting nie jest formą treningu; nie zmienia wag ani wiedzy modelu. Zamiast tego wpływa na zachowanie modelu podczas generowania odpowiedzi, zachęcając do uporządkowanego rozumowania poprzez odpowiednią treść promptu.

5. Czy promptowanie chain-of-thought zawsze poprawia dokładność?

Chain-of-thought prompting nie zawsze poprawia dokładność. Pomaga przy zadaniach wymagających wieloetapowego rozumowania, ale przy prostych może wprowadzać zbędną złożoność, a nawet pogorszyć wyniki.

.webp)