- 連鎖思考提示讓 AI 模型一步步推理,比單純預測下一個字更能精確解決複雜任務。

- 最適合用於多步驟問題,例如數學、邏輯謎題或程序性任務,但對於單一事實或簡單查詢則不需要。

- Prompt chaining(提示鏈接)與 chain-of-thought(思路鏈)不同,前者把任務拆成多個獨立提示,後者則在同一個提示-回應流程內進行。

如果你用過GPT 聊天機器人(像 ChatGPT),應該會發現回應品質參差不齊。

有時它給出的答案正是你要的。有時你會懷疑 AI 的「智慧」其實有點唬人。

你可以透過優化提示,讓你的ChatGPT更上一層樓。鏈式思考提示鼓勵LLM 代理逐步推理任務,再產生回應。

較新的 AI 模型和功能已開始直接內建chain-of-thought 推理,讓模型自動推理問題,不需額外提示。

什麼是思維鏈提示?

chain-of-thought 提示是一種 AI 提示工程技巧,指示模型將複雜任務拆解,逐步推理後再回應。

你可能也聽過「chain-of-thought 推理」這個詞。它指的是模型推理任務時,會一步步思考的過程。

OpenAI o1 模型不需要 chain-of-thought 提示,因為它們已內建 chain-of-thought 推理。但你仍可在任何 LLM 驅動的聊天機器人上使用 chain-of-thought 提示。

chain-of-thought 推理是如何運作的?

鏈式思考推理是將問題拆解成更小、合邏輯的步驟,讓AI 聊天機器人依序解決。

首先,AI 會辨識問題的關鍵部分。接著依序處理每個部分,思考每一步如何推進到下一步。每個步驟都建立在前一步之上,讓 AI 能有條理地推導出合理結論。

chain-of-thought 提示範例

知名的「草莓」提示

ChatGPT 和其他大型語言模型有一些眾所皆知的弱點。其中之一就是無法正確判斷「strawberry」這個單字裡有幾個 R。(這大概也是 o1 模型代號 Strawberry 的由來。)

ChatGPT-4o 並不使用 chain-of-thought 推理。它是參考訓練資料,根據每個詞出現的機率來產生回應。雖然大多數時候聽起來很正確,但它只是模仿人類語言——並不是在推理或做研究。

當你問 ChatGPT-4o 著名的草莓問題時,它沒辦法給出正確答案:

不過,你可以使用「思維鏈提示」技巧,協助由 LLM 驅動的聊天機器人得出正確答案:

最新一代的 ChatGPT,由 OpenAI o1-preview 驅動,是首個能在無需額外提示下使用 chain-of-thought 推理的大型語言模型。

它第一次就能答對,因為已被指示自動採用上面 ChatGPT-4o 第二個提示的解題流程。唯一不同的是,它不需要額外提示就能這樣做。

數學

如果你問舊版 ChatGPT 一道國小數學題,它不一定能答對。

多步驟數學題需要推理,這是早期 LLM 不具備的。你可以拆解每個步驟,但如果你不知道正確步驟,LLM 也幫不上忙。

ChatGPT-4o 能透過拆解問題步驟,推理出這個問題的答案:

連接到 Hubspot 的 AI 智能代理

舉個實際例子,假設有一個 LLM 驅動的AI agent已整合進 Hubspot。銷售團隊會用這個 AI agent 處理來自各渠道的新潛在客戶。

情境

業務員將新潛在客戶交給 AI 助理,請它在 Hubspot 建立資料並寄出第一封聯絡信,但如果該客戶公司已經是潛在客戶,就不要重複建立。

沒有 chain-of-thought 推理的 LLM

這個由 LLM 驅動的 AI 智能代理在註冊潛在客戶並發送電子郵件時,沒有檢查該公司是否已經是潛在客戶,錯過了關鍵條件。

具備 chain-of-thought 推理的 LLM

由 LLM 驅動的 AI 代理人會先檢查該公司是否已是潛在客戶。如果是,就跳過註冊和寄信;如果不是,則會註冊潛在客戶並發送郵件,精確依照業務人員的指示執行。

什麼時候該用 chain of thought 提示?

鏈式思考提示最適合需要逐步推理的情境。

最適合的任務包括邏輯推理、數學問題、程序性任務,或任何需要多步驟解答的情境。

但等等:推理聽起來很棒——為什麼不每次都用?

好問題。並非所有問題都需要推理。例如:

- 簡單的事實性問題,例如「加拿大的首都是哪裡?」

- 單步驟問題,例如「145 + 37 等於多少?」

- 內容產生任務,例如「寫一封有禮貌的三句話電子郵件,詢問同事專案是否完成」。

提示詞變化與連鎖思考提示

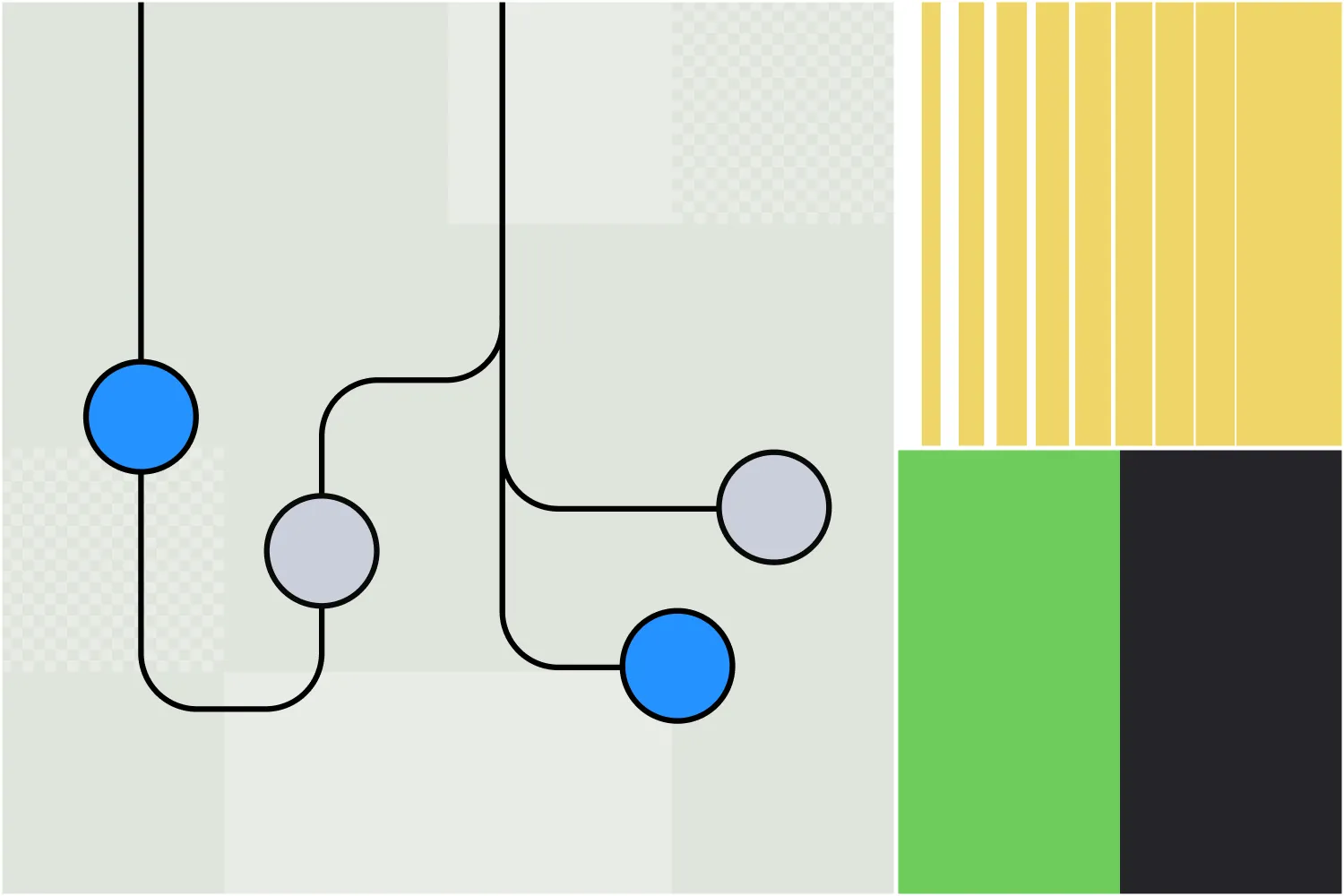

雖然名稱相似,prompt chaining 和 chain-of-thought 提示法其實是不同的提示策略,用來提升生成式 AI 的輸出效果。

Chain-of-thought 提示法

透過連鎖思考提示,使用者能引導 AI 在單一回應中說明其推理過程。這會促使 AI 逐步走過解題流程,但只需一次提示與回應即可完成。

舉例來說,思路鏈結提示可以在一則訊息中完成:

「人資團隊需要審查 5 份員工績效評估。每份需 30 分鐘,事前準備需 15 分鐘。資深員工評估每份需額外 10 分鐘。請問完成 5 份資深與 25 份一般評估總共需要多久?請逐步說明你的推理。」

提示串接

提示鏈結則是將任務拆解為多個步驟,每個提示都建立在前一個結果之上。這有助於結構化並引導 AI 處理需要推理的複雜任務。

第一個提示可能是:

提示 1:找出公司轉型遠距工作時可能遇到的主要挑戰。

回應:

- 溝通落差

- 維持生產力

- 技術基礎建設

- 員工參與度

接下來的提示可以針對這些概念深入探討。例如:

提示 2:請說明公司在轉型遠距工作時,如何解決溝通落差的問題。

下一輪回應後,鏈結的下一步可能是:

提示 3:企業在導入這些解決方案時常見的挑戰有哪些?

因此,雖然兩者相似,但它們在引導生成式 AI 產生深入且相關內容時,採用的是不同的方法。

在 Botpress 上使用 Chain-of-thought 提示

Botpress 用戶已經熟悉一項運用連鎖思考推理的功能。

Autonomous Node 於 2024年7月在 Botpress 平台首次亮相。這個 Autonomous Node 能自動化多步驟流程,並自主做出決策。

你可以用一句簡單的文字就建立並啟動一個 Autonomous Node,例如:「你的目的是產生合格潛在客戶。當使用者表達購買意願時,請在 Salesforce 建立潛在客戶。」

你用這個 Autonomous Node 建立的 AI 智能代理,會自主採取各種行動來達成目標,不受限於人類設計的流程。它還能根據需求在不同 LLM 間切換,靈活選擇速度或效能優先。

建立自訂自主代理

Botpress 是唯一能讓你打造真正自主智能代理的 AI 平台。

開放且彈性的 Botpress Studio,適用於各行各業的無限應用情境,從人資到潛在客戶開發皆可。預建的整合庫與豐富教學,讓使用者能輕鬆從零開始打造 AI 智能代理。

立即開始打造,完全免費。

常見問題

1. chain-of-thought 提示只對 AI 模型有用,還是也反映人類的解題方式?

Chain-of-thought 提示對 AI 模型很有幫助,也反映了人類解決問題的方式,因為它模仿人們逐步推理、拆解複雜問題的自然過程。

2. 連鎖思考推理和單純「逐步思考」有什麼不同?

雖然「逐步思考」是一種通用方法,但 chain-of-thought 推理更有結構且有意識,鼓勵 AI 模型明確說出中間推理步驟,而不是直接給結論。

3. 為什麼有些 LLM 預設不使用思維鏈推理?

有些大型語言模型,特別是早期或規模較小的版本,預設不會使用 chain-of-thought 推理,因為它們沒有針對多步驟輸出進行微調,而是傾向根據訓練資料模式預測最可能的答案。

4. chain-of-thought 提示算不算是在推論階段「訓練」模型?

不,chain-of-thought 提示不是一種訓練方式;它不會改變模型的權重或知識。它是在推論時,透過提示引導模型進行結構化推理,從而影響輸出行為。

5. 思路鏈提示法一定會提升準確率嗎?

Chain-of-thought 提示法不一定能提升準確率。它通常對需要多步推理的任務有幫助,但對簡單任務反而可能增加不必要的複雜度,甚至降低效能。

.webp)