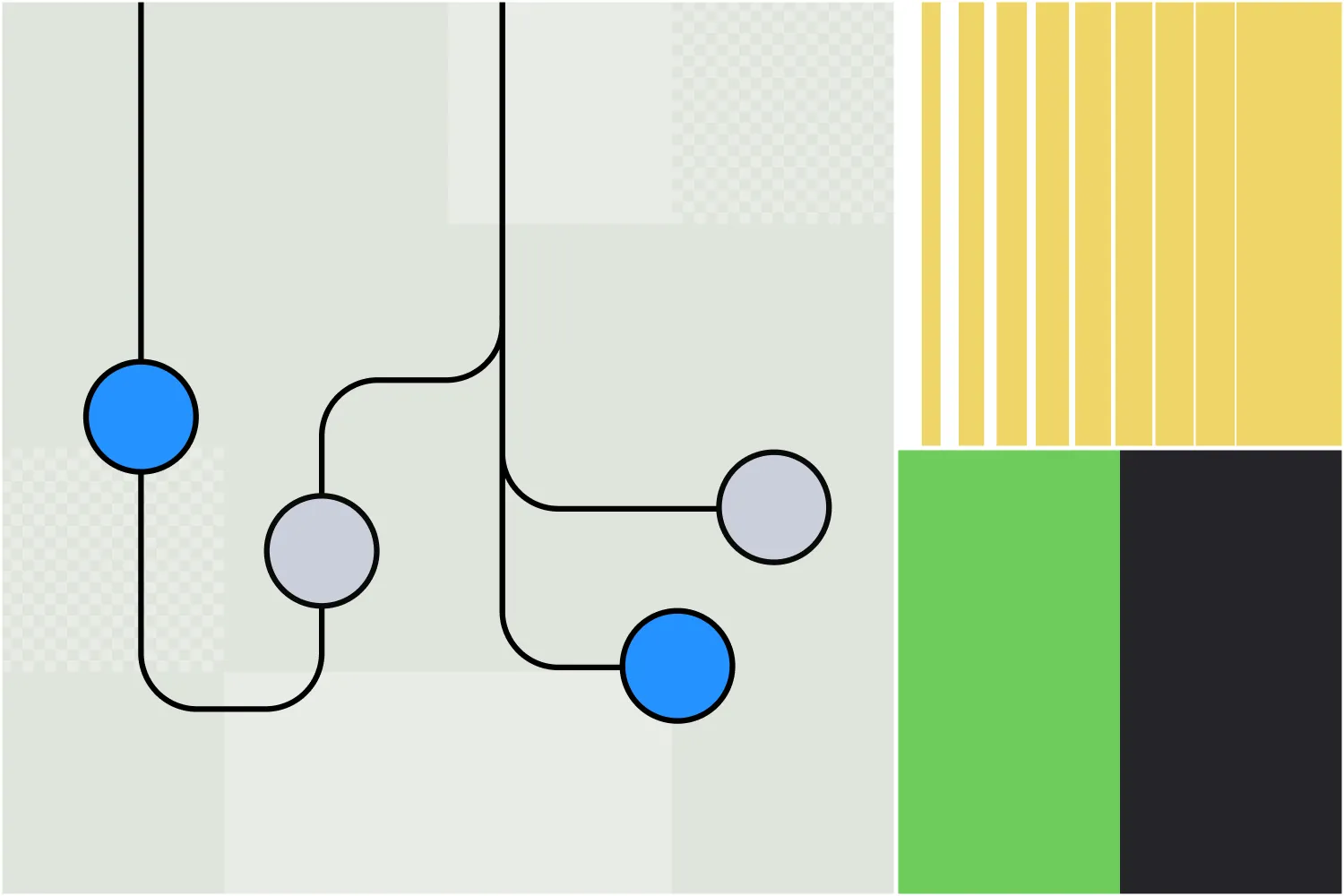

Węzeł Autonomiczny Botpress pozwala tworzyć funkcjonalnych agentów AI – nie chatboty, lecz autonomicznych agentów podejmujących decyzje na podstawie dostępnego kontekstu.

Dzięki jasnym instrukcjom i integracji narzędzi, twórcy botów mogą wykorzystać Węzły Autonomiczne do określenia zachowania chatbota.

Węzeł został zaprojektowany do obsługi zarówno podejmowania decyzji, jak i ich realizacji – rozumie dane wejściowe użytkownika, odpowiada odpowiednimi danymi i korzysta z dostępnych narzędzi.

Jeśli chcesz korzystać z Węzła Autonomicznego, jesteś we właściwym miejscu. W tym artykule przedstawię podstawy korzystania z tej kluczowej funkcji naszej platformy.

Najważniejsze cechy Węzła Autonomicznego

1. Decyzje oparte na LLM

Węzeł Autonomiczny wykorzystuje możliwości LLM do podejmowania inteligentnych decyzji za pośrednictwem agenta LLM.

2. Zachowanie autonomiczne

Węzeł Autonomiczny potrafi wykonywać działania bez ręcznej ingerencji, bazując na instrukcjach i danych od użytkownika.

3. Narzędzia

Węzeł Autonomiczny rozumie i wykorzystuje określone narzędzia – na przykład może przeszukiwać bazy wiedzy, wykonywać wyszukiwania w sieci czy przeprowadzać przejścia w ramach workflow.

4. Personalizacja

Konfigurując Węzeł Autonomiczny z odpowiednią osobowością i szczegółowymi instrukcjami, możesz mieć pewność, że będzie działał zgodnie z marką i w ramach ustalonego zakresu podczas rozmów.

5. Pisanie i wykonywanie kodu

Węzeł Autonomiczny potrafi generować i wykonywać własny kod, aby realizować zadania.

6. Samokorekta

Jeśli Węzeł Autonomiczny zauważy, że podąża w niewłaściwym kierunku, potrafi samodzielnie się poprawić i wyjść z błędu.

Ustawienia konfiguracyjne

Każdy Węzeł Autonomiczny wymaga starannej konfiguracji, by jego zachowanie odpowiadało potrzebom biznesowym.

Najważniejszym elementem konfiguracji Węzła Autonomicznego jest napisanie odpowiedniego promptu i instrukcji. Prompt pomaga agentowi zrozumieć swoją rolę i kieruje podejmowaniem decyzji.

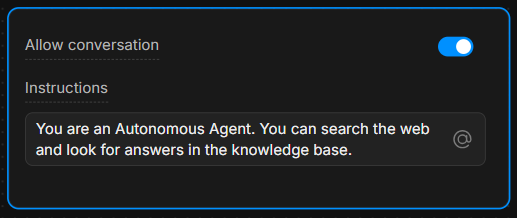

Okno instrukcji

W oknie instrukcji podaj jasne wytyczne. Im bardziej szczegółowe instrukcje, tym lepsze decyzje podejmuje agent.

Przykład: „Jesteś pomocnym asystentem, który zawsze odpowiada na pytania, korzystając z narzędzia ‘knowledgeAgent.knowledgequery’. Jeśli użytkownik wpisze ‘search’, użyj narzędzia ‘browser.webSearch’.”

Zezwól na rozmowę

Przełącznik Zezwól na rozmowę umożliwia Węzłowi Autonomicznemu bezpośrednią komunikację z użytkownikami. Po wyłączeniu, Węzeł przetwarza jedynie polecenia i wykonuje swoją logikę wewnętrzną, nie wysyłając wiadomości do użytkowników.

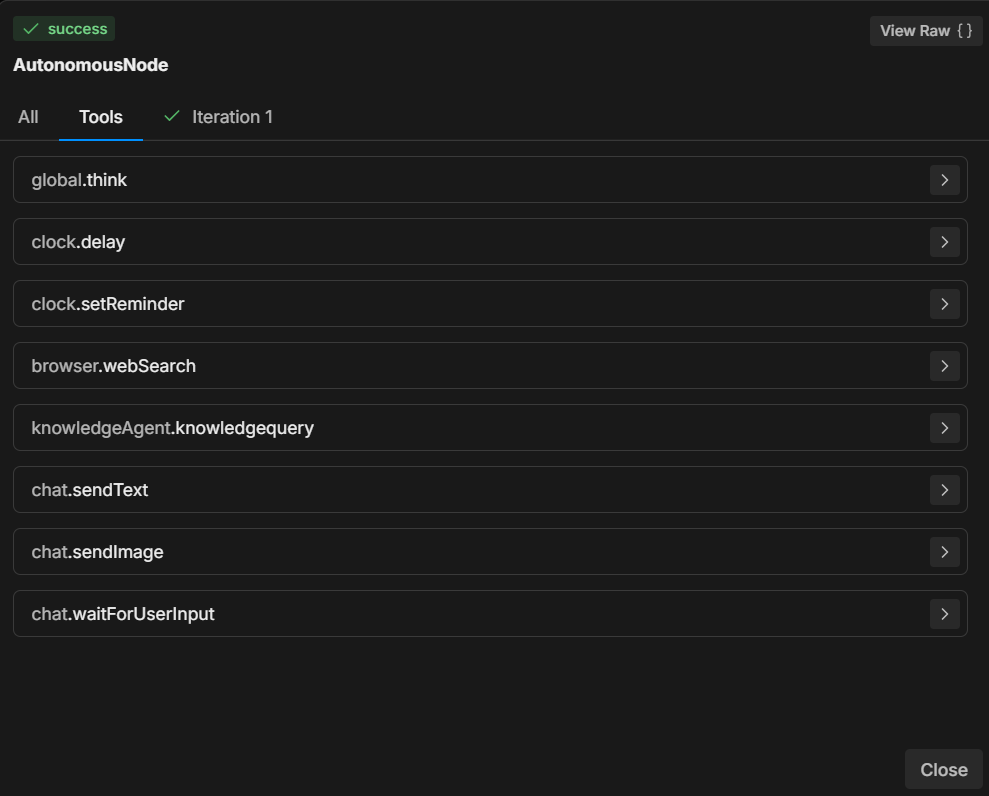

Zrozumienie narzędzi

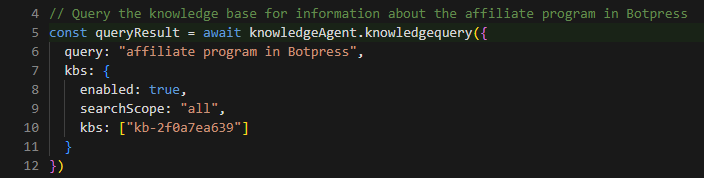

Na podstawie przekazanych instrukcji, Węzeł Autonomiczny wyposażony jest w kilka narzędzi, z których może korzystać.

Każde narzędzie realizuje określone zadanie – zrozumienie, kiedy i jak ich używać, jest kluczowe dla podejmowania decyzji przez Węzeł.

7 najczęściej używanych narzędzi

- global.think: Pozwala silnikowi LLMz zastanowić się przed podjęciem kolejnych działań.

- browser.webSearch: Umożliwia agentowi wyszukiwanie odpowiedzi w internecie.

- knowledgeAgent.knowledgequery: Przeszukuje wewnętrzną bazę wiedzy w poszukiwaniu odpowiednich informacji.

- clock.setReminder: Ustawia przypomnienie dla przyszłych zadań lub odpowiedzi.

- workflow.transition: Wykonuje przejście w workflow, przechodząc do innej części rozmowy na podstawie danych od użytkownika.

- chat.sendText: Wysyła wiadomość tekstową do użytkownika jako odpowiedź.

- chat.waitForUserInput: Zatrzymuje działanie i czeka na dalsze dane od użytkownika.

Określając, które narzędzie ma być użyte w odpowiedzi na działania użytkownika, możesz kontrolować przebieg i efekty rozmowy.

Na przykład możesz polecić LLM, by zawsze wykonywał określone działania, gdy spełnione są konkretne warunki: „Gdy użytkownik wpisze ‘1’, użyj narzędzia ‘workflow.transition’, by przejść do następnego kroku.”

Lub: „Jeśli użytkownik zada pytanie, najpierw spróbuj odpowiedzieć, korzystając z narzędzia ‘knowledgeAgent.knowledgequery’.”

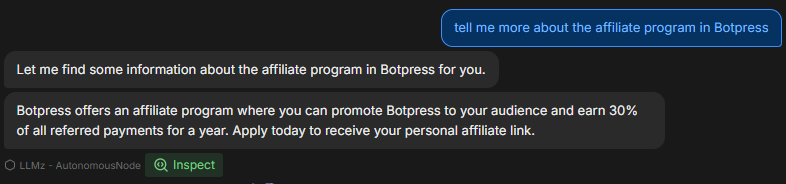

Przykładowy workflow

Oto przykład krok po kroku, jak Węzeł Autonomiczny może być skonfigurowany i działać podczas rozmowy:

1. Wprowadzenie użytkownika

Użytkownik wpisuje pytanie dotyczące produktu firmy.

2. Wykonanie instrukcji

Węzeł Autonomiczny stosuje prompt i korzysta z narzędzia knowledgeAgent.knowledgequery, by przeszukać wewnętrzną bazę wiedzy.

3. Decyzja LLM

Jeśli baza wiedzy nie zawiera satysfakcjonującej odpowiedzi, węzeł może użyć narzędzia browser.webSearch, by znaleźć dodatkowe informacje w internecie.

4. Wysłanie wiadomości

Gdy odpowiedź jest gotowa, węzeł używa chat.sendText, by przekazać użytkownikowi odpowiednie informacje.

5. Oczekiwanie na dane

Po udzieleniu odpowiedzi, węzeł korzysta z chat.waitForUserInput , by poczekać na kolejne pytania lub interakcję od użytkownika.

Jak pisać instrukcje

Jak pokazano w przykładzie, jasne instrukcje są kluczowe, by Węzeł Autonomiczny działał poprawnie.

Zdolność LLM do podejmowania decyzji jest w dużej mierze zależna od sposobu sformułowania instrukcji.

Oto 3 najlepsze praktyki pisania instrukcji dla Węzła Autonomicznego:

1. Bądź precyzyjny

Zamiast ogólnych poleceń, używaj jasnych sformułowań, które jednoznacznie kierują agenta.

Przykład: „Jeśli użytkownik wpisze ‘help’, wyślij mu zdefiniowaną listę opcji wsparcia za pomocą ‘chat.sendText’.”

2. Określ użycie narzędzi

Wyraźnie wskaż, które narzędzie ma być używane w jakich sytuacjach.

Przykład: „Zawsze używaj ‘knowledgeAgent.knowledgequery’ do odpowiadania na pytania dotyczące produktu.”

3. Kieruj przebiegiem rozmowy

Stosuj jasne przejścia i kroki, by rozmowa przebiegała we właściwym kierunku.

Przykład: „Jeśli baza wiedzy nie może odpowiedzieć, przejdź do zapytania w wyszukiwarce za pomocą ‘browser.webSearch’.”

Więcej informacji znajdziesz pod poniższymi linkami:

- Najlepsze praktyki tworzenia promptów z OpenAI API

- Budowanie systemów z ChatGPT API

- Inżynieria promptów ChatGPT dla deweloperów

Korzystanie ze składni Markdown

Zanim zaczniesz, warto omówić znaczenie korzystania ze składni Markdown.

Aby stworzyć przejrzysty, uporządkowany prompt, warto stosować składnię markdown, taką jak nagłówki, wypunktowania czy pogrubienia.

Taka składnia pomaga LLM rozpoznać i zachować hierarchię instrukcji, ułatwiając rozróżnienie głównych sekcji, podinstrukcji i przykładów.

Jeśli trudno Ci korzystać ze składni Markdown, użyj dowolnej struktury, która jest dla Ciebie wygodna – ważne, by była jasna i hierarchiczna.

Więcej o podstawowej składni Markdown

Przydatne prompty

Ta sekcja zawiera listę najczęściej spotykanych przykładów i wzorców, które możesz wykorzystać do kontrolowania zachowania Węzła Autonomicznego.

Przykłady te pochodzą z praktyki i pokazują, jak radzić sobie z różnymi scenariuszami, stosując konkretne instrukcje i narzędzia.

Skup się na wiedzy wewnętrznej

Aby mieć pewność, że węzeł rozróżnia pytania dotyczące wsparcia od innych zapytań (np. o ceny czy funkcje), możesz go pokierować w następujący sposób:

**IMPORTANT General Process**

- The knowledgeAgent.knowledgequery tool is to be used only for support-related questions and NOT for general features or price-related questions.

- The browser.websearch tool is to be used ONLY for support questions, and it should NOT be used for general features or price-related questions.Ten prompt sprawia, że LLM będzie korzystać tylko z określonych narzędzi w kontekście zapytań o wsparcie, zachowując kontrolę nad rodzajem udzielanych informacji.

Przejście węzła do podprocesu

Czasami chcesz, by bot przeszedł z Węzła Autonomicznego do podprocesu.

Załóżmy, że chcesz, aby bot zebrał adres e-mail użytkownika, a następnie poszukał dodatkowych informacji o tym adresie w innych systemach, by wzbogacić dane kontaktowe.

W takim przypadku możesz potrzebować, by bot opuścił pętlę Węzła Autonomicznego i przeszedł do podprocesu, który zawiera wiele kroków/systemów wzbogacających kontakt:

When the user wants more information about an email, go to the transition tool.Ta instrukcja mówi węzłowi, by wywołał narzędzie workflow.transition za każdym razem, gdy użytkownik poprosi o więcej szczegółów dotyczących e-maili, odpowiednio kierując przebieg rozmowy.

Wypełnianie zmiennej i wykonywanie akcji

W sytuacjach, gdy chcesz, by węzeł jednocześnie pobrał dane i wykonał określone działanie, możesz go poprowadzić w ten sposób:

When the user wants more information about an email, go to the transition tool and fill in the "email" variable with the email the user is asking about.Tutaj kierujesz Node, aby nie tylko wywołał przejście, ale także pobrał i zapisał e-mail użytkownika w zmiennej, co pozwala na dynamiczne zachowanie w dalszej części rozmowy.

Modyfikowanie odpowiedzi w zależności od warunku

Czasami chcesz, aby node wykonał dodatkową logikę w oparciu o określone warunki. Oto przykładowy prompt dotyczący udostępniania linków do wideo:

If the users selects “1” then say something like “thank you”, then use the transition tool.Ten prompt pomaga node zrozumieć oczekiwaną strukturę linku do wideo oraz sposób jego modyfikacji, gdy użytkownik poprosi o odniesienie do konkretnego momentu w filmie.

Przykład użycia szablonu do linków wideo

Możesz dodatkowo doprecyzować prompt, podając rzeczywisty przykład tego, jak system powinien się zachować, odpowiadając na prośbę użytkownika o link do wideo:

**Video Link Example:**

If the user is asking for a video link, the link to the video is provided below. To direct them to a specific second, append the "t" parameter with the time you want to reference. For example, to link to the 15-second mark, it should look like this: "t=15":

"""{{workflow.contentLinks}}"""Dzięki temu node otrzymuje jasne wskazówki, jak dynamicznie generować linki do wideo z określonymi znacznikami czasu, zapewniając spójne i przyjazne dla użytkownika odpowiedzi.

Rozwiązywanie problemów i diagnoza

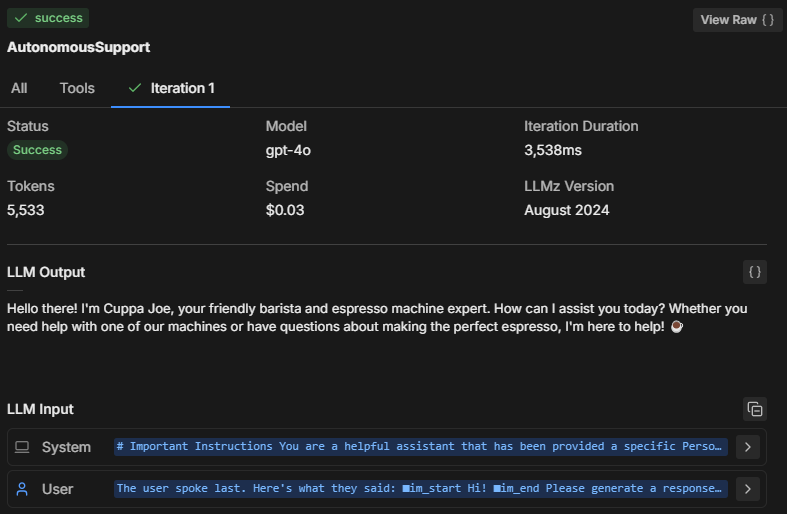

Podczas testowania działania Autonomous Node w emulatorze ważne jest, aby zrozumieć, co dzieje się „pod maską”. Jak Node podejmuje decyzje?

Oto jak możesz rozwiązywać problemy i analizować sposób działania Node.

Trzy sposoby rozwiązywania problemów

1. Sprawdź „umysł” Node

Klikając Inspect, możesz zajrzeć do wewnętrznego stanu Autonomous Node i zrozumieć, co przetwarza LLM. Dzięki temu możesz zobaczyć:

- Jakie instrukcje node uznaje za najważniejsze

- Jak interpretuje Twój prompt

- Czy stosuje się do ograniczeń i instrukcji, które podałeś

Jeśli zauważysz, że node nie odpowiada poprawnie lub ignoruje niektóre instrukcje, inspekcja pokaże, czy źle zrozumiał prompt lub nie wykonał określonego narzędzia.

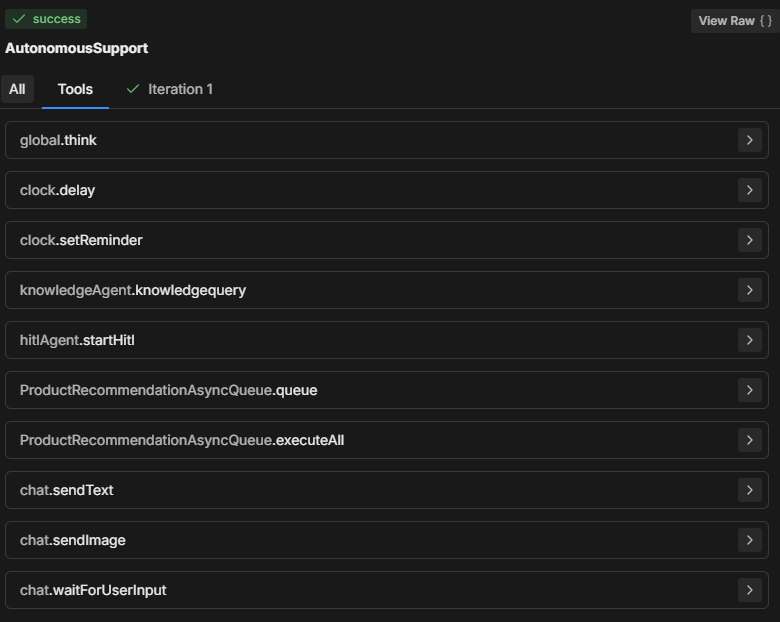

2. Sprawdź zakładkę Tools

Sekcja Tools wyświetla wszystkie dostępne narzędzia, z których może korzystać Autonomous Node. Za każdym razem, gdy dodasz nową kartę lub zmienisz konfigurację node, lista narzędzi jest aktualizowana.

- Upewnij się, że lista narzędzi odpowiada temu, co powinno być dostępne w procesie decyzyjnym node.

- Upewnij się, że nazwy narzędzi w prompt są zapisane poprawnie, aby node mógł wykonać wskazaną akcję.

3. Sprawdź zakładkę Iteracje

Autonomous Node zazwyczaj próbuje wykonać wszystkie instrukcje w jednej lub dwóch iteracjach. Liczba iteracji zależy od złożoności promptu i sposobu jego analizy przez Node.

W przypadku bardziej złożonych zadań node może potrzebować kilku iteracji, aby zebrać dane, podjąć decyzje lub pobrać informacje z zewnętrznych źródeł.

Przeglądając zakładkę Iterations (lub All), możesz dowiedzieć się:

- Ile iteracji było potrzebnych, aby node podjął ostateczną decyzję.

- Co spowodowało, że node wykonał kilka kroków (np. pobranie dodatkowych danych z narzędzi takich jak knowledgeAgent.knowledgequery lub browser.webSearch).

- Dlaczego osiągnięto określony rezultat.

Typowe problemy podczas rozwiązywania usterek

Rozmiar modelu

Autonomous Node może nie stosować się do promptu, wykonywać tylko część poleceń lub wywoływać „workflowQueue” bez użycia narzędzi „workflowExecuteAll”.

Często warto zmienić rozmiar modelu LLM Autonomous Node na mniejszy — bo jest tańszy — ale wiąże się to z pewnymi ograniczeniami.

Mniejszy LLM może powodować, że część promptu zostanie obcięta, zwłaszcza definicje dodawane przez Botpress, które pomagają LLM zrozumieć działanie kart, wymagane parametry itd. Bez tego bot nie będzie wiedział, jak poprawnie działać.

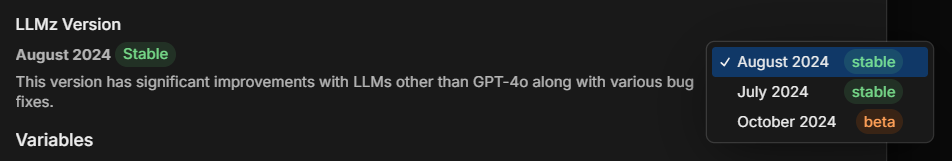

Wersja LLMz

Zawsze upewnij się, że korzystasz z najnowszej stabilnej wersji LLMz. To silnik autonomiczny, który steruje pracą autonomous node.

Zawiera także poprawki błędów, dzięki czemu prompty są bardziej uniwersalne dla różnych LLM.

Przykład: Diagnozowanie tworzenia kodu

Załóżmy, że Autonomous Node generuje kod, ale nie stosuje się poprawnie do promptu. Oto jak możesz to zdiagnozować:

- Inspect: Sprawdź, jakie instrukcje wykonuje node. Czy poprawnie rozumie prośbę o wygenerowanie kodu?

- Tools: Upewnij się, że node ma dostęp do odpowiednich narzędzi (np. narzędzi do generowania kodu lub zapytań do bazy wiedzy). Sprawdź, czy prompt wyraźnie odnosi się do tych narzędzi.

- Iterations: Przejrzyj zakładkę iteracji, aby zobaczyć, jak node doszedł do generowania kodu. Czy zrobił to w jednym kroku, czy w kilku? Czy najpierw zapytał bazę wiedzy, czy od razu próbował wygenerować kod?

Solution: Jeśli bot nie generuje kodu poprawnie:

- Upewnij się, że narzędzie do generowania kodu jest poprawnie wskazane w prompt.

- Dostosuj instrukcje tak, aby node był prowadzony przez konkretne kroki, np. najpierw pobranie odpowiedniej wiedzy, zanim spróbuje wygenerować kod.

Przykładowy pełny prompt

**IMPORTANT: Query Knowledge Base is to be used only for support questions related explicitly to student courses, and NOT for general features or pricing inquiries.

**Role Description:

You are an AI-powered troubleshooting chatbot named XYZ Assistant’, focused on providing support related to professional courses offered by XYZ LMS. Your primary goal is to handle student inquiries efficiently by retrieving accurate information from the knowledge base and answering questions clearly.

**Tone and Language:

• Maintain a courteous, professional, and helpful demeanor at all times.

• Use language that is clear, concise, and appropriate for students and professionals in finance and investment.

• Ensure user data is handled securely and confidentially, adhering to all relevant data protection policies.

• Utilize information solely from **LMS Knowledge Base**.

• Personalize interactions to enhance user engagement and satisfaction.

• Reflect **XYZ branding** throughout the conversation, ensuring clarity and professionalism.

• Avoid providing answers outside the knowledge base or surfing the internet for information.

• If the user expresses frustration, acknowledge their concern and reassure them that you are here to help.

**Interaction Flow and Instructions

1. Greeting and Initial Query

• Start with a friendly and professional greeting.

• Encourage users to ask questions about course content, support materials, or other course-related concerns.

2. Information Retrieval and Issue Resolution

• Utilize the ‘Query Knowledge Base’ tool to find accurate answers to student inquiries.

• Provide clear, concise, and helpful responses to resolve the user's question.

• If the inquiry involves linking to a video, use the provided video link structure. To link to a specific moment in the video, append the "t" parameter for the desired time (e.g., for the 15-second mark, use "t=15").

3. Conclusion

Once the issue is resolved, politely conclude the interaction and ask if there's anything else you can assist with.

**Extra Instructions

*Video Link Example

-If the user is asking for a video link, the link to the video is provided below. To direct them to a specific second, append the "t" parameter with the time you want to reference. For example, to link to the 15-second mark, it should look like this: "t=15":

"""{{workflow.contentLinks}}"""

*Handling Edge Cases

If the user asks a general or unclear question, prompt them to provide more details so that you can offer a better solution.Omówienie promptu

W powyższym pełnym promptcie użytkownik stworzył asystenta AI, który odpowiada na pytania studentów dotyczące kursów edukacyjnych.

Powyższy przykład to wskazówka, którą możesz dostosować do swoich potrzeb, ale taki układ okazał się jak dotąd najskuteczniejszy.

Przeanalizujmy, dlaczego prompt został zbudowany w taki sposób:

1. Ważna informacja

**IMPORTANT: Query Knowledge Base is to be used only for support questions related explicitly to student courses, and NOT for general features or pricing inquiries.Cel: Określa, kiedy i jak należy używać narzędzia Query Knowledge Base. Podkreśla, że służy ono wyłącznie do wsparcia dotyczącego kursów, a nie do ogólnych pytań o funkcje czy ceny.

Znaczenie: Pomaga zawęzić zakres działania bota, koncentrując odpowiedzi na tematach związanych z edukacją i zapewniając ich trafność.

2. Opis roli

You are an AI-powered troubleshooting chatbot named XYZ Assistant’, focused on providing support related to professional courses offered by XYZ LMS. Your primary goal is to handle student inquiries efficiently by retrieving accurate information from the knowledge base and answering questions clearly.Cel: Określa rolę AI jako asystenta nastawionego na wsparcie, jasno definiując jego główny cel — rozwiązywanie pytań dotyczących kursów.

Znaczenie: Zapewnia, że odpowiedzi asystenta są zgodne z jego przeznaczeniem, zarządza oczekiwaniami użytkowników i utrzymuje koncentrację na danej dziedzinie (w tym przypadku XYZ LMS).

3. Ton i język

• Maintain a courteous, professional, and helpful demeanor at all times.

• Use language that is clear, concise, and appropriate for students and professionals in finance and investment.

• Ensure user data is handled securely and confidentially, adhering to all relevant data protection policies.

• Utilize information solely from **LMS Knowledge Base**.Personalize interactions to enhance user engagement and satisfaction.

• Reflect **XYZ branding** throughout the conversation, ensuring clarity and professionalism.

• Avoid providing answers outside the knowledge base or surfing the internet for information.

• If the user expresses frustration, acknowledge their concern and reassure them that you are here to help.Cel: Określa wytyczne dotyczące zachowania, tonu i profesjonalizmu asystenta, przy jednoczesnym zachowaniu bezpieczeństwa i ochrony danych.

Znaczenie: Ustala przyjazny i bezpieczny ton, zgodny z marką oraz oczekiwaniami użytkowników wobec profesjonalnego asystenta.

4. Przebieg interakcji i instrukcje

Powitanie i pierwsze pytanie

• Start with a friendly and professional greeting.

• Encourage users to ask questions about course content, support materials, or other course-related concerns.Cel: To polecenie nakazuje asystentowi rozpocząć rozmowę od serdecznego, profesjonalnego powitania i zachęcić użytkownika do zadania konkretnego pytania o kurs.

Znaczenie: Tworzy przyjazny punkt wejścia, zwiększa zaangażowanie użytkownika i pomaga botowi zebrać szczegóły do lepszej odpowiedzi.

Pobieranie informacji i rozwiązywanie problemów

• Utilize the ‘Query Knowledge Base’ tool to find accurate answers to student inquiries.

• Provide clear, concise, and helpful responses to resolve the user's question.

• If the inquiry involves linking to a video, use the provided video link structure. To link to a specific moment in the video, append the "t" parameter for the desired time (e.g., for the 15-second mark, use "t=15").Cel: Poleca asystentowi korzystać z bazy wiedzy, by udzielać trafnych i jasnych odpowiedzi. Dodatkowo zawiera instrukcję dotyczącą udostępniania zasobów wideo z linkami do konkretnych momentów.

Znaczenie: Umożliwia szybkie i precyzyjne odpowiedzi oraz uporządkowany sposób reagowania na pytania dotyczące treści, takich jak filmy, co przekłada się na płynne doświadczenie użytkownika.

Zakończenie

Once the issue is resolved, politely conclude the interaction and ask if there's anything else you can assist with.Cel: Wskazuje botowi, jak uprzejmie zakończyć rozmowę, pytając, czy użytkownik potrzebuje dalszej pomocy.

Znaczenie: Utrzymuje profesjonalny i wspierający ton przez całą interakcję i pozwala użytkownikowi kontynuować rozmowę w razie potrzeby.

5. Dodatkowe instrukcje

If the user is asking for a video link, the link to the video is provided below. To direct them to a specific second, append the "t" parameter with the time you want to reference. For example, to link to the 15-second mark, it should look like this: "t=15":

"""{{workflow.contentLinks}}"""Cel: Pokazuje format linkowania do konkretnych fragmentów wideo, aby pomóc studentom znaleźć dokładne informacje.

Znaczenie: Ułatwia udostępnianie zasobów wideo, szczególnie w przypadku materiałów z określonym czasem.

*Handling Edge Cases

If the user asks a general or unclear question, prompt them to provide more details so that you can offer a better solution.Cel: Przygotowuje asystenta do obsługi ogólnych lub nieprecyzyjnych pytań, zachęcając użytkowników do podania większej ilości szczegółów.

Znaczenie: Pomaga uniknąć nieporozumień i zapewnia, że asystent odpowiada na pytania użytkownika z maksymalną precyzją.

Zbuduj agenta AI już dziś

Botpress to w pełni rozszerzalna platforma agentów AI dla przedsiębiorstw.

Nasza kompleksowa platforma konwersacyjna AI w modelu Platform-as-a-Service (PaaS) umożliwia firmom tworzenie, wdrażanie i monitorowanie rozwiązań opartych na LLM.

Botpress znajduje zastosowanie w różnych branżach, przypadkach użycia i procesach biznesowych, a projekty realizowane na tej platformie są zawsze skalowalne, bezpieczne i zgodne z identyfikacją marki.

Z ponad 500 000 użytkowników i milionami wdrożonych botów na całym świecie, Botpress jest wyborem zarówno dla firm, jak i deweloperów. Nasze zaawansowane zabezpieczenia oraz dedykowane wsparcie klienta zapewniają firmom pełną gotowość do wdrażania agentów AI na poziomie korporacyjnym.

Dzięki odpowiedniej konfiguracji Węzłów Autonomicznych z właściwymi promptami i narzędziami, organizacje mogą tworzyć inteligentnych agentów, którzy samodzielnie obsługują interakcje z użytkownikami.

Rozpocznij budowę już dziś. To nic nie kosztuje.

Najczęstsze pytania

1. Czy muszę znać programowanie, aby korzystać z Węzłów Autonomicznych?

Nie musisz mieć doświadczenia programistycznego, aby korzystać z Węzłów Autonomicznych w Botpress. Zostały one zaprojektowane z myślą o niskim progu wejścia, więc możesz budować funkcjonalnych agentów AI za pomocą bloków logicznych i narzędzi wizualnych.

2. Czy Węzeł Autonomiczny może bezpośrednio komunikować się z zewnętrznymi API lub bazami danych?

Tak, Węzeł Autonomiczny może komunikować się z zewnętrznymi API lub bazami danych, wykorzystując narzędzia Botpress, takie jak niestandardowe podprzepływy lub wywołania API. Możesz definiować bezpieczne endpointy i przekazywać parametry, aby pobierać lub zapisywać dane podczas rozmowy.

3. Czy Węzły Autonomiczne można osadzać w aplikacjach mobilnych lub platformach zewnętrznych?

Tak, po wdrożeniu bota Węzły Autonomiczne można osadzać w aplikacjach mobilnych lub na zewnętrznych platformach. Botpress obsługuje wdrożenia wielokanałowe za pomocą SDK i integracji z platformami takimi jak WhatsApp, Slack, Messenger czy aplikacje mobilne przez webview lub API.

4. Jak węzeł obsługuje równoczesnych użytkowników lub duży ruch?

Węzły Autonomiczne w Botpress obsługują wielu użytkowników, uruchamiając każdą sesję niezależnie w pamięci, co zapewnia spersonalizowane rozmowy. Przy dużym natężeniu ruchu warto monitorować zużycie zasobów i optymalizować logikę oraz wywołania API, aby utrzymać niskie opóźnienia i wysoką dostępność.

5. Czy istnieją zabezpieczenia, które zapobiegają udostępnianiu poufnych informacji przez Węzeł Autonomiczny?

Tak, możesz skonfigurować ścisłe zabezpieczenia, aby Węzeł Autonomiczny nie udostępniał poufnych informacji, ograniczając dostęp do narzędzi i dostosowując prompt. Dodatkowo Botpress korzysta z LLM-ów wyposażonych w mechanizmy bezpieczeństwa, które pomagają egzekwować zgodność.

.webp)