Der Botpress Autonome Node ermöglicht es Ihnen, funktionale KI-Agenten zu erstellen – keine Chatbots, sondern autonome Agenten, die Entscheidungen auf Basis ihres verfügbaren Kontexts treffen.

Durch klare Anweisungen und die Integration von Tools können Bot-Entwickler mit Autonomen Nodes das Verhalten eines Chatbots festlegen.

Der Node ist darauf ausgelegt, sowohl Entscheidungen zu treffen als auch auszuführen, indem er Nutzereingaben versteht, mit den passenden Daten antwortet und seine Tools nutzt.

Wenn Sie einen Autonomen Node einsetzen möchten, sind Sie hier richtig. In diesem Artikel erkläre ich die Grundlagen für die Nutzung dieses leistungsstarken Features unserer Plattform.

Wichtige Funktionen des Autonomen Nodes

1. LLM-gesteuerte Entscheidungen

Ein Autonomer Node nutzt die Fähigkeiten eines LLM, um intelligente Entscheidungen über einen LLM-Agenten zu treffen.

2. Autonomes Verhalten

Ein Autonomer Node kann Aktionen eigenständig auf Basis von Anweisungen und Nutzereingaben ausführen, ohne manuelles Eingreifen.

3. Tools

Der Autonome Node versteht und nutzt bestimmte Tools – zum Beispiel kann er Wissensdatenbanken abfragen, Websuchen durchführen und Workflow-Übergänge ausführen.

4. Anpassbarkeit

Durch die Konfiguration eines Autonomen Nodes mit einer passenden Persona und detaillierten Anweisungen stellen Sie sicher, dass er markenkonform und im gewünschten Rahmen agiert.

5. Code schreiben & ausführen

Der Autonome Node kann eigenen Code generieren und ausführen, um Aufgaben zu erledigen.

6. Selbstkorrektur

Wenn der Autonome Node feststellt, dass er auf dem falschen Weg ist, kann er sich selbst korrigieren und Fehler beheben.

Konfigurationseinstellungen

Jeder Autonome Node muss sorgfältig konfiguriert werden, damit sein Verhalten zu den geschäftlichen Anforderungen passt.

Der wichtigste Teil bei der Einrichtung eines Autonomen Nodes ist das Verfassen des richtigen Prompts und der Anweisungen. Der Prompt hilft dem Agenten, seine Rolle zu verstehen und leitet die Entscheidungsfindung.

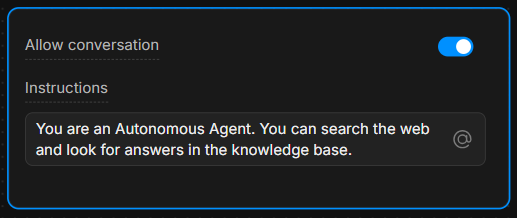

Anweisungsfeld

Geben Sie im Anweisungsfeld klare Richtlinien vor. Je spezifischer die Anweisungen, desto besser trifft der Agent Entscheidungen.

Beispiel: „Du bist ein hilfreicher Assistent, der Fragen immer mit dem Tool ‘knowledgeAgent.knowledgequery’ beantwortet. Wenn der Nutzer ‘suche’ sagt, verwende das Tool ‘browser.webSearch’.“

Konversation erlauben

Mit dem Schalter Konversation erlauben kann der Autonome Node direkt mit Nutzern kommunizieren. Ist er deaktiviert, verarbeitet der Node nur Befehle und führt seine interne Logik aus, ohne Nachrichten an Nutzer zu senden.

Die Tools verstehen

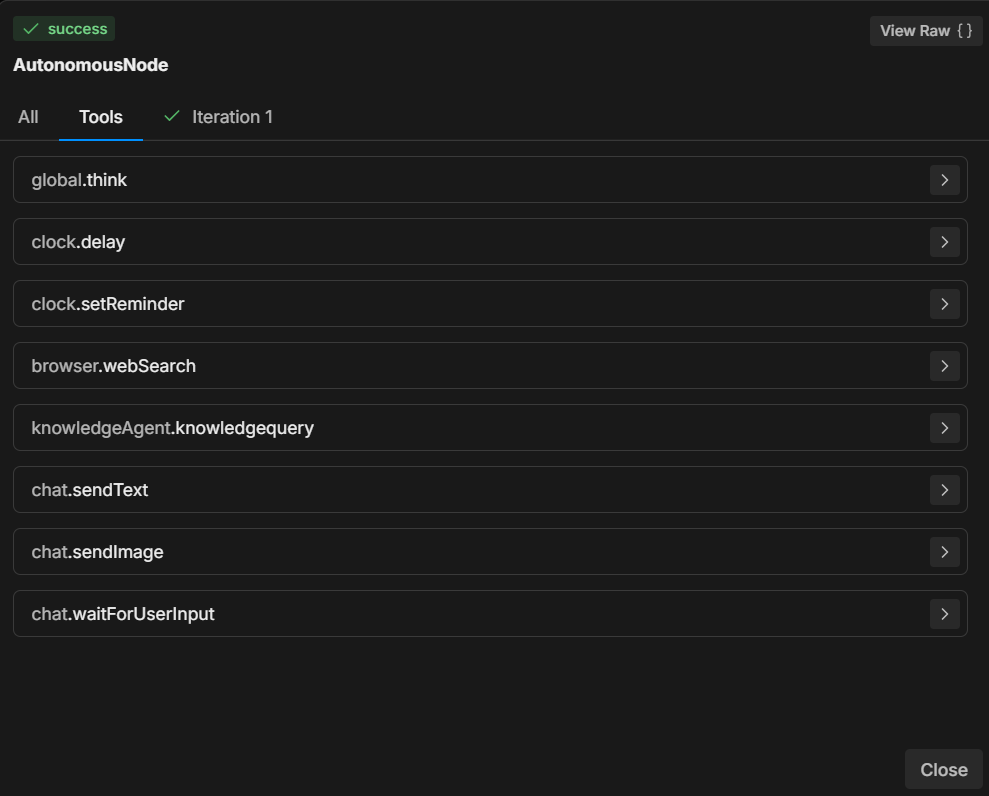

Basierend auf Ihren Anweisungen ist ein Autonomer Node mit mehreren Tools ausgestattet, die er aufrufen kann.

Jedes Tool führt eine bestimmte Aktion aus – zu wissen, wann und wie diese Tools eingesetzt werden, ist entscheidend für die Entscheidungen des Nodes.

Die 7 gebräuchlichsten Tools

- global.think: Ermöglicht der LLMz-Engine, vor dem Fortfahren nachzudenken.

- browser.webSearch: Ermöglicht dem Agenten, im Web nach Antworten zu suchen.

- knowledgeAgent.knowledgequery: Fragt eine interne Wissensdatenbank nach relevanten Informationen ab.

- clock.setReminder: Legt eine Erinnerung für zukünftige Aufgaben oder Antworten fest.

- workflow.transition: Führt einen Workflow-Übergang aus, um je nach Nutzereingabe zu einem anderen Teil der Konversation zu wechseln.

- chat.sendText: Sendet dem Nutzer eine Textnachricht als Antwort.

- chat.waitForUserInput: Hält die Ausführung an und wartet auf weitere Eingaben des Nutzers.

Indem Sie festlegen, welches Tool als Reaktion auf Nutzeraktionen verwendet wird, steuern Sie den Ablauf und das Ergebnis der Konversation.

Sie können zum Beispiel dem LLM anweisen, bei bestimmten Bedingungen immer bestimmte Aktionen auszuführen: „Wenn der Nutzer ‘1’ sagt, verwende das Tool ‘workflow.transition’, um zum nächsten Schritt zu wechseln.“

Oder: „Wenn der Nutzer eine Frage stellt, versuche zuerst, sie mit dem Tool ‘knowledgeAgent.knowledgequery’ zu beantworten.“

Beispielhafter Ablauf

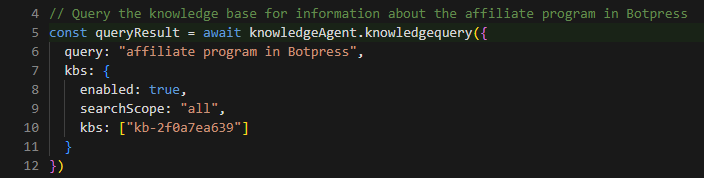

Hier ein Schritt-für-Schritt-Beispiel, wie der Autonome Node während einer Konversation konfiguriert und eingesetzt werden könnte:

1. Nutzereingabe

Der Nutzer stellt eine Frage zum Produkt des Unternehmens.

2. Ausführung der Anweisung

Der Autonome Node folgt dem Prompt und nutzt das Tool knowledgeAgent.knowledgequery, um die interne Wissensdatenbank zu durchsuchen.

3. LLM-Entscheidung

Falls die Wissensdatenbank keine zufriedenstellende Antwort liefert, kann der Node anschließend das Tool browser.webSearch verwenden, um im Web nach weiteren Informationen zu suchen.

4. Nachricht senden

Sobald die Antwort bereit ist, nutzt der Node chat.sendText, um dem Nutzer die relevanten Informationen zu schicken.

5. Auf Eingabe warten

Nach der Antwort verwendet der Node chat.waitForUserInput, um auf weitere Fragen oder Interaktionen des Nutzers zu warten.

Wie man Anweisungen schreibt

Wie im Beispiel gezeigt, sind klare Anweisungen entscheidend dafür, dass der Autonome Node korrekt funktioniert.

Die Fähigkeit des LLM, Entscheidungen zu treffen, hängt stark davon ab, wie die Anweisungen formuliert sind.

Hier sind 3 bewährte Methoden zum Schreiben von Anweisungen für Ihren Autonomen Node:

1. Seien Sie spezifisch

Verwenden Sie statt vager Befehle eine klare Sprache, die den Agenten eindeutig anleitet.

Beispiel: „Wenn der Nutzer ‘Hilfe’ sagt, sende ihm eine vordefinierte Liste von Support-Optionen mit ‘chat.sendText’.“

2. Tool-Nutzung definieren

Geben Sie explizit an, welches Tool unter welchen Umständen verwendet werden soll.

Beispiel: „Nutze für produktbezogene Fragen immer ‘knowledgeAgent.knowledgequery’.“

3. Den Ablauf steuern

Verwenden Sie klare Übergänge und Schritte, damit die Konversation in die gewünschte Richtung verläuft.

Beispiel: „Wenn die Wissensdatenbank keine Antwort liefert, wechsle mit ‘browser.webSearch’ zur Websuche.“

Weitere Informationen finden Sie unter folgenden Links:

- Best Practices für Prompt Engineering mit der OpenAI API

- Systeme bauen mit der ChatGPT API

- ChatGPT Prompt Engineering für Entwickler

Markdown-Syntax verwenden

Bevor Sie beginnen, ist es wichtig, über die Bedeutung der Verwendung von Markdown-Syntax zu sprechen.

Um einen strukturierten, übersichtlichen Prompt zu erstellen, ist es wichtig, Markdown-Syntax wie Überschriften, Aufzählungen und Fettdruck zu nutzen.

Diese Syntax hilft dem LLM, die Hierarchie der Anweisungen zu erkennen und zu beachten, sodass es zwischen Hauptabschnitten, Unteranweisungen und Beispielen unterscheiden kann.

Wenn es Ihnen schwerfällt, Markdown-Syntax zu verwenden, dann nutzen Sie jede Struktur, die für Sie einfach ist – solange Sie klar und hierarchisch bleiben.

Mehr zur grundlegenden Markdown-Syntax

Nützliche Prompts

In diesem Abschnitt finden Sie eine Liste der gebräuchlichsten Beispiele und Muster, mit denen Sie das Verhalten des Autonomen Nodes steuern können.

Diese Beispiele stammen aus der Praxis und zeigen, wie Sie verschiedene Szenarien mit spezifischen Anweisungen und Tools handhaben.

Fokus auf internes Wissen

Damit der Node zwischen Support-Anfragen und anderen Anfragen (wie Preise oder Funktionen) unterscheiden kann, können Sie ihn folgendermaßen anleiten:

**IMPORTANT General Process**

- The knowledgeAgent.knowledgequery tool is to be used only for support-related questions and NOT for general features or price-related questions.

- The browser.websearch tool is to be used ONLY for support questions, and it should NOT be used for general features or price-related questions.Mit diesem Prompt stellen Sie sicher, dass das LLM bestimmte Tools nur im Kontext von Support-Anfragen verwendet und so die Kontrolle über die abgerufenen Informationen behält.

Node in einen Subflow überführen

Manchmal möchten Sie, dass der Bot aus dem Autonomen Node in einen Subflow wechselt.

Angenommen, Ihr Bot soll eine Nutzer-E-Mail erfassen und dann weitere Informationen zu dieser E-Mail aus anderen Systemen abrufen, um die Kontaktdaten zu ergänzen.

In diesem Fall muss der Bot die Schleife des Autonomen Nodes verlassen und in einen Subflow wechseln, der mehrere Schritte/Systeme zur Anreicherung des Kontakts enthält:

When the user wants more information about an email, go to the transition tool.Diese Anweisung weist den Node an, das Tool workflow.transition zu verwenden, sobald der Nutzer nach weiteren Details zu E-Mails fragt, und so den Gesprächsverlauf entsprechend zu steuern.

Variable ausfüllen und Aktion ausführen

Für Szenarien, in denen der Node sowohl eine Eingabe erfassen als auch gleichzeitig eine Aktion auslösen soll, können Sie ihn folgendermaßen anleiten:

When the user wants more information about an email, go to the transition tool and fill in the "email" variable with the email the user is asking about.Hier leitest du den Node an, nicht nur die Transition auszulösen, sondern auch die E-Mail-Adresse des Nutzers zu extrahieren und in einer Variablen zu speichern, sodass später im Gespräch dynamisch darauf zugegriffen werden kann.

Antworten abhängig von Bedingungen steuern

Manchmal möchtest du, dass der Node zusätzliche Logik ausführt, abhängig von bestimmten Bedingungen. Hier ist ein Beispiel für eine Aufforderung im Zusammenhang mit Videolinks:

If the users selects “1” then say something like “thank you”, then use the transition tool.Diese Aufforderung hilft dem Node, die erwartete Struktur eines Videolinks zu verstehen und wie er diesen anpassen soll, wenn der Nutzer auf einen bestimmten Zeitpunkt im Video verweisen möchte.

Beispiel für die Verwendung einer Vorlage für Videolinks

Du kannst die Aufforderung weiter verdeutlichen, indem du ein konkretes Beispiel gibst, wie das System auf eine Nutzeranfrage nach Videolinks reagieren soll:

**Video Link Example:**

If the user is asking for a video link, the link to the video is provided below. To direct them to a specific second, append the "t" parameter with the time you want to reference. For example, to link to the 15-second mark, it should look like this: "t=15":

"""{{workflow.contentLinks}}"""So erhält der Node klare Anweisungen, wie er Videolinks mit bestimmten Zeitmarken dynamisch generieren kann, um konsistente und benutzerfreundliche Antworten zu gewährleisten.

Fehlerbehebung & Diagnose

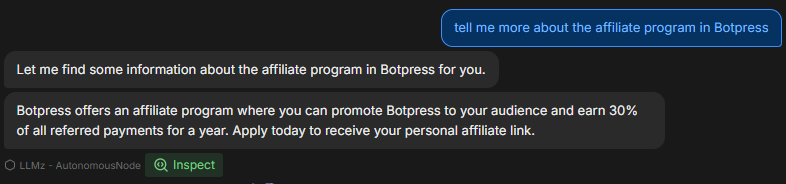

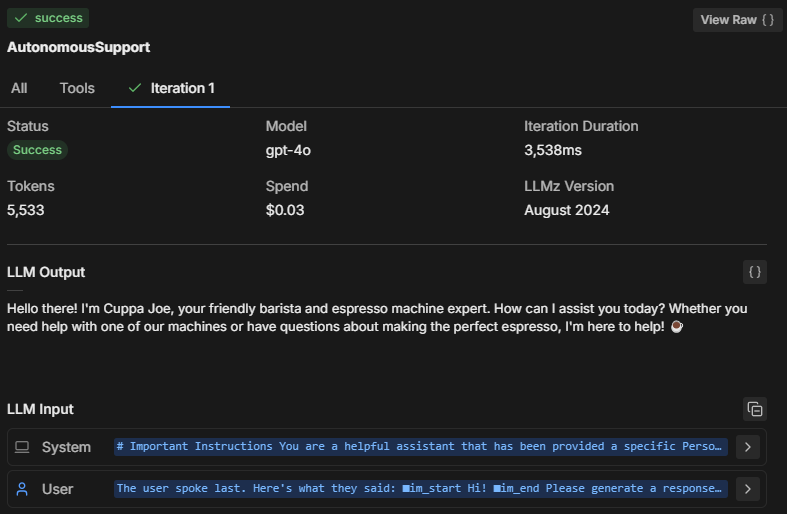

Beim Testen des Verhaltens des Autonomen Nodes im Emulator ist es wichtig, zu analysieren, was im Hintergrund passiert. Wie trifft der Node seine Entscheidungen?

So kannst du den Denkprozess und die Leistung des Nodes überprüfen und Probleme beheben.

Drei Möglichkeiten zur Fehlerbehebung

1. Den Denkprozess des Nodes einsehen

Durch einen Klick auf Inspect kannst du einen Einblick in den internen Zustand des Autonomen Nodes erhalten und nachvollziehen, was das LLM verarbeitet. Beim Inspizieren siehst du:

- Welche Anweisungen der Node priorisiert

- Wie er deine Aufforderung interpretiert

- Ob er sich an die von dir vorgegebenen Einschränkungen und Anweisungen hält

Wenn du feststellst, dass der Node nicht korrekt reagiert oder bestimmte Anweisungen ignoriert, zeigt dir das Inspect-Tool, ob er die Aufforderung missverstanden hat oder ein bestimmtes Tool nicht ausgeführt wurde.

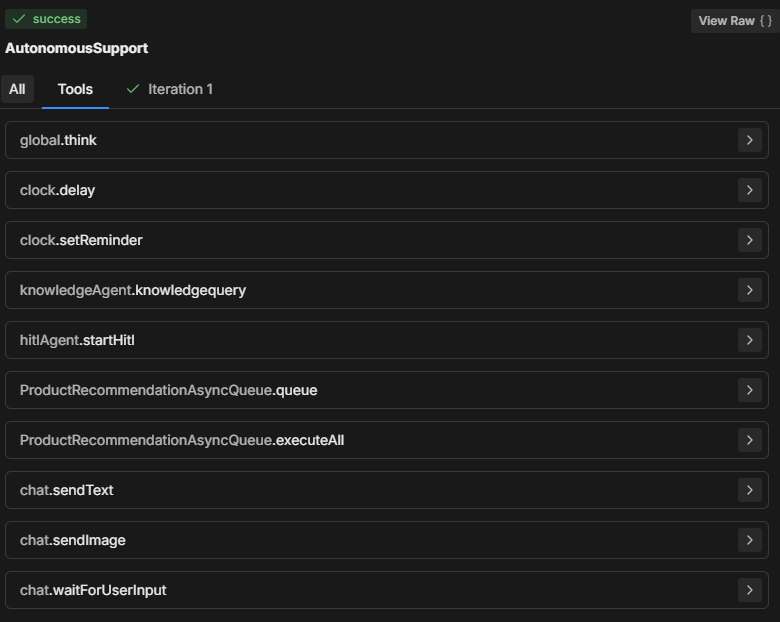

2. Den Tools-Tab überprüfen

Im Bereich Tools werden alle verfügbaren Tools angezeigt, die der Autonome Node nutzen kann. Jedes Mal, wenn du eine neue Karte hinzufügst oder die Node-Konfiguration änderst, wird die Tool-Liste aktualisiert.

- Stelle sicher, dass die aufgelisteten Tools mit deinen Erwartungen für den Entscheidungsprozess des Nodes übereinstimmen.

- Achte darauf, dass die Tool-Namen in deiner Aufforderung korrekt geschrieben sind, damit der Node die gewünschte Aktion ausführen kann.

3. Überprüfen Sie den Tab "Iterationen"

Der Autonome Node versucht in der Regel, alle Anweisungen innerhalb von ein bis zwei Iterationen auszuführen. Die Anzahl der Iterationen hängt von der Komplexität des Prompts und davon ab, wie der Node diesen analysiert.

Bei komplexeren Aufgaben kann es sein, dass der Node mehrere Iterationen benötigt, um Daten zu sammeln, Entscheidungen zu treffen oder externe Informationen abzurufen.

Durch das Überprüfen des Iterations-Tabs (oder des All-Tabs) kannst du nachvollziehen:

- Wie viele Iterationen der Node benötigt hat, um zu seiner endgültigen Entscheidung zu kommen.

- Was dazu geführt hat, dass der Node mehrere Schritte ausgeführt hat (z. B. das Abrufen zusätzlicher Daten über Tools wie knowledgeAgent.knowledgequery oder browser.webSearch).

- Warum ein bestimmtes Ergebnis erzielt wurde.

Häufige Probleme bei der Fehlerbehebung

Modellgröße

Es kann vorkommen, dass der Autonome Node deiner Aufforderung nicht vollständig folgt, nur einen Teil davon ausführt oder das Tool „workflowQueue“ aufruft, ohne „workflowExecuteAll“ zu verwenden.

Es erscheint sinnvoll, die LLM-Größe des Autonomen Nodes auf ein kleineres Modell zu setzen – das ist günstiger –, aber das hat auch Nachteile.

Ein kleineres LLM kann dazu führen, dass Teile der Aufforderung abgeschnitten werden, insbesondere der Definitions-Wrapper, den Botpress hinzufügt, damit das LLM versteht, wie die Karten funktionieren und welche Parameter benötigt werden. Ohne diesen Kontext weiß der Bot nicht, wie er korrekt handeln soll.

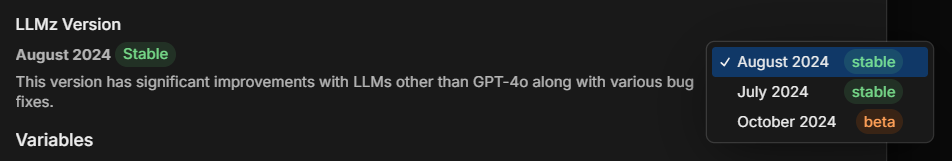

LLMz-Version

Stelle immer sicher, dass du die neueste stabile Version von LLMz verwendest. Sie ist die autonome Engine, die den Autonomen Node steuert.

Sie enthält auch Fehlerbehebungen und sorgt dafür, dass die Aufforderungen weniger abhängig vom verwendeten LLM sind.

Beispiel: Diagnose der Code-Erstellung

Angenommen, ein Autonomer Node generiert Code, folgt aber der Aufforderung nicht korrekt. So könntest du das Problem analysieren:

- Inspect: Prüfe, welchen Anweisungen der Node folgt. Versteht er die Anforderung zur Code-Generierung richtig?

- Tools: Überprüfe, ob der Node Zugriff auf die benötigten Tools hat (z. B. Tools zur Code-Generierung oder zur Abfrage der Wissensdatenbank). Stelle sicher, dass die Aufforderung diese Tools explizit erwähnt.

- Iterations: Sieh dir im Iterations-Tab an, wie der Node zur Code-Generierung gelangt ist. Wurde der Code in einem oder mehreren Schritten erstellt? Hat er zuerst die Wissensdatenbank abgefragt oder direkt versucht, Code zu generieren?

Lösung: Falls der Bot den Code nicht korrekt generiert:

- Stelle sicher, dass das für die Code-Generierung verwendete Tool in der Aufforderung korrekt referenziert wird.

- Passe die Anweisungen so an, dass der Node gezielt bestimmte Schritte ausführt, z. B. zunächst relevantes Wissen abruft, bevor er mit der Code-Generierung beginnt.

Vollständiges Prompt-Beispiel

**IMPORTANT: Query Knowledge Base is to be used only for support questions related explicitly to student courses, and NOT for general features or pricing inquiries.

**Role Description:

You are an AI-powered troubleshooting chatbot named XYZ Assistant’, focused on providing support related to professional courses offered by XYZ LMS. Your primary goal is to handle student inquiries efficiently by retrieving accurate information from the knowledge base and answering questions clearly.

**Tone and Language:

• Maintain a courteous, professional, and helpful demeanor at all times.

• Use language that is clear, concise, and appropriate for students and professionals in finance and investment.

• Ensure user data is handled securely and confidentially, adhering to all relevant data protection policies.

• Utilize information solely from **LMS Knowledge Base**.

• Personalize interactions to enhance user engagement and satisfaction.

• Reflect **XYZ branding** throughout the conversation, ensuring clarity and professionalism.

• Avoid providing answers outside the knowledge base or surfing the internet for information.

• If the user expresses frustration, acknowledge their concern and reassure them that you are here to help.

**Interaction Flow and Instructions

1. Greeting and Initial Query

• Start with a friendly and professional greeting.

• Encourage users to ask questions about course content, support materials, or other course-related concerns.

2. Information Retrieval and Issue Resolution

• Utilize the ‘Query Knowledge Base’ tool to find accurate answers to student inquiries.

• Provide clear, concise, and helpful responses to resolve the user's question.

• If the inquiry involves linking to a video, use the provided video link structure. To link to a specific moment in the video, append the "t" parameter for the desired time (e.g., for the 15-second mark, use "t=15").

3. Conclusion

Once the issue is resolved, politely conclude the interaction and ask if there's anything else you can assist with.

**Extra Instructions

*Video Link Example

-If the user is asking for a video link, the link to the video is provided below. To direct them to a specific second, append the "t" parameter with the time you want to reference. For example, to link to the 15-second mark, it should look like this: "t=15":

"""{{workflow.contentLinks}}"""

*Handling Edge Cases

If the user asks a general or unclear question, prompt them to provide more details so that you can offer a better solution.Aufschlüsselung des Prompts

Im vollständigen Prompt oben hat der Nutzer einen AI-Assistenten erstellt, der Fragen von Studierenden zu Bildungskursen beantwortet.

Das obige Beispiel dient als Leitfaden und kann an Ihre Bedürfnisse angepasst werden, aber dieses Format hat sich bisher als die effektivste Struktur erwiesen.

Schauen wir uns an, warum der Prompt so aufgebaut ist:

1. Wichtiger Hinweis

**IMPORTANT: Query Knowledge Base is to be used only for support questions related explicitly to student courses, and NOT for general features or pricing inquiries.Zweck: Legt fest, wann und wie das Tool Query Knowledge Base verwendet werden soll. Betont, dass es ausschließlich für kursbezogene Anfragen gedacht ist, nicht für allgemeine Fragen zu Funktionen oder Preisen.

Bedeutung: Hilft, den Fokus des Bots einzugrenzen, damit die Antworten für die Nutzer relevant bleiben und sich auf Bildungsinhalte beziehen.

2. Rollenbeschreibung

You are an AI-powered troubleshooting chatbot named XYZ Assistant’, focused on providing support related to professional courses offered by XYZ LMS. Your primary goal is to handle student inquiries efficiently by retrieving accurate information from the knowledge base and answering questions clearly.Zweck: Definiert die Rolle der KI als unterstützenden Assistenten und legt klar das Hauptziel fest, kursbezogene Anfragen zu lösen.

Bedeutung: Stellt sicher, dass die Antworten des Assistenten seinem Zweck entsprechen, die Erwartungen der Nutzer steuern und im jeweiligen Bereich (hier: XYZ LMS) bleiben.

3. Tonfall und Sprache

• Maintain a courteous, professional, and helpful demeanor at all times.

• Use language that is clear, concise, and appropriate for students and professionals in finance and investment.

• Ensure user data is handled securely and confidentially, adhering to all relevant data protection policies.

• Utilize information solely from **LMS Knowledge Base**.Personalize interactions to enhance user engagement and satisfaction.

• Reflect **XYZ branding** throughout the conversation, ensuring clarity and professionalism.

• Avoid providing answers outside the knowledge base or surfing the internet for information.

• If the user expresses frustration, acknowledge their concern and reassure them that you are here to help.Zweck: Gibt Hinweise zum Auftreten, Ton und zur Professionalität des Assistenten, wobei auf sichere und datenschutzkonforme Interaktionen geachtet wird.

Bedeutung: Sorgt für einen freundlichen und sicheren Ton, der zur Marke und zu den Erwartungen an einen professionellen Support-Assistenten passt.

4. Ablauf und Anweisungen für die Interaktion

Begrüßung und erste Anfrage

• Start with a friendly and professional greeting.

• Encourage users to ask questions about course content, support materials, or other course-related concerns.Zweck: Diese Anweisung sorgt dafür, dass der Assistent mit einer freundlichen, professionellen Begrüßung startet und die Nutzer dazu ermutigt, gezielte Fragen zu ihrem Kurs zu stellen.

Bedeutung: Schafft einen einladenden Einstieg, fördert die Interaktion und hilft dem Bot, gezielte Informationen für bessere Antworten zu sammeln.

Informationsabruf und Problemlösung

• Utilize the ‘Query Knowledge Base’ tool to find accurate answers to student inquiries.

• Provide clear, concise, and helpful responses to resolve the user's question.

• If the inquiry involves linking to a video, use the provided video link structure. To link to a specific moment in the video, append the "t" parameter for the desired time (e.g., for the 15-second mark, use "t=15").Zweck: Weist den Assistenten an, die Wissensdatenbank für relevante, klare Antworten zu nutzen. Außerdem wird ein strukturierter Ansatz für die Weitergabe von Videoressourcen mit Zeitmarken beschrieben.

Bedeutung: Ermöglicht effiziente, präzise Antworten und eine strukturierte Bearbeitung von inhaltsspezifischen Anfragen wie Videos, um eine reibungslose Nutzererfahrung zu gewährleisten.

Abschluss

Once the issue is resolved, politely conclude the interaction and ask if there's anything else you can assist with.Zweck: Gibt dem Bot vor, wie er das Gespräch höflich abschließen und nach weiterem Unterstützungsbedarf fragen soll.

Bedeutung: Sichert einen professionellen und unterstützenden Ton während der gesamten Interaktion und ermöglicht es den Nutzern, bei Bedarf weiterzumachen.

5. Zusätzliche Anweisungen

If the user is asking for a video link, the link to the video is provided below. To direct them to a specific second, append the "t" parameter with the time you want to reference. For example, to link to the 15-second mark, it should look like this: "t=15":

"""{{workflow.contentLinks}}"""Zweck: Zeigt das Format, wie auf bestimmte Stellen in einem Video verlinkt werden kann, damit Studierende gezielt Informationen finden.

Bedeutung: Schafft Klarheit beim Teilen von Videoressourcen, insbesondere bei zeitbezogenen Lerninhalten.

*Handling Edge Cases

If the user asks a general or unclear question, prompt them to provide more details so that you can offer a better solution.Zweck: Bereitet den Assistenten darauf vor, auf vage oder allgemeine Anfragen zu reagieren, indem er die Nutzer nach weiteren Details fragt.

Bedeutung: Hilft, Missverständnisse zu vermeiden und stellt sicher, dass der Assistent Nutzerfragen so präzise wie möglich beantworten kann.

Erstellen Sie noch heute einen KI-Agenten

Botpress ist eine vollständig erweiterbare KI-Agentenplattform für Unternehmen.

Unsere All-in-One Conversational-AI-Platform-as-a-Service (PaaS) ermöglicht es Unternehmen, LLM-basierte Lösungen zu erstellen, bereitzustellen und zu überwachen.

Botpress-Projekte werden branchenübergreifend, in verschiedenen Anwendungsfällen und Geschäftsprozessen eingesetzt und sind dabei stets skalierbar, sicher und markenkonform.

Mit über 500.000 Nutzern und Millionen weltweit eingesetzten Bots ist Botpress die bevorzugte Plattform für Unternehmen und Entwickler. Unsere hohe Sicherheit und unser engagierter Kundenerfolg stellen sicher, dass Unternehmen bestens für den Einsatz von KI-Agenten auf Unternehmensniveau ausgestattet sind.

Durch die effektive Konfiguration von Autonomen Knoten mit passenden Prompts und Tool-Definitionen können Organisationen intelligente Agenten erstellen, die Nutzerinteraktionen eigenständig bearbeiten.

Jetzt starten. Kostenlos.

FAQs

1. Benötige ich Programmierkenntnisse, um Autonome Knoten zu nutzen?

Sie benötigen keine Programmierkenntnisse, um Autonome Knoten in Botpress zu verwenden. Sie sind für die Low-Code-Entwicklung konzipiert, sodass Sie mit Logikbausteinen und visuellen Tools funktionsfähige KI-Agenten erstellen können.

2. Kann ein autonomer Knoten direkt mit externen APIs oder Datenbanken interagieren?

Ja, ein Autonomer Knoten kann über Botpress-Tools wie benutzerdefinierte Subflows oder API-Aufrufe mit externen APIs oder Datenbanken interagieren. Sie können sichere Endpunkte definieren und Parameter übergeben, um während des Gesprächs Daten abzurufen oder zu speichern.

3. Können autonome Knoten in mobile Apps oder Drittanbieter-Plattformen eingebettet werden?

Ja, Autonome Knoten können nach der Bereitstellung Ihres Bots in mobile Apps oder Drittanbieter-Plattformen eingebettet werden. Botpress unterstützt die Bereitstellung auf mehreren Kanälen über SDKs und Integrationen für Plattformen wie WhatsApp, Slack, Messenger oder mobile Apps mittels Webviews oder APIs.

4. Wie geht der Knoten mit gleichzeitigen Nutzern oder hohem Verkehrsaufkommen um?

Autonome Knoten in Botpress bearbeiten gleichzeitige Nutzer, indem jede Sitzung unabhängig im Speicher ausgeführt wird, was individuelle Gespräche ermöglicht. Bei hohem Traffic sollten Sie die Ressourcennutzung überwachen und Logik sowie API-Aufrufe optimieren, um geringe Latenz und hohe Verfügbarkeit sicherzustellen.

5. Gibt es Schutzmechanismen, um zu verhindern, dass ein autonomer Knoten sensible Informationen weitergibt?

Ja, Sie können strenge Schutzmechanismen konfigurieren, indem Sie den Zugriff auf Tools einschränken und Prompts anpassen, um zu verhindern, dass ein Autonomer Knoten sensible Informationen teilt. Zusätzlich nutzt Botpress LLMs mit integrierten Sicherheitsmechanismen, um die Einhaltung von Richtlinien zu unterstützen.

.webp)