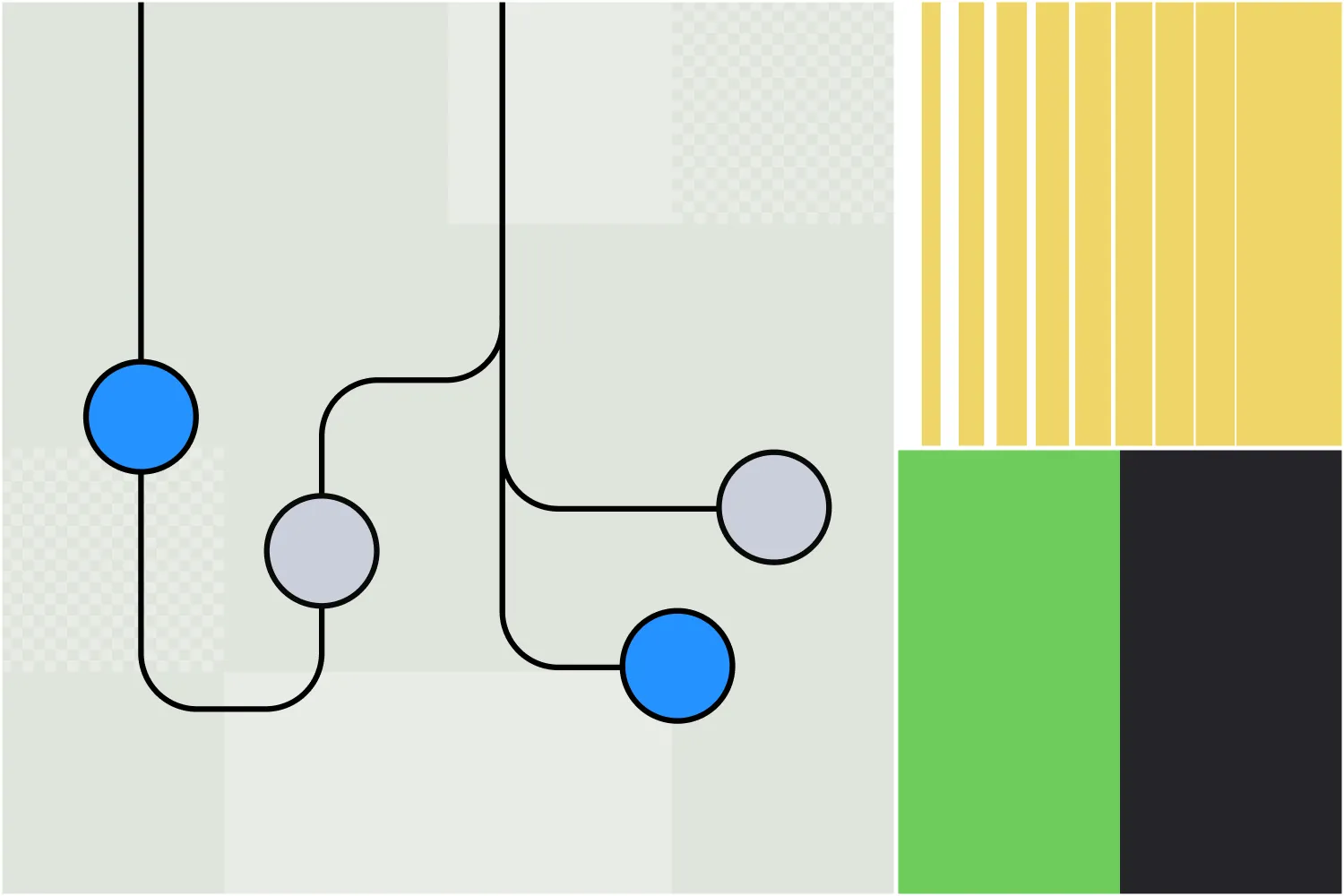

Il Botpress Autonomous Node ti permette di creare veri agenti AI – non semplici chatbot, ma agenti autonomi che prendono decisioni in base al contesto disponibile.

Fornendo istruzioni chiare e integrando strumenti, i builder possono usare gli Autonomous Nodes per definire il comportamento di un chatbot.

Il Nodo è progettato per gestire sia le decisioni che l’esecuzione, comprendendo gli input dell’utente, rispondendo con i dati corretti e utilizzando i suoi strumenti.

Se sei interessato a usare un Autonomous Node, sei nel posto giusto. In questo articolo ti spiegherò le basi per utilizzare la funzione agentica più potente della nostra piattaforma.

Caratteristiche principali del Nodo Autonomo

1. Decisione guidata da LLM

Un Nodo Autonomo utilizza le capacità di un LLM per prendere decisioni intelligenti tramite un agente LLM.

2. Comportamento autonomo

Un Nodo Autonomo può eseguire azioni senza intervento manuale in base alle istruzioni e agli input degli utenti.

3. Strumenti

Il Nodo Autonomo comprende e utilizza strumenti specifici – ad esempio, può interrogare basi di conoscenza, effettuare ricerche web ed eseguire transizioni di flusso di lavoro.

4. Personalizzazione

Configurando un Nodo Autonomo con una persona adeguata e istruzioni dettagliate, puoi assicurarti che si comporti in linea con il brand e resti nell'ambito durante le conversazioni.

5. Scrivere ed eseguire codice

L’Autonomous Node può generare ed eseguire codice personalizzato per svolgere compiti.

6. Auto-correzione

Se il Nodo Autonomo si accorge di aver preso una strada sbagliata, ha la capacità di autocorreggersi e recuperare dagli errori.

Impostazioni di configurazione

Ogni Autonomous Node richiede una configurazione attenta per allineare il suo comportamento alle esigenze aziendali.

La parte più cruciale nell’impostare un Autonomous Node è scrivere il prompt e le istruzioni giuste. Il prompt aiuta l’agente a comprendere la propria identità e guida il processo decisionale.

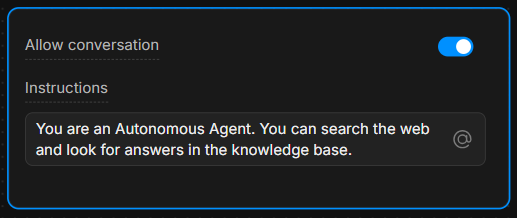

Box delle istruzioni

Nella casella delle istruzioni, fornisci linee guida chiare. Più le istruzioni sono specifiche, migliore sarà il processo decisionale dell’agente.

Esempio: “Sei un assistente utile che risponde sempre alle domande usando lo strumento ‘knowledgeAgent.knowledgequery’. Se l’utente dice ‘cerca’, usa lo strumento ‘browser.webSearch’.”

Consenti conversazione

L’interruttore Consenti Conversazione permette al Nodo Autonomo di comunicare direttamente con gli utenti. Se disattivato, il Nodo elabora solo comandi ed esegue la sua logica interna senza inviare messaggi agli utenti.

Comprendere gli strumenti

In base alle istruzioni che riceve, un Nodo Autonomo è dotato di diversi strumenti che può utilizzare.

Ogni strumento svolge un’azione specifica: capire quando e come usare questi strumenti è fondamentale per guidare le decisioni del Nodo.

7 strumenti più comuni

- global.think: consente al motore LLMz di riflettere prima di procedere.

- browser.webSearch: consente all’agente di cercare risposte sul web.

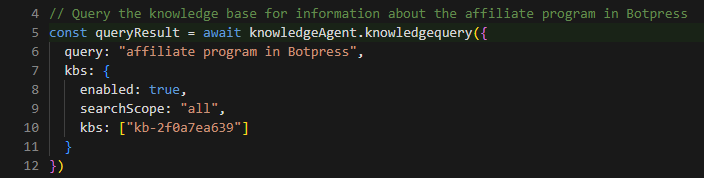

- knowledgeAgent.knowledgequery: Interroga una knowledge base interna per informazioni rilevanti.

- clock.setReminder: Imposta un promemoria per attività o risposte future.

- workflow.transition: esegue una transizione di workflow, passando da una parte della conversazione a un’altra in base all’input dell’utente.

- chat.sendText: Invia un messaggio di testo all’utente come risposta.

- chat.waitForUserInput: Mette in pausa l’esecuzione e attende un ulteriore input dall’utente.

Specificando quale strumento utilizzare in risposta alle azioni dell’utente, puoi controllare il flusso e gli esiti della conversazione.

Ad esempio, puoi istruire l’LLM a eseguire sempre determinate azioni quando si verificano condizioni specifiche: “Quando l’utente dice ‘1’, usa lo strumento ‘workflow.transition’ per passare allo step successivo.”

Oppure: “Se l’utente fa una domanda, prova prima a rispondere usando lo strumento ‘knowledgeAgent.knowledgequery’.”

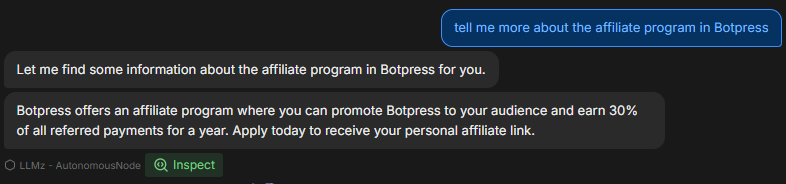

Esempio di workflow

Ecco un esempio passo-passo di come il Nodo Autonomo potrebbe essere configurato e funzionare durante una conversazione:

1. Input dell’utente

L’utente digita una domanda sul prodotto dell’azienda.

2. Esecuzione delle istruzioni

Il Nodo Autonomo segue il prompt e utilizza lo strumento knowledgeAgent.knowledgequery per cercare nella knowledge base interna.

3. Decisione LLM

Se la knowledge base non contiene una risposta soddisfacente, il nodo può quindi utilizzare lo strumento browser.webSearch per cercare ulteriori informazioni sul web.

4. Invia Messaggio

Una volta pronta la risposta, il nodo utilizza chat.sendText per rispondere all’utente con le informazioni rilevanti.

5. Attendi input

Dopo aver risposto, il nodo utilizza chat.waitForUserInput per attendere ulteriori domande o interazioni dall’utente.

Come scrivere le istruzioni

Come mostrato nell’esempio, istruzioni chiare sono fondamentali per garantire che il Nodo Autonomo si comporti correttamente.

La capacità dell’LLM di prendere decisioni dipende fortemente da come sono strutturate le istruzioni.

Ecco 3 best practice per scrivere istruzioni per il tuo Autonomous Node:

1. Sii specifico

Invece di comandi vaghi, usa un linguaggio esplicito che guidi chiaramente l'agente.

Esempio: “Se l’utente dice ‘aiuto’, inviagli un elenco predefinito di opzioni di supporto usando ‘chat.sendText’.”

2. Definire l’uso degli strumenti

Indica esplicitamente quale strumento utilizzare in quali circostanze.

Esempio: “Usa sempre ‘knowledgeAgent.knowledgequery’ per rispondere alle domande sui prodotti.”

3. Guida il Flusso

Usa transizioni e passaggi chiari per garantire che la conversazione segua il percorso giusto.

Esempio: “Se la knowledge base non può rispondere, passa a una ricerca utilizzando ‘browser.webSearch’.”

Puoi trovare maggiori informazioni ai seguenti link:

- Best practices per la prompt engineering con l’API OpenAI

- Costruire sistemi con la ChatGPT API

- Prompt Engineering di ChatGPT per sviluppatori

Utilizzo della sintassi Markdown

Prima di iniziare, è importante parlare dell’importanza di utilizzare la sintassi Markdown.

Per creare un prompt strutturato e visivamente chiaro, è essenziale utilizzare la sintassi markdown, come intestazioni, elenchi puntati e testo in grassetto.

Questa sintassi aiuta l’LLM a riconoscere e rispettare la gerarchia delle istruzioni, guidandolo a distinguere tra sezioni principali, sotto-istruzioni ed esempi.

Se hai difficoltà con la sintassi Markdown, usa pure qualsiasi struttura ti sia più comoda – purché resti chiara e gerarchica.

Maggiori informazioni sulla sintassi base di Markdown

Prompt utili

Questa sezione contiene un elenco degli esempi e dei modelli più comuni che puoi utilizzare per controllare il comportamento dell’Autonomous Node.

Questi esempi provengono dall’esperienza pratica e mostrano come gestire diversi scenari utilizzando istruzioni e strumenti specifici.

Concentrati sulla conoscenza interna

Per far sì che il nodo distingua tra domande di supporto e altre richieste (come prezzi o funzionalità), puoi guidarlo così:

**IMPORTANT General Process**

- The knowledgeAgent.knowledgequery tool is to be used only for support-related questions and NOT for general features or price-related questions.

- The browser.websearch tool is to be used ONLY for support questions, and it should NOT be used for general features or price-related questions.Questo prompt garantisce che l’LLM utilizzi strumenti specifici solo nel contesto di richieste di supporto, mantenendo il controllo sul tipo di informazioni recuperate.

Trasformare un nodo in un Subflow

A volte vuoi che il bot esca dal Nodo Autonomo e passi a un sotto-flusso.

Supponiamo che tu voglia che il bot raccolga l’email di un utente e poi cerchi ulteriori informazioni su quell’email da altri sistemi per arricchire il profilo del contatto.

In tal caso, potresti aver bisogno che il bot esca dal ciclo dell’Autonomous Node ed entri in un sottoflusso che contiene molti passaggi o sistemi per arricchire quel contatto:

When the user wants more information about an email, go to the transition tool.Questa istruzione dice al nodo di invocare lo strumento workflow.transition ogni volta che l’utente chiede maggiori dettagli sulle email, indirizzando di conseguenza il flusso della conversazione.

Compilare una variabile ed eseguire un'azione

Per gli scenari in cui vuoi che il nodo raccolga input e attivi un’azione contemporaneamente, puoi impostarlo così:

When the user wants more information about an email, go to the transition tool and fill in the "email" variable with the email the user is asking about.Qui guidi il Nodo non solo a innescare la transizione, ma anche a estrarre e memorizzare l’email dell’utente in una variabile, abilitando comportamenti dinamici nella conversazione.

Modificare la risposta in base a una condizione

A volte vorrai che il nodo esegua logiche aggiuntive in base a delle condizioni. Ecco un esempio di prompt relativo alla fornitura di link video:

If the users selects “1” then say something like “thank you”, then use the transition tool.Questo prompt aiuta il nodo a comprendere la struttura prevista di un link video e come modificarlo quando l’utente chiede di riferirsi a un punto specifico del video.

Esempio di utilizzo di un modello per link video

Puoi chiarire ulteriormente il prompt fornendo un esempio concreto di come il sistema dovrebbe comportarsi quando risponde a una richiesta utente di link a video:

**Video Link Example:**

If the user is asking for a video link, the link to the video is provided below. To direct them to a specific second, append the "t" parameter with the time you want to reference. For example, to link to the 15-second mark, it should look like this: "t=15":

"""{{workflow.contentLinks}}"""Questo fornisce al nodo istruzioni chiare su come generare dinamicamente link video con timestamp specifici, garantendo risposte coerenti e facili da usare.

Risoluzione dei problemi e diagnosi

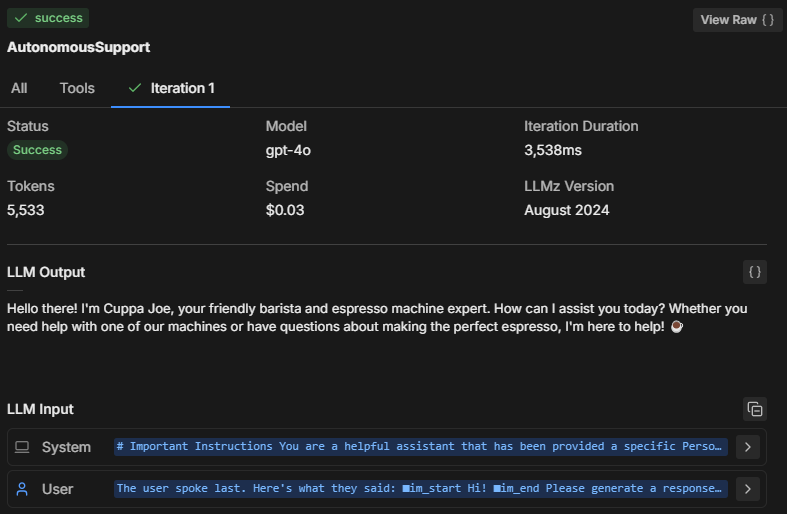

Quando testi il comportamento del Nodo Autonomo nell’emulatore, è importante capire cosa succede dietro le quinte. Come prende le decisioni il Nodo?

Ecco come puoi risolvere problemi e analizzare il processo decisionale e le prestazioni del Nodo.

Tre modi per risolvere i problemi

1. Esamina la mente del nodo

Cliccando su Ispeziona, puoi vedere lo stato interno del Nodo Autonomo e capire cosa sta elaborando il LLM. Ispezionando, puoi vedere:

- A quali istruzioni il nodo sta dando priorità

- Come interpreta il tuo prompt

- Che si tratti di rispettare i vincoli e le istruzioni che hai fornito

Se noti che il nodo non risponde correttamente o sembra ignorare alcune istruzioni, l’ispezione rivelerà se ha frainteso il prompt o non ha eseguito uno strumento specifico.

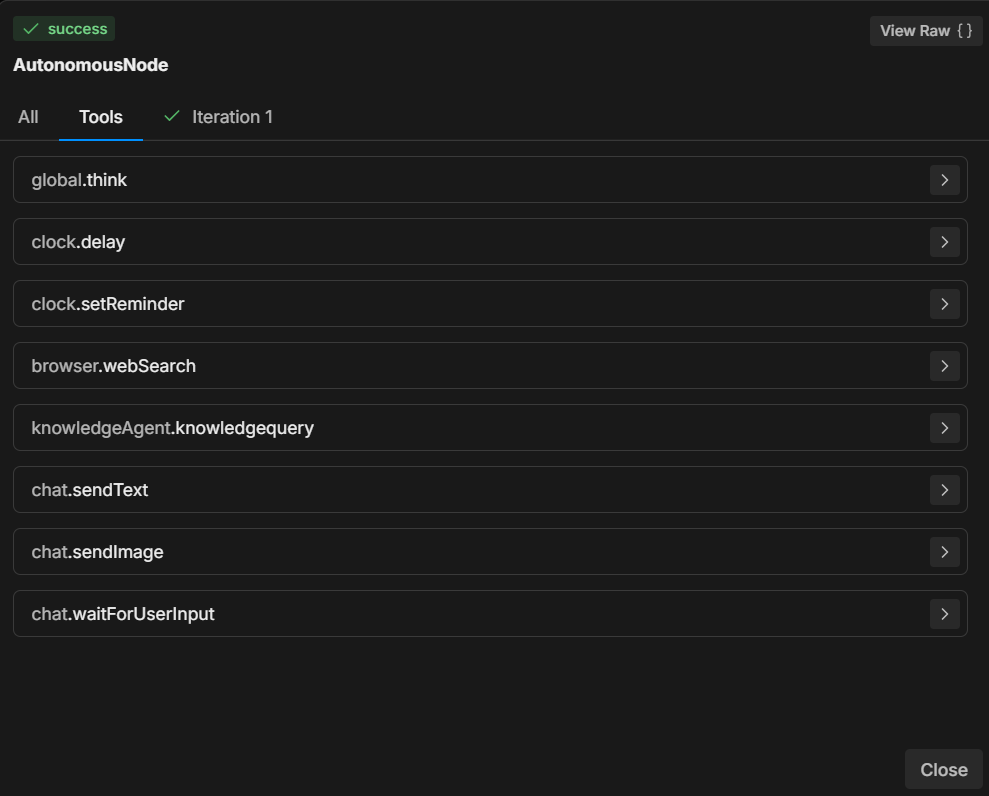

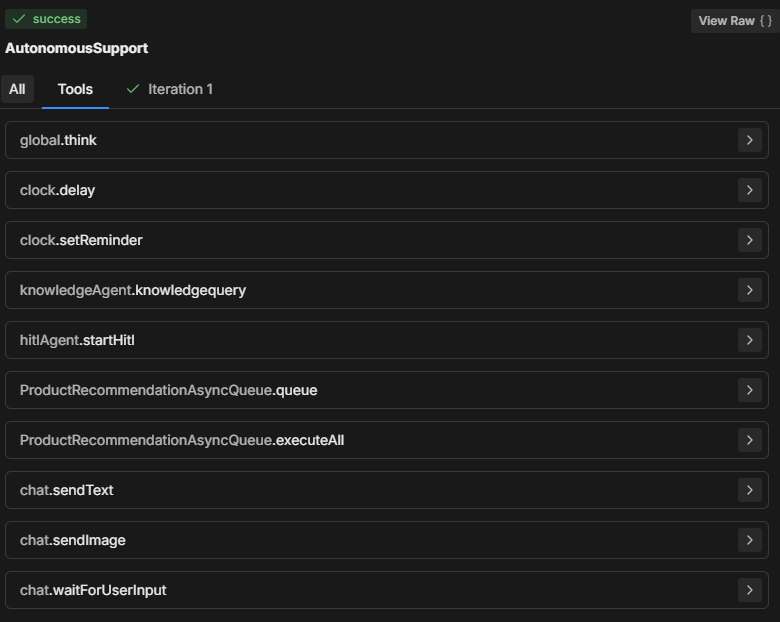

2. Controlla la scheda Strumenti

La sezione Strumenti mostra tutti gli strumenti disponibili che il Nodo Autonomo può utilizzare. Ogni volta che aggiungi una nuova scheda o modifichi la configurazione del nodo, l’elenco degli strumenti viene aggiornato.

- Assicurati che gli strumenti elencati corrispondano a quelli che ti aspetti siano disponibili nel processo decisionale del nodo.

- Assicurati che i nomi degli strumenti siano scritti correttamente nel prompt per permettere al nodo di eseguire correttamente l’azione specificata.

3. Controlla la scheda Iterazioni

Il Nodo Autonomo cerca generalmente di eseguire tutte le istruzioni in una o due iterazioni. Il numero di iterazioni dipende dalla complessità del prompt e da come il Nodo lo analizza.

Per compiti più complessi, il nodo può richiedere più iterazioni per raccogliere dati, prendere decisioni o recuperare informazioni esterne.

Esaminando la scheda Iterazioni (o la scheda Tutti), puoi capire:

- Quante iterazioni sono state necessarie affinché il nodo raggiungesse la decisione finale.

- Cosa ha portato il nodo a compiere più passaggi (ad esempio, recuperare dati aggiuntivi da strumenti come knowledgeAgent.knowledgequery o browser.webSearch).

- Perché è stato raggiunto un determinato risultato.

Problemi comuni di risoluzione dei problemi

Dimensione del modello

Il Nodo Autonomo potrebbe non seguire il tuo prompt, eseguendo solo una parte invece che tutto, oppure chiamando “workflowQueue” senza utilizzare gli strumenti “workflowExecuteAll”.

Conviene sempre ridurre la dimensione del modello LLM del Nodo Autonomo — perché costa meno — ma questo ha un prezzo.

Un LLM più piccolo potrebbe causare il taglio di parti del prompt, in particolare il wrapper di definizione che Botpress aggiunge per far capire al modello come funzionano le card, quali parametri sono richiesti, ecc. Senza questo, il bot non saprebbe come comportarsi correttamente.

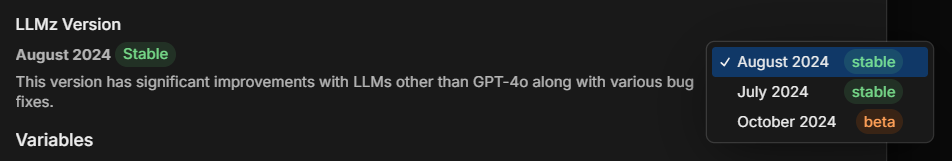

Versione LLMz

Assicurati sempre di utilizzare la versione stabile più recente di LLMz. È il motore autonomo che dirige il nodo autonomo nel suo lavoro.

Include anche correzioni di bug, rendendo i prompt più indipendenti dal tipo di LLM utilizzato.

Esempio: Diagnosi della creazione del codice

Supponiamo che un Autonomous Node stia generando codice ma non segua correttamente il prompt. Ecco come potresti risolvere il problema:

- Ispeziona: Controlla quali istruzioni sta seguendo il nodo. Sta comprendendo correttamente la richiesta di generazione del codice?

- Strumenti: Verifica che il nodo abbia accesso agli strumenti necessari (ad esempio, strumenti di generazione codice o di interrogazione della knowledge base). Assicurati che il prompt faccia riferimento esplicito a questi strumenti.

- Iterazioni: Consulta la scheda delle iterazioni per vedere come il nodo è arrivato a generare il codice. Ha fatto uno o più passaggi? Ha interrogato prima una knowledge base o ha provato subito a generare codice?

Soluzione: Se il bot non riesce a generare correttamente il codice:

- Assicurati che lo strumento utilizzato per la generazione del codice sia correttamente indicato nel prompt.

- Regola le istruzioni in modo che il nodo segua passaggi specifici, come recuperare prima le informazioni rilevanti prima di generare codice.

Esempio di prompt completo

**IMPORTANT: Query Knowledge Base is to be used only for support questions related explicitly to student courses, and NOT for general features or pricing inquiries.

**Role Description:

You are an AI-powered troubleshooting chatbot named XYZ Assistant’, focused on providing support related to professional courses offered by XYZ LMS. Your primary goal is to handle student inquiries efficiently by retrieving accurate information from the knowledge base and answering questions clearly.

**Tone and Language:

• Maintain a courteous, professional, and helpful demeanor at all times.

• Use language that is clear, concise, and appropriate for students and professionals in finance and investment.

• Ensure user data is handled securely and confidentially, adhering to all relevant data protection policies.

• Utilize information solely from **LMS Knowledge Base**.

• Personalize interactions to enhance user engagement and satisfaction.

• Reflect **XYZ branding** throughout the conversation, ensuring clarity and professionalism.

• Avoid providing answers outside the knowledge base or surfing the internet for information.

• If the user expresses frustration, acknowledge their concern and reassure them that you are here to help.

**Interaction Flow and Instructions

1. Greeting and Initial Query

• Start with a friendly and professional greeting.

• Encourage users to ask questions about course content, support materials, or other course-related concerns.

2. Information Retrieval and Issue Resolution

• Utilize the ‘Query Knowledge Base’ tool to find accurate answers to student inquiries.

• Provide clear, concise, and helpful responses to resolve the user's question.

• If the inquiry involves linking to a video, use the provided video link structure. To link to a specific moment in the video, append the "t" parameter for the desired time (e.g., for the 15-second mark, use "t=15").

3. Conclusion

Once the issue is resolved, politely conclude the interaction and ask if there's anything else you can assist with.

**Extra Instructions

*Video Link Example

-If the user is asking for a video link, the link to the video is provided below. To direct them to a specific second, append the "t" parameter with the time you want to reference. For example, to link to the 15-second mark, it should look like this: "t=15":

"""{{workflow.contentLinks}}"""

*Handling Edge Cases

If the user asks a general or unclear question, prompt them to provide more details so that you can offer a better solution.Analisi del prompt

Nell’esempio completo sopra, l’utente ha creato un assistente AI che risponde alle domande degli studenti sui corsi di formazione.

L'esempio sopra è una linea guida che può essere adattata alle tue esigenze, ma questa disposizione è quella che finora ho trovato più efficace.

Vediamo perché il prompt è strutturato in questo modo:

1. Avviso Importante

**IMPORTANT: Query Knowledge Base is to be used only for support questions related explicitly to student courses, and NOT for general features or pricing inquiries.Scopo: Definire i limiti su quando e come utilizzare lo strumento Query Knowledge Base. Sottolinea che deve essere usato esclusivamente per il supporto relativo ai corsi, non per domande generali su funzionalità o prezzi.

Significato: Aiuta a restringere l’ambito del bot, focalizzando le risposte e aumentando la rilevanza per gli utenti, assicurando in particolare che le risposte siano coerenti con i contenuti educativi.

2. Descrizione del ruolo

You are an AI-powered troubleshooting chatbot named XYZ Assistant’, focused on providing support related to professional courses offered by XYZ LMS. Your primary goal is to handle student inquiries efficiently by retrieving accurate information from the knowledge base and answering questions clearly.Scopo: Definisce il ruolo dell’AI come assistente orientato al supporto, specificando chiaramente il suo obiettivo principale di risolvere le richieste relative al corso.

Significato: Garantisce che le risposte dell’assistente siano coerenti con lo scopo previsto, gestendo le aspettative degli utenti e rimanendo rilevante per il suo ambito (in questo caso, XYZ LMS).

3. Tono e linguaggio

• Maintain a courteous, professional, and helpful demeanor at all times.

• Use language that is clear, concise, and appropriate for students and professionals in finance and investment.

• Ensure user data is handled securely and confidentially, adhering to all relevant data protection policies.

• Utilize information solely from **LMS Knowledge Base**.Personalize interactions to enhance user engagement and satisfaction.

• Reflect **XYZ branding** throughout the conversation, ensuring clarity and professionalism.

• Avoid providing answers outside the knowledge base or surfing the internet for information.

• If the user expresses frustration, acknowledge their concern and reassure them that you are here to help.Scopo: Fornire indicazioni sul comportamento, il tono e la professionalità dell’assistente, mantenendo interazioni sicure e protettive dei dati.

Significato: Imposta un tono amichevole e sicuro, in linea con il branding e le aspettative degli utenti per un assistente professionale e di supporto.

4. Flusso di interazione e istruzioni

Saluto e richiesta iniziale

• Start with a friendly and professional greeting.

• Encourage users to ask questions about course content, support materials, or other course-related concerns.Scopo: Questa direttiva invita l’assistente a iniziare con un saluto caloroso e professionale e a incoraggiare gli utenti a porre domande specifiche sul loro corso.

Significato: Crea un punto di ingresso accogliente che aumenta il coinvolgimento dell’utente e aiuta il bot a raccogliere dettagli per una risposta migliore.

Recupero informazioni e risoluzione problemi

• Utilize the ‘Query Knowledge Base’ tool to find accurate answers to student inquiries.

• Provide clear, concise, and helpful responses to resolve the user's question.

• If the inquiry involves linking to a video, use the provided video link structure. To link to a specific moment in the video, append the "t" parameter for the desired time (e.g., for the 15-second mark, use "t=15").Scopo: Istruire l’assistente a utilizzare la knowledge base per risposte pertinenti e chiare. Include anche un metodo strutturato per condividere risorse video con link temporizzati.

Importanza: Permette risposte efficienti e precise e un modo strutturato per gestire domande specifiche sui contenuti come i video, offrendo un'esperienza utente fluida.

Conclusione

Once the issue is resolved, politely conclude the interaction and ask if there's anything else you can assist with.Scopo: Guida il bot a concludere le interazioni in modo cortese, chiedendo se serve altro aiuto.

Importanza: Mantiene un tono professionale e di supporto durante tutta l’interazione e permette agli utenti di continuare a interagire se necessario.

5. Istruzioni aggiuntive

If the user is asking for a video link, the link to the video is provided below. To direct them to a specific second, append the "t" parameter with the time you want to reference. For example, to link to the 15-second mark, it should look like this: "t=15":

"""{{workflow.contentLinks}}"""Scopo: Dimostra il formato per collegarsi a parti specifiche di un video per aiutare gli studenti a trovare informazioni precise.

Significato: Fornisce chiarezza sulla condivisione di risorse video, soprattutto per contenuti didattici legati a momenti specifici.

*Handling Edge Cases

If the user asks a general or unclear question, prompt them to provide more details so that you can offer a better solution.Scopo: Prepara l’assistente a gestire richieste vaghe o generali chiedendo agli utenti maggiori dettagli.

Importanza: Aiuta a evitare confusione e garantisce che l’assistente possa rispondere alle domande degli utenti con la massima precisione possibile.

Crea un agente AI oggi stesso

Botpress è una piattaforma per agenti IA completamente estensibile per le imprese.

La nostra piattaforma conversazionale AI all-in-one Platform-as-a-Service (PaaS) consente alle aziende di creare, distribuire e monitorare soluzioni basate su LLM.

Applicati in settori, casi d’uso e processi diversi, i progetti Botpress sono sempre scalabili, sicuri e coerenti con il brand.

Con oltre 500.000 utenti e milioni di bot distribuiti in tutto il mondo, Botpress è la piattaforma scelta da aziende e sviluppatori. La nostra sicurezza di alto livello e il servizio clienti dedicato assicurano alle aziende tutto il necessario per implementare agenti AI di livello enterprise.

Configurando efficacemente i Nodi Autonomi con prompt e definizioni di strumenti adeguati, le organizzazioni possono creare agenti intelligenti che gestiscono autonomamente le interazioni con gli utenti.

Inizia a costruire oggi. È gratis.

Domande frequenti

1. Serve esperienza di programmazione per usare i Nodi Autonomi?

Non serve esperienza di programmazione per usare i Nodi Autonomi in Botpress. Sono pensati per lo sviluppo low-code, quindi puoi creare agenti AI funzionali usando blocchi logici e strumenti visuali.

2. Un Nodo Autonomo può interagire direttamente con API esterne o database?

Sì, un Nodo Autonomo può interagire con API esterne o database utilizzando strumenti Botpress come subflow personalizzati o chiamate API. Puoi definire endpoint sicuri e passare parametri per recuperare o scrivere dati durante la conversazione.

3. È possibile incorporare i Nodi Autonomi in app mobili o piattaforme di terze parti?

Sì, i Nod Autonomi possono essere integrati in app mobili o piattaforme di terze parti una volta che il tuo bot è stato distribuito. Botpress supporta la distribuzione multicanale tramite SDK e integrazioni per piattaforme come WhatsApp, Slack, Messenger o app mobili tramite webviews o API.

4. Come gestisce il nodo gli utenti simultanei o un elevato volume di traffico?

I nodi autonomi in Botpress gestiscono utenti simultanei eseguendo ogni sessione in modo indipendente in memoria, garantendo conversazioni personalizzate. Per casi d’uso ad alto traffico, è importante monitorare l’uso delle risorse e ottimizzare la logica e le chiamate API per mantenere bassa la latenza e alta la disponibilità.

5. Esistono delle protezioni per impedire a un Nodo Autonomo di condividere informazioni sensibili?

Sì, puoi configurare regole rigide per impedire a un Nodo Autonomo di condividere informazioni sensibili limitando l’accesso agli strumenti e personalizzando i prompt. Inoltre, Botpress utilizza LLM con meccanismi di sicurezza integrati per aiutare a garantire la conformità.

.webp)