Le Nœud Autonome de Botpress vous permet de créer de véritables agents IA – il ne s'agit pas de simples chatbots, mais d'agents autonomes capables de prendre des décisions en fonction du contexte disponible.

En fournissant des instructions claires et en intégrant des outils, les créateurs de bots peuvent utiliser les Nœuds Autonomes pour définir le comportement d’un chatbot.

Le Nœud est conçu pour gérer à la fois la prise de décision et l’exécution : il comprend les demandes des utilisateurs, répond avec les bonnes données et utilise ses outils à bon escient.

Si vous souhaitez utiliser un Nœud Autonome, vous êtes au bon endroit. Dans cet article, je vais poser les bases pour exploiter cette fonctionnalité phare de notre plateforme.

Fonctionnalités clés du Nœud Autonome

1. Décision basée sur un LLM

Un Nœud Autonome utilise les capacités d’un LLM pour prendre des décisions intelligentes via un agent LLM.

2. Comportement autonome

Un Nœud Autonome peut exécuter des actions sans intervention humaine, selon les instructions et les entrées utilisateur.

3. Outils

Le Nœud Autonome comprend et utilise des outils spécifiques : par exemple, il peut interroger des bases de connaissances, effectuer des recherches web ou lancer des transitions de workflow.

4. Personnalisation

En configurant un Nœud Autonome avec une persona adaptée et des instructions détaillées, vous vous assurez qu’il reste cohérent avec votre marque et dans le périmètre défini lors des conversations.

5. Générer et exécuter du code

Le Nœud Autonome peut générer et exécuter du code personnalisé pour accomplir des tâches.

6. Auto-correction

Si le Nœud Autonome s’engage dans une mauvaise direction, il est capable de se corriger et de se remettre d’une erreur.

Paramètres de configuration

Chaque Nœud Autonome doit être configuré avec soin pour aligner son comportement sur les besoins métier.

L’étape la plus importante lors de la configuration d’un Nœud Autonome est la rédaction du bon prompt et des instructions. Le prompt aide l’agent à comprendre sa persona et oriente ses prises de décision.

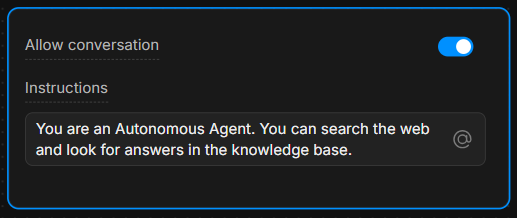

Boîte d’instructions

Dans la boîte d’instructions, fournissez des consignes claires. Plus les instructions sont précises, meilleures seront les décisions de l’agent.

Exemple : « Vous êtes un assistant utile qui répond toujours aux questions en utilisant l’outil ‘knowledgeAgent.knowledgequery’. Si l’utilisateur dit ‘recherche’, utilisez l’outil ‘browser.webSearch’. »

Autoriser la conversation

L’option Autoriser la conversation permet au Nœud Autonome d’échanger directement avec les utilisateurs. Si elle est désactivée, le Nœud traite uniquement les commandes et exécute sa logique interne sans envoyer de messages aux utilisateurs.

Comprendre les outils

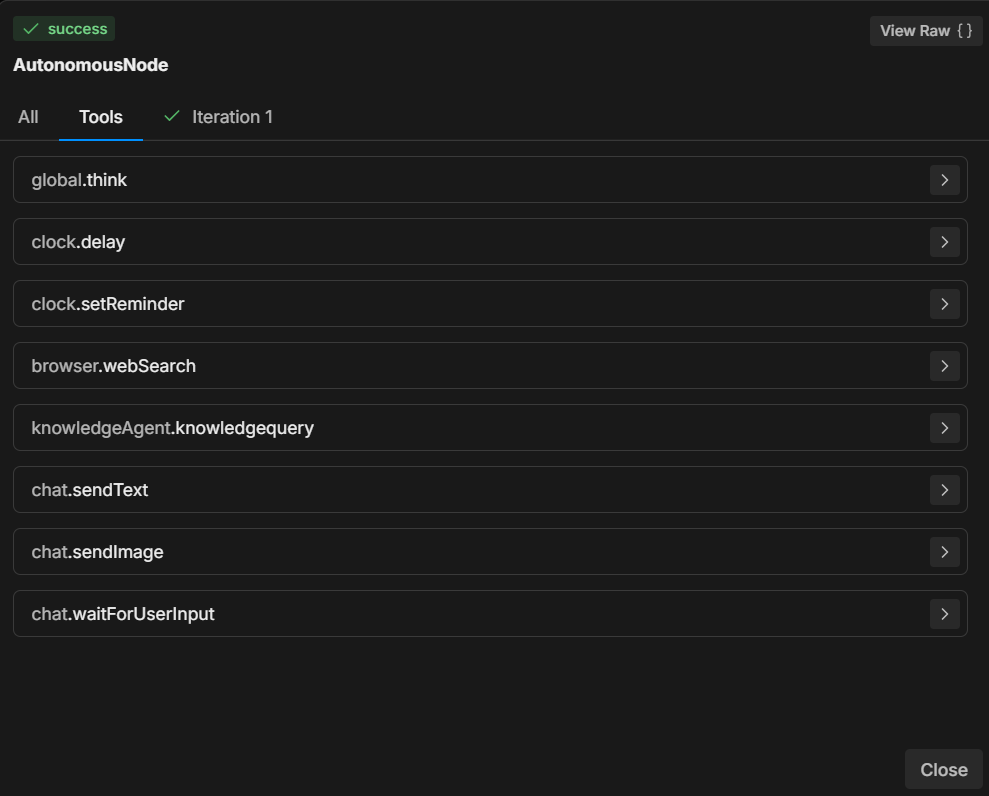

Selon les instructions données, un Nœud Autonome dispose de plusieurs outils qu’il peut utiliser.

Chaque outil réalise une action précise – savoir quand et comment les utiliser est essentiel pour orienter les décisions du Nœud.

7 outils les plus courants

- global.think : Permet au moteur LLMz de réfléchir avant de poursuivre.

- browser.webSearch : Autorise l’agent à rechercher des réponses sur le web.

- knowledgeAgent.knowledgequery : Interroge une base de connaissances interne pour obtenir des informations pertinentes.

- clock.setReminder : Définit un rappel pour des tâches ou réponses futures.

- workflow.transition : Effectue une transition de workflow, passant d’une étape de la conversation à une autre selon l’entrée utilisateur.

- chat.sendText : Envoie un message texte à l’utilisateur en guise de réponse.

- chat.waitForUserInput : Met en pause l’exécution et attend une nouvelle entrée de l’utilisateur.

En précisant quel outil utiliser selon l’action de l’utilisateur, vous contrôlez le déroulement et les résultats de la conversation.

Par exemple, vous pouvez demander au LLM d’effectuer systématiquement certaines actions lorsque des conditions précises sont réunies : « Quand l’utilisateur dit ‘1’, utilisez l’outil ‘workflow.transition’ pour passer à l’étape suivante. »

Ou : « Si l’utilisateur pose une question, essayez d’abord d’y répondre avec l’outil ‘knowledgeAgent.knowledgequery’. »

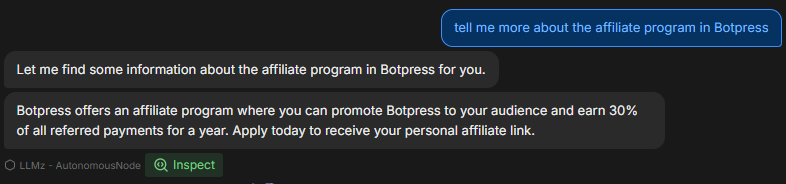

Exemple de workflow

Voici un exemple étape par étape de configuration et de fonctionnement d’un Nœud Autonome lors d’une conversation :

1. Entrée utilisateur

L’utilisateur saisit une question sur le produit de l’entreprise.

2. Exécution des instructions

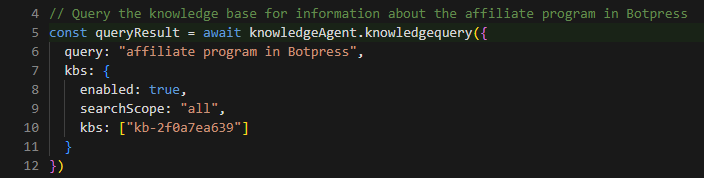

Le Nœud Autonome suit le prompt et utilise l’outil knowledgeAgent.knowledgequery pour interroger la base de connaissances interne.

3. Décision du LLM

Si la base de connaissances ne fournit pas de réponse satisfaisante, le nœud peut alors utiliser l’outil browser.webSearch pour chercher des informations supplémentaires sur le web.

4. Envoi du message

Une fois la réponse prête, le nœud utilise chat.sendText pour répondre à l’utilisateur avec les informations pertinentes.

5. Attente d’une entrée

Après avoir répondu, le nœud utilise chat.waitForUserInput pour attendre d’autres questions ou interactions de l’utilisateur.

Comment rédiger les instructions

Comme illustré dans l’exemple, des instructions claires sont essentielles pour garantir le bon comportement du Nœud Autonome.

La capacité du LLM à prendre des décisions dépend fortement de la manière dont les instructions sont formulées.

Voici 3 bonnes pratiques pour rédiger les instructions de votre Nœud Autonome :

1. Soyez précis

Au lieu de commandes vagues, utilisez un langage explicite qui guide clairement l’agent.

Exemple : « Si l’utilisateur dit ‘aide’, envoyez-lui une liste prédéfinie d’options de support via ‘chat.sendText’. »

2. Définissez l’utilisation des outils

Indiquez clairement quel outil doit être utilisé dans quelles circonstances.

Exemple : « Utilisez toujours ‘knowledgeAgent.knowledgequery’ pour répondre aux questions sur les produits. »

3. Guidez le déroulement

Utilisez des transitions et des étapes claires pour garantir que la conversation progresse dans la bonne direction.

Exemple : « Si la base de connaissances ne peut pas répondre, passez à une recherche web avec ‘browser.webSearch’. »

Vous trouverez plus d’informations aux liens suivants :

- Bonnes pratiques pour l’ingénierie de prompts avec l’API OpenAI

- Construire des systèmes avec l’API ChatGPT

- Ingénierie de prompts ChatGPT pour les développeurs

Utilisation de la syntaxe Markdown

Avant de commencer, il est important d’aborder l’intérêt d’utiliser la syntaxe Markdown.

Pour créer un prompt structuré et lisible, il est essentiel d’utiliser la syntaxe markdown : titres, listes à puces, texte en gras, etc.

Cette syntaxe aide le LLM à reconnaître et respecter la hiérarchie des instructions, ce qui lui permet de distinguer sections principales, sous-instructions et exemples.

Si vous avez du mal avec la syntaxe Markdown, utilisez alors toute structure qui vous est facile – du moment que vous restez clair et hiérarchique.

En savoir plus sur la syntaxe de base Markdown

Prompts utiles

Cette section propose une liste d’exemples et de modèles courants pour contrôler le comportement du Nœud Autonome.

Ces exemples sont issus de l’expérience pratique et montrent comment gérer différents scénarios à l’aide d’instructions et d’outils spécifiques.

Concentrez-vous sur la connaissance interne

Pour que le nœud fasse la différence entre les questions de support et d’autres demandes (tarifs, fonctionnalités…), vous pouvez l’orienter ainsi :

**IMPORTANT General Process**

- The knowledgeAgent.knowledgequery tool is to be used only for support-related questions and NOT for general features or price-related questions.

- The browser.websearch tool is to be used ONLY for support questions, and it should NOT be used for general features or price-related questions.Ce prompt garantit que le LLM utilisera uniquement certains outils dans le cadre des questions de support, ce qui permet de contrôler le type d’informations fournies.

Faire passer le nœud dans un sous-flux

Parfois, vous souhaitez que le bot quitte le Nœud Autonome pour entrer dans un sous-flux.

Supposons que vous vouliez que votre bot collecte l’email d’un utilisateur, puis recherche des informations complémentaires sur cet email dans d’autres systèmes pour enrichir la fiche contact.

Dans ce cas, il peut être nécessaire que le bot sorte de la boucle du Nœud Autonome et passe dans un sous-flux comprenant plusieurs étapes ou systèmes pour enrichir le contact :

When the user wants more information about an email, go to the transition tool.Cette instruction indique au nœud d’utiliser l’outil workflow.transition chaque fois que l’utilisateur demande plus de détails sur les emails, afin d’orienter la conversation en conséquence.

Remplir une variable et effectuer une action

Pour les cas où vous souhaitez que le nœud capture une donnée et déclenche une action en même temps, vous pouvez le lui demander ainsi :

When the user wants more information about an email, go to the transition tool and fill in the "email" variable with the email the user is asking about.Ici, vous guidez le nœud pour qu’il déclenche non seulement la transition, mais aussi pour qu’il extrait et stocke l’email de l’utilisateur dans une variable, permettant ainsi un comportement dynamique plus tard dans la conversation.

Adapter la réponse selon une condition

Parfois, vous souhaiterez que le nœud effectue une logique supplémentaire selon certaines conditions. Voici un exemple d’invite concernant la fourniture de liens vidéo :

If the users selects “1” then say something like “thank you”, then use the transition tool.Cette invite aide le nœud à comprendre la structure attendue d’un lien vidéo et la façon de le modifier lorsque l’utilisateur demande à accéder à un moment précis de la vidéo.

Exemple d’utilisation d’un modèle pour les liens vidéo

Vous pouvez préciser davantage l’invite en fournissant un exemple concret du comportement attendu du système lors d’une demande d’utilisateur pour des liens vidéo :

**Video Link Example:**

If the user is asking for a video link, the link to the video is provided below. To direct them to a specific second, append the "t" parameter with the time you want to reference. For example, to link to the 15-second mark, it should look like this: "t=15":

"""{{workflow.contentLinks}}"""Cela donne au nœud des instructions claires pour générer dynamiquement des liens vidéo avec des horodatages spécifiques, garantissant des réponses cohérentes et faciles à utiliser.

Dépannage et diagnostic

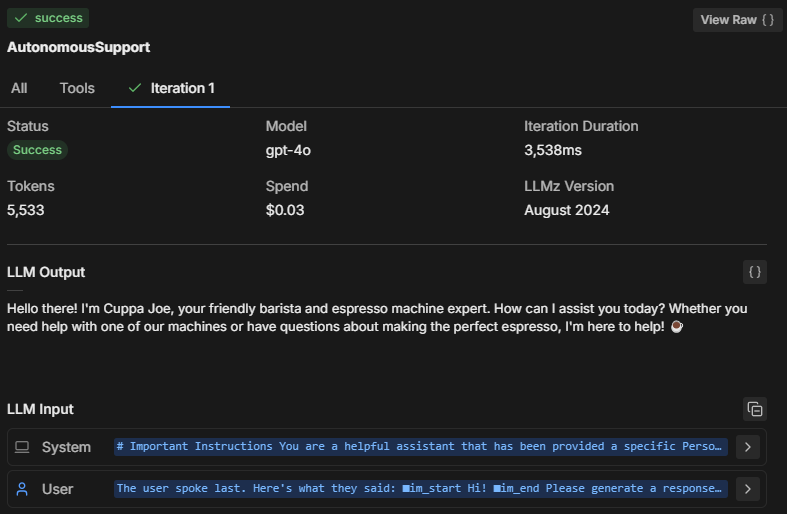

Lors des tests du comportement du nœud autonome dans l’émulateur, il est important de diagnostiquer ce qui se passe en arrière-plan. Comment le nœud prend-il ses décisions ?

Voici comment diagnostiquer et examiner le raisonnement et les performances du nœud.

Trois méthodes pour diagnostiquer

1. Inspecter l’état du nœud

En cliquant sur Inspecter, vous pouvez consulter l’état interne du nœud autonome et comprendre ce que le LLM traite. L’inspection permet de voir :

- Quelles instructions le nœud privilégie

- Comment il interprète votre invite

- S’il respecte bien les contraintes et instructions que vous avez fournies

Si vous constatez que le nœud ne répond pas correctement ou semble ignorer certaines instructions, l’inspection révélera s’il a mal compris l’invite ou s’il n’a pas exécuté un outil spécifique.

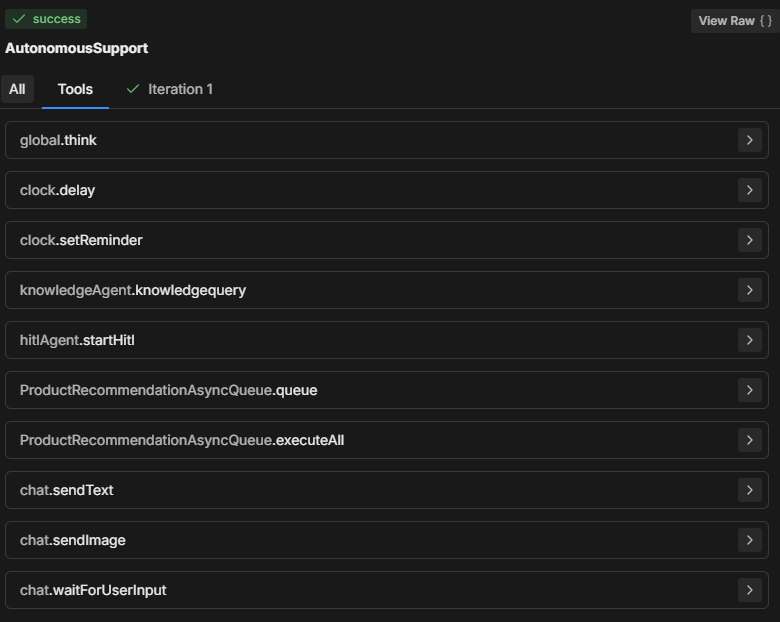

2. Vérifier l’onglet Outils

La section Outils affiche tous les outils disponibles que le nœud autonome peut utiliser. À chaque ajout de carte ou modification de la configuration du nœud, la liste des outils est mise à jour.

- Assurez-vous que les outils listés correspondent bien à ceux que vous attendez dans le processus de décision du nœud.

- Vérifiez que les noms des outils sont correctement orthographiés dans votre invite afin que le nœud puisse exécuter correctement l’action demandée.

3. Vérifiez l’onglet Itérations a

Le nœud autonome tente généralement d’exécuter toutes les instructions en une ou deux itérations. Le nombre d’itérations dépend de la complexité de l’invite et de la façon dont le nœud l’analyse.

Pour les tâches plus complexes, le nœud peut effectuer plusieurs itérations pour collecter des données, prendre des décisions ou récupérer des informations externes.

En consultant l’onglet Itérations (ou l’onglet Tout), vous pouvez comprendre :

- Combien d’itérations ont été nécessaires pour que le nœud prenne sa décision finale.

- Ce qui a poussé le nœud à effectuer plusieurs étapes (par exemple, récupérer des données supplémentaires via des outils comme knowledgeAgent.knowledgequery ou browser.webSearch).

- Pourquoi un résultat particulier a été obtenu.

Problèmes de dépannage fréquents

Taille du modèle

Le nœud autonome peut ne pas suivre votre invite, n’exécuter qu’une partie de l’invite, ou appeler « workflowQueue » sans utiliser les outils « workflowExecuteAll ».

Il est logique de toujours choisir une taille de LLM plus petite pour le nœud autonome — car c’est moins coûteux — mais cela a un impact.

Un LLM plus petit peut entraîner la coupure de certaines parties de l’invite, notamment l’enveloppe de définition ajoutée par Botpress pour que le LLM comprenne le fonctionnement des cartes, les paramètres requis, etc. Sans cela, le bot ne saurait pas comment agir correctement.

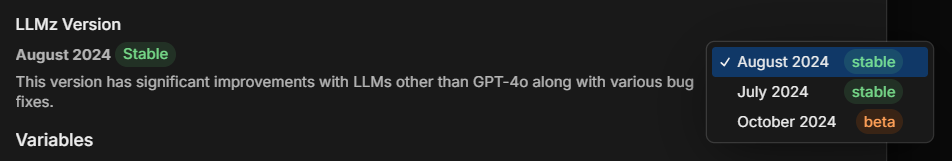

Version de LLMz

Assurez-vous toujours d’utiliser la dernière version stable de LLMz. C’est le moteur autonome qui dirige le fonctionnement du nœud autonome.

Il inclut aussi des corrections de bugs, rendant les invites plus compatibles avec différents LLM.

Exemple a: Diagnostic de la création de code

Supposons qu’un nœud autonome génère du code mais ne respecte pas correctement l’invite. Voici comment vous pourriez le diagnostiquer :

- Inspecter : Vérifiez quelles instructions le nœud suit. Comprend-il bien la demande de génération de code ?

- Outils : Vérifiez que le nœud a accès aux outils nécessaires (par exemple, outils de génération de code ou de requête à la base de connaissances). Assurez-vous que l’invite mentionne explicitement ces outils.

- Itérations : Consultez l’onglet itérations pour voir comment le nœud en est arrivé à générer le code. A-t-il effectué une ou plusieurs étapes ? A-t-il d’abord interrogé une base de connaissances ou a-t-il tenté de générer le code immédiatement ?

Solution : Si le bot n’arrive pas à générer le code correctement :

- Vérifiez que l’outil utilisé pour la génération de code est bien mentionné dans l’invite.

- Ajustez les instructions pour guider le nœud à suivre des étapes précises, comme récupérer d’abord les connaissances pertinentes avant de générer le code.

Exemple d’invite complète

**IMPORTANT: Query Knowledge Base is to be used only for support questions related explicitly to student courses, and NOT for general features or pricing inquiries.

**Role Description:

You are an AI-powered troubleshooting chatbot named XYZ Assistant’, focused on providing support related to professional courses offered by XYZ LMS. Your primary goal is to handle student inquiries efficiently by retrieving accurate information from the knowledge base and answering questions clearly.

**Tone and Language:

• Maintain a courteous, professional, and helpful demeanor at all times.

• Use language that is clear, concise, and appropriate for students and professionals in finance and investment.

• Ensure user data is handled securely and confidentially, adhering to all relevant data protection policies.

• Utilize information solely from **LMS Knowledge Base**.

• Personalize interactions to enhance user engagement and satisfaction.

• Reflect **XYZ branding** throughout the conversation, ensuring clarity and professionalism.

• Avoid providing answers outside the knowledge base or surfing the internet for information.

• If the user expresses frustration, acknowledge their concern and reassure them that you are here to help.

**Interaction Flow and Instructions

1. Greeting and Initial Query

• Start with a friendly and professional greeting.

• Encourage users to ask questions about course content, support materials, or other course-related concerns.

2. Information Retrieval and Issue Resolution

• Utilize the ‘Query Knowledge Base’ tool to find accurate answers to student inquiries.

• Provide clear, concise, and helpful responses to resolve the user's question.

• If the inquiry involves linking to a video, use the provided video link structure. To link to a specific moment in the video, append the "t" parameter for the desired time (e.g., for the 15-second mark, use "t=15").

3. Conclusion

Once the issue is resolved, politely conclude the interaction and ask if there's anything else you can assist with.

**Extra Instructions

*Video Link Example

-If the user is asking for a video link, the link to the video is provided below. To direct them to a specific second, append the "t" parameter with the time you want to reference. For example, to link to the 15-second mark, it should look like this: "t=15":

"""{{workflow.contentLinks}}"""

*Handling Edge Cases

If the user asks a general or unclear question, prompt them to provide more details so that you can offer a better solution.Décomposition de l’invite

Dans l’invite complète ci-dessus, l’utilisateur a créé un assistant IA qui répond aux questions des étudiants sur des cours éducatifs.

L’exemple ci-dessus sert de guide et peut être adapté selon vos besoins, mais c’est la structure la plus efficace que j’ai trouvée jusqu’à présent.

Voyons pourquoi l’invite est structurée ainsi :

1. Avis important

**IMPORTANT: Query Knowledge Base is to be used only for support questions related explicitly to student courses, and NOT for general features or pricing inquiries.Objectif : Définir les limites d’utilisation de l’outil Query Knowledge Base. Il doit être utilisé uniquement pour l’assistance liée aux cours, et non pour des questions générales sur les fonctionnalités ou les tarifs.

Importance : Permet de restreindre le champ d’action du bot, de cibler ses réponses et d’assurer leur pertinence pour les utilisateurs, en particulier pour garantir que les réponses concernent bien le contenu pédagogique.

2. Description du rôle

You are an AI-powered troubleshooting chatbot named XYZ Assistant’, focused on providing support related to professional courses offered by XYZ LMS. Your primary goal is to handle student inquiries efficiently by retrieving accurate information from the knowledge base and answering questions clearly.Objectif : Définir le rôle de l’IA comme assistant orienté support, en précisant clairement que sa mission principale est de répondre aux questions liées aux cours.

Importance : Garantit que les réponses de l’assistant restent en accord avec son objectif, gère les attentes des utilisateurs et reste pertinent dans son domaine (ici, XYZ LMS).

3. Ton et langage

• Maintain a courteous, professional, and helpful demeanor at all times.

• Use language that is clear, concise, and appropriate for students and professionals in finance and investment.

• Ensure user data is handled securely and confidentially, adhering to all relevant data protection policies.

• Utilize information solely from **LMS Knowledge Base**.Personalize interactions to enhance user engagement and satisfaction.

• Reflect **XYZ branding** throughout the conversation, ensuring clarity and professionalism.

• Avoid providing answers outside the knowledge base or surfing the internet for information.

• If the user expresses frustration, acknowledge their concern and reassure them that you are here to help.Objectif : Donner des indications sur l’attitude, le ton et le professionnalisme de l’assistant tout en assurant des échanges sécurisés et respectueux des données.

Importance : Instaure un ton amical et sécurisé, en accord avec l’image de marque et les attentes des utilisateurs pour un assistant professionnel et bienveillant.

4. Déroulement de l’interaction et instructions

Accueil et première question

• Start with a friendly and professional greeting.

• Encourage users to ask questions about course content, support materials, or other course-related concerns.Objectif : Cette directive demande à l’assistant de commencer par un accueil chaleureux et professionnel, et d’encourager les utilisateurs à poser des questions précises sur leur cours.

Importance : Crée un point d’entrée accueillant qui favorise l’engagement et aide le bot à recueillir les informations nécessaires pour mieux répondre.

Recherche d’informations et résolution de problèmes

• Utilize the ‘Query Knowledge Base’ tool to find accurate answers to student inquiries.

• Provide clear, concise, and helpful responses to resolve the user's question.

• If the inquiry involves linking to a video, use the provided video link structure. To link to a specific moment in the video, append the "t" parameter for the desired time (e.g., for the 15-second mark, use "t=15").Objectif : Demander à l’assistant d’utiliser la base de connaissances pour fournir des réponses pertinentes et claires. Inclut aussi une méthode structurée pour partager des ressources vidéo avec des liens temporels.

Importance : Permet des réponses efficaces et précises, et une manière structurée de traiter les questions spécifiques au contenu comme les vidéos, pour une expérience utilisateur fluide.

Conclusion

Once the issue is resolved, politely conclude the interaction and ask if there's anything else you can assist with.Objectif : Indiquer au bot comment conclure poliment l’échange, en demandant si l’utilisateur a besoin d’aide supplémentaire.

Importance : Maintient un ton professionnel et bienveillant tout au long de l’interaction et permet à l’utilisateur de poursuivre la conversation si besoin.

5. Instructions supplémentaires

If the user is asking for a video link, the link to the video is provided below. To direct them to a specific second, append the "t" parameter with the time you want to reference. For example, to link to the 15-second mark, it should look like this: "t=15":

"""{{workflow.contentLinks}}"""Objectif : Montrer le format à utiliser pour lier une partie précise d’une vidéo afin d’aider les étudiants à trouver l’information recherchée.

Importance : Apporte de la clarté sur le partage de ressources vidéo, notamment pour les contenus pédagogiques liés à un moment précis.

*Handling Edge Cases

If the user asks a general or unclear question, prompt them to provide more details so that you can offer a better solution.Objectif : Préparer l’assistant à gérer les demandes vagues ou générales en incitant les utilisateurs à donner plus de détails.

Importance : Permet d’éviter toute confusion et garantit que l’assistant puisse répondre aux questions des utilisateurs avec le plus de précision possible.

Créez un agent IA dès aujourd’hui

Botpress est une plateforme d’agents IA entièrement extensible, conçue pour les entreprises.

Notre plateforme conversationnelle tout-en-un, proposée en mode PaaS, permet aux entreprises de créer, déployer et superviser des solutions alimentées par des LLM.

Utilisés dans tous les secteurs, pour de nombreux cas d’usage et processus métiers, les projets Botpress sont toujours évolutifs, sécurisés et fidèles à l’image de marque.

Avec plus de 500 000 utilisateurs et des millions de bots déployés dans le monde, Botpress est la plateforme privilégiée des entreprises et des développeurs. Notre sécurité de haut niveau et notre service client dédié assurent aux entreprises tous les outils nécessaires pour déployer des agents IA de niveau entreprise.

En configurant efficacement les Nœuds Autonomes avec des prompts adaptés et des outils bien définis, les organisations peuvent créer des agents intelligents capables de gérer les interactions utilisateurs de façon autonome.

Commencez à créer dès aujourd’hui. C’est gratuit.

FAQ

1. Ai-je besoin de compétences en programmation pour utiliser les Nœuds Autonomes ?

Vous n’avez pas besoin de savoir coder pour utiliser les Nœuds Autonomes dans Botpress. Ils sont conçus pour le développement low-code, ce qui vous permet de créer des agents IA fonctionnels à l’aide de blocs logiques et d’outils visuels.

2. Un nœud autonome peut-il interagir directement avec des API ou des bases de données externes ?

Oui, un Nœud Autonome peut interagir avec des API externes ou des bases de données en utilisant les outils Botpress, comme les sous-flux personnalisés ou les appels API. Vous pouvez définir des points de terminaison sécurisés et transmettre des paramètres pour récupérer ou écrire des données pendant la conversation.

3. Les Nœuds Autonomes peuvent-ils être intégrés dans des applications mobiles ou des plateformes tierces a?

Oui, les Nœuds Autonomes peuvent être intégrés dans des applications mobiles ou des plateformes tierces une fois votre bot déployé. Botpress prend en charge le déploiement multicanal via des SDK et des intégrations pour des plateformes comme WhatsApp, Slack, Messenger, ou des applications mobiles via webviews ou APIs.

4. Comment le nœud gère-t-il les utilisateurs simultanés ou un trafic important a?

Les Nœuds Autonomes de Botpress gèrent les utilisateurs simultanés en exécutant chaque session indépendamment en mémoire, ce qui garantit des conversations personnalisées. Pour les cas de fort trafic, il est important de surveiller l’utilisation des ressources et d’optimiser la logique ainsi que les appels API afin de maintenir une faible latence et une haute disponibilité.

5. Existe-t-il des garde-fous pour empêcher un Nœud Autonome de partager des informations sensibles a?

Oui, vous pouvez configurer des garde-fous stricts pour empêcher un Nœud Autonome de partager des informations sensibles en limitant l’accès aux outils et en personnalisant les prompts. De plus, Botpress utilise des LLM dotés de mécanismes de sécurité intégrés pour renforcer la conformité.

.webp)