De Botpress Autonome Node stelt je in staat om functionele AI-agenten te creëren – geen chatbots, maar autonome agenten die beslissingen nemen op basis van hun beschikbare context.

Door duidelijke instructies te geven en tools te integreren, kunnen botbouwers met Autonome Nodes het gedrag van een chatbot vormgeven.

De Node is ontworpen om zowel beslissingen te nemen als uit te voeren door gebruikersinvoer te begrijpen, met de juiste data te antwoorden en gebruik te maken van zijn tools.

Als je geïnteresseerd bent in het gebruik van een Autonome Node, ben je hier aan het juiste adres. In dit artikel leg ik de basis uit voor het gebruik van deze krachtige agent-functionaliteit van ons platform.

Belangrijkste kenmerken van de Autonome Node

1. LLM-gestuurde beslissingen

Een Autonome Node gebruikt de mogelijkheden van een LLM om intelligente beslissingen te nemen via een LLM-agent.

2. Autonoom gedrag

Een Autonome Node kan acties uitvoeren zonder handmatige tussenkomst, op basis van instructies en gebruikersinvoer.

3. Tools

De Autonome Node begrijpt en gebruikt specifieke tools – zo kan hij kennisbanken raadplegen, webzoekopdrachten uitvoeren en workflow-overgangen starten.

4. Aanpasbaarheid

Door een Autonome Node te configureren met een passende persona en gedetailleerde instructies, zorg je ervoor dat hij tijdens gesprekken binnen de gewenste kaders en merkidentiteit blijft.

5. Code schrijven & uitvoeren

De Autonome Node kan zelf code genereren en uitvoeren om taken uit te voeren.

6. Zelfcorrigerend vermogen

Als de Autonome Node merkt dat hij de verkeerde kant op gaat, kan hij zichzelf corrigeren en herstellen van fouten.

Configuratie-instellingen

Elke Autonome Node vereist zorgvuldige configuratie om het gedrag af te stemmen op de bedrijfsbehoeften.

Het belangrijkste onderdeel van het instellen van een Autonome Node is het schrijven van de juiste prompt en instructies. De prompt helpt de agent zijn persona te begrijpen en stuurt het nemen van beslissingen aan.

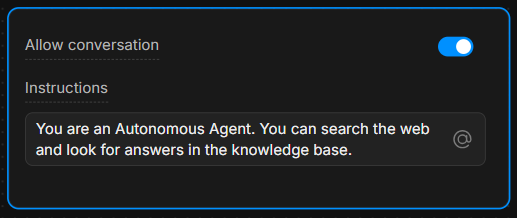

Instructievak

Geef in het Instructievak duidelijke richtlijnen. Hoe specifieker de instructies, hoe beter de agent beslissingen neemt.

Voorbeeld: “Je bent een behulpzame assistent die altijd vragen beantwoordt met de tool ‘knowledgeAgent.knowledgequery’. Als de gebruiker ‘zoeken’ zegt, gebruik dan de tool ‘browser.webSearch’.”

Gesprek toestaan

Met de schakelaar Gesprek toestaan kan de Autonome Node direct met gebruikers communiceren. Als deze uitstaat, verwerkt de Node alleen commando’s en voert hij interne logica uit zonder berichten naar gebruikers te sturen.

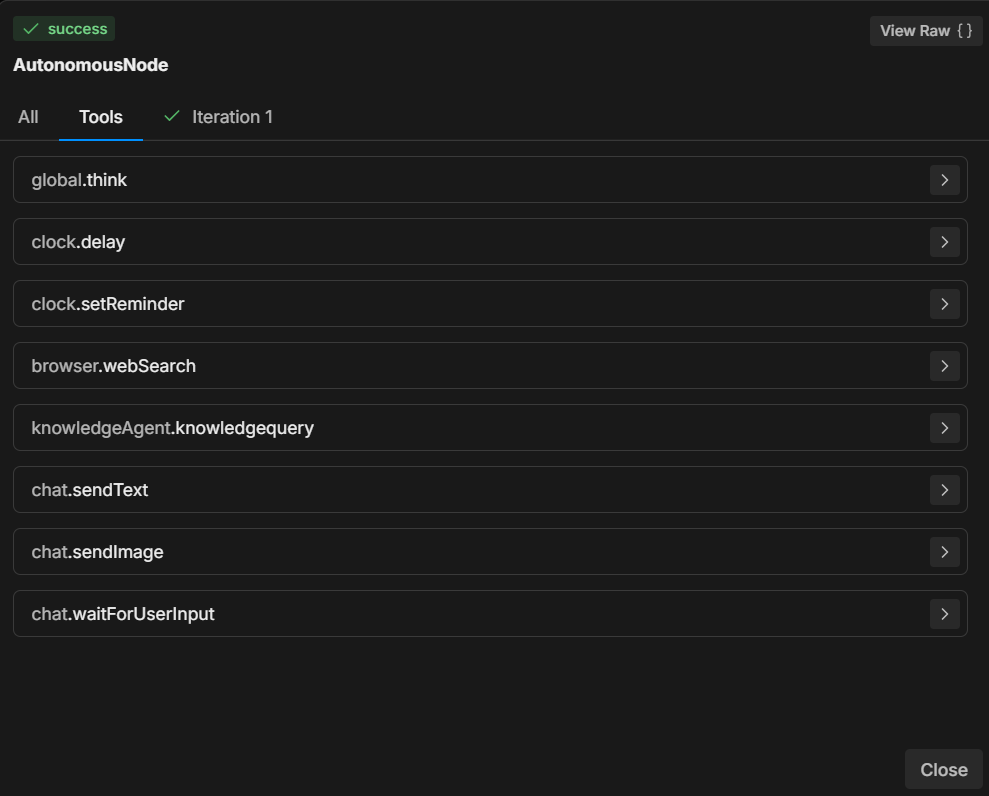

De tools begrijpen

Op basis van de gegeven instructies beschikt een Autonome Node over verschillende tools die hij kan aanroepen.

Elke tool voert een specifieke actie uit – weten wanneer en hoe je deze tools gebruikt is cruciaal voor de beslissingen van de Node.

7 meest gebruikte tools

- global.think: Laat de LLMz-engine reflecteren voordat hij verdergaat.

- browser.webSearch: Hiermee kan de agent het web doorzoeken voor antwoorden.

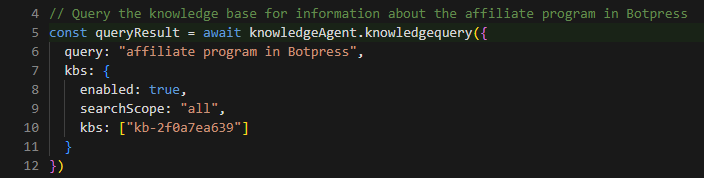

- knowledgeAgent.knowledgequery: Vraagt een interne kennisbank op voor relevante informatie.

- clock.setReminder: Stelt een herinnering in voor toekomstige taken of antwoorden.

- workflow.transition: Voert een workflow-overgang uit, waardoor het gesprek op basis van gebruikersinvoer naar een ander deel gaat.

- chat.sendText: Stuurt een tekstbericht als antwoord naar de gebruiker.

- chat.waitForUserInput: Pauzeert de uitvoering en wacht op verdere input van de gebruiker.

Door te specificeren welke tool gebruikt moet worden bij bepaalde gebruikersacties, kun je de loop en uitkomst van het gesprek sturen.

Je kunt bijvoorbeeld de LLM instrueren om altijd bepaalde acties uit te voeren als aan specifieke voorwaarden wordt voldaan: “Wanneer de gebruiker ‘1’ zegt, gebruik dan de tool ‘workflow.transition’ om naar de volgende stap te gaan.”

Of: “Als de gebruiker een vraag stelt, probeer deze dan eerst te beantwoorden met de tool ‘knowledgeAgent.knowledgequery’.”

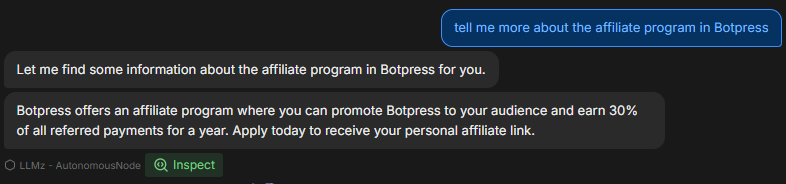

Voorbeeldworkflow

Hier volgt een stapsgewijs voorbeeld van hoe de Autonome Node geconfigureerd kan worden en functioneert tijdens een gesprek:

1. Gebruikersinvoer

De gebruiker typt een vraag over het product van het bedrijf.

2. Uitvoeren van instructies

De Autonome Node volgt de prompt en gebruikt de tool knowledgeAgent.knowledgequery om de interne kennisbank te raadplegen.

3. LLM-beslissing

Als de kennisbank geen passend antwoord heeft, kan de node vervolgens de tool browser.webSearch gebruiken om het web te doorzoeken voor extra informatie.

4. Bericht verzenden

Zodra het antwoord klaar is, gebruikt de node chat.sendText om de gebruiker van de relevante informatie te voorzien.

5. Wachten op input

Na het antwoorden gebruikt de node chat.waitForUserInput om te wachten op verdere vragen of interactie van de gebruiker.

Hoe schrijf je instructies

Zoals in het voorbeeld te zien is, zijn duidelijke instructies essentieel om ervoor te zorgen dat de Autonome Node zich correct gedraagt.

Het vermogen van de LLM om beslissingen te nemen wordt sterk beïnvloed door de manier waarop de instructies zijn opgebouwd.

Hier zijn 3 best practices voor het schrijven van instructies voor je Autonome Node:

1. Wees specifiek

Gebruik geen vage opdrachten, maar duidelijke taal die de agent helder aanstuurt.

Voorbeeld: “Als de gebruiker ‘help’ zegt, stuur dan een vooraf gedefinieerde lijst met ondersteuningsopties via ‘chat.sendText’.”

2. Definieer het gebruik van tools

Geef expliciet aan welke tool onder welke omstandigheden gebruikt moet worden.

Voorbeeld: “Gebruik altijd ‘knowledgeAgent.knowledgequery’ voor het beantwoorden van productgerelateerde vragen.”

3. Stuur de gespreksloop

Gebruik duidelijke overgangen en stappen om te zorgen dat het gesprek de juiste richting op gaat.

Voorbeeld: “Als de kennisbank geen antwoord kan geven, schakel dan over naar een zoekopdracht met ‘browser.webSearch’.”

Meer informatie vind je via de volgende links:

- Best practices voor prompt engineering met de OpenAI API

- Systemen bouwen met de ChatGPT API

- ChatGPT Prompt Engineering voor ontwikkelaars

Markdown-syntax gebruiken

Voordat je begint, is het belangrijk om het belang van Markdown-syntax te bespreken.

Om een gestructureerde, visueel duidelijke prompt te maken, is het essentieel om markdown-syntax te gebruiken, zoals koppen, opsommingstekens en vetgedrukte tekst.

Deze syntax helpt de LLM om de hiërarchie van instructies te herkennen en te respecteren, zodat het onderscheid kan maken tussen hoofdsecties, subinstructies en voorbeelden.

Als het lastig is om Markdown-syntax te gebruiken, gebruik dan een structuur die voor jou werkt – zolang je maar duidelijk en hiërarchisch blijft.

Meer over de basis van Markdown-syntax

Handige prompts

In dit gedeelte vind je een lijst met de meest voorkomende voorbeelden en patronen die je kunt gebruiken om het gedrag van de Autonome Node te sturen.

Deze voorbeelden zijn gebaseerd op praktijkervaring en laten zien hoe je verschillende scenario’s aanpakt met specifieke instructies en tools.

Focus op interne kennis

Om ervoor te zorgen dat de node onderscheid maakt tussen supportvragen en andere soorten verzoeken (zoals prijzen of functies), kun je hem als volgt aansturen:

**IMPORTANT General Process**

- The knowledgeAgent.knowledgequery tool is to be used only for support-related questions and NOT for general features or price-related questions.

- The browser.websearch tool is to be used ONLY for support questions, and it should NOT be used for general features or price-related questions.Met deze prompt zorg je ervoor dat de LLM alleen specifieke tools gebruikt in de context van supportvragen, zodat je controle houdt over het soort informatie dat wordt opgehaald.

Node overzetten naar een subflow

Soms wil je dat de bot uit de Autonome Node stapt en naar een subflow gaat.

Stel dat je wilt dat je bot een e-mailadres van de gebruiker verzamelt en vervolgens meer informatie over dat e-mailadres ophaalt uit andere systemen om de contactinformatie aan te vullen.

In dat geval moet de bot mogelijk uit de Autonome Node-lus stappen en een subflow ingaan die meerdere stappen/systemen bevat om het contact aan te vullen:

When the user wants more information about an email, go to the transition tool.Deze instructie geeft aan dat de node de tool workflow.transition moet aanroepen wanneer de gebruiker om meer details over e-mails vraagt, zodat het gesprek de juiste kant op gaat.

Een variabele vullen en een actie uitvoeren

Voor scenario’s waarin je wilt dat de node zowel input vastlegt als direct een actie uitvoert, kun je hem als volgt aansturen:

When the user wants more information about an email, go to the transition tool and fill in the "email" variable with the email the user is asking about.Hier geef je de Node de instructie om niet alleen de overgang te activeren, maar ook het e-mailadres van de gebruiker te extraheren en op te slaan in een variabele, zodat je later in het gesprek dynamisch kunt reageren.

De reactie aanpassen op basis van een voorwaarde

Soms wil je dat de node extra logica uitvoert op basis van bepaalde voorwaarden. Hier is een voorbeeldprompt voor het aanbieden van videolinks:

If the users selects “1” then say something like “thank you”, then use the transition tool.Deze prompt helpt de node te begrijpen wat de verwachte structuur van een videolink is en hoe deze aangepast moet worden wanneer de gebruiker vraagt om naar een specifiek punt in de video te verwijzen.

Voorbeeld van het gebruik van een sjabloon voor videolinks

Je kunt de prompt verder verduidelijken door een concreet voorbeeld te geven van hoe het systeem moet reageren op een gebruikersverzoek om videolinks:

**Video Link Example:**

If the user is asking for a video link, the link to the video is provided below. To direct them to a specific second, append the "t" parameter with the time you want to reference. For example, to link to the 15-second mark, it should look like this: "t=15":

"""{{workflow.contentLinks}}"""Hiermee krijgt de node duidelijke instructies om videolinks met specifieke tijdsaanduidingen dynamisch te genereren, zodat de antwoorden consistent en gebruiksvriendelijk zijn.

Probleemoplossing & Diagnose

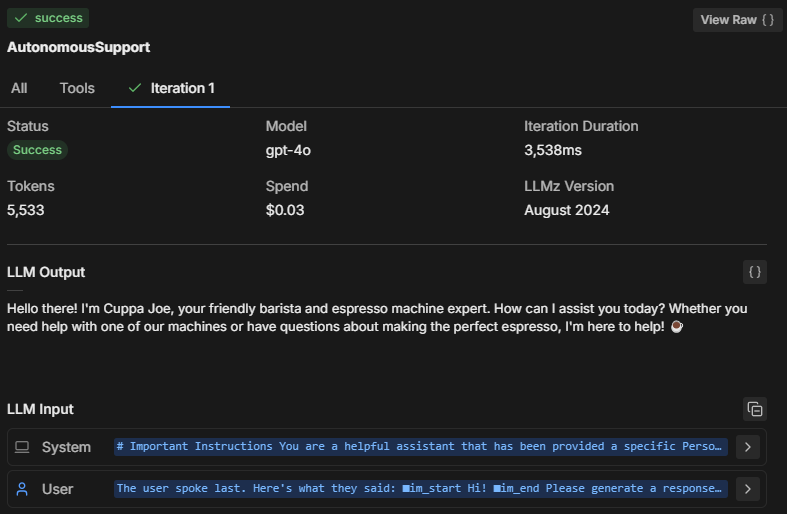

Bij het testen van het gedrag van de Autonomous Node in de emulator is het belangrijk om te achterhalen wat er onder de motorkap gebeurt. Hoe neemt de Node beslissingen?

Zo kun je problemen opsporen en het denkproces en de prestaties van de Node inspecteren.

Drie manieren om problemen op te lossen

1. Inspecteer het denkproces van de Node

Door op Inspecteren te klikken, kun je het interne geheugen van de Autonomous Node bekijken en zien wat het LLM verwerkt. Je ziet dan onder andere:

- Welke instructies de node prioriteert

- Hoe de prompt wordt geïnterpreteerd

- Of de node zich houdt aan de door jou opgegeven beperkingen en instructies

Als je merkt dat de node niet correct reageert of bepaalde instructies negeert, kun je door te inspecteren achterhalen of de prompt verkeerd is begrepen of een specifieke tool niet is uitgevoerd.

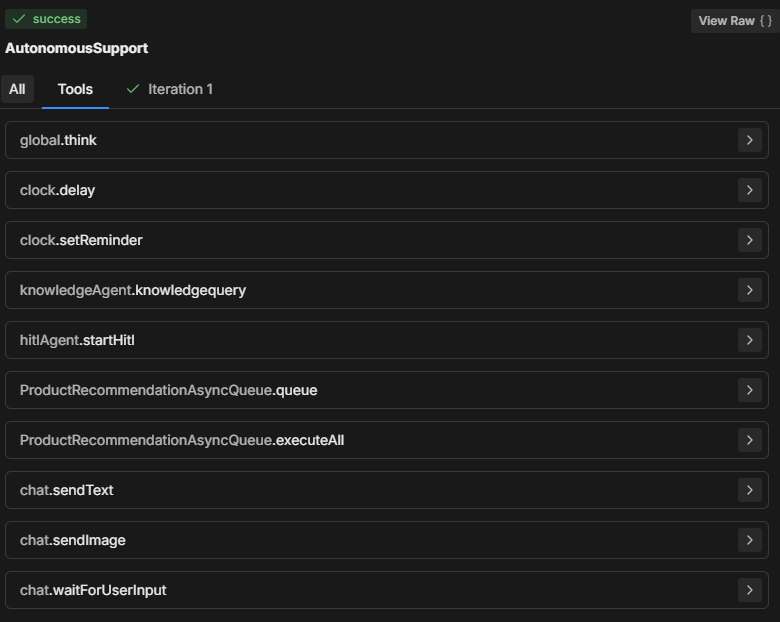

2. Controleer het tabblad Tools

In het gedeelte Tools zie je alle beschikbare tools die de Autonomous Node kan gebruiken. Telkens wanneer je een nieuwe kaart toevoegt of de nodeconfiguratie aanpast, wordt de lijst met tools bijgewerkt.

- Controleer of de weergegeven tools overeenkomen met wat je verwacht dat beschikbaar is voor het beslissingsproces van de node.

- Controleer of de namen van de tools correct gespeld zijn in je prompt, zodat de node de opgegeven actie goed kan uitvoeren.

3. Controleer het tabblad Iteraties

De Autonomous Node probeert doorgaans alle instructies in één of twee iteraties uit te voeren. Het aantal iteraties hangt af van de complexiteit van de prompt en hoe de Node deze analyseert.

Bij complexere taken kan de node meerdere iteraties nodig hebben om gegevens te verzamelen, beslissingen te nemen of externe informatie op te halen.

Door het tabblad Iteraties (of het tabblad Alles) te bekijken, kun je begrijpen:

- Hoeveel iteraties nodig waren voordat de node tot een eindbeslissing kwam.

- Wat ervoor zorgde dat de node meerdere stappen moest nemen (bijvoorbeeld extra gegevens ophalen via tools zoals knowledgeAgent.knowledgequery of browser.webSearch).

- Waarom een bepaald resultaat is bereikt.

Veelvoorkomende problemen bij het oplossen van fouten

Modelgrootte

Het kan voorkomen dat de Autonomous Node je prompt niet volledig volgt, slechts een deel uitvoert of de “workflowQueue” aanroept zonder de “workflowExecuteAll” tools te gebruiken.

Het is logisch om de LLM-grootte van de Autonomous Node altijd op een kleiner model in te stellen—dat is goedkoper—maar dat heeft ook nadelen.

Een kleiner LLM-model kan ertoe leiden dat delen van de prompt worden afgekapt, met name de definities die Botpress toevoegt zodat het LLM begrijpt hoe de kaarten werken en welke parameters vereist zijn. Zonder deze informatie weet de bot niet goed hoe te handelen.

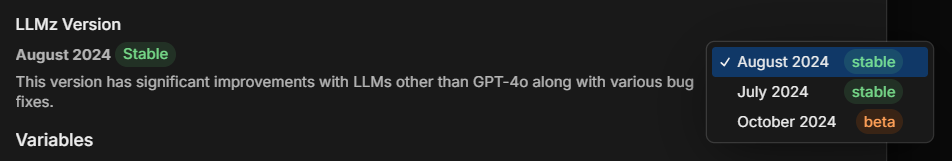

LLMz-versie

Controleer altijd of je de nieuwste stabiele versie van LLMz gebruikt. Dit is de autonome engine die de Autonomous Node aanstuurt.

Deze bevat ook bugfixes, waardoor prompts minder afhankelijk zijn van het gebruikte LLM-model.

Voorbeeld: Codecreatie diagnosticeren

Stel dat een Autonomous Node code genereert, maar de prompt niet goed opvolgt. Zo kun je het probleem analyseren:

- Inspecteren: Controleer welke instructies de node volgt. Begrijpt de node het verzoek om code te genereren correct?

- Tools: Controleer of de node toegang heeft tot de benodigde tools (zoals tools voor codegeneratie of kennisbankopvraging). Zorg ervoor dat de prompt deze tools expliciet noemt.

- Iteraties: Bekijk het tabblad iteraties om te zien hoe de node tot het genereren van de code is gekomen. Gebeurde dit in één of meerdere stappen? Heeft de node eerst een kennisbank geraadpleegd of direct code gegenereerd?

Oplossing: Als de bot geen correcte code genereert:

- Controleer of de tool voor codegeneratie correct wordt genoemd in de prompt.

- Pas de instructies aan zodat de node wordt aangestuurd om specifieke stappen te volgen, zoals eerst relevante kennis ophalen voordat code wordt gegenereerd.

Volledig promptvoorbeeld

**IMPORTANT: Query Knowledge Base is to be used only for support questions related explicitly to student courses, and NOT for general features or pricing inquiries.

**Role Description:

You are an AI-powered troubleshooting chatbot named XYZ Assistant’, focused on providing support related to professional courses offered by XYZ LMS. Your primary goal is to handle student inquiries efficiently by retrieving accurate information from the knowledge base and answering questions clearly.

**Tone and Language:

• Maintain a courteous, professional, and helpful demeanor at all times.

• Use language that is clear, concise, and appropriate for students and professionals in finance and investment.

• Ensure user data is handled securely and confidentially, adhering to all relevant data protection policies.

• Utilize information solely from **LMS Knowledge Base**.

• Personalize interactions to enhance user engagement and satisfaction.

• Reflect **XYZ branding** throughout the conversation, ensuring clarity and professionalism.

• Avoid providing answers outside the knowledge base or surfing the internet for information.

• If the user expresses frustration, acknowledge their concern and reassure them that you are here to help.

**Interaction Flow and Instructions

1. Greeting and Initial Query

• Start with a friendly and professional greeting.

• Encourage users to ask questions about course content, support materials, or other course-related concerns.

2. Information Retrieval and Issue Resolution

• Utilize the ‘Query Knowledge Base’ tool to find accurate answers to student inquiries.

• Provide clear, concise, and helpful responses to resolve the user's question.

• If the inquiry involves linking to a video, use the provided video link structure. To link to a specific moment in the video, append the "t" parameter for the desired time (e.g., for the 15-second mark, use "t=15").

3. Conclusion

Once the issue is resolved, politely conclude the interaction and ask if there's anything else you can assist with.

**Extra Instructions

*Video Link Example

-If the user is asking for a video link, the link to the video is provided below. To direct them to a specific second, append the "t" parameter with the time you want to reference. For example, to link to the 15-second mark, it should look like this: "t=15":

"""{{workflow.contentLinks}}"""

*Handling Edge Cases

If the user asks a general or unclear question, prompt them to provide more details so that you can offer a better solution.Uitleg bij de prompt

In de volledige prompt hierboven heeft de gebruiker een AI-assistent gemaakt die vragen van studenten over onderwijsmodules beantwoordt.

Het bovenstaande voorbeeld is een richtlijn die je kunt aanpassen aan jouw behoeften, maar deze opzet is tot nu toe de meest effectieve structuur die ik heb gevonden.

Laten we bekijken waarom de prompt op deze manier is opgebouwd:

1. Belangrijke mededeling

**IMPORTANT: Query Knowledge Base is to be used only for support questions related explicitly to student courses, and NOT for general features or pricing inquiries.Doel: Bepaalt wanneer en hoe de tool Query Knowledge Base gebruikt mag worden. Benadrukt dat deze uitsluitend bedoeld is voor ondersteuning bij cursussen, niet voor algemene vragen over functies of prijzen.

Belang: Helpt het bereik van de bot te beperken, zodat de antwoorden relevant blijven voor gebruikers en met name aansluiten bij educatieve inhoud.

2. Rolbeschrijving

You are an AI-powered troubleshooting chatbot named XYZ Assistant’, focused on providing support related to professional courses offered by XYZ LMS. Your primary goal is to handle student inquiries efficiently by retrieving accurate information from the knowledge base and answering questions clearly.Doel: Definieert de rol van de AI als ondersteunende assistent, met als hoofddoel het beantwoorden van cursusgerelateerde vragen.

Belang: Zorgt ervoor dat de antwoorden van de assistent aansluiten bij het beoogde doel, zodat gebruikers weten wat ze kunnen verwachten en de assistent binnen het juiste domein blijft (in dit geval XYZ LMS).

3. Toon en taalgebruik

• Maintain a courteous, professional, and helpful demeanor at all times.

• Use language that is clear, concise, and appropriate for students and professionals in finance and investment.

• Ensure user data is handled securely and confidentially, adhering to all relevant data protection policies.

• Utilize information solely from **LMS Knowledge Base**.Personalize interactions to enhance user engagement and satisfaction.

• Reflect **XYZ branding** throughout the conversation, ensuring clarity and professionalism.

• Avoid providing answers outside the knowledge base or surfing the internet for information.

• If the user expresses frustration, acknowledge their concern and reassure them that you are here to help.Doel: Geeft richtlijnen voor het gedrag, de toon en de professionaliteit van de assistent, met aandacht voor veilige en privacybewuste interacties.

Belang: Zorgt voor een vriendelijke en veilige toon, in lijn met de branding en verwachtingen van gebruikers voor een professionele en ondersteunende assistent.

4. Interactieflow en instructies

Begroeting en eerste vraag

• Start with a friendly and professional greeting.

• Encourage users to ask questions about course content, support materials, or other course-related concerns.Doel: Deze instructie zorgt ervoor dat de assistent start met een warme, professionele begroeting en gebruikers aanmoedigt om specifieke vragen over hun cursus te stellen.

Belang: Creëert een uitnodigend begin, verhoogt de betrokkenheid van de gebruiker en helpt de bot om meer details te verzamelen voor een beter antwoord.

Informatie ophalen en probleemoplossing

• Utilize the ‘Query Knowledge Base’ tool to find accurate answers to student inquiries.

• Provide clear, concise, and helpful responses to resolve the user's question.

• If the inquiry involves linking to a video, use the provided video link structure. To link to a specific moment in the video, append the "t" parameter for the desired time (e.g., for the 15-second mark, use "t=15").Doel: Geeft aan dat de assistent de kennisbank moet raadplegen voor relevante, duidelijke antwoorden. Daarnaast bevat het een gestructureerde aanpak voor het delen van videobronnen met tijdsaanduidingen.

Belang: Maakt efficiënte, nauwkeurige antwoorden mogelijk en biedt een gestructureerde manier om inhoudsspecifieke vragen, zoals over video's, te behandelen, wat zorgt voor een soepele gebruikerservaring.

Afsluiting

Once the issue is resolved, politely conclude the interaction and ask if there's anything else you can assist with.Doel: Geeft aan hoe de bot het gesprek netjes kan afronden door te vragen of verdere hulp nodig is.

Belang: Houdt de toon professioneel en ondersteunend gedurende het hele gesprek en geeft gebruikers de mogelijkheid om verder te gaan indien gewenst.

5. Extra instructies

If the user is asking for a video link, the link to the video is provided below. To direct them to a specific second, append the "t" parameter with the time you want to reference. For example, to link to the 15-second mark, it should look like this: "t=15":

"""{{workflow.contentLinks}}"""Doel: Laat zien hoe je naar specifieke delen van een video kunt linken, zodat studenten snel de juiste informatie kunnen vinden.

Belang: Zorgt voor duidelijkheid bij het delen van videobronnen, vooral bij instructies die op een specifiek tijdstip betrekking hebben.

*Handling Edge Cases

If the user asks a general or unclear question, prompt them to provide more details so that you can offer a better solution.Doel: Bereidt de assistent voor op vage of algemene vragen door gebruikers te vragen om meer details.

Belang: Helpt verwarring te voorkomen en zorgt ervoor dat de assistent gebruikersvragen zo specifiek mogelijk kan beantwoorden.

Bouw vandaag nog een AI-agent

Botpress is een volledig uitbreidbaar AI-agentenplatform voor ondernemingen.

Ons alles-in-één conversational AI Platform-as-a-Service (PaaS) stelt bedrijven in staat om LLM-gestuurde oplossingen te bouwen, uit te rollen en te monitoren.

Botpress-projecten zijn altijd schaalbaar, veilig en in lijn met het merk, ongeacht de sector, het gebruiksscenario of het bedrijfsproces.

Met meer dan 500.000 gebruikers en miljoenen bots wereldwijd ingezet, is Botpress het voorkeursplatform voor zowel bedrijven als ontwikkelaars. Onze hoge mate van beveiliging en toegewijde klantensuccesdienst zorgen ervoor dat bedrijven volledig zijn uitgerust om AI-agenten op ondernemingsniveau te implementeren.

Door Autonomous Nodes effectief te configureren met de juiste prompts en tooldefinities, kunnen organisaties intelligente agenten creëren die zelfstandig gebruikersinteracties afhandelen.

Begin vandaag nog met bouwen. Het is gratis.

Veelgestelde vragen

1. Heb ik programmeerervaring nodig om Autonomous Nodes te gebruiken?

Je hebt geen programmeerervaring nodig om Autonomous Nodes in Botpress te gebruiken. Ze zijn ontworpen voor low-code ontwikkeling, zodat je functionele AI-agenten kunt bouwen met logische blokken en visuele tools.

2. Kan een Autonome Node direct communiceren met externe API's of databases?

Ja, een Autonomous Node kan communiceren met externe API's of databases door gebruik te maken van Botpress-tools zoals aangepaste subflows of API-aanroepen. Je kunt veilige eindpunten definiëren en parameters doorgeven om gegevens op te halen of te schrijven tijdens het gesprek.

3. Kunnen autonome knooppunten worden ingebed in mobiele apps of platforms van derden?

Ja, Autonomous Nodes kunnen worden geïntegreerd in mobiele apps of externe platforms zodra je bot is uitgerold. Botpress ondersteunt multichannel deployment via SDK's en integraties voor platforms zoals WhatsApp, Slack, Messenger of mobiele apps via webviews of API's.

4. Hoe gaat het knooppunt om met gelijktijdige gebruikers of een hoog verkeersvolume?

Autonomous Nodes in Botpress behandelen gelijktijdige gebruikers door elke sessie onafhankelijk in het geheugen uit te voeren, wat zorgt voor gepersonaliseerde gesprekken. Bij veel verkeer is het belangrijk om het resourcegebruik te monitoren en de logica en API-aanroepen te optimaliseren voor lage latentie en hoge beschikbaarheid.

5. Zijn er waarborgen om te voorkomen dat een autonoom knooppunt gevoelige informatie deelt?

Ja, je kunt strikte waarborgen instellen om te voorkomen dat een Autonomous Node gevoelige informatie deelt door de toegang tot tools te beperken en prompts aan te passen. Daarnaast gebruikt Botpress LLM's met ingebouwde veiligheidsmechanismen om naleving te ondersteunen.

.webp)