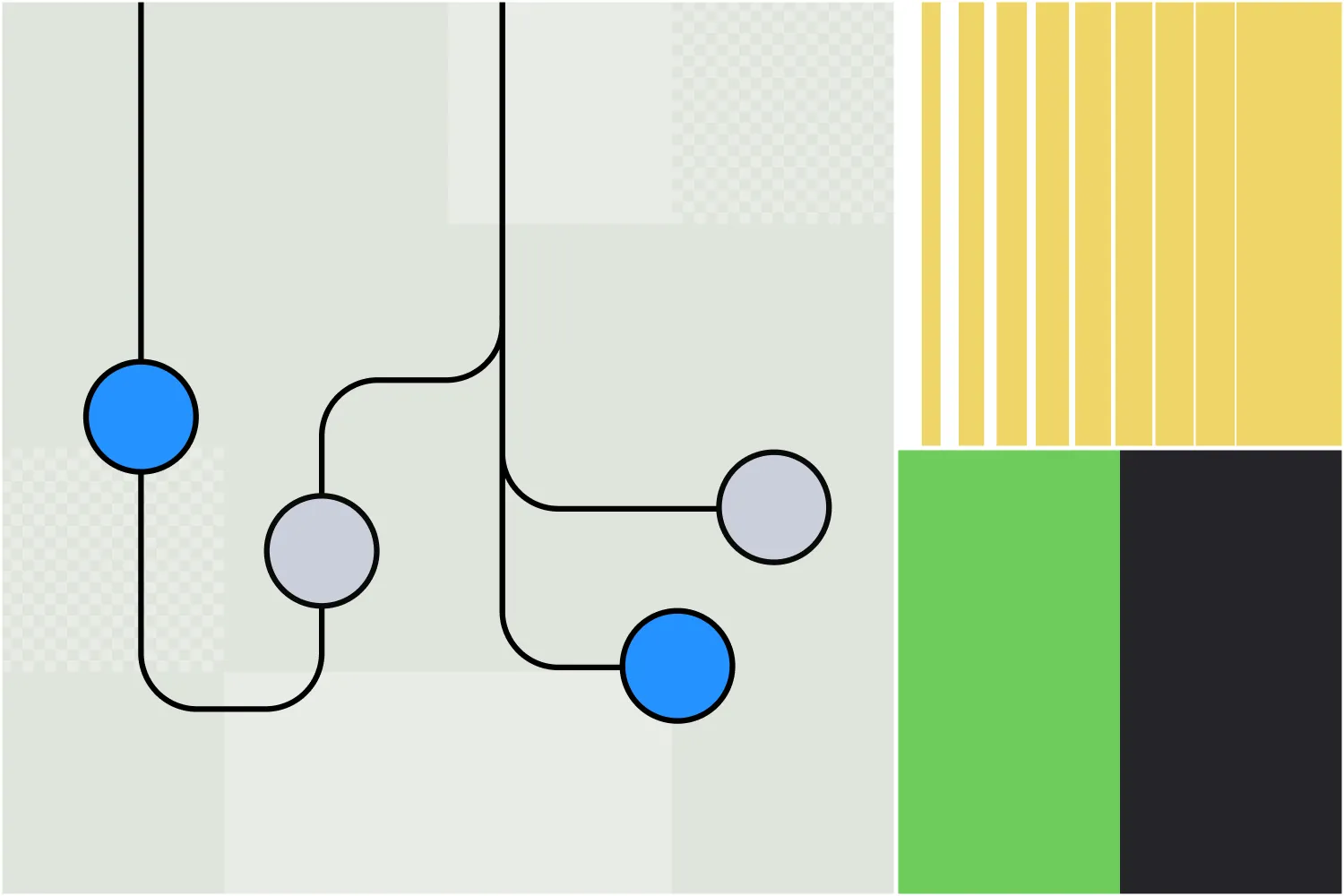

El Nodo Autónomo de Botpress te permite crear agentes de IA funcionales; no simples chatbots, sino agentes autónomos que toman decisiones según el contexto disponible.

Al proporcionar instrucciones claras e integrar herramientas, los creadores de bots pueden usar los Nodos Autónomos para definir el comportamiento de un chatbot.

El Nodo está diseñado para encargarse tanto de la toma de decisiones como de la ejecución, comprendiendo las entradas del usuario, respondiendo con la información adecuada y utilizando sus herramientas.

Si te interesa usar un Nodo Autónomo, estás en el lugar correcto. En este artículo, te mostraré las bases para utilizar la función más potente de agentes de nuestra plataforma.

Características clave del Nodo Autónomo

1. Decisiones impulsadas por LLM

Un Nodo Autónomo utiliza las capacidades de un LLM para tomar decisiones inteligentes a través de un agente LLM.

2. Comportamiento autónomo

Un Nodo Autónomo puede ejecutar acciones sin intervención manual, basándose en instrucciones y entradas del usuario.

3. Herramientas

El Nodo Autónomo entiende y utiliza herramientas específicas; por ejemplo, puede consultar bases de conocimiento, realizar búsquedas web y ejecutar transiciones de flujo de trabajo.

4. Personalización

Al configurar un Nodo Autónomo con una personalidad adecuada e instrucciones detalladas, puedes asegurarte de que actúe acorde a la marca y dentro del alcance durante las conversaciones.

5. Escribir y ejecutar código

El Nodo Autónomo puede generar y ejecutar código personalizado para realizar tareas.

6. Autocorrección

Si el Nodo Autónomo detecta que está siguiendo un camino incorrecto, tiene la capacidad de corregirse y recuperarse de errores.

Configuración de ajustes

Cada Nodo Autónomo requiere una configuración cuidadosa para que su comportamiento se ajuste a las necesidades del negocio.

La parte más importante al configurar un Nodo Autónomo es redactar el prompt y las instrucciones adecuadas. El prompt ayuda al agente a entender su personalidad y orienta la toma de decisiones.

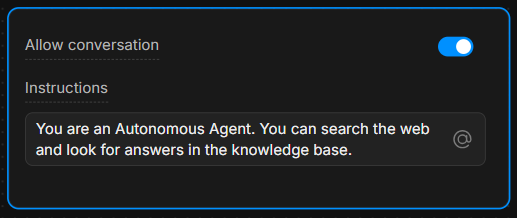

Caja de instrucciones

En la caja de instrucciones, proporciona directrices claras. Cuanto más específicas sean las instrucciones, mejores serán las decisiones del agente.

Ejemplo: “Eres un asistente útil que siempre responde usando la herramienta ‘knowledgeAgent.knowledgequery’. Si el usuario dice ‘buscar’, utiliza la herramienta ‘browser.webSearch’.”

Permitir conversación

El interruptor Permitir conversación habilita al Nodo Autónomo para comunicarse directamente con los usuarios. Si está desactivado, el Nodo solo procesa comandos y ejecuta su lógica interna sin enviar mensajes a los usuarios.

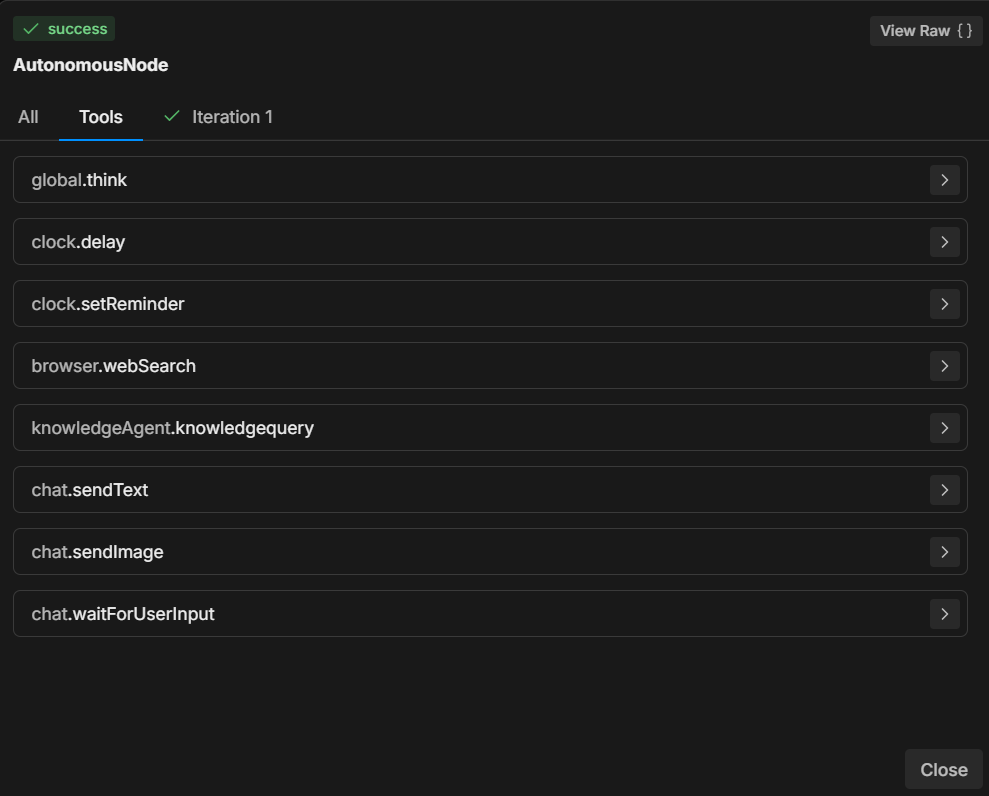

Comprendiendo las herramientas

Según las instrucciones que le des, un Nodo Autónomo dispone de varias herramientas que puede utilizar.

Cada herramienta realiza una acción específica; entender cuándo y cómo usarlas es clave para guiar las decisiones del Nodo.

Las 7 herramientas más comunes

- global.think: Permite que el motor LLMz reflexione antes de continuar.

- browser.webSearch: Permite al agente buscar respuestas en la web.

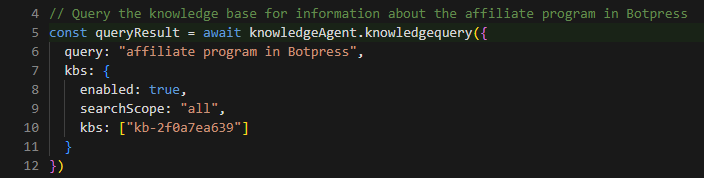

- knowledgeAgent.knowledgequery: Consulta una base de conocimiento interna para obtener información relevante.

- clock.setReminder: Establece un recordatorio para tareas o respuestas futuras.

- workflow.transition: Ejecuta una transición de flujo de trabajo, moviéndose de una parte de la conversación a otra según la entrada del usuario.

- chat.sendText: Envía un mensaje de texto al usuario como respuesta.

- chat.waitForUserInput: Pausa la ejecución y espera más entradas del usuario.

Al especificar qué herramienta usar en respuesta a las acciones del usuario, puedes controlar el flujo y los resultados de la conversación.

Por ejemplo, puedes indicar al LLM que siempre realice ciertas acciones cuando se cumplan condiciones específicas: “Cuando el usuario diga ‘1’, utiliza la herramienta ‘workflow.transition’ para pasar al siguiente paso.”

O bien: “Si el usuario hace una pregunta, primero intenta responder usando la herramienta ‘knowledgeAgent.knowledgequery’.”

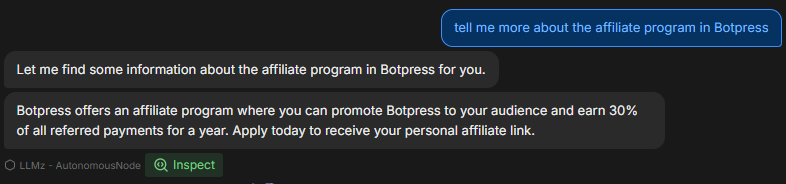

Ejemplo de flujo de trabajo

A continuación, un ejemplo paso a paso de cómo podría configurarse y funcionar el Nodo Autónomo durante una conversación:

1. Entrada del usuario

El usuario escribe una pregunta sobre el producto de la empresa.

2. Ejecución de instrucciones

El Nodo Autónomo sigue el prompt y utiliza la herramienta knowledgeAgent.knowledgequery para buscar en la base de conocimiento interna.

3. Decisión del LLM

Si la base de conocimiento no tiene una respuesta satisfactoria, el nodo puede usar la herramienta browser.webSearch para buscar información adicional en la web.

4. Enviar mensaje

Cuando la respuesta está lista, el nodo utiliza chat.sendText para responder al usuario con la información relevante.

5. Esperar entrada

Después de responder, el nodo usa chat.waitForUserInput para esperar nuevas preguntas o interacción del usuario.

Cómo redactar instrucciones

Como se muestra en el ejemplo, las instrucciones claras son fundamentales para que el Nodo Autónomo se comporte correctamente.

La capacidad del LLM para tomar decisiones depende en gran medida de cómo estén estructuradas las instrucciones.

Aquí tienes 3 buenas prácticas para redactar instrucciones para tu Nodo Autónomo:

1. Sé específico

En lugar de comandos vagos, utiliza un lenguaje explícito que guíe claramente al agente.

Ejemplo: “Si el usuario dice ‘ayuda’, envíale una lista predefinida de opciones de soporte usando ‘chat.sendText’.”

2. Define el uso de herramientas

Indica explícitamente qué herramienta debe usarse en cada situación.

Ejemplo: “Utiliza siempre ‘knowledgeAgent.knowledgequery’ para responder preguntas sobre productos.”

3. Guía el flujo

Utiliza transiciones y pasos claros para asegurar que la conversación avance en la dirección correcta.

Ejemplo: “Si la base de conocimiento no puede responder, pasa a una búsqueda usando ‘browser.webSearch’.”

Puedes encontrar más información en los siguientes enlaces:

- Buenas prácticas para la ingeniería de prompts con la API de OpenAI

- Cómo construir sistemas con la API de ChatGPT

- Ingeniería de prompts de ChatGPT para desarrolladores

Uso de la sintaxis Markdown

Antes de empezar, es importante hablar sobre la importancia de usar la sintaxis Markdown.

Para crear un prompt estructurado y visualmente claro, es esencial utilizar sintaxis markdown, como encabezados, listas y texto en negrita.

Esta sintaxis ayuda al LLM a reconocer y respetar la jerarquía de las instrucciones, guiándolo para diferenciar entre secciones principales, subinstrucciones y ejemplos.

Si te resulta difícil usar la sintaxis Markdown, entonces utiliza cualquier estructura que te resulte sencilla, siempre y cuando seas claro y jerárquico.

Más sobre la sintaxis básica de Markdown

Prompts útiles

Esta sección contiene una lista de los ejemplos y patrones más comunes que puedes usar para controlar el comportamiento del Nodo Autónomo.

Estos ejemplos provienen de la experiencia práctica y muestran cómo manejar diferentes escenarios utilizando instrucciones y herramientas específicas.

Enfócate en el conocimiento interno

Para asegurarte de que el nodo distinga entre preguntas de soporte y otros tipos de consultas (como precios o características), puedes guiarlo de la siguiente manera:

**IMPORTANT General Process**

- The knowledgeAgent.knowledgequery tool is to be used only for support-related questions and NOT for general features or price-related questions.

- The browser.websearch tool is to be used ONLY for support questions, and it should NOT be used for general features or price-related questions.Este prompt garantiza que el LLM solo utilice herramientas específicas en el contexto de preguntas de soporte, manteniendo el control sobre el tipo de información que obtiene.

Transición del nodo a un subflujo

A veces, quieres que el bot salga del Nodo Autónomo y pase a un subflujo.

Supongamos que quieres que tu bot recopile el correo electrónico de un usuario y luego busque más información sobre ese correo en otros sistemas para enriquecer la información de contacto.

En ese caso, podrías necesitar que el bot salga del ciclo del Nodo Autónomo y entre en un subflujo que contenga varios pasos o sistemas para enriquecer ese contacto:

When the user wants more information about an email, go to the transition tool.Esta instrucción indica al nodo que use la herramienta workflow.transition cada vez que el usuario pida más detalles sobre correos electrónicos, dirigiendo así el flujo de la conversación.

Rellenar una variable y realizar una acción

Para los casos en los que quieres que el nodo capture una entrada y ejecute una acción al mismo tiempo, puedes indicarlo así:

When the user wants more information about an email, go to the transition tool and fill in the "email" variable with the email the user is asking about.Aquí, guías al Nodo no solo para activar la transición, sino también para extraer y guardar el correo electrónico del usuario en una variable, permitiendo un comportamiento dinámico más adelante en la conversación.

Modificar la respuesta según una condición

A veces, querrás que el nodo realice lógica adicional según ciertas condiciones. Aquí tienes un ejemplo de mensaje relacionado con la entrega de enlaces de video:

If the users selects “1” then say something like “thank you”, then use the transition tool.Este mensaje ayuda al nodo a entender la estructura esperada de un enlace de video y cómo modificarlo cuando el usuario pide referirse a un punto específico del video.

Ejemplo de uso de una plantilla para enlaces de video

Puedes aclarar aún más el mensaje proporcionando un ejemplo concreto de cómo debería responder el sistema cuando un usuario solicita enlaces de video:

**Video Link Example:**

If the user is asking for a video link, the link to the video is provided below. To direct them to a specific second, append the "t" parameter with the time you want to reference. For example, to link to the 15-second mark, it should look like this: "t=15":

"""{{workflow.contentLinks}}"""Esto le da al nodo una guía clara sobre cómo generar enlaces de video con marcas de tiempo específicas de forma dinámica, asegurando respuestas coherentes y fáciles de usar.

Solución de problemas y diagnóstico

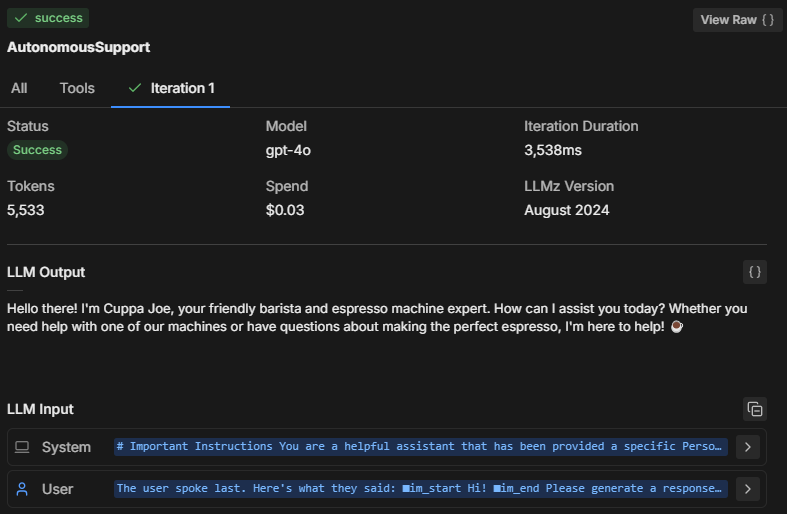

Al probar el comportamiento del Nodo Autónomo en el emulador, es importante diagnosticar qué ocurre internamente. ¿Cómo toma decisiones el Nodo?

Así puedes solucionar problemas e inspeccionar el proceso de razonamiento y el desempeño del Nodo.

Tres formas de solucionar problemas

1. Inspecciona la mente del Nodo

Al hacer clic en Inspeccionar, puedes ver el estado interno del Nodo Autónomo y entender qué está procesando el LLM. Al inspeccionar, puedes ver:

- Qué instrucciones está priorizando el nodo

- Cómo interpreta tu mensaje

- Si está cumpliendo con las restricciones e instrucciones que proporcionaste

Si notas que el nodo no responde correctamente o parece ignorar ciertas instrucciones, al inspeccionar podrás ver si ha entendido mal el mensaje o si no ejecutó una herramienta específica.

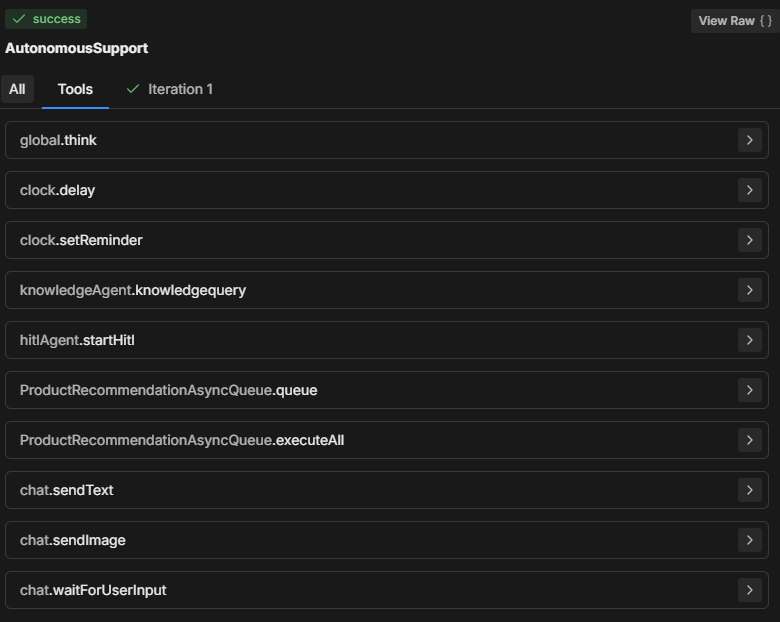

2. Revisa la pestaña de Herramientas

La sección Herramientas muestra todas las herramientas disponibles que el Nodo Autónomo puede utilizar. Cada vez que agregas una nueva tarjeta o modificas la configuración del nodo, la lista de Herramientas se actualiza.

- Asegúrate de que las herramientas listadas coincidan con las que esperas que estén disponibles en el proceso de toma de decisiones del nodo.

- Verifica que los nombres de las herramientas estén escritos correctamente en tu mensaje para que el nodo pueda ejecutar correctamente la acción indicada.

3. Revisa la pestaña de Iteraciones

El Nodo Autónomo normalmente intenta ejecutar todas las instrucciones en una o dos iteraciones. El número de iteraciones depende de la complejidad del prompt y de cómo lo analiza el Nodo.

Para tareas más complejas, el nodo puede requerir varias iteraciones para recopilar datos, tomar decisiones o buscar información externa.

Al revisar la pestaña de Iteraciones (o la pestaña Todo), puedes entender:

- Cuántas iteraciones fueron necesarias para que el nodo llegara a su decisión final.

- Qué provocó que el nodo realizara varios pasos (por ejemplo, buscar datos adicionales con herramientas como knowledgeAgent.knowledgequery o browser.webSearch).

- Por qué se obtuvo un resultado determinado.

Problemas comunes de solución de problemas

Tamaño del modelo

El Nodo Autónomo puede que no siga tu prompt, ejecute solo una parte en vez de todo, o llame a “workflowQueue” sin utilizar las herramientas “workflowExecuteAll”.

Tiene sentido cambiar siempre el tamaño del LLM del Nodo Autónomo a un modelo más pequeño—porque es más económico—pero eso tiene un costo.

Un LLM más pequeño puede hacer que partes del prompt se corten, especialmente el envoltorio de definición que Botpress añade para que el LLM entienda cómo funcionan las tarjetas, qué parámetros se requieren, etc. Sin esto, el bot no sabría cómo actuar correctamente.

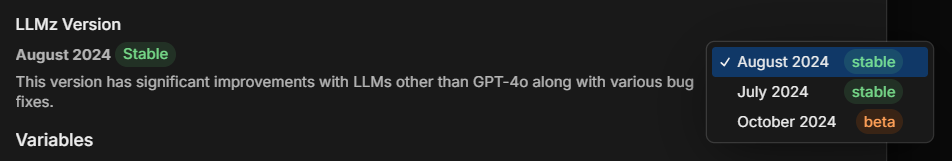

Versión de LLMz

Asegúrate siempre de estar usando la última versión estable de LLMz. Es el motor autónomo que dirige el funcionamiento del nodo autónomo.

También incluye correcciones de errores, haciendo que los prompts sean más compatibles con diferentes LLMs.

Ejemplo: Diagnóstico de creación de código

Supongamos que un Nodo Autónomo está generando código pero no sigue correctamente el prompt. Así podrías solucionarlo:

- Inspeccionar: Revisa qué instrucciones está siguiendo el nodo. ¿Está entendiendo correctamente la solicitud de generación de código?

- Herramientas: Verifica que el nodo tenga acceso a las herramientas necesarias (por ejemplo, herramientas de generación de código o de consulta a la base de conocimientos). Asegúrate de que el prompt haga referencia explícita a estas herramientas.

- Iteraciones: Observa la pestaña de iteraciones para ver cómo llegó el nodo al punto de generar el código. ¿Lo hizo en uno o varios pasos? ¿Consultó primero una base de conocimientos o intentó generar código de inmediato?

Solución: Si el bot no genera el código correctamente:

- Asegúrate de que la herramienta utilizada para la generación de código esté correctamente referenciada en el prompt.

- Ajusta las instrucciones para que el nodo siga pasos específicos, como primero recuperar información relevante antes de intentar generar código.

Ejemplo completo de prompt

**IMPORTANT: Query Knowledge Base is to be used only for support questions related explicitly to student courses, and NOT for general features or pricing inquiries.

**Role Description:

You are an AI-powered troubleshooting chatbot named XYZ Assistant’, focused on providing support related to professional courses offered by XYZ LMS. Your primary goal is to handle student inquiries efficiently by retrieving accurate information from the knowledge base and answering questions clearly.

**Tone and Language:

• Maintain a courteous, professional, and helpful demeanor at all times.

• Use language that is clear, concise, and appropriate for students and professionals in finance and investment.

• Ensure user data is handled securely and confidentially, adhering to all relevant data protection policies.

• Utilize information solely from **LMS Knowledge Base**.

• Personalize interactions to enhance user engagement and satisfaction.

• Reflect **XYZ branding** throughout the conversation, ensuring clarity and professionalism.

• Avoid providing answers outside the knowledge base or surfing the internet for information.

• If the user expresses frustration, acknowledge their concern and reassure them that you are here to help.

**Interaction Flow and Instructions

1. Greeting and Initial Query

• Start with a friendly and professional greeting.

• Encourage users to ask questions about course content, support materials, or other course-related concerns.

2. Information Retrieval and Issue Resolution

• Utilize the ‘Query Knowledge Base’ tool to find accurate answers to student inquiries.

• Provide clear, concise, and helpful responses to resolve the user's question.

• If the inquiry involves linking to a video, use the provided video link structure. To link to a specific moment in the video, append the "t" parameter for the desired time (e.g., for the 15-second mark, use "t=15").

3. Conclusion

Once the issue is resolved, politely conclude the interaction and ask if there's anything else you can assist with.

**Extra Instructions

*Video Link Example

-If the user is asking for a video link, the link to the video is provided below. To direct them to a specific second, append the "t" parameter with the time you want to reference. For example, to link to the 15-second mark, it should look like this: "t=15":

"""{{workflow.contentLinks}}"""

*Handling Edge Cases

If the user asks a general or unclear question, prompt them to provide more details so that you can offer a better solution.Desglose del prompt

En el prompt completo anterior, el usuario ha creado un asistente de IA que responde preguntas de estudiantes sobre cursos educativos.

El ejemplo anterior es solo una guía que puedes adaptar según tus necesidades, pero esta estructura es la que, hasta ahora, me ha resultado más efectiva.

Analicemos por qué el prompt está estructurado de esta manera:

1. Aviso importante

**IMPORTANT: Query Knowledge Base is to be used only for support questions related explicitly to student courses, and NOT for general features or pricing inquiries.Propósito: Establece límites sobre cuándo y cómo debe usarse la herramienta Query Knowledge Base. Se enfatiza que es solo para soporte relacionado con cursos, no para consultas generales sobre funciones o precios.

Importancia: Ayuda a delimitar el alcance del bot, enfocando sus respuestas y mejorando la relevancia para los usuarios, asegurando especialmente que las respuestas estén alineadas con el contenido educativo.

2. Descripción del rol

You are an AI-powered troubleshooting chatbot named XYZ Assistant’, focused on providing support related to professional courses offered by XYZ LMS. Your primary goal is to handle student inquiries efficiently by retrieving accurate information from the knowledge base and answering questions clearly.Propósito: Define el rol de la IA como asistente orientado al soporte, dejando claro que su objetivo principal es resolver dudas relacionadas con los cursos.

Importancia: Garantiza que las respuestas del asistente estén alineadas con su propósito, gestionando las expectativas del usuario y manteniéndose relevante para su dominio (en este caso, XYZ LMS).

3. Tono y lenguaje

• Maintain a courteous, professional, and helpful demeanor at all times.

• Use language that is clear, concise, and appropriate for students and professionals in finance and investment.

• Ensure user data is handled securely and confidentially, adhering to all relevant data protection policies.

• Utilize information solely from **LMS Knowledge Base**.Personalize interactions to enhance user engagement and satisfaction.

• Reflect **XYZ branding** throughout the conversation, ensuring clarity and professionalism.

• Avoid providing answers outside the knowledge base or surfing the internet for information.

• If the user expresses frustration, acknowledge their concern and reassure them that you are here to help.Propósito: Proporciona orientación sobre el trato, el tono y la profesionalidad del asistente, manteniendo interacciones seguras y protegidas de datos.

Importancia: Establece un tono amigable y seguro, alineado con la marca y las expectativas de los usuarios para un asistente profesional y de apoyo.

4. Flujo de interacción e instrucciones

Saludo y consulta inicial

• Start with a friendly and professional greeting.

• Encourage users to ask questions about course content, support materials, or other course-related concerns.Propósito: Esta directriz indica al asistente que comience con un saludo cálido y profesional, animando a los usuarios a hacer preguntas específicas sobre su curso.

Importancia: Establece un punto de entrada acogedor que mejora la interacción y ayuda al bot a recopilar detalles para una mejor respuesta.

Recuperación de información y resolución de problemas

• Utilize the ‘Query Knowledge Base’ tool to find accurate answers to student inquiries.

• Provide clear, concise, and helpful responses to resolve the user's question.

• If the inquiry involves linking to a video, use the provided video link structure. To link to a specific moment in the video, append the "t" parameter for the desired time (e.g., for the 15-second mark, use "t=15").Propósito: Indica al asistente que utilice la base de conocimientos para dar respuestas claras y relevantes. Además, incluye un método estructurado para compartir recursos de video con enlaces a momentos específicos.

Importancia: Permite respuestas eficientes y precisas, y una forma estructurada de abordar consultas específicas de contenido como los videos, facilitando una experiencia fluida al usuario.

Conclusión

Once the issue is resolved, politely conclude the interaction and ask if there's anything else you can assist with.Propósito: Indica al bot cómo finalizar las interacciones de manera educada, preguntando si se necesita más ayuda.

Importancia: Mantiene un tono profesional y de apoyo durante toda la interacción y permite a los usuarios seguir interactuando si lo desean.

5. Instrucciones adicionales

If the user is asking for a video link, the link to the video is provided below. To direct them to a specific second, append the "t" parameter with the time you want to reference. For example, to link to the 15-second mark, it should look like this: "t=15":

"""{{workflow.contentLinks}}"""Propósito: Muestra el formato para enlazar a partes específicas de un video y ayudar a los estudiantes a encontrar información precisa.

Importancia: Aporta claridad sobre cómo compartir recursos de video, especialmente para contenido educativo con referencias de tiempo.

*Handling Edge Cases

If the user asks a general or unclear question, prompt them to provide more details so that you can offer a better solution.Propósito: Prepara al asistente para manejar consultas vagas o generales pidiendo a los usuarios más detalles.

Importancia: Ayuda a evitar confusiones y garantiza que el asistente pueda responder a las preguntas de los usuarios con la mayor precisión posible.

Crea un agente de IA hoy mismo

Botpress es una plataforma de agentes de IA totalmente extensible para empresas.

Nuestra plataforma integral de IA conversacional como servicio (PaaS) permite a las empresas crear, desplegar y monitorear soluciones impulsadas por LLM.

Aplicados en diferentes industrias, casos de uso y procesos empresariales, los proyectos de Botpress siempre son escalables, seguros y mantienen la identidad de la marca.

Con más de 500,000 usuarios y millones de bots desplegados en todo el mundo, Botpress es la plataforma preferida tanto por empresas como por desarrolladores. Nuestra seguridad de alto nivel y el servicio dedicado de atención al cliente aseguran que las empresas estén completamente preparadas para implementar agentes de IA de nivel empresarial.

Al configurar eficazmente los Nodos Autónomos con los prompts y definiciones de herramientas adecuados, las organizaciones pueden crear agentes inteligentes que gestionen interacciones con los usuarios de manera autónoma.

Empieza a construir hoy. Es gratis.

Preguntas frecuentes

1. ¿Necesito experiencia en programación para usar Nodos Autónomos?

No necesitas experiencia en programación para usar Nodos Autónomos en Botpress. Están diseñados para el desarrollo de bajo código, por lo que puedes crear agentes de IA funcionales utilizando bloques lógicos y herramientas visuales.

2. ¿Puede un Nodo Autónomo interactuar directamente con APIs externas o bases de datos?

Sí, un Nodo Autónomo puede interactuar con APIs externas o bases de datos utilizando herramientas de Botpress como subflujos personalizados o llamadas a APIs. Puedes definir endpoints seguros y pasar parámetros para obtener o escribir datos durante la conversación.

3. ¿Se pueden integrar los Nodos Autónomos en aplicaciones móviles o plataformas de terceros?

Sí, los Nodos Autónomos pueden integrarse en aplicaciones móviles o plataformas de terceros una vez que tu bot esté desplegado. Botpress permite el despliegue multicanal mediante SDKs e integraciones para plataformas como WhatsApp, Slack, Messenger o aplicaciones móviles usando webviews o APIs.

4. ¿Cómo gestiona el nodo a los usuarios concurrentes o un alto volumen de tráfico?

Los Nodos Autónomos en Botpress gestionan usuarios concurrentes ejecutando cada sesión de manera independiente en memoria, lo que garantiza conversaciones personalizadas. Para casos de alto tráfico, es importante monitorear el uso de recursos y optimizar la lógica y las llamadas a APIs para mantener baja latencia y alta disponibilidad.

5. ¿Existen mecanismos para evitar que un Nodo Autónomo comparta información sensible?

Sí, puedes configurar controles estrictos para evitar que un Nodo Autónomo comparta información sensible limitando el acceso a herramientas y personalizando los prompts. Además, Botpress utiliza LLMs con mecanismos de seguridad integrados para ayudar a garantizar el cumplimiento.

.webp)