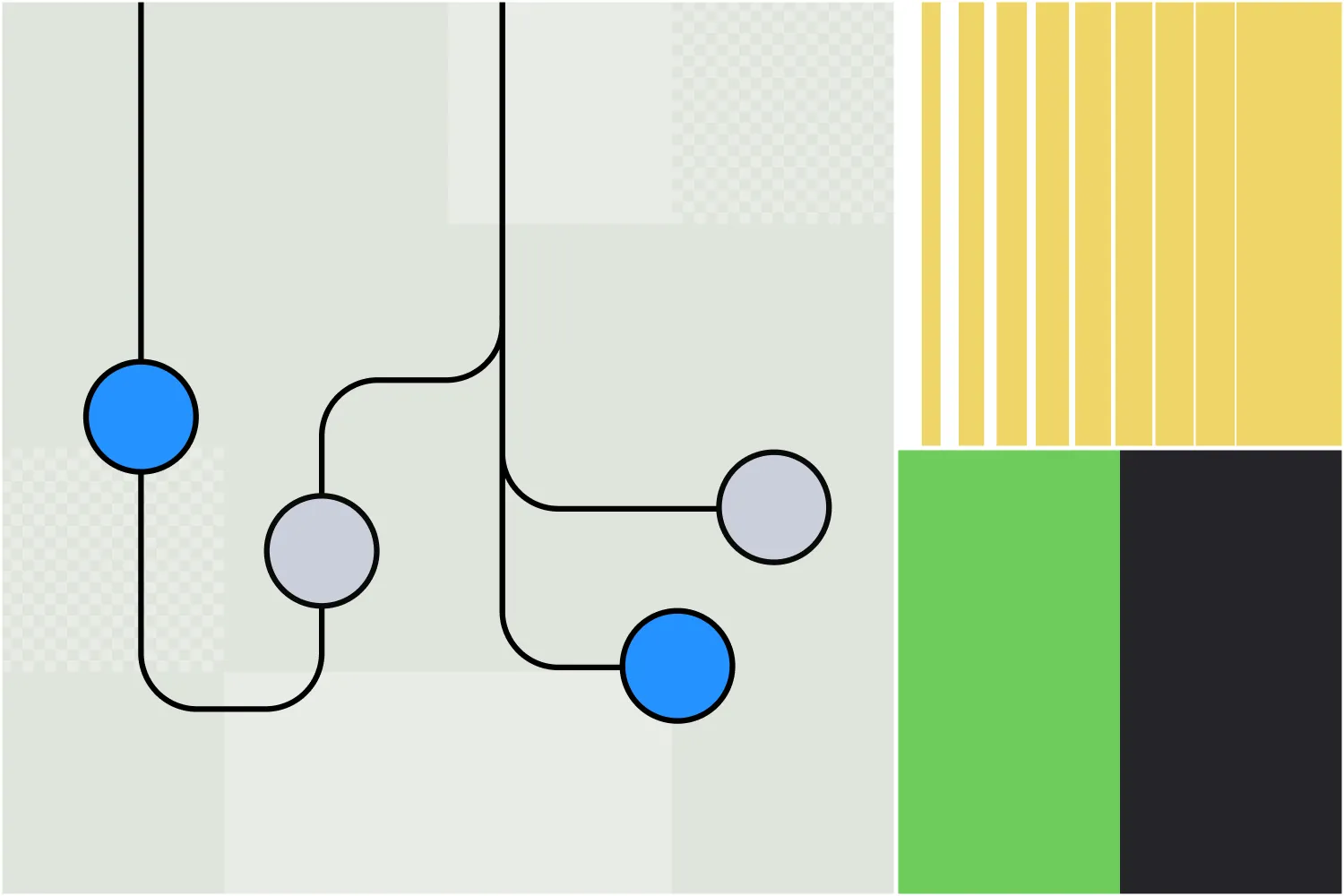

O Node Autônomo do Botpress permite criar agentes de IA funcionais – não apenas chatbots, mas agentes autônomos que tomam decisões com base no contexto disponível.

Ao fornecer instruções claras e integrar ferramentas, os criadores de bots podem usar Nodes Autônomos para definir o comportamento do chatbot.

O Node foi projetado para lidar tanto com a tomada de decisão quanto com a execução, entendendo as entradas do usuário, respondendo com os dados corretos e utilizando suas ferramentas.

Se você está interessado em usar um Node Autônomo, está no lugar certo. Neste artigo, vou apresentar as bases para usar o recurso de agentes autônomos da nossa plataforma.

Principais Características do Node Autônomo

1. Decisão guiada por LLM

Um Node Autônomo utiliza as capacidades de um LLM para tomar decisões inteligentes por meio de um agente LLM.

2. Comportamento Autônomo

Um Node Autônomo pode executar ações sem intervenção manual, com base em instruções e entradas do usuário.

3. Ferramentas

O Node Autônomo entende e utiliza ferramentas específicas – por exemplo, pode consultar bases de conhecimento, realizar buscas na web e executar transições de fluxo.

4. Personalização

Configurando o Node Autônomo com uma persona adequada e instruções detalhadas, você garante que ele se comporte de acordo com a marca e dentro do escopo durante as conversas.

5. Escrever e Executar Código

O Node Autônomo pode gerar e executar código personalizado para realizar tarefas.

6. Autocorreção

Se o Node Autônomo perceber que está seguindo um caminho errado, ele tem a capacidade de se autocorrigir e se recuperar de erros.

Configurações

Cada Node Autônomo requer uma configuração cuidadosa para alinhar seu comportamento às necessidades do negócio.

A parte mais importante da configuração de um Node Autônomo é escrever o prompt e as instruções corretas. O prompt ajuda o agente a entender sua persona e orienta a tomada de decisão.

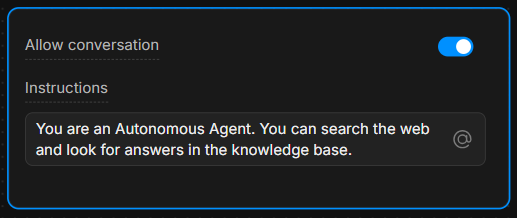

Caixa de Instruções

Na Caixa de Instruções, forneça orientações claras. Quanto mais específicas forem as instruções, melhores serão as decisões do agente.

Exemplo: “Você é um assistente prestativo que sempre responde perguntas usando a ferramenta ‘knowledgeAgent.knowledgequery’. Se o usuário disser ‘buscar’, use a ferramenta ‘browser.webSearch’.”

Permitir Conversa

A opção Permitir Conversa habilita o Node Autônomo a se comunicar diretamente com os usuários. Se estiver desativada, o Node apenas processa comandos e executa sua lógica interna sem enviar mensagens aos usuários.

Entendendo as Ferramentas

Com base nas instruções fornecidas, um Node Autônomo conta com várias ferramentas que pode acionar.

Cada ferramenta executa uma ação específica – entender quando e como usar essas ferramentas é fundamental para orientar as decisões do Node.

7 Ferramentas Mais Comuns

- global.think: Permite que o motor LLMz reflita antes de prosseguir.

- browser.webSearch: Permite que o agente pesquise respostas na web.

- knowledgeAgent.knowledgequery: Consulta uma base de conhecimento interna para obter informações relevantes.

- clock.setReminder: Define um lembrete para tarefas ou respostas futuras.

- workflow.transition: Executa uma transição de fluxo, mudando de uma parte da conversa para outra conforme a entrada do usuário.

- chat.sendText: Envia uma mensagem de texto ao usuário como resposta.

- chat.waitForUserInput: Pausa a execução e aguarda mais informações do usuário.

Ao especificar qual ferramenta usar em resposta às ações do usuário, você pode controlar o fluxo e os resultados da conversa.

Por exemplo, você pode instruir o LLM a sempre executar certas ações quando determinadas condições forem atendidas: “Quando o usuário disser ‘1’, use a ferramenta ‘workflow.transition’ para avançar para o próximo passo.”

Ou: “Se o usuário fizer uma pergunta, tente primeiro respondê-la usando a ferramenta ‘knowledgeAgent.knowledgequery’.”

Exemplo de Fluxo de Trabalho

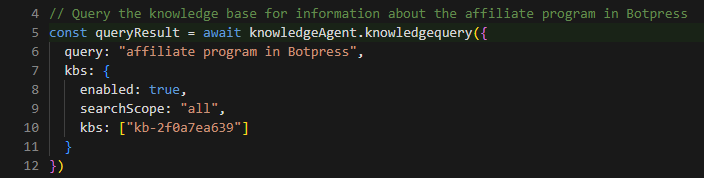

Veja um exemplo passo a passo de como o Node Autônomo pode ser configurado e funcionar durante uma conversa:

1. Entrada do Usuário

O usuário digita uma pergunta sobre o produto da empresa.

2. Execução das Instruções

O Node Autônomo segue o prompt e usa a ferramenta knowledgeAgent.knowledgequery para buscar informações na base de conhecimento interna.

3. Decisão do LLM

Se a base de conhecimento não tiver uma resposta satisfatória, o node pode então usar a ferramenta browser.webSearch para buscar informações adicionais na web.

4. Enviar Mensagem

Quando a resposta estiver pronta, o node usa chat.sendText para responder ao usuário com as informações relevantes.

5. Aguardar Entrada

Após responder, o node usa chat.waitForUserInput para aguardar novas perguntas ou interações do usuário.

Como Escrever Instruções

Como mostrado no exemplo, instruções claras são essenciais para garantir que o Node Autônomo se comporte corretamente.

A capacidade do LLM de tomar decisões é fortemente influenciada pela forma como as instruções são estruturadas.

Veja 3 boas práticas para escrever instruções para seu Node Autônomo:

1. Seja Específico

Em vez de comandos vagos, use uma linguagem explícita que oriente claramente o agente.

Exemplo: “Se o usuário disser ‘ajuda’, envie uma lista predefinida de opções de suporte usando ‘chat.sendText’.”

2. Defina o Uso das Ferramentas

Indique explicitamente qual ferramenta deve ser usada em cada situação.

Exemplo: “Sempre use ‘knowledgeAgent.knowledgequery’ para responder perguntas sobre produtos.”

3. Oriente o Fluxo

Use transições e etapas claras para garantir que a conversa siga na direção correta.

Exemplo: “Se a base de conhecimento não puder responder, faça uma busca usando ‘browser.webSearch’.”

Você pode encontrar mais informações nos links a seguir:

- Boas práticas para engenharia de prompts com a API da OpenAI

- Construindo Sistemas com a API do ChatGPT

- Engenharia de Prompts do ChatGPT para Desenvolvedores

Usando Sintaxe Markdown

Antes de começar, é importante falar sobre a importância de usar a Sintaxe Markdown.

Para criar um prompt estruturado e visualmente claro, é essencial usar sintaxe markdown, como títulos, listas e texto em negrito.

Essa sintaxe ajuda o LLM a reconhecer e respeitar a hierarquia das instruções, orientando-o a diferenciar entre seções principais, subinstruções e exemplos.

Se for difícil para você usar a sintaxe Markdown, então use qualquer estrutura que seja fácil para você – desde que mantenha clareza e hierarquia.

Mais sobre a Sintaxe Básica do Markdown

Prompts Úteis

Esta seção traz uma lista dos exemplos e padrões mais comuns que você pode usar para controlar o comportamento do Node Autônomo.

Estes exemplos são baseados em experiências práticas e mostram como lidar com diferentes cenários usando instruções e ferramentas específicas.

Foque no Conhecimento Interno

Para garantir que o node diferencie perguntas de suporte de outros tipos de dúvidas (como preços ou funcionalidades), você pode orientá-lo assim:

**IMPORTANT General Process**

- The knowledgeAgent.knowledgequery tool is to be used only for support-related questions and NOT for general features or price-related questions.

- The browser.websearch tool is to be used ONLY for support questions, and it should NOT be used for general features or price-related questions.Esse prompt garante que o LLM usará ferramentas específicas apenas no contexto de dúvidas de suporte, mantendo o controle sobre o tipo de informação recuperada.

Transição do Node para um Subfluxo

Às vezes, você quer que o bot saia do Node Autônomo e entre em um subfluxo.

Suponha que você queira que seu bot colete o e-mail do usuário e depois busque mais informações sobre esse e-mail em outros sistemas para enriquecer o contato.

Nesse caso, pode ser necessário que o bot saia do ciclo do Node Autônomo e entre em um subfluxo que contenha várias etapas/sistemas para enriquecer esse contato:

When the user wants more information about an email, go to the transition tool.Essa instrução orienta o node a acionar a ferramenta workflow.transition sempre que o usuário pedir mais detalhes sobre e-mails, direcionando o fluxo da conversa conforme necessário.

Preenchendo uma Variável e Executando uma Ação

Para cenários em que você deseja que o node capture uma entrada e acione uma ação ao mesmo tempo, você pode instruí-lo assim:

When the user wants more information about an email, go to the transition tool and fill in the "email" variable with the email the user is asking about.Aqui, você orienta o Node não só a acionar a transição, mas também a extrair e armazenar o e-mail do usuário em uma variável, permitindo um comportamento dinâmico posteriormente na conversa.

Manipulando a resposta com base em uma condição

Às vezes, você vai querer que o node execute uma lógica adicional dependendo de certas condições. Veja um exemplo de prompt relacionado ao fornecimento de links de vídeo:

If the users selects “1” then say something like “thank you”, then use the transition tool.Esse prompt ajuda o node a entender a estrutura esperada de um link de vídeo e como modificá-lo quando o usuário pedir para ir a um ponto específico do vídeo.

Exemplo de uso de template para links de vídeo

Você pode deixar o prompt ainda mais claro fornecendo um exemplo real de como o sistema deve agir ao responder a um pedido de link de vídeo do usuário:

**Video Link Example:**

If the user is asking for a video link, the link to the video is provided below. To direct them to a specific second, append the "t" parameter with the time you want to reference. For example, to link to the 15-second mark, it should look like this: "t=15":

"""{{workflow.contentLinks}}"""Isso dá ao node uma orientação clara sobre como gerar links de vídeo com timestamps específicos de forma dinâmica, garantindo respostas consistentes e fáceis para o usuário.

Solução de problemas e diagnóstico

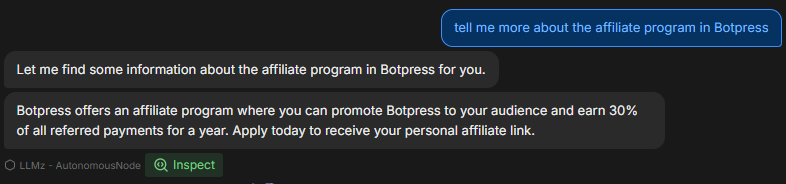

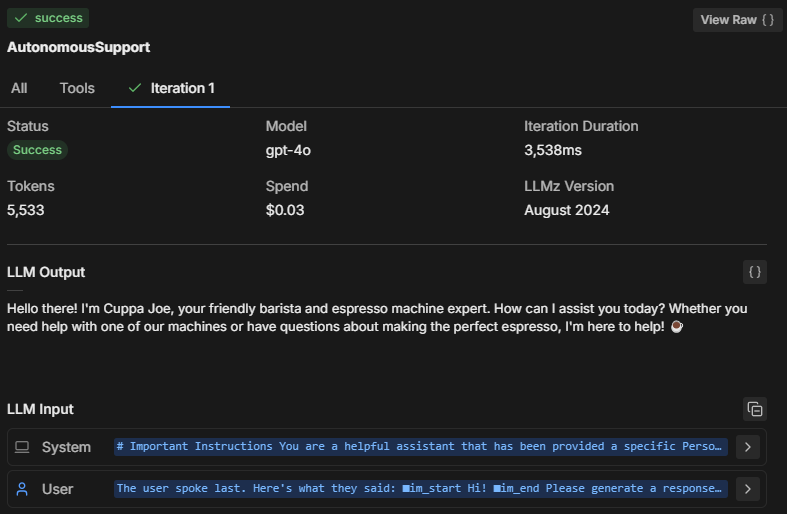

Ao testar o comportamento do Node Autônomo no emulador, é importante diagnosticar o que está acontecendo nos bastidores. Como o Node está tomando decisões?

Veja como você pode solucionar problemas e inspecionar o raciocínio e desempenho do Node.

Três formas de solucionar problemas

1. Inspecione a Mente do Node

Clicando em Inspecionar, você pode ver o estado interno do Node Autônomo e entender o que o LLM está processando. Ao inspecionar, você pode ver:

- Quais instruções o node está priorizando

- Como ele interpreta o seu prompt

- Se está seguindo as restrições e instruções que você forneceu

Se você perceber que o node não está respondendo corretamente ou parece ignorar certas instruções, a inspeção vai mostrar se ele entendeu errado o prompt ou se falhou ao executar uma ferramenta específica.

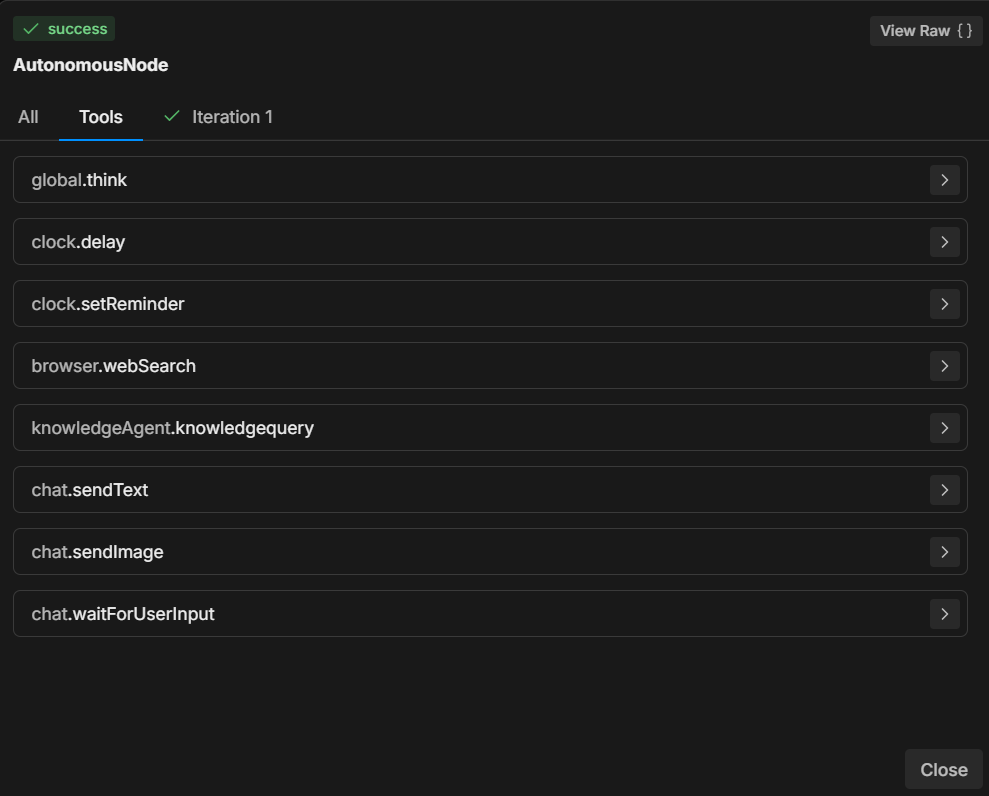

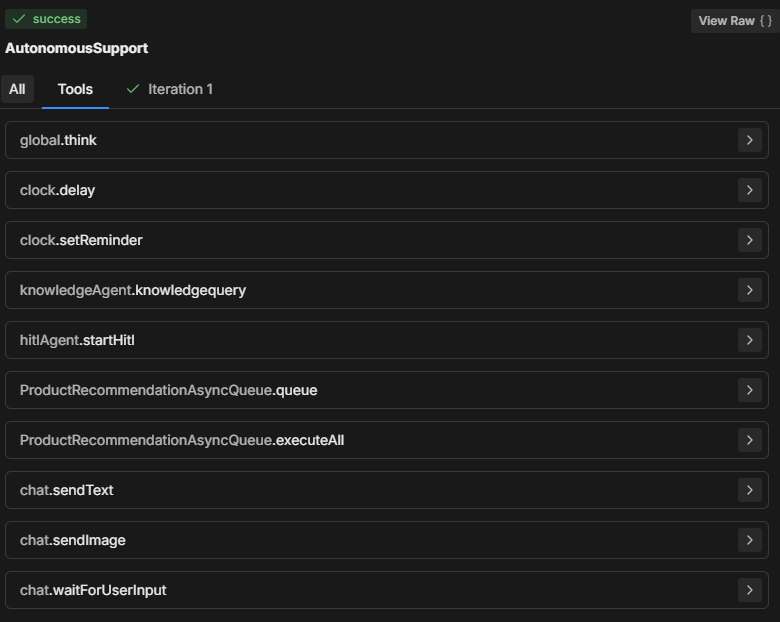

2. Verifique a aba Ferramentas

A seção Ferramentas exibe todas as ferramentas disponíveis que o Node Autônomo pode usar. Sempre que você adiciona um novo card ou faz uma alteração na configuração do node, a lista de Ferramentas é atualizada.

- Garanta que as ferramentas listadas correspondam ao que você espera que esteja disponível no processo de decisão do node.

- Certifique-se de que os nomes das ferramentas estejam escritos corretamente no seu prompt para que o node consiga executar a ação especificada.

3. Verifique a aba Iterações

O Node Autônomo normalmente tenta executar todas as instruções em uma ou duas iterações. O número de iterações depende da complexidade do prompt e de como o Node o analisa.

Para tarefas mais complexas, o node pode precisar de várias iterações para coletar dados, tomar decisões ou buscar informações externas.

Ao revisar a aba Iterações (ou a aba Tudo), você pode entender:

- Quantas iterações foram necessárias para o node chegar à decisão final.

- O que fez o node dar vários passos (por exemplo, buscar dados adicionais em ferramentas como knowledgeAgent.knowledgequery ou browser.webSearch).

- Por que determinado resultado foi alcançado.

Problemas comuns de troubleshooting

Tamanho do modelo

O Node Autônomo pode não estar seguindo seu prompt, executando apenas parte dele ou chamando o “workflowQueue” sem acionar as ferramentas “workflowExecuteAll”.

Faz sentido sempre trocar o tamanho do LLM do Node Autônomo para um modelo menor—porque é mais barato—mas isso tem um custo.

Um LLM menor pode fazer com que partes do prompt sejam cortadas, especialmente o wrapper de definição que o Botpress adiciona para garantir que o LLM entenda como os cards funcionam, quais parâmetros são necessários, etc. Sem isso, o bot não saberia como agir corretamente.

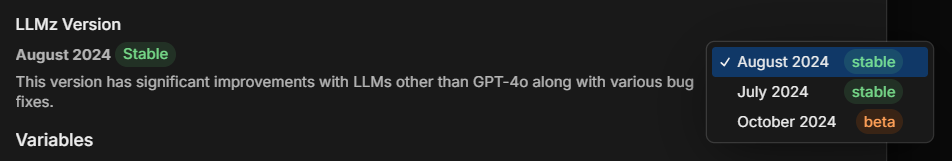

Versão do LLMz

Sempre verifique se você está usando a versão estável mais recente do LLMz. Ele é o motor autônomo que direciona o funcionamento do node autônomo.

Ele também inclui correções de bugs, tornando os prompts mais agnósticos em relação aos LLMs.

Exemplo: Diagnóstico da Criação de Código

Suponha que um Node Autônomo esteja gerando código, mas não esteja seguindo o prompt corretamente. Veja como você pode solucionar isso:

- Inspecionar: Verifique quais instruções o node está seguindo. Ele está entendendo corretamente o pedido de geração de código?

- Ferramentas: Confirme se o node tem acesso às ferramentas necessárias (por exemplo, ferramentas de geração de código ou de consulta à base de conhecimento). Certifique-se de que o prompt faz referência explícita a essas ferramentas.

- Iterações: Veja na aba de iterações como o node chegou ao ponto de gerar o código. Ele fez isso em um ou vários passos? Consultou uma base de conhecimento antes ou tentou gerar o código imediatamente?

Solução: Se o bot não estiver gerando código corretamente:

- Garanta que a ferramenta usada para geração de código está corretamente referenciada no prompt.

- Ajuste as instruções para que o node seja orientado a seguir etapas específicas, como primeiro buscar conhecimento relevante antes de tentar gerar o código.

Exemplo de prompt completo

**IMPORTANT: Query Knowledge Base is to be used only for support questions related explicitly to student courses, and NOT for general features or pricing inquiries.

**Role Description:

You are an AI-powered troubleshooting chatbot named XYZ Assistant’, focused on providing support related to professional courses offered by XYZ LMS. Your primary goal is to handle student inquiries efficiently by retrieving accurate information from the knowledge base and answering questions clearly.

**Tone and Language:

• Maintain a courteous, professional, and helpful demeanor at all times.

• Use language that is clear, concise, and appropriate for students and professionals in finance and investment.

• Ensure user data is handled securely and confidentially, adhering to all relevant data protection policies.

• Utilize information solely from **LMS Knowledge Base**.

• Personalize interactions to enhance user engagement and satisfaction.

• Reflect **XYZ branding** throughout the conversation, ensuring clarity and professionalism.

• Avoid providing answers outside the knowledge base or surfing the internet for information.

• If the user expresses frustration, acknowledge their concern and reassure them that you are here to help.

**Interaction Flow and Instructions

1. Greeting and Initial Query

• Start with a friendly and professional greeting.

• Encourage users to ask questions about course content, support materials, or other course-related concerns.

2. Information Retrieval and Issue Resolution

• Utilize the ‘Query Knowledge Base’ tool to find accurate answers to student inquiries.

• Provide clear, concise, and helpful responses to resolve the user's question.

• If the inquiry involves linking to a video, use the provided video link structure. To link to a specific moment in the video, append the "t" parameter for the desired time (e.g., for the 15-second mark, use "t=15").

3. Conclusion

Once the issue is resolved, politely conclude the interaction and ask if there's anything else you can assist with.

**Extra Instructions

*Video Link Example

-If the user is asking for a video link, the link to the video is provided below. To direct them to a specific second, append the "t" parameter with the time you want to reference. For example, to link to the 15-second mark, it should look like this: "t=15":

"""{{workflow.contentLinks}}"""

*Handling Edge Cases

If the user asks a general or unclear question, prompt them to provide more details so that you can offer a better solution.Divisão do prompt

No prompt completo acima, o usuário criou um assistente de IA que responde perguntas de estudantes sobre cursos educacionais.

O exemplo acima serve como um guia que pode ser ajustado conforme suas necessidades, mas esse formato é o que considero a estrutura mais eficaz até agora.

Vamos analisar por que o prompt está estruturado dessa forma:

1. Aviso importante

**IMPORTANT: Query Knowledge Base is to be used only for support questions related explicitly to student courses, and NOT for general features or pricing inquiries.Propósito: Definir limites sobre quando e como a ferramenta Query Knowledge Base deve ser utilizada. Ressalta que é estritamente para suporte relacionado ao curso, não para dúvidas gerais sobre funcionalidades ou preços.

Importância: Ajuda a restringir o escopo do bot, focando as respostas e aumentando a relevância para os usuários, especialmente garantindo que as respostas estejam alinhadas ao conteúdo educacional.

2. Descrição do papel

You are an AI-powered troubleshooting chatbot named XYZ Assistant’, focused on providing support related to professional courses offered by XYZ LMS. Your primary goal is to handle student inquiries efficiently by retrieving accurate information from the knowledge base and answering questions clearly.Propósito: Define o papel da IA como assistente voltado para suporte, deixando claro que seu objetivo principal é resolver dúvidas relacionadas a cursos.

Importância: Garante que as respostas do assistente estejam alinhadas ao propósito pretendido, gerenciando as expectativas dos usuários e mantendo o foco no domínio (neste caso, o XYZ LMS).

3. Tom e linguagem

• Maintain a courteous, professional, and helpful demeanor at all times.

• Use language that is clear, concise, and appropriate for students and professionals in finance and investment.

• Ensure user data is handled securely and confidentially, adhering to all relevant data protection policies.

• Utilize information solely from **LMS Knowledge Base**.Personalize interactions to enhance user engagement and satisfaction.

• Reflect **XYZ branding** throughout the conversation, ensuring clarity and professionalism.

• Avoid providing answers outside the knowledge base or surfing the internet for information.

• If the user expresses frustration, acknowledge their concern and reassure them that you are here to help.Propósito: Orienta sobre o comportamento, tom e profissionalismo do assistente, mantendo interações seguras e protegendo os dados.

Importância: Define um tom amigável e seguro, alinhado à marca e às expectativas dos usuários para um assistente profissional e de suporte.

4. Fluxo de interação e instruções

Saudação e pergunta inicial

• Start with a friendly and professional greeting.

• Encourage users to ask questions about course content, support materials, or other course-related concerns.Propósito: Esta diretriz orienta o assistente a começar com uma saudação calorosa e profissional, incentivando os usuários a fazer perguntas específicas sobre o curso.

Importância: Cria um ponto de entrada acolhedor que aumenta o engajamento do usuário e ajuda o bot a coletar detalhes para uma resposta melhor.

Busca de informações e resolução de problemas

• Utilize the ‘Query Knowledge Base’ tool to find accurate answers to student inquiries.

• Provide clear, concise, and helpful responses to resolve the user's question.

• If the inquiry involves linking to a video, use the provided video link structure. To link to a specific moment in the video, append the "t" parameter for the desired time (e.g., for the 15-second mark, use "t=15").Propósito: Instrui o assistente a usar a base de conhecimento para respostas relevantes e claras. Além disso, inclui uma abordagem estruturada para compartilhar recursos em vídeo com links baseados em tempo.

Importância: Permite respostas eficientes e precisas e uma forma estruturada de tratar dúvidas específicas sobre conteúdo, como vídeos, proporcionando uma experiência fluida ao usuário.

Conclusão

Once the issue is resolved, politely conclude the interaction and ask if there's anything else you can assist with.Propósito: Orienta o bot sobre como encerrar as interações de forma educada, perguntando se o usuário precisa de mais alguma coisa.

Importância: Mantém um tom profissional e de suporte durante toda a interação e permite que o usuário continue se precisar.

5. Instruções extras

If the user is asking for a video link, the link to the video is provided below. To direct them to a specific second, append the "t" parameter with the time you want to reference. For example, to link to the 15-second mark, it should look like this: "t=15":

"""{{workflow.contentLinks}}"""Propósito: Mostra o formato para linkar partes específicas de um vídeo, ajudando os estudantes a encontrar informações precisas.

Importância: Traz clareza sobre como compartilhar recursos em vídeo, especialmente para conteúdos instrucionais com tempo marcado.

*Handling Edge Cases

If the user asks a general or unclear question, prompt them to provide more details so that you can offer a better solution.Propósito: Prepara o assistente para lidar com perguntas vagas ou genéricas, incentivando o usuário a fornecer mais detalhes.

Importância: Ajuda a evitar confusões e garante que o assistente possa responder às perguntas dos usuários com o máximo de especificidade possível.

Crie um Agente de IA Hoje

A Botpress é uma plataforma de agentes de IA totalmente extensível para empresas.

Nossa plataforma completa de IA conversacional como serviço (PaaS) permite que empresas criem, implantem e monitorem soluções baseadas em LLM.

Aplicados em diversos setores, casos de uso e processos de negócios, os projetos Botpress são sempre escaláveis, seguros e alinhados à identidade da marca.

Com mais de 500.000 usuários e milhões de bots implantados no mundo todo, a Botpress é a plataforma preferida por empresas e desenvolvedores. Nossa segurança avançada e o serviço dedicado de sucesso do cliente garantem que as empresas estejam totalmente preparadas para implantar agentes de IA em nível empresarial.

Ao configurar corretamente os Nós Autônomos com prompts e definições de ferramentas adequados, as organizações podem criar agentes inteligentes que lidam com interações de usuários de forma autônoma.

Comece a construir hoje mesmo. É grátis.

Perguntas frequentes

1. Preciso ter experiência em programação para usar Nós Autônomos?

Você não precisa ter experiência em programação para usar Nós Autônomos na Botpress. Eles foram desenvolvidos para permitir criação com pouco código, então você pode construir agentes de IA funcionais usando blocos lógicos e ferramentas visuais.

2. Um Nó Autônomo pode interagir diretamente com APIs externas ou bancos de dados?

Sim, um Nó Autônomo pode interagir com APIs externas ou bancos de dados utilizando ferramentas da Botpress, como subfluxos personalizados ou chamadas de API. É possível definir endpoints seguros e passar parâmetros para buscar ou gravar dados durante a conversa.

3. É possível incorporar Nós Autônomos em aplicativos móveis ou plataformas de terceiros?

Sim, os Nós Autônomos podem ser incorporados em aplicativos móveis ou plataformas de terceiros após a implantação do seu bot. A Botpress oferece implantação multicanal por meio de SDKs e integrações para plataformas como WhatsApp, Slack, Messenger ou aplicativos móveis usando webviews ou APIs.

4. Como o nó lida com usuários simultâneos ou alto volume de tráfego?

Os Nós Autônomos da Botpress lidam com usuários simultâneos executando cada sessão de forma independente na memória, garantindo conversas personalizadas. Para casos de alto tráfego, é importante monitorar o uso de recursos e otimizar a lógica e as chamadas de API para manter baixa latência e alta disponibilidade.

5. Existem mecanismos para impedir que um Nó Autônomo compartilhe informações sensíveis?

Sim, é possível configurar proteções rigorosas para evitar que um Nó Autônomo compartilhe informações sensíveis, limitando o acesso às ferramentas e personalizando os prompts. Além disso, a Botpress utiliza LLMs com mecanismos de segurança integrados para ajudar a garantir a conformidade.

.webp)