- Chain-of-Thought-Prompting führt KI-Modelle dazu, Schritt für Schritt zu argumentieren, wodurch sie komplexe Aufgaben genauer lösen können, als wenn sie nur das nächste Wort vorhersagen.

- Am besten geeignet für mehrstufige Aufgaben wie Mathematik, Logikrätsel oder Abläufe – aber unnötig für einfache Fakten oder einstufige Fragen.

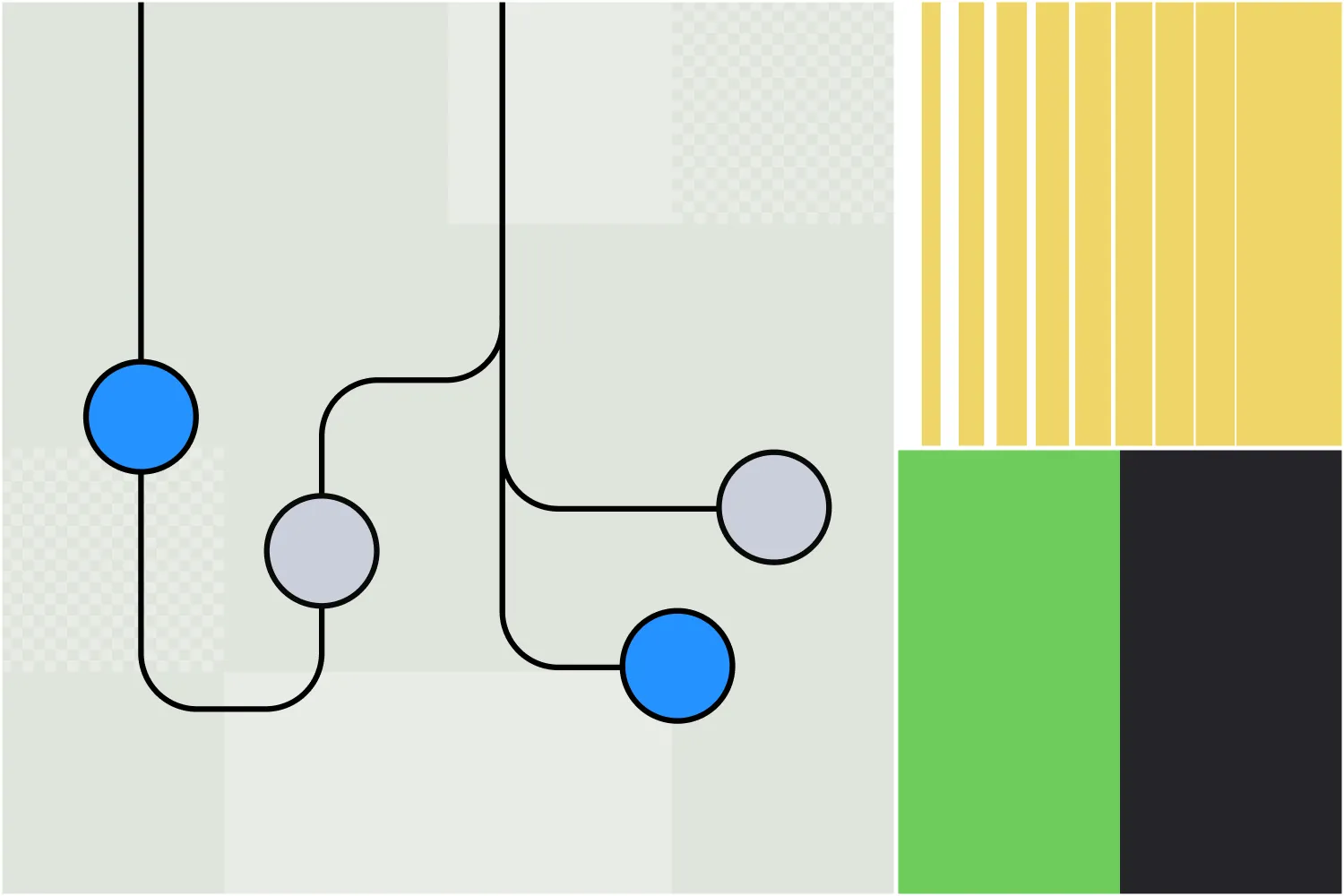

- Prompt Chaining unterscheidet sich vom Chain-of-Thought-Prompting, indem es eine Aufgabe in mehrere einzelne Prompts aufteilt, während Chain-of-Thought innerhalb eines einzigen Prompt-Antwort-Flows bleibt.

Wenn Sie schon einmal einen GPT-Chatbot wie ChatGPT genutzt haben, ist Ihnen sicher die unterschiedliche Qualität der Antworten aufgefallen.

Manchmal liefert die KI genau das, was Sie brauchen. Manchmal hat man jedoch das Gefühl, dass die ‚Intelligenz‘ in KI eher eine Farce ist.

Du kannst dein ChatGPT-Erlebnis verbessern, indem du gezielter promptest. Chain-of-Thought-Prompting regt LLM-Agenten dazu an, Schritt für Schritt über eine Aufgabe nachzudenken, bevor sie eine Antwort generieren.

Neuere KI-Modelle und Funktionen integrieren Chain-of-Thought-Reasoning direkt, sodass ihre Modelle automatisch Schritt für Schritt durch das Problem gehen – ganz ohne zusätzliche Prompts.

Was ist Chain-of-Thought-Prompting?

Chain-of-Thought-Prompting ist eine Technik im Prompt Engineering, bei der KI-Modelle angewiesen werden, komplexe Aufgaben in Einzelschritte zu zerlegen und jeden Schritt vor der Antwort zu durchdenken.

Vielleicht hören Sie auch den Begriff ‚Chain-of-Thought-Reasoning‘. Damit ist der schrittweise Denkprozess gemeint, mit dem das Modell die jeweilige Aufgabe durchdenkt.

Die OpenAI o1-Modelle benötigen kein Chain-of-Thought-Prompting, da sie diese Art des Denkens bereits integriert haben. Sie können Chain-of-Thought-Prompting aber mit jedem LLM-basierten Chatbot nutzen.

Wie funktioniert Chain-of-Thought-Reasoning?

Chain-of-Thought-Reasoning bedeutet, ein Problem in kleinere, logische Schritte zu zerlegen, damit der KI-Chatbot sie nacheinander lösen kann.

Zuerst identifiziert die KI die wichtigsten Teile des Problems. Dann bearbeitet sie jeden Teil nacheinander und berücksichtigt dabei, wie ein Schritt zum nächsten führt. Jeder Schritt baut auf dem vorherigen auf, sodass die KI methodisch zu einer logischen Schlussfolgerung gelangt.

Beispiele für Chain-of-Thought-Prompting

Der berühmte ‚Strawberry‘-Prompt

ChatGPT und andere LLMs haben gut dokumentierte Schwächen. Eine davon ist ihre Unfähigkeit, korrekt zu erkennen, wie viele 'R' im Wort ‚strawberry‘ enthalten sind. (Wahrscheinlich die berühmte Einschränkung, die hinter dem Codenamen der o1-Modelle steht: Strawberry.)

ChatGPT-4o verwendet kein Chain-of-Thought-Reasoning. Stattdessen greift es auf Trainingsdaten zurück und generiert eine Antwort basierend auf der Wahrscheinlichkeit, mit der ein Wort auf das vorherige folgt. Auch wenn es meist richtig klingt, imitiert es nur menschliche Sprache – es denkt nicht nach oder recherchiert.

Wenn Sie ChatGPT-4o die berühmte Erdbeerfrage stellen, kann es die richtige Antwort nicht geben:

Sie können jedoch eine Chain-of-Thought-Prompting-Technik verwenden, um dem LLM-basierten Chatbot zu helfen, zur richtigen Antwort zu gelangen:

Die neueste Version von ChatGPT, betrieben durch OpenAI o1-preview, ist das erste große LLM, das Chain-of-Thought-Reasoning ohne zusätzliche Prompts nutzt.

Es findet die Antwort beim ersten Versuch, weil es so programmiert ist, automatisch denselben Prozess wie beim zweiten ChatGPT-4o-Prompt oben zu befolgen. Der einzige Unterschied: Es macht das ohne zusätzlichen Prompt.

Mathematik

Wenn Sie einer älteren Version von ChatGPT eine Mathematikaufgabe aus einem Grundschulbuch gestellt hätten, hätte sie nicht immer die richtige Antwort gegeben.

Mehrstufige Mathematikaufgaben erfordern logisches Denken – das konnten frühere LLMs nicht. Man konnte zwar jeden Schritt einzeln eingeben, aber wenn man die richtigen Schritte nicht kannte, konnte ein LLM nicht helfen.

ChatGPT-4o kann die Antwort auf die Frage finden, indem es die einzelnen Schritte des Problems nachvollzieht:

KI-Agenten, die mit Hubspot verbunden sind

Für ein Praxisbeispiel nehmen wir einen LLM-gestützten KI-Agenten, der in Hubspot integriert ist. Ein Vertriebsteam nutzt diesen Agenten, um neue Leads aus verschiedenen Kanälen zu verarbeiten.

Szenario

Ein Vertriebsmitarbeiter schickt einen neuen Lead an den KI-Agenten und bittet ihn, diesen in Hubspot einzutragen und eine erste Kontaktmail zu senden – aber nicht, wenn der Lead bei einem Unternehmen arbeitet, das bereits als Interessent geführt wird.

LLM ohne Chain-of-Thought-Reasoning

Der LLM-basierte KI-Agent registriert den Lead und versendet die E-Mail, prüft aber nicht, ob das Unternehmen bereits ein Interessent ist – die entscheidende Bedingung fehlt.

LLM mit Chain-of-Thought-Reasoning

Der KI-Agent auf LLM-Basis prüft, ob das Unternehmen bereits als Interessent erfasst ist. Ist das der Fall, überspringt er die Registrierung und das Versenden der E-Mail; andernfalls registriert er den Lead und verschickt die E-Mail – genau nach den Vorgaben des Vertriebsmitarbeiters.

Wann sollte ich Chain-of-Thought-Prompting verwenden?

Chain-of-Thought-Prompting eignet sich besonders für Szenarien, die schrittweises Denken erfordern.

Geeignete Aufgaben sind solche, die logische Schlussfolgerungen, Mathematik, prozedurale Aufgaben oder Situationen mit mehrstufigen Antworten erfordern.

Aber Moment: Logisches Denken klingt super – warum sollte ich es nicht immer nutzen?

Gute Frage. Nicht alle Fragen erfordern eine Begründung. Zum Beispiel:

- Einfache Wissensfragen wie „Was ist die Hauptstadt von Kanada?“

- Einfache Aufgaben, wie „Was ist 145 + 37?“

- Aufgaben zur Inhaltserstellung, wie zum Beispiel: „Schreibe eine höfliche E-Mail mit drei Sätzen, in der ich meinen Kollegen frage, ob er mit seinem Projekt schon fertig ist.“

Prompting-Änderung vs. Chain-of-Thought-Prompting

Auch wenn die Begriffe ähnlich klingen, sind Prompt Chaining und Chain-of-thought-Prompting unterschiedliche Strategien, um die Ergebnisse generativer KI zu verbessern.

Chain-of-thought-Prompting

Mit Chain-of-Thought-Prompting fordert der Nutzer die KI auf, die Begründung für ihre Antwort in einer einzigen Antwort zu erklären. Die KI geht dabei Schritt für Schritt durch den Lösungsweg – aber alles in einem Prompt und einer Antwort.

Ein Beispiel für ein Chain-of-Thought Prompt in einer Nachricht:

"Ein HR-Team muss 5 Mitarbeiterbeurteilungen prüfen. Jede dauert 30 Minuten, und sie benötigen vorher 15 Minuten Vorbereitung. Für Senior-Bewertungen sind jeweils 10 Minuten zusätzlich nötig. Wie lange dauert es, 5 Senior- und 25 Junior-Bewertungen abzuschließen? Erklären Sie Ihre Überlegungen Schritt für Schritt."

Prompt Chaining

Beim Prompt Chaining wird die Aufgabe in einzelne Schritte mit mehreren Prompts unterteilt, wobei jeder auf dem vorherigen Ergebnis aufbaut. So wird die KI gezielt und strukturiert durch eine komplexe Aufgabe geführt, die meist auch Überlegungen erfordert.

Der erste Prompt könnte lauten:

Prompt 1: Identifizieren Sie die wichtigsten Herausforderungen, denen ein Unternehmen beim Wechsel zur Remote-Arbeit begegnen könnte.

Ausgabe:

- Kommunikationslücken

- Aufrechterhaltung der Produktivität

- Technische Infrastruktur

- Mitarbeiterbindung

Die nächsten Prompts gehen dann tiefer auf diese Themen ein. Zum Beispiel:

Prompt 2: Bitte erklären Sie, wie ein Unternehmen Lösungen für Kommunikationslücken beim Übergang zur Remote-Arbeit finden kann.

Nach der nächsten Ausgaberunde könnte das nächste Glied der Kette sein:

Prompt 3: Was sind die häufigsten Herausforderungen, denen Unternehmen bei der Einführung solcher Lösungen begegnen?

Obwohl sich beide Methoden ähneln, verfolgen sie unterschiedliche Ansätze, um möglichst relevante und tiefgehende Inhalte aus generativen KI-Tools zu gewinnen.

Chain-of-Thought-Prompting in Botpress

Botpress-Nutzer kennen bereits eine Funktion, die Chain-of-Thought-Reasoning verwendet.

Der Autonomous Node wurde im Juli 2024 auf Botpress eingeführt, einer Plattform zum Erstellen von KI-Agenten. Der Autonomous Node kann mehrstufige Workflows automatisieren und eigenständig Entscheidungen treffen.

Ein Autonomous Node kann mit einer einfachen Textzeile erstellt und angestoßen werden, etwa: ‚Deine Aufgabe ist es, qualifizierte Leads zu generieren. Erstelle Leads in Salesforce, wenn ein Nutzer Kaufinteresse zeigt.‘

Der KI-Agent, den Sie mit diesem Autonomous Node erstellen, führt eigenständig verschiedene Aktionen aus, um sein Ziel zu erreichen – unabhängig von von Menschen entworfenen Workflows. Er kann auch je nach Bedarf zwischen verschiedenen LLMs wechseln und dabei entscheiden, ob Geschwindigkeit oder Leistung Priorität hat.

Einen eigenen autonomen Agenten bauen

Botpress ist die einzige KI-Agenten-Plattform, mit der Sie wirklich autonome Agenten erstellen können.

Das offene und flexible Botpress Studio ermöglicht unzählige Anwendungsfälle in verschiedensten Branchen – von HR bis Leadgenerierung. Mit unserer Bibliothek an vorgefertigten Integrationen und umfangreichen Tutorials können Nutzer KI-Agenten einfach von Grund auf bauen.

Jetzt starten. Kostenlos.

Oder kontaktieren Sie unser Vertriebsteam.

FAQs

1. Ist Chain-of-Thought-Prompting nur für KI-Modelle nützlich oder spiegelt es auch menschliches Problemlösen wider?

Chain-of-Thought-Prompting ist sowohl für KI-Modelle als auch für Menschen hilfreich, da es das natürliche Vorgehen beim Lösen komplexer Probleme nachahmt: Schritt für Schritt durchdenken.

2. Wie unterscheidet sich Chain-of-Thought-Reasoning vom einfachen „Schritt-für-Schritt-Denken“?

Während „Schritt für Schritt denken“ ein allgemeiner Ansatz ist, ist Chain-of-Thought-Reasoning strukturierter und bewusster: Das KI-Modell wird dazu angeleitet, Zwischenschritte explizit zu formulieren, statt direkt zum Ergebnis zu springen.

3. Warum verwenden manche LLMs standardmäßig kein Chain-of-Thought-Reasoning?

Einige LLMs, insbesondere ältere oder kleinere Modelle, nutzen Chain-of-Thought-Reasoning nicht standardmäßig, da sie nicht darauf trainiert wurden, mehrstufige Ausgaben zu erzeugen, sondern sich auf die Vorhersage wahrscheinlicher Antworten anhand von Trainingsdatenmustern konzentrieren.

4. Ist Chain-of-Thought-Prompting eine Form des „Trainings“ des Modells während der Ausführung?

Nein, Chain-of-Thought-Prompting ist keine Form des Trainings; es verändert weder die Gewichte noch das Wissen des Modells. Stattdessen beeinflusst es das Antwortverhalten während der Ausführung, indem es durch den Prompt zu strukturiertem Denken anregt.

5. Verbessert Chain-of-Thought-Prompting immer die Genauigkeit?

Chain-of-thought Prompting verbessert nicht immer die Genauigkeit. Es hilft meist bei Aufgaben, die mehrstufiges Denken erfordern, kann bei einfachen Aufgaben aber unnötig verkomplizieren und sogar die Leistung verschlechtern.

.webp)