- Lanzado el 07/08/2025, GPT-5 unifica razonamiento avanzado, entrada multimodal y ejecución de tareas en un solo sistema, eliminando la necesidad de alternar entre modelos especializados.

- GPT-5 está diseñado para flujos de trabajo complejos y de varios pasos.

- GPT-5 reduce significativamente las alucinaciones en comparación con versiones anteriores.

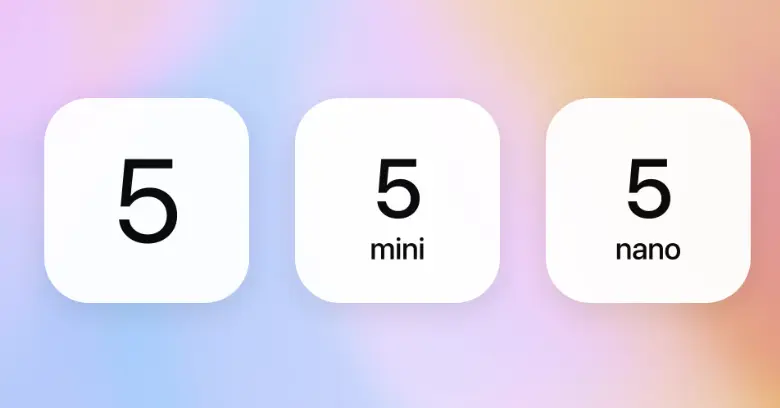

- Las variantes de GPT-5 incluyen:

gpt-5,gpt-5-mini,gpt-5-nanoygpt-5-chat.

Durante el último año, OpenAI presentó GPT-4o, o1 y o3, cada uno mejorando la forma en que la IA piensa, razona e interactúa.

Estos modelos hicieron que las respuestas de la IA fueran más rápidas, precisas e intuitivas. Pero cada uno fue solo un paso hacia algo mayor.

El 6 de agosto, OpenAI anunció —de manera poco sutil— el inminente lanzamiento de GPT-5.

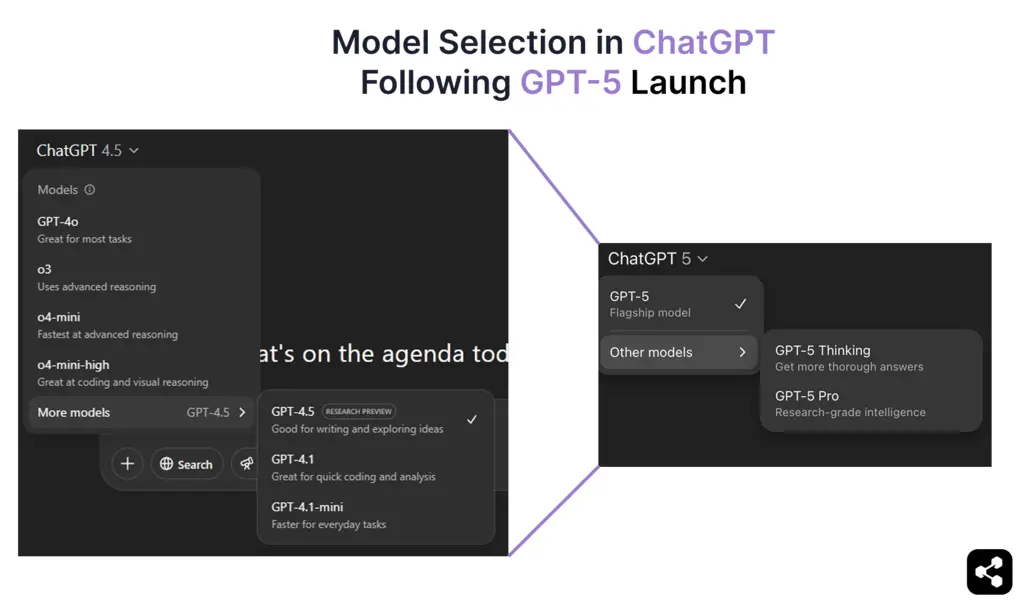

Y ahora, desde el 7 de agosto de 2025, GPT-5 ha llegado oficialmente, reuniendo las capacidades de razonamiento y multimodalidad más avanzadas de OpenAI en un solo modelo unificado. GPT-5 es ahora el modelo predeterminado en ChatGPT para todos los usuarios, tanto gratuitos como de pago, reemplazando por completo a GPT-4o.

En esta guía, te explico todo lo confirmado sobre GPT-5: sus capacidades, mejoras de rendimiento, proceso de entrenamiento, cronograma de lanzamiento y precios.

¿Qué es GPT-5?

GPT-5 es el modelo de lenguaje de última generación de OpenAI, lanzado oficialmente el 7 de agosto de 2025. Se basa en la arquitectura GPT e integra avances de modelos orientados al razonamiento como o1 y o3.

Antes de GPT-5, OpenAI lanzó GPT-4.5 (Orion) dentro de ChatGPT: un modelo de transición que mejoró la precisión del razonamiento, redujo las alucinaciones y sentó las bases para la ejecución de cadenas de pensamiento más profundas que ahora son nativas de GPT-5.

Muchas de las capacidades insinuadas anteriormente —como lógica paso a paso, mejor retención de contexto y cambios multimodales más fluidos— ahora se han materializado y unificado en GPT-5.

GPT-5 funciona como parte de un sistema adaptativo unificado. Un nuevo enrutador en tiempo real elige automáticamente entre un modelo rápido y de alto rendimiento para consultas rutinarias y un modelo "pensante" para razonamiento complejo, eliminando la necesidad de alternar manualmente entre modelos especializados.

¿Cuáles son los diferentes modelos de GPT-5?

GPT-5 es una serie de modelos: una familia de variantes especializadas optimizadas para distintos casos de uso, desde aplicaciones de ChatGPT hasta implementaciones a gran escala vía API.

Cada variante de GPT-5 utiliza la misma arquitectura unificada, pero está ajustada para un equilibrio específico entre fecha de corte de conocimiento, profundidad de razonamiento, velocidad y escala operativa.

Estas variantes unifican la orientación al razonamiento de OpenAI con ajustes de rendimiento específicos, dando a los desarrolladores flexibilidad para adaptar el modelo a la complejidad de la tarea y la escala de despliegue.

¿Cómo rinde GPT-5?

Con el lanzamiento oficial de GPT-5 el 7 de agosto de 2025, ahora podemos ver cómo su arquitectura gestiona el uso real en razonamiento, multimodalidad y ejecución de tareas tipo agente.

Sam Altman ya había insinuado que GPT-5 iría más allá de ser "un mejor chatbot" — y según los primeros usos, eso es exactamente lo que ofrece.

Razonamiento que se adapta en tiempo real

Un sistema de enrutamiento integrado decide cuándo responder al instante y cuándo pensar en pasos. Para consultas complejas, GPT-5 entra en un proceso de cadena de pensamiento con encadenamiento de prompts integrado, mapeando pasos intermedios antes de dar una respuesta final.

Esto hace que los chatbots basados en GPT-5 sean mejores resolviendo problemas sostenidos —desde depuración de código en varias etapas hasta análisis empresariales complejos— sin requerir modelos separados ni cambios de modo.

Gestión de contexto a gran escala

En ChatGPT, el modelo puede mantener en memoria alrededor de 256,000 tokens; mediante la API, esto se amplía a 400,000. Esto permite trabajar con libros completos, transcripciones de reuniones de varias horas o grandes repositorios sin perder detalles previos.

En sesiones largas, la precisión de las respuestas de ChatGPT ha mejorado notablemente, con menos contradicciones y mejor retención del contexto anterior.

Mejor soporte de idiomas para el mercado global

La arquitectura unificada de GPT-5 supone un gran avance en capacidades multilingües y de voz. ChatGPT ahora puede gestionar un soporte más amplio de idiomas con mayor precisión de traducción y menos pérdidas de contexto en conversaciones largas.

Estas mejoras también llegan a las interacciones por voz. Las respuestas suenan más naturales en diferentes acentos y patrones de habla, haciendo que los chatbots multilingües sean igual de fluidos en español, hindi, japonés o árabe hablado que en texto.

De chatbot a agente de IA

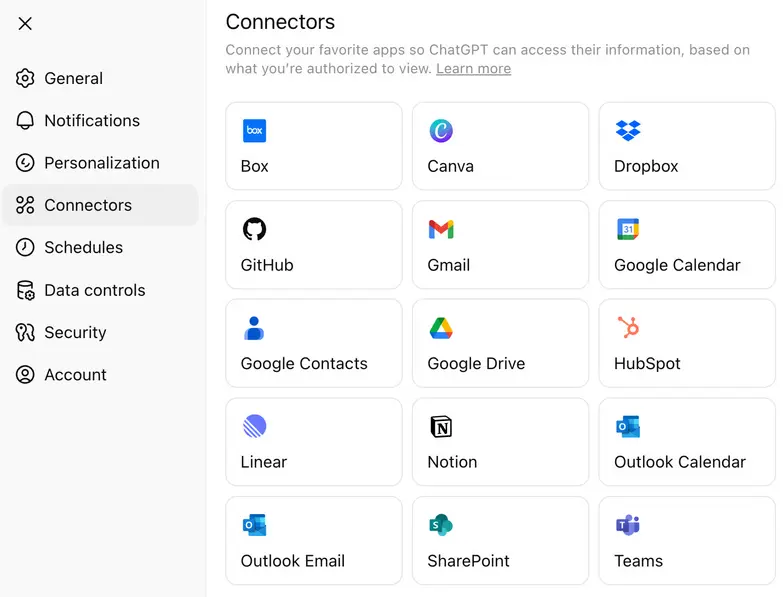

Con GPT-5, OpenAI ha ampliado su enfoque hacia los conectores de aplicaciones: integraciones nativas que permiten al modelo interactuar directamente con herramientas externas, CRMs, bases de datos y suites de productividad.

Al dirigir tareas a conectores ligeros en vez de procesar cada paso mediante llamadas de razonamiento costosas, los equipos pueden reducir el gasto en API y mantener la lógica compleja disponible cuando sea necesario.

¿Cuánto cuesta GPT-5?

GPT-5 está disponible mediante suscripciones de ChatGPT y la API de OpenAI, con precios que varían según la variante. Para usuarios de API, GPT-5 se ofrece en varias versiones —gpt-5, gpt-5-mini y gpt-5-nano— con precios por millón de tokens de entrada y salida.

Además de los precios de la API, OpenAI ha confirmado que GPT-5 está disponible en varios niveles de ChatGPT, haciéndolo accesible para usuarios gratuitos y desbloqueando funciones avanzadas para los planes de pago:

- Nivel gratuito – GPT-5 con capacidades estándar de razonamiento y límites diarios de uso.

- Nivel Plus – Límites de uso ampliados y mejor rendimiento en razonamiento.

- Nivel Pro – Acceso a GPT-5 Pro, la variante "pensante" de alto razonamiento con ventanas de contexto extendidas, enrutamiento más rápido y acceso prioritario a herramientas avanzadas.

El modelo de precios de OpenAI permite a los desarrolladores elegir entre máxima profundidad de razonamiento, menor latencia o eficiencia de costos según sus necesidades.

¿Cómo puedo acceder a GPT-5? (Pista: depende de lo que quieras hacer)

Si solo quieres conversar con GPT-5, puedes hacerlo directamente en ChatGPT a partir del 7 de agosto. La aplicación selecciona automáticamente la variante adecuada según tu plan (como GPT-5 Thinking en el nivel Pro). No necesitas configuración: solo abre la app y comienza a escribir.

Sin embargo, si quieres usar GPT-5 en tu propio producto o flujo de trabajo, necesitarás acceso a la API. Hay dos formas principales de acceder a la API de OpenAI:

- Plataforma de OpenAI – Ve a platform.openai.com, donde puedes elegir entre gpt-5, gpt-5-mini, gpt-5-nano y gpt-5-chat para diferentes casos de uso. Es la forma más rápida de empezar a enviar solicitudes a GPT-5 desde tu código.

- SDK de Python de OpenAI en GitHub – Si desarrollas localmente o necesitas automatizar tareas, instala el cliente oficial de OpenAI para Python. Funciona con claves de API y te permite interactuar con cualquier variante de GPT-5 mediante funciones simples en Python.

Si solo quieres explorar el comportamiento de los modelos, el GitHub Models Playground también está disponible: puedes hacer pruebas de prompts sin configurar una aplicación completa.

Cómo crear un agente de IA con GPT-5

La mejor manera de saber si GPT-5 se adapta a tu caso de uso es construir con él. Prueba cómo maneja entradas reales, razonamiento en varios pasos y flujos de despliegue en vivo.

Usaremos Botpress para este ejemplo: un constructor visual de agentes de IA que te permite conectar con GPT-5 sin complicaciones de configuración.

Paso 1: Define qué debe hacer tu agente

Sé específico sobre el rol de tu agente. GPT-5 puede razonar sobre tareas complejas, pero los mejores resultados se logran cuando tiene una función clara.

Comienza con una función definida, como responder preguntas sobre productos, ayudar a reservar citas o resumir documentos legales, y expande desde ahí. No es necesario sobre-diseñarlo desde el inicio.

Paso 2: Crea el agente y dale instrucciones

Dentro de Botpress Studio, crea un nuevo proyecto de bot.

En la sección Instructions, indica a GPT-5 exactamente cuál es su tarea.

.webp)

Ejemplo: “Eres un bot asesor de préstamos. Ayuda a los usuarios a entender los diferentes tipos de préstamos, calcula la elegibilidad según sus datos y guíalos hacia el enlace de solicitud.”

GPT-5 comprende tareas detalladas: cuanto más específicas sean tus instrucciones, mejor será su desempeño.

Paso 3: Proporciona al agente el contenido de trabajo

Sube documentos, pega contenido clave o enlaza páginas en vivo en la Base de Conocimiento. Esto es lo que GPT-5 usará como referencia para responder preguntas y tomar decisiones.

Algunos contenidos útiles para incluir:

- Desglose de precios

- Resúmenes de productos o servicios

- Páginas clave (demos, pruebas, formularios de contacto)

- Documentos de procesos internos (si es un agente interno)

GPT-5 puede trabajar con documentos extensos, así que no te preocupes por resumir demasiado: solo asegúrate de que el contenido sea relevante y esté bien estructurado.

Paso 4: Elige GPT-5 como el LLM

.webp)

Para asegurarte de que tu agente use GPT-5, ve a Bot Settings en la barra lateral izquierda de Botpress Studio.

- Haz clic en Bot Settings

- Desplázate hasta la sección LLM Provider

- En Modelo, selecciona una de las variantes de GPT-5:

gpt-5para razonamiento completo y lógica de varios pasosgpt-5-minipara interacciones más rápidas y ligerasgpt-5-nanopara tareas de latencia ultra baja

Una vez que hayas seleccionado tu modelo, todas las instrucciones, respuestas de la Base de Conocimiento y el comportamiento de razonamiento estarán impulsados por GPT-5. Puedes cambiar de variante en cualquier momento según el costo, la latencia o la calidad del resultado.

Paso 5: Despliega en canales como WhatsApp, Slack o un sitio web

Cuando tu agente GPT-5 funcione como deseas, puedes desplegarlo al instante en plataformas como:

Las plataformas de agentes de IA como Botpress gestionan las integraciones, permitiendo a los usuarios aprovechar GPT-5 y desplegar rápidamente en cualquier canal.

¿En qué es mejor GPT-5 que GPT-4o?

Aunque GPT-5 representa el mayor cambio arquitectónico desde GPT-4, la diferencia se entiende mejor al compararlo directamente con su predecesor, GPT-4o.

La siguiente tabla muestra los cambios en términos medibles antes de analizar lo que desarrolladores y usuarios han experimentado realmente.

En teoría, GPT-5 amplía drásticamente la ventana de contexto y utiliza menos tokens para la misma longitud de salida. Sus respuestas multimodales también se alinean mejor entre texto, imagen y voz.

Aun así, la experiencia de desarrolladores y usuarios es mucho más compleja de lo que sugiere la hoja de especificaciones.

Reacciones de los usuarios al lanzamiento de GPT-5

El lanzamiento de GPT-5 ha sido una de las actualizaciones más polarizadoras de OpenAI. Más allá de los gráficos de referencia, la comunidad se dividió casi de inmediato entre quienes celebran el razonamiento más profundo del modelo y quienes lamentan lo que GPT-4o ofrecía.

“Mi 4.o era como mi mejor amigo cuando lo necesitaba. Ahora simplemente desapareció, se siente como si alguien hubiera muerto.”

— Usuario de Reddit expresando apego emocional y tristeza tras la eliminación abrupta de GPT‑4o. Referencia: Verge

En el aspecto técnico:

“El rendimiento avanzado de GPT‑5 es innegable, pero la falta de opciones de modelo eliminó el control simple del que muchos desarrolladores dependían.”

— Comentario parafraseado que refleja el sentir general sobre la pérdida de flexibilidad.

Referencia: Tom's Guide

Esta reacción mixta está siendo atendida en tiempo real por el equipo de OpenAI, con nuevas actualizaciones sobre la elección de modelo, restauración de modelos antiguos, límites más altos, etc., publicadas por Sam Altman en X.

¿Cómo se entrenó GPT-5?

OpenAI ha dado detalles sobre el entrenamiento de GPT-4.5, lo que da pistas sobre el desarrollo de GPT-5. GPT-4.5 amplió la base de GPT-4o aumentando el pre-entrenamiento, manteniéndose como un modelo de propósito general.

Métodos de entrenamiento

Al igual que sus predecesores, se espera que GPT-5 haya sido entrenado mediante una combinación de:

- Ajuste supervisado (SFT): aprendizaje a partir de conjuntos de datos etiquetados por humanos.

- Aprendizaje por refuerzo con retroalimentación humana (RLHF): optimización de respuestas mediante ciclos iterativos de retroalimentación.

- Nuevas técnicas de supervisión: probablemente basadas en mejoras de razonamiento de o3.

Estas técnicas fueron clave para la alineación y mejora en la toma de decisiones de GPT-4.5, y es probable que GPT-5 las lleve aún más lejos.

Aunque GPT‑5 fue entrenado por OpenAI usando aprendizaje supervisado y por refuerzo a gran escala, ahora los equipos pueden entrenar modelos GPT con sus propios datos a través de proveedores externos para crear comportamientos personalizados en dominios específicos.

Hardware y capacidad de cómputo

El entrenamiento de GPT-5 se realiza sobre la infraestructura de IA de Microsoft y las últimas GPU de NVIDIA.

- En abril de 2024, OpenAI recibió su primer lote de GPU NVIDIA H200, una mejora clave respecto a las H100.

- Las GPU NVIDIA B100 y B200 no estarán disponibles hasta 2025, por lo que OpenAI podría seguir optimizando el entrenamiento con el hardware actual.

Los clústeres de supercomputación de IA de Microsoft también participan en el entrenamiento de GPT-5. Aunque hay pocos detalles, se ha confirmado que el próximo modelo de OpenAI funciona sobre la infraestructura de IA más reciente de Microsoft.

Fecha de lanzamiento de GPT-5

Tras meses de especulación, OpenAI anunció oficialmente el lanzamiento de GPT-5 el 6 de agosto de 2025, con un enigmático adelanto publicado en X (antes Twitter):

El “5” en el título del livestream fue la única confirmación necesaria: marcó la llegada de GPT-5. Solo 24 horas después, el 7 de agosto a las 10am PT, OpenAI comenzó a desplegar GPT-5 en ChatGPT, la API y el Models Playground de GitHub.

Esta fecha también coincide con los comentarios previos de Sam Altman en febrero de 2025 de que GPT-5 llegaría “en unos meses”, y con la predicción de Mira Murati durante el evento de GPT-4o de que la “inteligencia a nivel de doctorado” surgiría en 18 meses.

GPT-5 ya está disponible públicamente y representa el nuevo “modelo de frontera” de OpenAI: un gran salto más allá de GPT-4.5 Orion, que solo se consideró una versión de transición.

Crea agentes de IA con LLMs de OpenAI

Olvida la complejidad: empieza a crear agentes de IA impulsados por modelos de OpenAI sin fricciones. Ya sea que necesites un chatbot para Slack, un asistente inteligente para Notion o un bot de soporte para WhatsApp, despliega fácilmente con solo unos clics.

Con integraciones flexibles, razonamiento autónomo y despliegue sencillo, Botpress te permite crear agentes de IA que realmente mejoran la productividad y la interacción.

Empieza hoy mismo — es gratis.

Preguntas frecuentes

1. ¿GPT-5 almacenará o usará mis datos para mejorar su entrenamiento?

No, GPT-5 no almacenará ni usará tus datos para entrenamiento por defecto. OpenAI ha confirmado que los datos de ChatGPT (incluido GPT-5) no se usan para entrenar modelos a menos que lo autorices explícitamente, y todo el uso de API y empresarial queda excluido automáticamente del entrenamiento.

2. ¿Qué medidas está tomando OpenAI para garantizar que GPT-5 sea seguro para los usuarios?

Para garantizar que GPT-5 sea seguro y confiable para los usuarios, OpenAI aplica técnicas como el aprendizaje por refuerzo con retroalimentación humana (RLHF), pruebas adversariales y ajuste fino para reducir resultados dañinos. También publican “system cards” para informar sobre las limitaciones del modelo y utilizan monitoreo en tiempo real para detectar usos indebidos.

3. ¿Se puede usar GPT-5 para crear agentes autónomos sin experiencia en programación?

Sí, es posible crear agentes autónomos con GPT-5 sin experiencia en programación utilizando plataformas sin código como Botpress o Langflow. Estas herramientas permiten a los usuarios diseñar flujos de trabajo, conectar APIs y añadir lógica mediante interfaces de arrastrar y soltar impulsadas por GPT-5.

4. ¿Cómo afectará GPT-5 a los trabajos tradicionales en atención al cliente, educación y derecho?

GPT-5 automatizará tareas repetitivas como responder preguntas frecuentes, calificar o resumir documentos legales, lo que podría reducir la demanda de puestos de nivel inicial en atención al cliente, educación y derecho. Sin embargo, también se espera que genere nuevas oportunidades en supervisión de IA, diseño de flujos de trabajo y roles de asesoría estratégica.

5. ¿GPT-5 es multilingüe? ¿Cómo se desempeña en diferentes idiomas?

Sí, GPT-5 es multilingüe y se espera que ofrezca un mejor rendimiento que GPT-4 en idiomas distintos al inglés. Aunque su desempeño es óptimo en inglés, puede manejar decenas de idiomas principales con gran fluidez, aunque en lenguas menos comunes o con menos recursos puede haber ligeras diferencias de calidad.

.webp)

.webp)