الذكاء الاصطناعي يشغل بال الجميع. ودائماً ما يقودنا ذلك إلى سؤال لاحق: ما مدى أمان أداة الذكاء الاصطناعي الجديدة هذه؟

إذا كنت مهتمًا بتطبيق chatbot لية لشركتك، فيجب أن يكون أمان chatbot على رأس أولوياتك.

في هذه المقالة، سوف أطلعك على جميع المخاطر الأمنية الرئيسية chatbot الآلية، بالإضافة إلى الاحتياطات التي يجب على مؤسستك اتخاذها عند تنفيذ chatbot لي أو وكيل الذكاء الاصطناعي.

هل روبوتات الدردشة الآلية آمنة؟

ليست كل روبوتات الدردشة الآلية آمنة - فأنت لا تعرف أبدًا احتياطات السلامة التي تم اتخاذها في تطويرها. ومع ذلك، من الممكن إنشاء chatbot آمن ونشره باستخدام الأدوات المناسبة.

يعد أمان Chatbot موضوعاً واسع النطاق، حيث يوجد عدد لا يحصى من الطرق لبناء chatbot أو وكلاء الذكاء الاصطناعي، بالإضافة إلى حالات استخدام لا حصر لها. سيجلب كل واحد من هذه الاختلافات جانباً أمنياً فريداً ستحتاج إلى مراعاته.

ما الذي يمكنني فعله لتجنب مخاطر chatbot

الأمان جزء مهم من مشروع chatbot الخاص بك - لا يمكن أن تكون استراتيجية الأمان الخاصة بك نصف مخبوزة.

إذا كنت خارج نطاق خبرتك، استعن بخبير. تسترشد معظم المؤسسات التي تقوم ببناء ونشر chatbot ردشة الآلية بشركاء الذكاء الاصطناعي: المؤسسات التي لديها خبرة في نوع معين من مشاريع الذكاء الاصطناعي. إذا كنت تقوم ببناء chatbot دردشة، يمكنك الاطلاع على قائمة الخبراء المعتمدين لدينا، وهي قائمة بالخبراء المستقلين والوكالات التي لديها خبرة في بناء ونشر ومراقبة روبوتات الدردشة الآمنة.

بخلاف ذلك، قم بتثقيف نفسك حول المخاطر ذات الصلة chatbot الخاص بك واتخذ جميع الخطوات اللازمة لمنع النتائج غير المرغوب فيها.

لقد جعلت هذا الأمر أسهل قليلاً بالنسبة لك من خلال تجميع المخاطر الأمنية الأكثر شيوعاً لروبوتات الدردشة الآلية وتقديم معلومات حول كيفية مكافحة كل خطر.

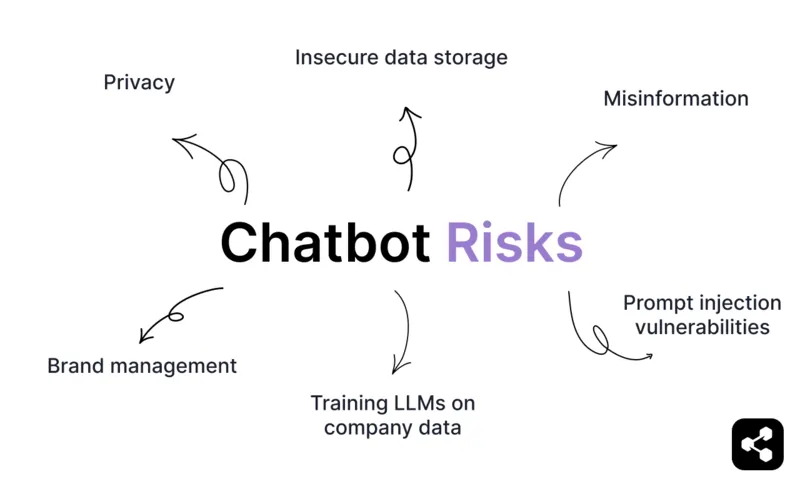

مخاطر Chatbot

الخصوصية والمعلومات السرية

غالبًا ما تتعامل روبوتات المحادثة مع البيانات الشخصية، مثل الأسماء أو عناوين البريد الإلكتروني أو التفاصيل المالية. وهذا يعني أنها تصبح خطراً على الخصوصية عندما تتعامل مع بيانات المستخدم الحساسة دون ضمانات قوية.

هذا الأمر مهم بشكل خاص في روبوتات الدردشة الطبية، أو روبوتات الدردشة التي تعالج المدفوعات من أي نوع، أو روبوتات الدردشة المالية، أو chatbotردشة المصرفية، أو أي روبوتات دردشة مؤسسية تتعامل مع البيانات الحساسة.

إذا تم تخزين هذه البيانات بشكل غير آمن أو نقلها دون تشفير، فإنها تصبح عرضة للاختراق - ومن ثم تعريض الشركات لمخاطر قانونية ومالية ومخاطر كبيرة على سمعتها.

التضليل والهلوسة

إن روبوتات الدردشة الآلية التي تعمل بواسطة LLMs - إذا تم إنشاؤها بشكل غير صحيح - معرضة لخطر نشر المعلومات المضللة.

خذ على سبيل المثال إخفاق chatbot ردشة chatbot الشهير على الخطوط الجوية الكندية. فقد تم إبلاغ أحد الركاب من خلال chatbot ردشة على موقع الشركة على الويب بأنه يمكنه التقدم بطلب للحصول على أسعار الحداد على رحلة طيران بعد وفاة جدته.

بعد التواصل للحصول على التعويض، تم إخبار العميل أن البوليصة لا تنطبق إلا على السفر المكتمل. اعترفت الشركة بأن chatbot استخدم "كلمات مضللة"، وذهبت القضية إلى المحكمة.

هذا النوع من الهلوسة لا يحرج العلامات التجارية فحسب، بل يكلفها الكثير.

ولكن من الممكن إنشاء روبوتات دردشة آلية تحافظ على الموضوع والعلامة التجارية. فقد تمكن أحد عملائنا، وهو منصة تدريب صحي، من تقليل الدعم اليدوي للتذاكر بنسبة 65% باستخدام chatbotردشة الآلية. وعلى مدار 100,000 محادثة، لم تجد الشركة أي هلوسة.

كيف؟ يلعب التوليد المعزّز بالاسترجاع (RAG) دورًا كبيرًا في معظم روبوتات الدردشة الآلية للمؤسسات. فبدلاً من توليد استجابات حرة، يجمع RAG بين القدرات التوليدية chatbotالآلية وقاعدة بيانات للمعلومات الحديثة التي تم التحقق منها. وهذا يضمن أن الردود تستند إلى الواقع، وليس إلى افتراضات أو تخمينات.

تتضمن روبوتات الدردشة الآلية للمؤسسات حواجز أمنية أخرى ضرورية قبل النشر العام - سنتطرق إليها أدناه.

تخزين البيانات غير الآمن

إذا كان chatbot الخاص بك يقوم بتخزين البيانات في خوادم أو بيئة سحابية، فإن بروتوكولات الأمان غير الكافية يمكن أن تجعله عرضة للاختراق.

يمكن للمهاجمين استغلال البرمجيات القديمة أو الخوادم ذات التكوين الخاطئ أو البيانات غير المشفرة للوصول إلى معلومات المستخدم الحساسة.

على سبيل المثال، تقوم بعض روبوتات الدردشة بتخزين النسخ الاحتياطية للبيانات دون تشفير مناسب، مما يجعلها عرضة للاعتراض أثناء النقل أو الوصول غير المصرح به.

ثغرات الحقن الموجه والمخرجات الضارة

إذا قمت بنشر chatbot ضعيف، فقد يكون حساساً للمطالبات المدمرة.

على سبيل المثال، إذا كان chatbot الخاص بك يساعد في بيع سيارات وكالتك، فأنت لا تريده أن يبيع شاحنة مقابل دولار واحد. (انظر حادثة شفروليه تاهو الشهيرة).

يمكن أن تنتج روبوتات المحادثة استجابات ضارة أو غير منطقية إذا لم يتم التحكم في مخرجاتها بشكل صحيح. يمكن أن تنشأ هذه الأخطاء من عدم كفاية الحواجز الوقائية، أو عدم وجود فحوصات التحقق من الصحة، أو التلاعب من قبل المستخدمين.

ومع ذلك، هذه واحدة من أسهل المخاطر الأمنية التي يمكن تجنبها. ستستخدم روبوتات الدردشة القوية حواجز حماية للمحادثة لمنع المحادثات الخارجة عن الموضوع أو خارج العلامة التجارية قبل إجرائها.

تدريب LLMs التدريب على بيانات الشركة

يمكن أن يشكل تدريب روبوتات الدردشة الآلية على بيانات الشركة مخاطر تتعلق بالخصوصية والأمان، خاصة مع منصات الأغراض العامة مثل ChatGPT. عند استخدام معلومات الشركة مع روبوتات الدردشة الآلية للأغراض العامة، هناك دائماً خطر تسريب البيانات.

من ناحية أخرى، تجعل روبوتات الدردشة الآلية المخصصة حماية بياناتك أسهل بكثير. عادةً ما يتم تصميم منصاتchatbot على مستوى المؤسسات مع مراعاة عزل البيانات وأمانها. يتم تدريب روبوتات الدردشة الآلية هذه في بيئات خاضعة للرقابة، مما يقلل بشكل كبير من مخاطر تسرب البيانات.

إدارة العلامات التجارية

تركزت أكبر أخطاء chatbot الآلية العامة على إدارة العلامة التجارية. ما مدى جودة تمثيل chatbot لعلامتك التجارية؟ هذا هو جوهر أمان chatbot الآلية.

غالبًا ما تكون روبوتات الدردشة الآلية هي أول نقطة اتصال بين العملاء ونشاطك التجاري، وإذا كانت ردودهم غير دقيقة أو غير مناسبة أو غير متقنة، فقد تضر بسمعة علامتك التجارية.

مرة أخرى، هذا خطر يمكن تجنبه من خلال حواجز حماية المحادثة وتصميم المحادثة.

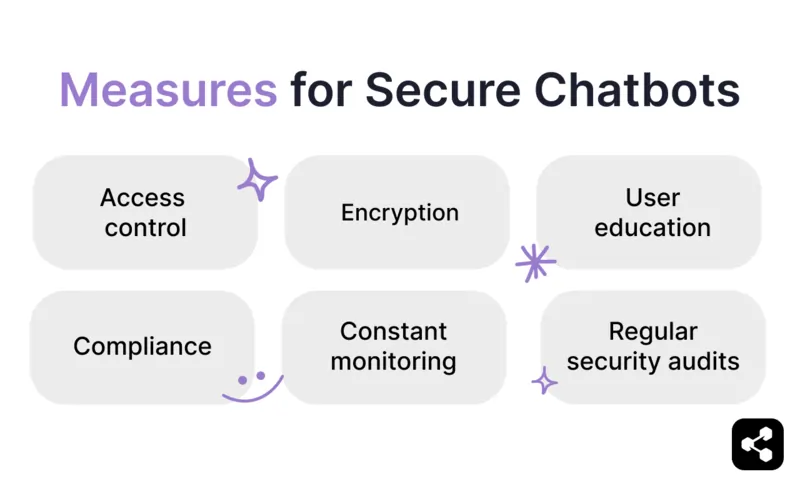

تدابير السلامة اللازمة لتأمين روبوتات المحادثة الآمنة

التحكم في الوصول وتأمين وصول المستخدم

إذا كانت أداة تستخدمها الجماهير، فأنت لا تريد أن يكون لدى الجميع نفس مستوى الوصول.

تتحقق المصادقة من هوية المستخدم - مما يضمن أن المستخدمين الشرعيين فقط هم من يمكنهم تسجيل الدخول. وبمجرد المصادقة، يحدد التفويض ما يُسمح لكل مستخدم بالقيام به، استناداً إلى دوره أو أذوناته.

جزء رئيسي من هذا هو التحكم في الوصول المستند إلى الأدوار (RBAC)، والذي يضمن وصول المستخدمين فقط إلى المعلومات والميزات التي يحتاجونها لأداء أدوارهم. وهذا يعني:

- قصر الوصول إلى البيانات الحساسة على الموظفين المصرح لهم.

- تقييد إمكانيات تحرير chatbot على المسؤولين.

- تحديد أدوار المستخدم بأذونات واضحة وقابلة للتنفيذ.

من خلال تطبيق RBAC إلى جانب بروتوكولات المصادقة والتفويض الآمنة، يمكنك تقليل المخاطر مثل الوصول غير المصرح به وتسريب البيانات وسوء الاستخدام العرضي. إنه حاجز حماية بسيط ولكنه أساسي لنشر chatbot الآمنة.

عمليات التدقيق الأمني المنتظمة

مثل أي برنامج آخر عالي الأداء، يجب أن تخضع برمجيات chatbot لعمليات تدقيق أمني منتظمة.

إن عمليات التدقيق الأمني المنتظمة هي مراجعات شاملة لبنية chatbot وتكويناته وعملياته للتأكد من أنها تفي بمعايير الأمان وأفضل الممارسات في المجال.

تتضمن عمليات التدقيق هذه عادةً اختبار الثغرات الأمنية - مثل بروتوكولات المصادقة الضعيفة أو الخوادم التي تمت تهيئتها بشكل خاطئ أو واجهات برمجة التطبيقات المكشوفة - بالإضافة إلى تقييم فعالية التدابير الأمنية الحالية مثل التشفير وضوابط الوصول.

تعمل عمليات التدقيق أيضًا على تقييم الامتثال للوائح حماية البيانات، مما يضمن التزام chatbot الخاص بك بأطر العمل مثل اللائحة العامة لحماية البيانات أو SOC 2.

وغالباً ما تتضمن هذه العملية:

- اختبار الاختراق لمحاكاة الهجمات المحتملة

- مراجعات الكود لاكتشاف العيوب الخفية

- مراقبة النشاط غير الاعتيادي

تُعد عمليات التدقيق الأمني إجراءً استباقياً لتقييم مرونة chatbot الخاص بك ضد التهديدات والتحقق من قدرته على التعامل مع المعلومات الحساسة بشكل آمن.

التشفير

التشفير هو عملية تحويل البيانات إلى تنسيق آمن لمنع الوصول غير المصرح به. بالنسبة للبيانات الحساسة، يشمل ذلك نوعين أساسيين: تشفير البيانات في حالة التخزين، والذي يحمي المعلومات المخزنة، وتشفير البيانات أثناء النقل، والذي يؤمن البيانات أثناء نقلها.

ويضمن استخدام بروتوكولات التشفير القوية مثل AES (معيار التشفير المتقدم) أنه حتى لو تم اعتراض البيانات، فإنها تظل غير قابلة للقراءة.

بالنسبة لروبوتات الدردشة الآلية التي تتعامل مع المعلومات الحساسة، فإن التشفير هو حاجز حماية غير قابل للتفاوض لحماية خصوصية المستخدم والحفاظ على الامتثال لمعايير الأمان.

المراقبة المستمرة

تقترح المنصة كخدمة 3 مراحل لتنفيذ chatbot : البناء والنشر والمراقبة.

يميل العملاء إلى نسيان المرحلة الأخيرة عند وضع خططهم الأولية، ولكن المراقبة هي أهم خطوة على الإطلاق.

ويشمل ذلك:

- تتبع مقاييس الأداء

- تحديد نقاط الضعف

- معالجة مشكلات مثل الهلوسة أو تسريب البيانات

تساعد التحديثات والاختبارات المنتظمة على ضمان تكيُّف chatbot الخاص بك مع التهديدات المتطورة وبقائه متوافقاً مع لوائح الصناعة.

بدون المراقبة المناسبة، حتى أكثر chatbot لية المبنية بشكل جيد يمكن أن تصبح عائقاً بمرور الوقت.

الامتثال

إذا كان chatbot الخاص بك سيتعامل مع بيانات حساسة، فأنت بحاجة إلى اختيار منصة تتوافق مع أطر الامتثال الرئيسية.

تشمل أطر الامتثال الأكثر شيوعًا وذات الصلة ما يلي:

- اللائحة العامة لحماية البيانات (GDPR): اللائحة العامة لحماية البيانات

- قانون خصوصية المستهلك في كاليفورنيا قانون خصوصية المستهلك في كاليفورنيا

- HIPAA قانون قابلية التأمين الصحي والمساءلة والمحاسبة على التأمين الصحي

- مركز SOC 2: ضوابط النظام والتنظيم 2

إذا كنت ستعالج بيانات الأفراد في الاتحاد الأوروبي، فستحتاج إلى chatbot متوافق مع اللائحة العامة لحماية البيانات.

للامتثال الكامل، سيتطلب الأمر أ) منصة تتبع تدابير الامتثال المناسبة و ب) بعض العمل من مُنشئي chatbot لية (مثل كيفية التعامل مع البيانات بمجرد استلامها من قبل chatbot الخاص بك).

تثقيف المستخدم

في بعض الأحيان لا يكون الخطأ في التكنولوجيا - بل في عدم فهم مستخدميها.

يتمثل أحد الأجزاء المهمة لتأسيس تكنولوجيا chatbot لية في إعداد موظفيك بشكل صحيح لمواجهة المخاطر والتحديات الجديدة (إلى جانب الفوائد الكثيرة).

ثقّف موظفيك حول كيفية دمج chatbot الدردشة الآلي في عملهم دون المخاطرة بسمعة شركتك. من الناحية المثالية، سيتم بناء chatbot الآلي الخاص بك بحواجز حماية كافية بحيث يكون من شبه المستحيل إساءة استخدامه.

نشر Chatbot الأكثر أماناً في السوق

يجب أن يكون الأمان على رأس أولويات الاستثمار في chatbot الخاصة بشركتك.

Botpress هو وكيل للذكاء الاصطناعي ومنصة chatbot تستخدمها 35% من الشركات المدرجة في قائمة فورتشن 500. تتيح مجموعة الأمان المتطورة لدينا أقصى قدر من التحكم في أدوات الذكاء الاصطناعي الخاصة بك.

تضمن بوابة LLM الخاصة ودرع الخصوصية وعامل الأمان المدمج وإطار عمل حماية العلامة التجارية الخاص بنا أن يحصل عملاؤنا على تجربة chatbot الأكثر أماناً في السوق.

ابدأ البناء اليوم. إنه مجاني.

أو احجز اتصالاً مع فريقنا للبدء في العمل.

الأسئلة الأكثر تداولًا

1. كيف تخزن روبوتات الدردشة الآلية البيانات؟

تقوم روبوتات الدردشة الآلية بتخزين البيانات في قواعد بيانات آمنة - عادةً ما تكون مستندة إلى السحابة - باستخدام التشفير في حالة السكون وفي النقل. قد تتضمن البيانات المخزنة سجلات المحادثة والبيانات الوصفية، وغالباً ما تكون منظمة لدعم التخصيص أو الامتثال التنظيمي.

2. كيف يمكنني ضمان أمان chatbot

للحصول على chatbot آمن، قم بتطبيق HTTPS لجميع الاتصالات، وقم بتشفير البيانات المخزنة، وصادق على مكالمات واجهة برمجة التطبيقات، وقيد الوصول باستخدام أذونات قائمة على الأدوار. كما يجب عليك أيضًا تدقيق النظام بانتظام والامتثال لقوانين خصوصية البيانات مثل اللائحة العامة لحماية البيانات أو قانون HIPAA.

3. ما هي سلامة chatbot

سلامة Chatbot هي مجموعة من الممارسات التي تحمي المستخدمين والأنظمة من المخاطر مثل انتهاكات البيانات، أو المعلومات الخاطئة، أو هجمات الهندسة الاجتماعية، أو التفاعلات المسيئة. وهي تشمل فرض فلاتر المحتوى، وتأمين قنوات البيانات، والتحقق من صحة المدخلات، وتمكين الاحتياط البشري عند الحاجة.

4. ما هو chatbot الأكثر أماناً؟

أكثر chatbot الآمنة هي تلك التي يتم نشرها مع التشفير من طرف إلى طرف، وضوابط وصول صارمة، وخيارات السحابة المحلية أو السحابة الخاصة، والامتثال لشهادات مثل SOC 2 أو ISO 27001 أو HIPAA.

%20(1).webp)