- Rilasciato l'8 luglio 2025, GPT unifica il ragionamento avanzato, l'input multimodale e l'esecuzione dei compiti in un unico sistema, eliminando la necessità di passare da un modello all'altro.

- GPT è progettato per flussi di lavoro complessi e in più fasi.

- GPT riduce significativamente le allucinazioni rispetto alle versioni precedenti.

- Le varianti di GPT comprendono:

gpt-5,gpt-5-mini,gpt-5-nano, egpt-5-chat.

Nel corso dell'ultimo anno, OpenAI ha introdotto GPT, o1 e o3, ognuno dei quali migliora il modo in cui l'intelligenza artificiale pensa, ragiona e interagisce.

Questi modelli hanno reso le risposte dell'intelligenza artificiale più veloci, più precise e più intuitive. Ma ognuno di essi era solo un passo verso qualcosa di più grande.

Il 6 agosto OpenAI ha annunciato, non tanto velatamente, l'imminente lancio di GPT.

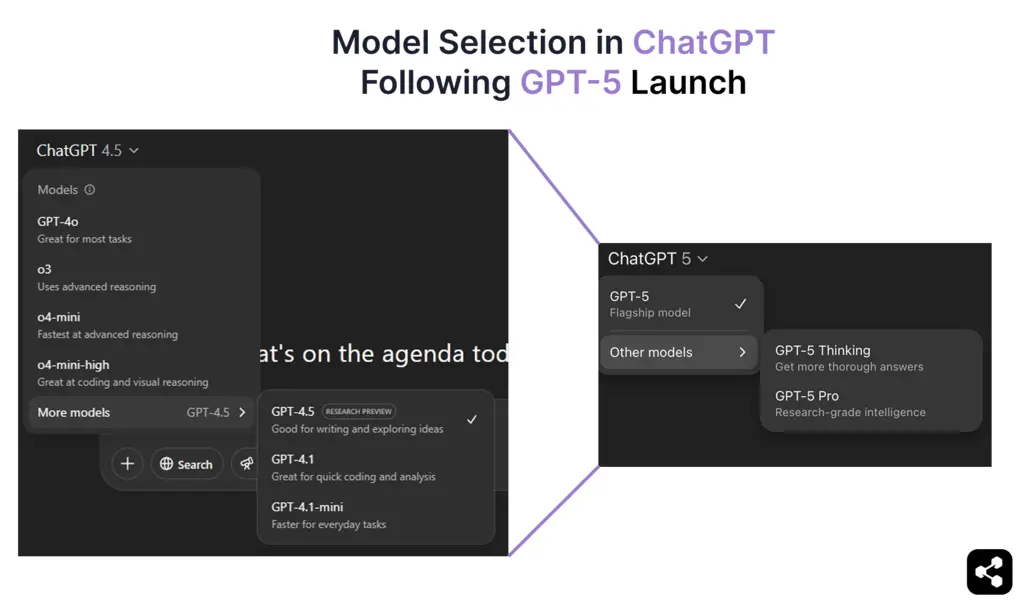

E ora, dal 7 agosto 2025, è arrivato ufficialmente il GPT, che riunisce le più avanzate capacità di ragionamento e multimodali di OpenAIin un modello unificato. GPT è ora il modello predefinito in ChatGPT per tutti gli utenti gratuiti e a pagamento, sostituendo completamente GPT.

In questa guida, vi illustrerò tutte le informazioni confermate sul GPT: le sue capacità, gli aggiornamenti delle prestazioni, il processo di formazione, la tempistica di rilascio e il costo.

Che cos'è GPT-5?

GPT è il modello linguistico di ultima generazione di OpenAI, rilasciato ufficialmente il 7 agosto 2025. Si basa sull'architettura GPT e integra i progressi dei modelli reasoning-first come o1 e o3.

Prima di GPT, OpenAI ha distribuito GPT.5 (Orion) all'interno di ChatGPT - un modello di transizione che affinava l'accuratezza del ragionamento, riduceva le allucinazioni e gettava le basi per un'esecuzione più profonda della catena di pensiero, ora nativa di GPT.

Molte delle funzionalità accennate in passato, come la logica a gradini, una migliore conservazione del contesto e una commutazione multimodale più fluida, sono ora pienamente realizzate e unificate in GPT.

GPT funziona come parte di un sistema adattivo unificato. Un nuovo router in tempo reale sceglie automaticamente tra un modello veloce e ad alta velocità per le interrogazioni di routine e un modello "pensante" per i ragionamenti complessi, eliminando la necessità di passare manualmente da un modello all'altro.

Quali sono i diversi modelli di GPT?

GPT è una serie di modelli - una famiglia di varianti specializzate ottimizzate per diversi casi d'uso, che vanno dalle applicazioni di ChatGPT alle implementazioni su larga scala tramite API.

Ciascuna variante di GPT funziona sulla stessa architettura unificata, ma è regolata in base a un equilibrio specifico tra soglia di conoscenza, profondità di ragionamento, velocità e scala operativa.

Queste varianti unificano l'orientamento di OpenAIverso il ragionamento e la messa a punto mirata delle prestazioni, offrendo agli sviluppatori la flessibilità necessaria per adeguare la scelta del modello alla complessità del carico di lavoro e alla scala di distribuzione.

Come si comporta il GPT?

Con il GPT rilasciato ufficialmente il 7 agosto 2025, stiamo ora vedendo come la sua architettura gestisce l'uso nel mondo reale attraverso il ragionamento, la multimodalità e l'esecuzione di compiti in stile agente.

Sam Altman aveva accennato in precedenza al fatto che GPT non sarebbe stato solo "un chatbot migliore" e, stando ai primi utilizzi, è esattamente ciò che offre.

Ragionamento che si adatta in tempo reale

Un sistema di routing integrato decide quando rispondere istantaneamente e quando pensare per gradi. Per le domande complesse, GPT si muove in un processo a catena di pensiero con un prompt-chaining incorporato, mappando le fasi intermedie prima di fornire una risposta finale.

Questo fa sì che i chatbot GPT costruiti su GPT siano in grado di risolvere i problemi a lungo termine, dal debugging del codice in più fasi all'analisi aziendale a più livelli, senza richiedere modelli separati o la commutazione di modalità.

Gestione del contesto in scala

In ChatGPT, il modello può contenere circa 256.000 token in memoria; tramite l'API, la capacità di memorizzazione si espande a 400.000. Ciò consente di lavorare su interi libri, trascrizioni di riunioni di più ore o grandi archivi senza perdere traccia dei dettagli precedenti.

Nelle sessioni più lunghe, l'accuratezza delle risposte ChatGPT è notevolmente migliorata, con un minor numero di contraddizioni e una maggiore memorizzazione del contesto precedente.

Migliore supporto linguistico per il mercato globale

L'architettura unificata di GPT comporta un importante salto di qualità nelle funzionalità multilingue e vocali. ChatGPT è ora in grado di gestire un supporto più ampio per ChatGPT lingue, con una maggiore precisione di traduzione e un minor numero di cadute di contesto nelle conversazioni estese.

Questi vantaggi si estendono anche alle interazioni vocali. Le risposte hanno un suono più naturale a seconda dell'accento e del modo di parlare, rendendo i chatbot GPT multilingue altrettanto fluidi in spagnolo, hindi, giapponese o arabo come nel testo.

Da chatbot ad agente AI

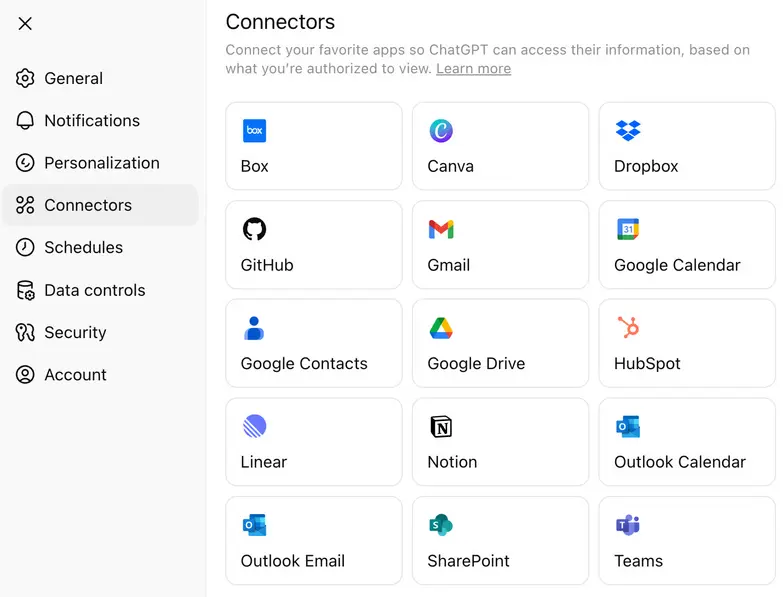

Con GPT, OpenAI ha ampliato il suo approccio ai connettori di applicazioni, ovvero integrazioni native che consentono al modello di interagire direttamente con strumenti esterni, CRM, database e suite di produttività.

Inoltrando le attività a connettori leggeri, invece di far passare ogni fase attraverso chiamate di ragionamento ad alto costo, i team possono ridurre la spesa per le API, mantenendo comunque la logica complessa disponibile quando è necessaria.

Quanto costa il GPT?

GPT è disponibile attraverso gli abbonamenti ChatGPT e l'API OpenAI , con prezzi che variano a seconda della variante. Per gli utenti dell'API, GPT è offerto in diverse varianti - gpt-5, gpt-5-mini e gpt-5-nano - con un prezzo per milione di token di ingresso e di uscita.

Oltre ai prezzi delle API, OpenAI ha confermato che il GPT è disponibile in più livelli di ChatGPT , rendendolo accessibile agli utenti gratuiti e sbloccando le funzionalità avanzate per i piani a pagamento:

- Free Tier - GPT con capacità di ragionamento standard e limiti di utilizzo giornalieri.

- LivelloPlus - Maggiori limiti di utilizzo e migliori prestazioni di ragionamento.

- Livello Pro - Accesso a GPT Pro, la variante "pensante" ad alto livello di ragionamento con finestre contestuali estese, instradamento più rapido e accesso prioritario agli strumenti avanzati.

Il modello di prezzo di OpenAIconsente agli sviluppatori di scegliere tra la massima profondità di ragionamento, una latenza più rapida o l'efficienza dei costi, a seconda delle loro esigenze.

Come si accede a GPT? (Suggerimento: dipende da cosa si sta cercando di fare)

Se volete solo chattare con il GPT, potete farlo direttamente in ChatGPT a partire dal 7 agosto. L'applicazione utilizza automaticamente la variante giusta in base al vostro piano (come GPT Thinking nel livello Pro). Non è necessaria alcuna configurazione: basta aprire l'applicazione e iniziare a scrivere.

Tuttavia, se si vuole utilizzare GPT in un proprio prodotto o flusso di lavoro, è necessario accedere all'API. Esistono due modi principali per accedere all'API di OpenAI:

- PiattaformaOpenAI - Andate su platform.openai.com, dove potete scegliere tra gpt-5, gpt-5-mini, gpt-5-nano e gpt-5-chat per diversi casi d'uso. Questo è il modo più rapido per iniziare a inviare richieste a GPT dal proprio codice.

- SDK Python diOpenAIsu GitHub - Se state costruendo localmente o facendo script, installate il client Python ufficiale di OpenAI . Funziona con chiavi API e consente di interagire con qualsiasi variante di GPT attraverso semplici funzioni Python.

Se state solo esplorando il comportamento dei modelli, è attivo anche il Models Playground GitHub , dove è possibile eseguire test immediati senza dover configurare un'applicazione completa.

Come costruire un agente AI con GPT

Il modo migliore per sapere se GPT è adatto al vostro caso d'uso è costruirlo davvero. Per vedere come gestisce gli input reali, i ragionamenti in più fasi e i flussi di distribuzione in tempo reale.

Per questo esempio utilizzeremo Botpress , un costruttore visuale per agenti AI che consente di collegarsi a GPT senza alcun attrito di configurazione.

Fase 1: definire cosa deve fare il vostro agente

Siate precisi sul ruolo del vostro agente. GPT è in grado di ragionare su compiti complessi, ma i risultati migliori si ottengono quando ha un compito chiaro.

Iniziate con una funzione definita, come rispondere alle domande sui prodotti, aiutare gli utenti a prenotare appuntamenti o riassumere documenti legali, e poi espandetevi da lì. Non c'è bisogno di ingegnerizzarla troppo fin dall'inizio.

Fase 2: creare l'agente e dargli istruzioni

All'interno di Botpress Studio, creare un nuovo progetto bot.

Nella sezione Istruzioni, indicare a GPT esattamente il suo compito.

.webp)

Esempio: "Sei un bot di consulenza sui prestiti. Aiutate gli utenti a capire i diversi tipi di prestito, calcolate l'idoneità in base ai loro input e guidateli verso il link per la richiesta".

GPT è in grado di comprendere l'inquadramento dettagliato dei compiti: più specifiche sono le istruzioni, meglio si comporta.

Fase 3: alimentare l'agente con il contenuto del lavoro

Caricate i documenti, incollate i contenuti chiave o collegatevi a pagine attive della Knowledge Base. È a questa che il GPT farà riferimento per rispondere alle domande e prendere decisioni.

Alcuni buoni contenuti da includere:

- Disaggregazione dei prezzi

- Panoramica dei prodotti o dei servizi

- Pagine chiave (demo, prove, moduli di contatto)

- Documenti di processo interni (se si tratta di un agente interno)

Il GPT può attingere da documenti lunghi, quindi non preoccupatevi di essere brevi, ma di essere pertinenti e strutturati.

Passo 4: scegliere GPT come LLM

.webp)

Per assicurarsi che il proprio agente stia utilizzando GPT, andare su Impostazioni bot nella barra laterale sinistra di Botpress Studio.

- Fare clic su Impostazioni bot

- Scorrere fino alla sezione ProviderLLM

- Sotto Modello, selezionare una delle varianti GPT:

gpt-5per il ragionamento completo e la logica a più fasigpt-5-miniper interazioni più veloci e leggerept-5-nanoper attività a bassissima latenza

Una volta selezionato il modello, tutte le istruzioni, le risposte della Knowledge Base e il comportamento di ragionamento saranno alimentati da GPT. È possibile cambiare variante in qualsiasi momento in base al costo, alla latenza o alla qualità dell'output.

Fase 5: Distribuzione a canali come WhatsApp, Slack o un sito web

Una volta che l'agente GPT si comporta nel modo desiderato, è possibile distribuirlo immediatamente su piattaforme quali:

Le piattaforme di agenti AI come Botpress gestiscono le integrazioni, in modo che gli utenti possano sfruttare la potenza del GPT e distribuirlo rapidamente su qualsiasi canale.

In che modo il GPT è migliore del GPT?

Sebbene GPT rappresenti il più grande cambiamento architettonico dai tempi di GPT, il contesto diventa più chiaro se confrontato direttamente con il suo predecessore, GPT.

La tabella che segue illustra i cambiamenti in termini misurabili, prima di addentrarsi in ciò che sviluppatori e utenti hanno effettivamente sperimentato.

Sulla carta, il GPT espande notevolmente la finestra di contesto e utilizza meno token per la stessa lunghezza di output. Inoltre, le sue risposte multimodali si allineano meglio tra testo, immagine e voce.

Tuttavia, la storia nella comunità degli sviluppatori e degli utenti è molto più complicata di quanto suggerisca la scheda tecnica.

Reazioni degli utenti al lancio del GPT

Il rilascio di GPT è stato uno degli aggiornamenti di OpenAIche ha suscitato più polemiche. Al di là dei grafici di benchmark, la comunità si è divisa quasi istantaneamente in coloro che sono entusiasti del ragionamento più profondo del modello e in coloro che piangono ciò che GPT ha portato sul tavolo.

"Il mio 4.o era come il mio migliore amico quando ne avevo bisogno. Ora non c'è più, è come se fosse morto qualcuno".

- Utente di Reddit che esprime attaccamento emotivo e dolore dopo l'improvvisa rimozione del GPT. Riferimento: Verge

Sul fronte tecnico:

"Le prestazioni avanzate delGPTsono innegabili, ma la mancanza di scelta del modello ha eliminato il semplice controllo su cui molti sviluppatori facevano affidamento".

- Commento parafrasato che riflette il sentimento diffuso sulla perdita di flessibilità.

Riferimento: Guida di Tom

Questa reazione contrastante è stata affrontata in diretta dal team OpenAI , con nuovi aggiornamenti riguardanti la scelta del modello, i rollback del modello legacy, i limiti più elevati e così via, pubblicati da Sam Altman su X.

Come è stato formato il GPT?

OpenAI ha fornito informazioni sull'addestramento di GPT.5, che offrono indizi sul modo in cui GPT viene sviluppato. GPT.5 ha ampliato le fondamenta di GPT aumentando il pre-addestramento, pur rimanendo un modello generico.

Metodi di formazione

Come i suoi predecessori, il GPT dovrebbe essere addestrato utilizzando una combinazione di:

- Supervised fine-tuning (SFT) - Apprendimento da insiemi di dati etichettati dall'uomo.

- Reinforcement learning from human feedback (RLHF) - Ottimizzazione delle risposte attraverso cicli di feedback iterativi.

- Nuove tecniche di supervisione - probabilmente basate sui miglioramenti di o3 incentrati sul ragionamento.

Queste tecniche sono state fondamentali per il miglioramento dell'allineamento e del processo decisionale del GPT.5, e GPT probabilmente le spingerà ulteriormente.

Mentre il GPTstesso è stato addestrato da OpenAI utilizzando l'apprendimento supervisionato e di rinforzo su larga scala, i team possono ora addestrare i modelli GPT sui propri dati attraverso fornitori di servizi esterni per creare comportamenti personalizzati per domini specifici.

Hardware e potenza di calcolo

L'allenamento di GPT si avvale dell'infrastruttura AI di Microsoft e delle più recenti GPU di NVIDIA.

- Nell'aprile del 2024, OpenAI ha ricevuto il primo lotto di GPU NVIDIA H200, un aggiornamento fondamentale rispetto alle H100.

- Le GPU B100 e B200 di NVIDIA non arriveranno prima del 2025, il che significa che OpenAI potrebbe ancora ottimizzare la formazione sull'hardware esistente.

Anche i cluster di supercalcolo AI di Microsoft stanno svolgendo un ruolo nell'addestramento del GPT. Anche se i dettagli sono limitati, è stato confermato che il prossimo modello di OpenAIfunzionerà sulla più recente infrastruttura di intelligenza artificiale di Microsoft.

GPT Data di uscita

Dopo mesi di speculazioni, OpenAI haannunciato ufficialmente il lancio del GPT il 6 agosto 2025, con un teaser criptico pubblicato su X (ex Twitter):

Il "5" nel titolo del livestream era l'unica conferma necessaria: segnava l'arrivo della GPT. Appena 24 ore dopo, il 7 agosto alle 10:00 PT, OpenAI ha iniziato a distribuire GPT su ChatGPT, sulle API e sul GitHub Models Playground.

Questa tempistica si allinea anche con i precedenti commenti di Sam Altman nel febbraio 2025, secondo cui ilGPT sarebbe arrivato "in pochi mesi", e con la previsione di Mira Murati durante l'evento GPT, secondo cui "un'intelligenza di livello dottorale" sarebbe emersa entro 18 mesi.

GPT è ora disponibile, accessibile al pubblico e rappresenta l'ultimo "modello di frontiera" di OpenAI- un salto importante rispetto a GPT.5 Orion, che era considerato solo una release di transizione.

Costruire agenti di intelligenza artificiale con iLLMs OpenAI

Dimenticate la complessità: iniziate a costruire agenti AI basati su modelli OpenAI senza attriti. Che abbiate bisogno di un chatbot per Slack, di un assistente intelligente per Notion o di un bot di assistenza clienti per WhatsApp, potete implementarlo senza problemi con pochi clic.

Grazie alle integrazioni flessibili, al ragionamento autonomo e alla facilità di distribuzione, Botpress consente di creare agenti AI che migliorano realmente la produttività e il coinvolgimento.

Iniziare oggi è gratuito.

Domande frequenti

1. GPT memorizzerà o utilizzerà i miei dati per migliorare la sua formazione?

No, GPT non memorizzerà o utilizzerà i vostri dati per l'addestramento per impostazione predefinita. OpenAI ha confermato che i dati di ChatGPT (compreso GPT) non vengono utilizzati per addestrare i modelli, a meno che non si scelga esplicitamente di farlo, e tutto l'uso dell'API e dell'azienda viene escluso automaticamente dall'addestramento.

2. Quali misure sta adottando OpenAI per garantire che il GPT sia sicuro e protetto per gli utenti?

Per garantire che il GPT sia sicuro e protetto per gli utenti, OpenAI applica tecniche come l'apprendimento rinforzato dal feedback umano (RLHF), i test avversari e la messa a punto per ridurre i risultati dannosi. Inoltre, rilascia "schede di sistema" per rivelare le limitazioni del modello e implementa il monitoraggio in tempo reale per rilevare gli usi impropri.

3. Il GPT può essere usato per costruire agenti autonomi senza esperienza di codifica?

Sì, GPT può essere utilizzato per costruire agenti autonomi senza esperienza di codifica, utilizzando piattaforme no-code come Botpress o Langflow. Questi strumenti consentono agli utenti di progettare flussi di lavoro, collegare API e aggiungere logica attraverso interfacce drag-and-drop alimentate da GPT sotto il cofano.

4. Che impatto avrà il GPT sui lavori tradizionali di assistenza ai clienti, istruzione e legge?

Il GPT automatizzerà compiti ripetitivi come rispondere a domande comuni, classificare o riassumere documenti legali, il che potrebbe ridurre la domanda di ruoli entry-level nell'assistenza clienti, nell'istruzione e nella legge. Tuttavia, si prevede che creerà anche nuove opportunità nei ruoli di supervisione dell'IA, di progettazione dei flussi di lavoro e di consulenza strategica.

5. Il GPT è multilingue? Come si confronta con le diverse lingue?

Sì, GPT è multilingue e dovrebbe offrire prestazioni migliori rispetto a GPT nelle lingue non inglesi. Sebbene dia il meglio di sé in inglese, è in grado di gestire decine di lingue principali con grande fluidità, anche se le lingue con minori risorse o di nicchia possono presentare lievi lacune qualitative.

.webp)

%20(1).webp)