- Botpress bietet eine transparente Preisgestaltung ohne versteckte KI-Gebühren, sodass Ihre KI-Kosten ausschließlich auf Ihrer tatsächlichen Nutzung basieren.

- Das Zwischenspeichern von KI-Antworten kann die Abfragekosten um etwa 30 % senken, ohne das Nutzererlebnis zu beeinträchtigen.

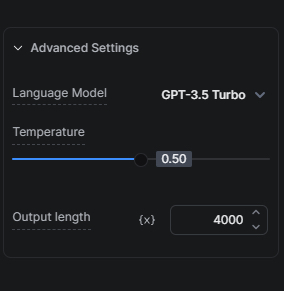

- Die Wahl des richtigen KI-Modells, zum Beispiel der Einstieg mit GPT-3.5 Turbo statt GPT-4, ist entscheidend, um Kosten und Qualität auszubalancieren.

Viele Unternehmen stehen vor der Herausforderung, das Potenzial von KI-Technologien zu nutzen, ohne zu viel auszugeben. Wir wissen, wie wichtig dieses Gleichgewicht ist, und setzen uns dafür ein, Lösungen bereitzustellen, mit denen unsere Nutzer KI kosteneffizient einsetzen können.

Unser Ansatz zu KI-Kosten

Zunächst ist es wichtig, zwei zentrale Aspekte zu verstehen, wie wir KI-bezogene Kosten für unsere Nutzer senken und gleichzeitig die Vorteile von KI bieten.

Transparente Preisgestaltung: Keine versteckten Gebühren

Wir schlagen auf KI-bezogene Aufgaben keine Marge auf. Das bedeutet, Ihre KI-Kosten richten sich direkt nach Ihrer tatsächlichen Nutzung – ohne zusätzliche KI-Gebühren unsererseits.

Zwischenspeichern von KI-Antworten

Das Zwischenspeichern von KI-Antworten ist eine unserer effektivsten Strategien, um die KI-Kosten von Bots zu senken. Durch das Zwischenspeichern reduzieren wir die Anzahl der Anfragen an den LLM-Anbieter, was die Abfragekosten um etwa 30 % senken kann – Sie sparen Geld, ohne dass die Qualität der Bot-Interaktionen leidet.

Tipps zur Optimierung der KI-Kosten

Nachdem wir zwei unserer Ansätze zur Senkung der KI-Kosten vorgestellt haben, finden Sie hier weitere Tipps, wie Sie beim Erstellen Ihres Bots die KI-Kosten weiter reduzieren können.

Optimieren Sie Ihre Wissensdatenbanken

Die Optimierung Ihrer Wissensdatenbanken (KBs) kann Ihre KI-Kosten erheblich beeinflussen, da KBs in einem Botpress-Projekt meist der größte Kostentreiber sind.

Tipp 1: Das richtige KI-Modell wählen

Die Wahl des KI-Modells hat großen Einfluss auf die Kosten. Da GPT-3.5 Turbo schneller und günstiger ist als GPT-4 Turbo, empfehlen wir, Ihr Setup zunächst gründlich mit GPT-3.5 Turbo zu testen, bevor Sie ein Upgrade auf eine fortschrittlichere Version in Betracht ziehen.

Unser hybrider KB-Agent-Modus bietet einen guten Mittelweg: Zunächst wird GPT-3.5 Turbo für eine Antwort verwendet und nur bei Bedarf auf GPT-4 Turbo umgeschaltet.

Tipp 2: Schützen Sie Ihre KB

Sie können Ihre KI-Kosten senken, indem Sie Ihre KB vor unnötigen Standard-FAQs schützen, die keine KI oder intelligente Antwort benötigen, indem Sie eine Find Records-Karte verwenden. So funktioniert es: Wenn Sie wissen, dass Nutzer häufig eine bestimmte Frage stellen und Sie 50 bekannte Fragen mit Antworten haben, können Sie diese in eine Tabelle eintragen und mit einer Find Records-Karte abfragen. Wird keine Antwort gefunden, wird erst dann die KB durchsucht.

Tipp 3: KBs richtig abgrenzen

Je nach Art und Umfang der Informationen, die Sie in eine KB aufnehmen möchten, empfiehlt es sich, zwei Dinge parallel zu tun, um die KI-Kosten zu senken: Erstens, gliedern Sie Ihre Informationen in kleinere KBs, die jeweils auf ein bestimmtes Produkt, Feature oder Thema ausgerichtet sind. Zweitens, führen Sie den Nutzer mit mehreren Fragen durch einen Workflow, um die Suche auf eine bestimmte KB einzugrenzen. Das senkt nicht nur die Kosten, sondern liefert auch bessere Ergebnisse.

Tipp 4: Website-KB-Datenquelle vs. Websuche-KB-Datenquelle

Wenn Sie eine Website als KB-Datenquelle nutzen, aber nicht ständig Änderungen an der Website vornehmen, die in Echtzeit an den Bot übermittelt werden müssen, ist es oft kostengünstiger, die Websuche als KB-Datenquelle zu verwenden. Testen Sie vor dem Wechsel, ob die Leistung bei den erwarteten Fragen nicht darunter leidet.

Tipp 5: Tabellen mit Find Records oder Execute Code-Karte abfragen

Wenn Sie eine Tabelle mit Daten abfragen möchten, nutzen Sie möglichst die Find Records-Karte anstelle der Tabelle in einer KB. Wer technisch versiert ist, kann durch Code-Ausführung noch kosteneffizienter auf eine Tabelle zugreifen: Greifen Sie direkt aus der Execute Code-Karte auf die Tabelle zu und speichern Sie das Ergebnis in einer Workflow-Variable, auf die Sie später zugreifen können.

Tipp 6: Chunks kontrollieren

Mit Chunks ist die Anzahl der Abschnitte gemeint, die aus der Wissensdatenbank für eine Antwort abgerufen werden. Je mehr Chunks abgerufen werden, desto genauer ist die Antwort – allerdings dauert es länger und kostet mehr KI-Tokens. Experimentieren Sie mit der Chunk-Anzahl, um die niedrigste Menge zu finden, die noch zu präzisen Antworten führt.

Execute Code-Karte zur Senkung der KI-Kosten nutzen

Die Execute Code-Karte kann für manche KI-Karten eine geeignete und kostengünstige Alternative sein. Hier einige Szenarien, in denen Sie sie einsetzen können:

Intelligentere Nachrichten-Alternativen

Wenn Ihr Bot bei derselben Anfrage jedes Mal eine andere KI-Antwort senden soll, müssen Sie das Caching verhindern (siehe Anhang für Details). In manchen Fällen ist der höhere KI-Aufwand durch ein besseres Gesprächserlebnis gerechtfertigt – aber nicht immer.

Denken Sie zum Beispiel an eine einfache Begrüßung, die per LLM generiert wird. Jede Begrüßung verursacht zusätzliche KI-Kosten. Lohnt sich das? Wahrscheinlich nicht. Zum Glück gibt es eine kostengünstige Alternative: Verwenden Sie ein Array mit mehreren Antworten und eine einfache Funktion, um zufällig eine Antwort auszuwählen und anzuzeigen.

Je nach Gesprächsvolumen kann sich der Aufwand für diese Methode finanziell deutlich lohnen.

Weitere Details zur Implementierung alternativer Nachrichten finden Sie hier.

Code-Ausführung für einfache Aufgaben

Für einfache Aufgaben wie Datenumwandlung oder das Extrahieren von Informationen aus strukturierten Daten ist die Execute Code-Karte oft effizienter, günstiger und schneller als ein LLM.

Alternativen zum Summary Agent

Mit Execute Code-Karten können Sie Ihr eigenes Transkript erstellen. Platzieren Sie eine Execute Code-Karte überall dort, wo Sie Nutzer- und Bot-Nachrichten in einer Array-Variable speichern möchten. Später können Sie dieses Array als Kontext an Ihre KB übergeben.

Vereinfachen, wo möglich

Wählen Sie die einfachste Interaktionsmethode, die das Ziel erreicht, ohne das Nutzererlebnis zu verschlechtern. Möchten Sie z. B. Nutzerfeedback einholen, ist ein einfaches Sternebewertungssystem mit Kommentaren kostengünstiger als eine KI-basierte Lösung.

Tipps für KI-Aufgaben, KI-Textgenerierung und Übersetzungen

Das richtige KI-Modell wählen

Ja, die Wahl des richtigen KI-Modells ist so wichtig, dass sie zweimal erwähnt wird. Wie bei KBs beeinflusst das Modell auch bei KI-Aufgaben die Kosten erheblich. Nutzen Sie GPT-3.5 Turbo für weniger komplexe Anweisungen. Testen Sie Ihr Setup gründlich mit diesem Modell, bevor Sie ein Upgrade in Erwägung ziehen. Denken Sie daran: GPT-4 Turbo kostet 20-mal mehr als GPT-3.5 Turbo. Wenn die Ergebnisse nicht deutlich besser sind, bleiben Sie bei GPT-3.5 Turbo.

Zusätzlich können Sie KI-Kosten sparen, indem Sie die Anzahl der Tokens pro KI-Aufgabenlauf reduzieren.

Ich empfehle, diese Zahl bewusst zu senken, da zusätzliche Tokens dann abgeschnitten werden. Begrenzen Sie zum Beispiel die Länge auf 2000 Tokens und Ihr Prompt plus Ausgabe überschreitet diesen Wert, wird Ihr Input entsprechend gekürzt.

KI-Aufgabe vs. KI-Textgenerierung

Für einfache Textausgaben benötigt die KI-Textgenerierung weniger Tokens und ist leichter einzurichten als die KI-Aufgabe. Geht es um das Auslesen von Informationen, ist die KI-Aufgabe der KI-Textgenerierung überlegen.

Daher empfehle ich die KI-Aufgabe, wenn Sie KI zur Informationsverarbeitung nutzen möchten (z. B. um die Nutzerabsicht zu erkennen oder Eingaben zu analysieren). Möchten Sie KI zur Texterstellung einsetzen, nutzen Sie stattdessen die KI-Textgenerierung (z. B. um eine KB-Antwort zu erweitern oder kreativ eine Frage zu generieren).

Für einen tieferen Einblick in die Unterschiede zwischen KI-Aufgabe und KI-Textgenerierung erfahren Sie hier mehr.

Übersetzungen

Wenn Ihr Bot viele mehrsprachige Gespräche führen soll, empfiehlt es sich, Hooks mit externen Übersetzungsdiensten zu integrieren, um Kosten zu sparen.

Weitere Informationen zu Hooks finden Sie hier.

Abschluss

Mit diesen Strategien und Tipps können Sie Ihre KI-Kosten in Botpress optimieren. Wenn Sie die Kosten verschiedener Aufgaben kennen und die effizientesten Methoden wählen, senken Sie Ihre KI-Ausgaben, ohne auf Leistung zu verzichten.

Unser Team unterstützt Sie dabei, die passenden Optionen zu finden, damit Ihr Bot Ihren Nutzern das bestmögliche Erlebnis zu den effizientesten Kosten bietet. Besuchen Sie unsere Preisseite für weitere Informationen oder treten Sie unserem Discord-Server bei, um Unterstützung zu erhalten.

Anhang

So verhindern Sie Caching

Wenn Sie Caching umgehen möchten, um immer aktuelle Ergebnisse zu erhalten, können Sie eine der folgenden Optionen wählen:

- Für eine dauerhafte Vermeidung von Caching: Fügen Sie `And discard:{{Date.now()}}` in alle KI-bezogenen Karten ein (z. B. in KI-Task-Prompts, im KB-Kontext usw.).

- Für eine temporäre Vermeidung von Caching: Veröffentlichen Sie Ihren Bot und testen Sie ihn in einem Inkognito-Fenster.

Hinweis: Wenn Sie diese Caching-Ebene entfernen und sonst keine Änderungen an Ihrem Bot vornehmen, steigen die KI-Kosten.

Empfohlene Kurse

- ChatGPT Prompt Engineering für Entwickler (obwohl der Titel sich an Entwickler richtet, profitieren auch Nicht-Entwickler davon!)

- Systeme mit der ChatGPT API bauen

.webp)