- Botpress biedt transparante prijzen zonder verborgen AI-kosten, zodat je AI-kosten alleen je werkelijke gebruik weerspiegelen.

- Het cachen van AI-reacties kan de querykosten met ongeveer 30% verlagen zonder de gebruikerservaring te schaden.

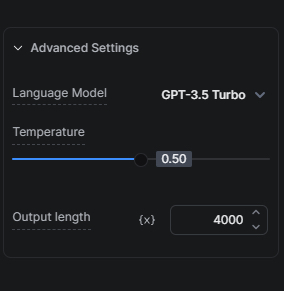

- Het kiezen van het juiste AI-model, zoals beginnen met GPT.5 Turbo in plaats van GPT, is cruciaal voor het vinden van de juiste balans tussen kosten en kwaliteit.

Veel bedrijven staan voor de uitdaging om het potentieel van AI-technologieën te benutten zonder te veel uit te geven. Wij begrijpen het belang van deze balans en zetten ons in om oplossingen te bieden waarmee onze gebruikers kosteneffectief gebruik kunnen maken van AI.

Onze benadering van AI-kosten

Ten eerste is het belangrijk om twee belangrijke onderdelen te begrijpen van hoe we de AI-gerelateerde kosten voor onze gebruikers verlagen en toch de voordelen van AI-mogelijkheden bieden.

Transparante prijzen: Geen verborgen kosten

We voegen geen marges toe aan AI-gerelateerde taken. Dit betekent dat de kosten van uw AI-uitgaven direct gerelateerd zijn aan uw werkelijke gebruik zonder extra AI-vergoedingen van onze kant.

AI-respons cachen

Caching is een van onze meest effectieve strategieën om de AI-kosten van bots te verlagen. Door AI-reacties te cachen, verminderen we het aantal verzoeken aan de LLM provider. Dit kan de kosten van zoekopdrachten met ongeveer 30% verlagen, waardoor u geld bespaart zonder afbreuk te doen aan de kwaliteit van de interacties van de bot met uw gebruikers.

Tips om AI-kosten te optimaliseren

Nu we twee van de benaderingen hebben gezien die we gebruiken om de AI-kosten van onze gebruikers te verlagen, laten we eens kijken naar tips die u kunt gebruiken tijdens het bouwen van uw bot om de AI-kosten verder te verlagen.

Uw kennisbanken optimaliseren

Het optimaliseren van je kennisbanken (KB's) kan je AI-uitgaven sterk beïnvloeden, omdat KB's meestal de grootste AI-kostenfactor zijn in een Botpress project.

Tip 1: Kies het juiste AI-model

De keuze van een AI-model heeft een aanzienlijke invloed op de kosten. Aangezien GPT-3.5 Turbo sneller en goedkoper is dan GPT-4 Turbo, raden we aan om je setup grondig te testen met GPT-3.5 Turbo voordat je een upgrade naar een geavanceerdere versie overweegt.

Onze KB Agent hybride modus biedt een uitstekende middenweg, omdat we in eerste instantie GPT-3.5 Turbo gebruiken om te proberen een antwoord te geven op een vraag en alleen escaleren naar GPT-4 Turbo als dat nodig is.

Tip 2: Scherm uw KB af

Je kunt je AI-uitgaven verlagen door je KB af te schermen van onnodige typische veelgestelde vragen die geen AI of slim antwoord nodig hebben met een Zoek Records-kaart. Dit is hoe het werkt: als je weet dat gebruikers meestal één vraag stellen en we hebben 50 bekende vragen met hun antwoorden, dan kunnen we die toevoegen aan een tabel en die tabel bevragen met een Find Records-kaart. Als we geen antwoord vinden, kijken we pas daarna in een KB.

Tip 3: Zorg voor de juiste reikwijdte van je KB's

Afhankelijk van het type informatie en de hoeveelheid informatie die je aan een KB wilt toevoegen, is het meestal het beste om twee dingen tegelijk te doen om de kosten van AI Spend te beperken. Ten eerste, organiseer je informatie in kleinere KB's, met elke KB gericht op een specifiek product/functie/onderwerp. Ten tweede, stuur de gebruiker door een workflow met meerdere vragen om je zoekopdracht te beperken tot een specifieke KB; dit zal niet alleen de kosten verlagen, maar ook betere resultaten opleveren.

Tip 4: Website KB-gegevensbron versus KB-gegevensbron op het web doorzoeken

Als u een website gebruikt als uw KB-gegevensbron, maar niet voortdurend wijzigingen aanbrengt aan de website die in realtime moeten worden doorgegeven aan uw bot, dan is een goed en kosteneffectief alternatief om Search The Web te gebruiken als uw KB-gegevensbron in plaats van de Website KB-gegevensbron. Voordat u deze overstap maakt, moet u testen of de prestaties op de vragen die u verwacht te gaan stellen niet verslechteren door deze overstap.

Tip 5: Tabellen ondervragen met de kaart Records zoeken of Code uitvoeren

Als je een Tabel hebt met gegevens die je wilt opvragen, overweeg dan om de Zoek Records-kaart te gebruiken in plaats van de Tabel in een KB. Voor mensen met technische expertise kan het uitvoeren van code een nog kostenefficiëntere methode zijn om een tabel te bevragen. Je doet dit door de tabel rechtstreeks te bevragen vanaf de kaart Code uitvoeren en de uitvoer op te slaan in een workflowvariabele waarnaar je later kunt verwijzen.

Tip 6: Beheers de brokken

Met chunks bedoel ik het aantal chunks dat uit de Knowledge Base wordt opgehaald om een antwoord te genereren. Over het algemeen geldt: hoe meer chunks worden opgehaald, hoe nauwkeuriger het antwoord, maar het duurt langer om meer AI-tokens te genereren en te kosten. Experimenteer met de grootte van de brokken om de laagste hoeveelheid vast te stellen die nog steeds tot nauwkeurige antwoorden leidt.

Gebruik Codekaart uitvoeren om AI-uitgaven te verlagen

De Execute Code-kaart kan een geschikte, kosteneffectieve vervanging zijn voor sommige AI-kaarten. Hier zijn een paar scenario's waarin je het gebruik ervan kunt overwegen:

Slimmere bericht alternatieven

Als je wilt dat je bot elke keer een ander AI-antwoord stuurt voor dezelfde vraag, moet je caching voorkomen (zie de bijlage om te leren hoe). Er zijn scenario's waarbij de toename in AI-uitgaven kan worden gerechtvaardigd door de verbetering van de conversatie-ervaring. Maar dit is niet altijd het geval.

Denk bijvoorbeeld aan een eenvoudige begroeting die wordt gegenereerd met LLMs. Bij elke begroeting maak je extra kosten voor AI Spend. Is dat het waard? Waarschijnlijk niet. Gelukkig is er een kosteneffectieve oplossing: gebruik een array met meerdere antwoorden en een eenvoudige functie om willekeurig een waarde op te halen en deze te presenteren.

Afhankelijk van het gespreksvolume kan het bedrag dat je bespaart door deze methode toe te passen de moeite waard zijn.

Meer informatie over het implementeren van alternatieve berichten vind je hier.

Uitvoering van code voor eenvoudige taken

Voor eenvoudige taken, zoals het herformatteren van gegevens of het extraheren van informatie uit gestructureerde gegevens, kan het gebruik van de Execute Code-kaart efficiënter, goedkoper en sneller zijn dan te vertrouwen op een LLM.

Alternatieven voor Samenvatting Agent

Je kunt Execute Code-kaarten gebruiken om je eigen transcript te maken. Plaats een Execute Code-kaart waar je maar wilt om de berichten van gebruikers en bots te volgen in een arrayvariabele. Daarna kun je die array gebruiken en als context aan je KB toevoegen.

Vereenvoudig waar mogelijk

Kies voor de eenvoudigere interactiemethode die hetzelfde doel bereikt zonder de gebruikerservaring te verslechteren. Als je bijvoorbeeld feedback van gebruikers wilt verzamelen, is een eenvoudig beoordelingssysteem met sterren en opmerkingen kosteneffectiever dan het gebruik van AI om dezelfde informatie te verzamelen.

Tips voor AI-taken, AI genereert tekst en vertalingen

Kies het juiste AI-model

Ja, het kiezen van het juiste AI-model is zo belangrijk dat het de moeite waard is om het twee keer te noemen. Net als bij KB's heeft de keuze van een AI-model een grote invloed op de kosten als het gaat om AI-taken. Kies voor GPT-3.5 Turbo voor minder ingewikkelde instructies. Voordat je een upgrade naar geavanceerdere versies overweegt, moet je je opstelling grondig testen met dit model. Vergeet niet dat GPT-4 Turbo 20x meer kost dan GPT-3.5 Turbo. Tenzij de resultaten aanzienlijk beter zijn, kies dan voor GPT-3.5 Turbo.

Naast het bovenstaande kunt u ook AI-uitgaven besparen door het aantal tokens dat wordt verbruikt bij elke AI-taakuitvoering te verminderen.

Mijn aanbeveling is om bewust te zijn van het verlagen van dit aantal, omdat dit ertoe zal leiden dat eventuele extra tokens worden afgekapt. Als u bijvoorbeeld de lengte beperkt tot 2000 tokens en uw prompt plus uw uitvoer meer dan 2000 tokens is, wordt uw invoer dienovereenkomstig afgekapt.

AI taak vs AI tekst genereren

Voor eenvoudige tekstuitvoer gebruikt de AI Generate Text-kaart minder tokens en is hij eenvoudiger in te stellen dan de AI Task-kaart. Voor taken waarbij informatie moet worden geparseerd, presteert de AI Task-kaart beter dan de AI Generate Text-kaart.

Daarom raad ik je aan om de AI Task kaart te gebruiken als je AI wilt gebruiken om informatie te verwerken (bijvoorbeeld als je de intentie van de gebruiker wilt detecteren of als je wilt dat de AI de invoer analyseert). Maar als je AI wilt gebruiken om tekst te genereren, gebruik dan de kaart AI Genereer tekst (bijvoorbeeld als je een KB-antwoord wilt nemen en uitbreiden of als je op een creatieve manier een vraag wilt genereren).

Lees hier meer over de verschillen tussen de AI Task-kaart en AI Generate Text-kaart.

Vertalingen

Als je bot een groot aantal meertalige conversaties gaat afhandelen, overweeg dan om hooks te integreren met externe vertaaldiensten voor een meer kosteneffectieve optie.

Meer informatie over haken vindt u hier.

Conclusie

Met deze strategieën en tips kunt u uw AI-uitgaven optimaliseren in Botpress. Als u de kostenimplicaties van verschillende taken begrijpt en de meest efficiënte methoden voor uw behoeften kiest, kunt u uw AI-gerelateerde uitgaven verlagen zonder dat dit ten koste gaat van de prestaties.

Ons team is er om u te helpen bij het navigeren door deze opties en ervoor te zorgen dat uw bot de best mogelijke ervaring levert voor uw gebruikers tegen de meest efficiënte kosten. Bezoek onze Prijzen pagina voor meer informatie of bezoek onze Discord server voor hulp.

Bijlage

Caching voorkomen

Als je caching wilt omzeilen om altijd live resultaten te krijgen, kun je een van de volgende opties doen:

- For more permanent caching prevention: add `And discard:{{Date.now()}}` in all your AI-related cards (e.g., in the AI Task prompts, in the KB context, etc.).

- Voor tijdelijke cachingpreventie: publiceer uw bot en test hem vanuit een incognitovenster.

Opmerking: als je deze cachinglaag verwijdert en geen andere wijzigingen aan je bot aanbrengt, zullen de AI-kosten toenemen.

Aanbevolen cursussen

- ChatGPT Prompt Engineering voor ontwikkelaars (hoewel de titel zegt dat het voor ontwikkelaars is, zullen ook niet-ontwikkelaars ervan profiteren!)

- Systemen bouwenmet de ChatGPT API

.webp)