- Botpress menawarkan harga yang telus tanpa yuran AI tersembunyi, membolehkan kos AI anda hanya mencerminkan penggunaan sebenar anda.

- Menyimpan respons AI (caching) boleh mengurangkan kos pertanyaan sekitar 30% tanpa menjejaskan pengalaman pengguna.

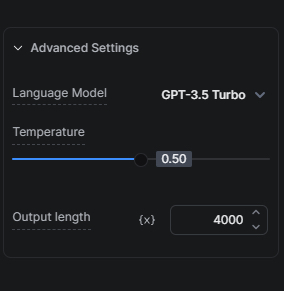

- Memilih model AI yang sesuai, seperti bermula dengan GPT-3.5 Turbo berbanding GPT-4, sangat penting untuk mengimbangi kos dan kualiti.

Ramai perniagaan menghadapi cabaran untuk memanfaatkan potensi teknologi AI tanpa berbelanja berlebihan. Kami faham kepentingan keseimbangan ini dan komited untuk menyediakan penyelesaian yang membolehkan pengguna kami menggunakan AI secara berkesan dari segi kos.

Pendekatan Kami terhadap Kos AI

Pertama, penting untuk memahami dua komponen utama bagaimana kami mengurangkan kos berkaitan AI untuk pengguna kami sambil tetap menawarkan kelebihan AI.

Harga Telus: Tiada Yuran Tersembunyi

Kami tidak menambah sebarang margin pada tugasan berkaitan AI. Ini bermakna kos Perbelanjaan AI anda berkait terus dengan penggunaan sebenar anda tanpa sebarang yuran AI tambahan daripada pihak kami.

Menyimpan Respons AI (Caching)

Caching adalah salah satu strategi paling berkesan kami untuk mengurangkan kos AI bot. Dengan menyimpan respons AI, kami mengurangkan jumlah permintaan kepada penyedia LLM yang boleh mengurangkan kos pertanyaan sekitar 30%, menjimatkan wang anda tanpa menjejaskan kualiti interaksi bot dengan pengguna anda.

Tip untuk mengoptimumkan Kos AI

Sekarang setelah kita melihat dua pendekatan yang kami gunakan untuk menurunkan Perbelanjaan AI pengguna, mari lihat tip yang boleh anda gunakan semasa membina bot anda untuk mengurangkan lagi kos AI.

Optimumkan Pangkalan Pengetahuan anda

Mengoptimumkan Pangkalan Pengetahuan (KB) anda boleh memberi kesan besar kepada Perbelanjaan AI kerana KB biasanya merupakan pendorong kos AI terbesar dalam projek Botpress.

Tip 1: Pilih Model AI yang Sesuai

Pemilihan model AI sangat mempengaruhi kos. Oleh kerana GPT-3.5 Turbo lebih pantas & murah berbanding GPT-4 Turbo, kami mengesyorkan anda menguji sepenuhnya tetapan anda dengan GPT-3.5 Turbo sebelum mempertimbangkan naik taraf ke versi yang lebih canggih.

Mod hibrid Ejen KB kami menawarkan jalan tengah yang baik, di mana kami mula-mula menggunakan GPT-3.5 Turbo untuk cuba menjawab pertanyaan dan hanya beralih ke GPT-4 Turbo jika perlu.

Tip 2: Lindungi KB anda

Anda boleh mengurangkan Perbelanjaan AI dengan melindungi KB anda daripada soalan lazim yang tidak memerlukan AI atau jawapan pintar dengan menggunakan kad Find Records. Caranya: jika anda tahu pengguna biasanya bertanya satu soalan dan kami mempunyai 50 soalan terkenal dengan jawapannya, kita boleh masukkan ke dalam jadual dan membuat pertanyaan menggunakan kad Find Records. Jika tiada jawapan dijumpai, barulah kita rujuk KB.

Tip 3: Skopkan KB anda dengan betul

Bergantung pada jenis dan jumlah maklumat yang anda ingin masukkan ke dalam KB, amalan terbaik biasanya ialah lakukan dua perkara serentak untuk mengurangkan kos Perbelanjaan AI. Pertama, susun maklumat anda ke dalam KB yang lebih kecil, setiap satu mengikut produk/ciri/topik tertentu. Kedua, bawa pengguna melalui aliran kerja dengan beberapa soalan untuk mengecilkan carian ke KB tertentu; ini bukan sahaja mengurangkan kos, malah memberikan hasil yang lebih baik.

Tip 4: Sumber Data KB Laman Web vs Sumber Data KB Cari Web

Jika anda menggunakan laman web sebagai sumber data KB tetapi tidak membuat perubahan berterusan pada laman web yang perlu ditunjukkan kepada bot anda secara masa nyata, alternatif yang lebih menjimatkan ialah gunakan Cari Web sebagai sumber data KB dan bukannya KB Laman Web. Sebelum beralih, pastikan anda menguji prestasi pada soalan yang dijangka tidak merosot dengan pertukaran ini.

Tip 5: Buat Pertanyaan Jadual dengan kad Find Records atau Execute Code

Jika anda mempunyai Jadual dengan data yang ingin anda pertanyakan, pertimbangkan untuk menggunakan kad Find Records dan bukannya menggunakan Jadual dalam KB. Untuk mereka yang mahir teknikal, melaksanakan kod boleh menjadi kaedah pertanyaan Jadual yang lebih menjimatkan. Anda boleh melakukannya dengan membuat pertanyaan terus dari kad Execute Code dan menyimpan output ke dalam pembolehubah aliran kerja untuk rujukan kemudian.

Tip 6: Kawal Bilangan Chunks

Dengan 'chunk', saya maksudkan bilangan bahagian maklumat yang akan diambil dari Pangkalan Pengetahuan untuk menjana jawapan. Secara amnya, lebih banyak chunk diambil, lebih tepat jawapannya – tetapi ia akan mengambil masa lebih lama untuk dijana dan menggunakan lebih banyak token AI. Uji saiz chunk untuk menentukan jumlah minimum yang masih memberikan respons tepat.

Guna Kad Execute Code untuk mengurangkan kos Perbelanjaan AI

Kad Execute Code boleh menjadi pengganti yang sesuai dan menjimatkan untuk beberapa kad AI. Berikut beberapa situasi di mana anda boleh mempertimbangkannya:

Alternatif Mesej Lebih Pintar

Jika anda mahu bot anda menghantar respons AI berbeza untuk pertanyaan sama setiap kali, anda mesti elakkan caching (lihat Lampiran untuk cara melakukannya). Ada situasi di mana peningkatan Perbelanjaan AI boleh diterima kerana pengalaman perbualan yang lebih baik. Tetapi ini tidak selalu berlaku.

Contohnya, untuk ucapan ringkas yang dijana dengan LLM. Setiap ucapan akan menambah kos Perbelanjaan AI. Adakah ia berbaloi? Mungkin tidak. Nasib baik, ada cara lebih menjimatkan: gunakan array dengan beberapa respons dan fungsi ringkas untuk memilih secara rawak dan memaparkannya.

Bergantung pada jumlah perbualan, penjimatan yang anda peroleh dengan kaedah ini boleh sangat berbaloi.

Anda boleh dapatkan maklumat lanjut tentang cara melaksanakan mesej alternatif di sini.

Pelaksanaan Kod untuk Tugasan Mudah

Untuk tugasan mudah seperti memformat semula data atau mengekstrak maklumat dari data berstruktur, menggunakan kad Execute Code boleh jadi lebih cekap, murah dan pantas berbanding bergantung pada LLM.

Alternatif kepada Summary Agent

Anda boleh gunakan kad Execute Code untuk mencipta transkrip anda sendiri. Letakkan kad Execute Code di mana-mana anda ingin menjejak mesej pengguna dan bot dalam pembolehubah array. Selepas itu, anda boleh gunakan array tersebut sebagai konteks untuk KB anda.

Permudahkan Jika Boleh

Pilih kaedah interaksi yang lebih mudah yang mencapai matlamat sama tanpa menjejaskan pengalaman pengguna. Contohnya, jika anda ingin mengumpul maklum balas pengguna, sistem penilaian bintang dengan komen adalah lebih menjimatkan berbanding menggunakan AI untuk mengumpul maklumat yang sama.

Tip untuk AI Tasks, AI Generate Text, dan Terjemahan

Pilih Model AI yang Sesuai

Ya, memilih model AI yang sesuai sangat penting sehingga perlu disebut dua kali. Seperti KB, pemilihan model AI sangat mempengaruhi kos untuk AI Tasks. Pilih GPT-3.5 Turbo untuk arahan yang kurang rumit. Sebelum menaik taraf ke versi lebih canggih, uji sepenuhnya tetapan anda dengan model ini. Ingat, GPT-4 Turbo 20 kali ganda lebih mahal daripada GPT-3.5 Turbo. Kecuali hasilnya jauh lebih baik, pilih GPT-3.5 Turbo.

Selain itu, anda juga boleh menjimatkan Perbelanjaan AI dengan mengurangkan jumlah token yang digunakan dalam setiap larian AI Task.

Cadangan saya ialah sentiasa peka untuk mengurangkan nombor ini kerana sebarang token tambahan akan dipotong. Contohnya, jika anda hadkan panjang kepada 2000 token dan prompt serta output anda melebihi 2000 token, input anda akan dipotong mengikut had tersebut.

AI Task vs AI Generate Text

Untuk output teks ringkas, kad AI Generate Text menggunakan lebih sedikit token dan lebih mudah disediakan berbanding kad AI Task. Untuk tugasan yang melibatkan pemprosesan maklumat, kad AI Task lebih baik daripada kad AI Generate Text.

Jadi, cadangan saya ialah gunakan kad AI Task jika anda mahu AI memproses maklumat (contohnya mengesan niat pengguna atau menganalisis input). Tetapi, jika anda mahu AI menjana teks, gunakan kad AI Generate Text (contohnya untuk mengembangkan jawapan KB atau menjana soalan secara kreatif).

Untuk penerangan lebih lanjut tentang perbezaan antara kad AI Task dan AI Generate Text, ketahui lebih lanjut di sini.

Terjemahan

Jika bot anda akan mengendalikan banyak perbualan berbilang bahasa, pertimbangkan untuk mengintegrasikan hooks dengan perkhidmatan terjemahan luaran sebagai pilihan yang lebih menjimatkan.

Anda boleh dapatkan maklumat lanjut tentang hooks di sini.

Penutup

Dengan strategi dan tip ini, anda akan dapat mengoptimumkan Perbelanjaan AI anda dalam Botpress. Memahami implikasi kos untuk setiap tugasan dan memilih kaedah paling cekap untuk keperluan anda akan mengurangkan perbelanjaan berkaitan AI tanpa menjejaskan prestasi.

Pasukan kami sedia membantu anda meneliti pilihan-pilihan ini dan memastikan bot anda memberikan pengalaman terbaik kepada pengguna anda dengan kos yang paling efisien. Lawati halaman Harga kami untuk maklumat lanjut atau sertai pelayan Discord kami untuk mendapatkan bantuan.

Lampiran

Cara Mengelakkan Cache

Jika anda ingin mengatasi cache supaya sentiasa mendapat hasil terkini, anda boleh lakukan salah satu daripada pilihan berikut:

- Untuk mengelakkan cache secara kekal: tambah `And discard:{{Date.now()}}` dalam semua kad berkaitan AI anda (contohnya, dalam arahan Tugas AI, dalam konteks KB, dan sebagainya).

- Untuk mengelakkan cache secara sementara: terbitkan bot anda dan uji dari tetingkap incognito.

Kursus Disyorkan

- Kejuruteraan Prompt ChatGPT untuk Pembangun (walaupun tajuknya untuk pembangun, bukan pembangun juga boleh mendapat manfaat!)

- Membina Sistem dengan API ChatGPT

.webp)