- Nag-aalok ang Botpress ng malinaw na pagpepresyo na walang nakatagong bayad sa AI, kaya ang gastos mo sa AI ay sumasalamin lang sa aktuwal mong paggamit.

- Ang pag-cache ng mga sagot ng AI ay maaaring magbawas ng gastos sa query ng halos 30% nang hindi naaapektuhan ang karanasan ng gumagamit.

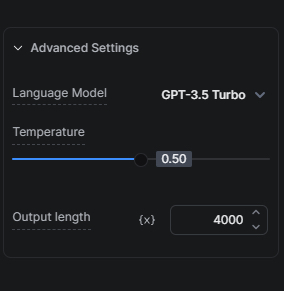

- Ang pagpili ng tamang modelo ng AI, tulad ng pagsisimula sa GPT-3.5 Turbo imbes na GPT-4, ay mahalaga para mapagbalanse ang gastos at kalidad.

Maraming negosyo ang nahihirapan kung paano mapapakinabangan ang AI nang hindi lumalagpas sa budget. Nauunawaan namin ang kahalagahan ng balanse na ito at nakatuon kami sa pagbibigay ng mga solusyon para magamit ng aming mga user ang AI nang matipid.

Ang aming paraan sa Gastos sa AI

Una, mahalagang maunawaan ang dalawang pangunahing bahagi kung paano namin binabawasan ang gastos sa AI para sa aming mga user habang patuloy na inaalok ang mga benepisyo ng AI.

Malinaw na Pagpepresyo: Walang Nakatagong Bayad

Hindi kami nagdadagdag ng patong sa mga gawaing may kinalaman sa AI. Ibig sabihin, ang gastos mo sa AI ay direktang nakabatay sa aktuwal mong paggamit at walang dagdag na bayad mula sa amin.

Pag-cache ng mga Sagot ng AI

Ang caching ay isa sa pinaka-epektibong paraan namin para mapababa ang gastos ng AI ng mga bot. Sa pag-cache ng mga sagot ng AI, nababawasan ang bilang ng request sa LLM provider na maaaring magbawas ng gastos sa query ng mga 30%—nakakatipid ka nang hindi bumababa ang kalidad ng pakikipag-usap ng bot sa iyong mga user.

Mga Tip para I-optimize ang Gastos sa AI

Ngayong nakita na natin ang dalawang paraan namin para mapababa ang AI Spend ng mga user, narito ang mga tips na magagamit mo habang ginagawa ang iyong bot para mas lalo pang bumaba ang gastos sa AI.

I-optimize ang Iyong Knowledge Bases

Malaki ang epekto ng pag-optimize ng iyong Knowledge Bases (KBs) sa AI Spend dahil kadalasan ito ang pinakamalaking pinagmumulan ng gastos sa AI sa isang proyekto sa Botpress.

Tip 1: Piliin ang Tamang Modelo ng AI

Malaki ang epekto ng pagpili ng modelo ng AI sa gastos. Dahil mas mabilis at mas mura ang GPT-3.5 Turbo kaysa GPT-4 Turbo, inirerekomenda naming subukan muna nang mabuti ang iyong setup gamit ang GPT-3.5 Turbo bago mag-upgrade sa mas advanced na bersyon.

Nag-aalok ang hybrid mode ng aming KB Agent ng magandang balanse, dahil una naming ginagamit ang GPT-3.5 Turbo para sumagot sa query at lilipat lang sa GPT-4 Turbo kung kinakailangan.

Tip 2: Protektahan ang Iyong KB

Mababawasan mo ang AI Spend sa pamamagitan ng pagprotekta sa iyong KB mula sa mga karaniwang FAQ na hindi nangangailangan ng AI o matalinong pagsagot gamit ang Find Records card. Ganito ito gumagana: kung alam mong madalas itanong ng mga user ang isang tanong at mayroon tayong 50 kilalang tanong at sagot, maaari natin itong ilagay sa isang table at i-query gamit ang Find Records card. Kapag walang nahanap na sagot, doon lang tayo titingin sa KB.

Tip 3: Ayusin nang Tama ang Saklaw ng Iyong KBs

Depende sa uri at dami ng impormasyong gusto mong ilagay sa KB, mainam na gawin ang dalawang bagay nang sabay para mapababa ang gastos sa AI. Una, hatiin ang impormasyon sa mas maliliit na KBs na nakatuon sa partikular na produkto/tampok/paksa. Pangalawa, gabayan ang user sa isang workflow na may maraming tanong para paliitin ang saklaw ng paghahanap sa isang tiyak na KB; hindi lang nito babawasan ang gastos, magbibigay din ito ng mas magagandang resulta.

Tip 4: Website KB Data Source vs Search the Web KB Data Source

Kung ginagamit mo ang website bilang KB data source pero hindi naman madalas magbago ang laman ng website na kailangang makita agad ng bot, mas matipid na alternatibo ang gamitin ang Search The Web bilang KB data source imbes na Website KB data source. Bago magpalit, tiyaking hindi bababa ang performance sa mga tanong na inaasahan mong itanong ng mga user.

Tip 5: Mag-query ng Tables gamit ang Find Records o Execute Code card

Kung may Table kang gustong i-query, subukan gamitin ang Find Records card imbes na gamitin ang Table sa isang KB. Para sa may teknikal na kaalaman, mas matipid pa ang direktang pag-query sa Table gamit ang Execute Code card at itago ang resulta sa workflow variable na magagamit mo sa susunod.

Tip 6: Kontrolin ang Chunks

Ang tinutukoy kong chunks ay ang bilang ng chunks na kukunin mula sa Knowledge Base para makabuo ng sagot. Karaniwan, mas maraming chunks ang kinukuha, mas tumpak ang sagot—pero mas matagal gawin at mas magastos sa AI tokens. Subukan ang iba't ibang laki ng chunk para matukoy ang pinakamababang bilang na nagbibigay pa rin ng tumpak na sagot.

Gamitin ang Execute Code Card para mapababa ang Gastos sa AI

Ang Execute Code card ay maaaring maging angkop at matipid na pamalit sa ilang AI cards. Narito ang ilang sitwasyon kung kailan mo ito maaaring gamitin:

Mas Matalinong Alternatibo sa Mensahe

Kung gusto mong magpadala ang bot mo ng iba-ibang AI sagot sa parehong tanong sa bawat pagkakataon, kailangan mong iwasan ang caching (tingnan ang Appendix para matutunan kung paano). May mga pagkakataon na makatarungan ang dagdag na gastos sa AI dahil sa mas magandang karanasan sa usapan. Pero hindi ito palaging ganoon.

Halimbawa, isang simpleng pagbati na ginagawa ng LLMs. Sa bawat pagbati, may dagdag kang gastos sa AI. Sulit ba ito? Malamang hindi. Mabuti na lang, may matipid na paraan: gumamit ng array na may maraming sagot at isang simpleng function para pumili nang random at ipakita ito.

Depende sa dami ng usapan, maaaring sulit sa pagsisikap ang matitipid mo sa pamamaraang ito.

Makikita mo ang higit pang detalye sa kung paano mag-implement ng alternatibong mensahe dito.

Pagpapatakbo ng Code para sa Simpleng Gawain

Para sa mga simpleng gawain tulad ng pagrereporma ng data o pagkuha ng impormasyon mula sa estrukturadong datos, mas mabilis, mas mura, at mas episyente ang paggamit ng Execute Code card kaysa umasa sa LLM.

Mga Alternatibo sa Summary Agent

Maaari kang gumamit ng Execute Code cards para gumawa ng sarili mong transcript. Ilagay ang Execute Code card kung saan mo gustong i-track ang mga mensahe ng user at bot sa isang array variable. Pagkatapos, magagamit mo ang array na iyon bilang konteksto sa iyong KB.

Pagsimplehin Kung Maaari

Piliin ang pinakasimpleng paraan ng interaksyon na nakakamit pa rin ang layunin nang hindi bumababa ang karanasan ng user. Halimbawa, kung gusto mong mangolekta ng feedback mula sa user, mas matipid ang simpleng star rating system na may komento kaysa gumamit ng AI para kunin ang parehong impormasyon.

Mga Tip para sa AI Tasks, AI Generate Text, at Pagsasalin

Piliin ang Tamang Modelo ng AI

Oo, napakahalaga ng pagpili ng tamang modelo ng AI kaya't inuulit namin ito. Tulad ng sa KBs, malaki ang epekto ng pagpili ng modelo ng AI sa gastos kapag AI Tasks ang usapan. Piliin ang GPT-3.5 Turbo para sa hindi komplikadong mga utos. Bago mag-upgrade sa mas advanced na bersyon, subukan muna nang mabuti ang setup mo gamit ang modelong ito. Tandaan, 20x ang presyo ng GPT-4 Turbo kumpara sa GPT-3.5 Turbo. Maliban kung mas maganda talaga ang resulta, piliin ang GPT-3.5 Turbo.

Bukod dito, makakatipid ka rin sa AI Spend kung babawasan mo ang bilang ng tokens na ginagamit sa bawat takbo ng AI Task.

Ang rekomendasyon ko ay maging maingat sa pagbabawas ng bilang na ito dahil anumang sobrang token ay puputulin. Halimbawa, kung nilimitahan mo sa 2,000 tokens at ang prompt plus output mo ay higit dito, puputulin ang input mo nang naaayon.

AI Task vs AI Generate Text

Para sa simpleng text output, mas kaunti ang tokens na ginagamit ng AI Generate Text card at mas madaling i-setup kaysa AI Task card. Para naman sa mga gawain na nangangailangan ng pag-parse ng impormasyon, mas mahusay ang AI Task card kaysa AI Generate Text card.

Kaya ang rekomendasyon ko: gamitin ang AI Task card kung gusto mong gamitin ang AI para magproseso ng impormasyon (hal. kung gusto mong tukuyin ang layunin ng user o ipa-analyze sa AI ang input). Pero kung gusto mong gamitin ang AI para gumawa ng teksto, gamitin ang AI Generate Text card (hal. kung gusto mong palawakin ang sagot mula sa KB o kung gusto mong gumawa ng tanong sa malikhaing paraan).

Para sa mas malalim na pagtalakay sa pagkakaiba ng AI Task card at AI Generate Text card, alamin pa rito.

Pagsasalin

Kung ang iyong bot ay hahawak ng maraming usapang multilingguwal, isaalang-alang ang pag-integrate ng hooks sa panlabas na serbisyo ng pagsasalin para sa mas matipid na opsyon.

Makikita mo ang karagdagang impormasyon tungkol sa hooks dito.

Pagwawakas

Sa mga estratehiya at tip na ito, mapapahusay mo ang paggamit ng AI mo sa Botpress. Ang pag-unawa sa epekto ng gastos ng iba't ibang gawain at pagpili ng pinaka-episyenteng paraan para sa iyong pangangailangan ay magbabawas ng gastusin sa AI nang hindi bumababa ang pagganap.

Narito ang aming koponan upang tulungan kang mag-navigate sa mga pagpipiliang ito at matiyak na ang iyong bot ay magbibigay ng pinakamahusay na karanasan para sa iyong mga gumagamit sa pinakamabisang halaga. Bisitahin ang aming Pahina ng Presyo para sa karagdagang impormasyon o sumali sa aming Discord server para sa tulong.

Apendiks

Paano Maiiwasan ang Caching

Kung nais mong lampasan ang caching upang palaging makuha ang live na resulta, maaari mong gawin ang alinman sa mga sumusunod na opsyon:

- Para sa mas permanenteng pag-iwas sa caching: idagdag ang `At itapon:{{Date.now()}}` sa lahat ng iyong AI-related na card (halimbawa, sa mga AI Task prompt, sa KB context, atbp.).

- Para sa pansamantalang pag-iwas sa caching: i-publish ang iyong bot at subukan ito mula sa incognito window.

Inirerekomendang mga Kurso

- ChatGPT Prompt Engineering para sa mga Developer (bagaman para sa mga developer ang pamagat, makikinabang din ang mga hindi developer!)

- Paggawa ng mga Sistema gamit ang ChatGPT API

.webp)