- Botpress oferuje przejrzyste ceny bez ukrytych opłat za AI – płacisz tylko za rzeczywiste wykorzystanie AI.

- Buforowanie odpowiedzi AI może obniżyć koszty zapytań nawet o 30%, nie pogarszając doświadczenia użytkownika.

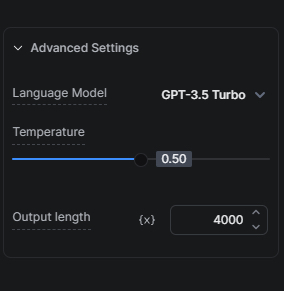

- Wybór odpowiedniego modelu AI, np. rozpoczęcie od GPT-3.5 Turbo zamiast GPT-4, jest kluczowy dla zachowania równowagi między kosztem a jakością.

Wiele firm staje przed wyzwaniem wykorzystania potencjału AI bez nadmiernych wydatków. Rozumiemy, jak ważna jest ta równowaga, i oferujemy rozwiązania, które pozwalają efektywnie kosztowo korzystać z AI.

Nasze podejście do kosztów AI

Najpierw warto poznać dwa kluczowe elementy, dzięki którym obniżamy koszty AI dla naszych użytkowników, jednocześnie zapewniając korzyści płynące z AI.

Przejrzyste ceny: brak ukrytych opłat

Nie doliczamy żadnych marż do zadań związanych z AI. Oznacza to, że Twój koszt AI zależy wyłącznie od rzeczywistego użycia, bez dodatkowych opłat z naszej strony.

Buforowanie odpowiedzi AI

Buforowanie to jedna z najskuteczniejszych metod obniżenia kosztów AI botów. Dzięki buforowaniu odpowiedzi AI zmniejszamy liczbę zapytań do dostawcy LLM, co może obniżyć koszt zapytań o około 30%, oszczędzając pieniądze bez pogorszenia jakości interakcji bota z użytkownikami.

Wskazówki, jak zoptymalizować koszty AI

Skoro poznaliśmy dwa nasze podejścia do obniżania kosztów AI, przyjrzyjmy się wskazówkom, które możesz wykorzystać podczas budowania swojego bota, by jeszcze bardziej zredukować koszty AI.

Optymalizuj bazy wiedzy

Optymalizacja baz wiedzy (KB) ma duży wpływ na koszty AI, ponieważ to właśnie KB są zwykle największym źródłem kosztów AI w projekcie Botpress.

Wskazówka 1: Wybierz odpowiedni model AI

Wybór modelu AI znacząco wpływa na koszty. Ponieważ GPT-3.5 Turbo jest szybszy i tańszy niż GPT-4 Turbo, zalecamy dokładne przetestowanie konfiguracji z GPT-3.5 Turbo przed rozważeniem przejścia na bardziej zaawansowane wersje.

Nasz hybrydowy tryb agenta KB to świetny kompromis – najpierw próbujemy odpowiedzieć na zapytanie za pomocą GPT-3.5 Turbo, a dopiero w razie potrzeby przechodzimy do GPT-4 Turbo.

Wskazówka 2: Chroń swoją bazę wiedzy

Możesz ograniczyć koszty AI, chroniąc bazę wiedzy przed typowymi pytaniami FAQ, które nie wymagają AI ani inteligentnych odpowiedzi, za pomocą karty Find Records. Jak to działa: jeśli wiesz, że użytkownicy często zadają jedno z 50 znanych pytań, możesz dodać je do tabeli i wyszukiwać w niej odpowiedzi kartą Find Records. Jeśli nie znajdziesz odpowiedzi, dopiero wtedy przeszukujesz bazę wiedzy.

Wskazówka 3: Odpowiednio określ zakres baz wiedzy

W zależności od rodzaju i ilości informacji, które chcesz dodać do bazy wiedzy, najlepiej równolegle zrobić dwie rzeczy, by obniżyć koszty AI. Po pierwsze, podziel informacje na mniejsze KB, z których każda dotyczy konkretnego produktu/funkcji/tematu. Po drugie, prowadź użytkownika przez workflow z wieloma pytaniami, by zawęzić wyszukiwanie do konkretnej KB; to nie tylko obniży koszty, ale też poprawi wyniki.

Wskazówka 4: Źródło danych KB – strona internetowa vs. wyszukiwanie w sieci

Jeśli korzystasz ze strony internetowej jako źródła danych KB, ale nie wprowadzasz na niej ciągłych zmian, które muszą być od razu widoczne w bocie, tańszą alternatywą jest użycie opcji Search The Web jako źródła danych KB zamiast Website KB. Przed zmianą upewnij się, że wydajność na spodziewanych pytaniach nie pogorszy się po tej zmianie.

Wskazówka 5: Wyszukuj w tabelach za pomocą Find Records lub Execute Code

Jeśli masz tabelę z danymi do przeszukania, rozważ użycie karty Find Records zamiast umieszczania tabeli w KB. Osoby techniczne mogą jeszcze taniej przeszukiwać tabelę bezpośrednio z karty Execute Code i zapisać wynik w zmiennej workflow do późniejszego użycia.

Wskazówka 6: Kontroluj liczbę fragmentów (chunks)

Fragmenty to liczba części pobieranych z bazy wiedzy do wygenerowania odpowiedzi. Im więcej fragmentów, tym odpowiedź dokładniejsza – ale generowanie trwa dłużej i zużywa więcej tokenów AI. Eksperymentuj z wielkością fragmentów, by znaleźć najmniejszą liczbę, która nadal daje trafne odpowiedzi.

Używaj karty Execute Code, by obniżyć koszty AI

Karta Execute Code może być tańszym zamiennikiem niektórych kart AI. Oto kilka scenariuszy, w których warto ją rozważyć:

Sprytniejsze alternatywy dla wiadomości

Jeśli chcesz, by bot za każdym razem odpowiadał inaczej na to samo zapytanie, musisz wyłączyć buforowanie (zobacz Dodatek, jak to zrobić). W niektórych przypadkach wyższy koszt AI jest uzasadniony lepszym doświadczeniem rozmowy. Ale nie zawsze.

Przykład: proste powitanie generowane przez LLM. Każde powitanie to dodatkowy koszt AI. Czy warto? Raczej nie. Na szczęście jest tańsze rozwiązanie: użyj tablicy z wieloma odpowiedziami i prostej funkcji, która losowo wybierze jedną z nich.

W zależności od liczby rozmów, oszczędności z tego rozwiązania mogą być naprawdę znaczące.

Więcej szczegółów o implementacji alternatywnych wiadomości znajdziesz tutaj.

Wykonywanie kodu dla prostych zadań

Do prostych zadań, takich jak formatowanie danych czy wyciąganie informacji ze strukturalnych danych, karta Execute Code jest często wydajniejsza, tańsza i szybsza niż korzystanie z LLM.

Alternatywy dla Summary Agent

Możesz użyć kart Execute Code, by stworzyć własny transkrypt. Umieść kartę Execute Code tam, gdzie chcesz śledzić wiadomości użytkownika i bota w zmiennej tablicowej. Potem możesz użyć tej tablicy jako kontekstu dla KB.

Uprość, gdy to możliwe

Wybieraj prostsze metody interakcji, które osiągają ten sam cel bez pogorszenia doświadczenia użytkownika. Na przykład, jeśli chcesz zebrać opinię użytkownika, prosty system ocen gwiazdkowych z komentarzem będzie tańszy niż użycie AI do zebrania tych samych informacji.

Wskazówki dla AI Tasks, AI Generate Text i tłumaczeń

Wybierz odpowiedni model AI

Tak, wybór odpowiedniego modelu AI jest tak ważny, że warto o nim wspomnieć dwa razy. Podobnie jak w przypadku KB, wybór modelu AI ma duży wpływ na koszty AI Tasks. Wybierz GPT-3.5 Turbo do mniej złożonych instrukcji. Przed rozważeniem przejścia na bardziej zaawansowane wersje, dokładnie przetestuj konfigurację z tym modelem. Pamiętaj, że GPT-4 Turbo kosztuje 20 razy więcej niż GPT-3.5 Turbo. Jeśli wyniki nie są znacznie lepsze, pozostań przy GPT-3.5 Turbo.

Dodatkowo możesz oszczędzać na kosztach AI, zmniejszając liczbę tokenów zużywanych podczas każdego uruchomienia AI Task.

Zalecam świadomie zmniejszać tę liczbę, bo każde przekroczenie limitu tokenów spowoduje ich obcięcie. Na przykład, jeśli ustawisz limit na 2000 tokenów, a Twój prompt plus odpowiedź przekroczy tę wartość, wejście zostanie odpowiednio skrócone.

AI Task vs AI Generate Text

Do prostych odpowiedzi tekstowych karta AI Generate Text zużywa mniej tokenów i jest łatwiejsza w konfiguracji niż AI Task. Do zadań wymagających analizy informacji karta AI Task sprawdza się lepiej niż AI Generate Text.

Dlatego zalecam używać karty AI Task, gdy chcesz, by AI przetwarzała informacje (np. wykrywała intencje użytkownika lub analizowała dane wejściowe). Jeśli chcesz, by AI generowała tekst, użyj karty AI Generate Text (np. by rozwinąć odpowiedź z KB lub kreatywnie wygenerować pytanie).

Aby dokładniej poznać różnice między kartami AI Task i AI Generate Text, dowiedz się więcej tutaj.

Tłumaczenia

Jeśli Twój bot będzie obsługiwał dużą liczbę rozmów wielojęzycznych, rozważ integrację hooków z zewnętrznymi usługami tłumaczeń jako tańszą opcję.

Więcej informacji o hookach znajdziesz tutaj.

Zakończenie

Dzięki tym strategiom i wskazówkom zoptymalizujesz koszty AI w Botpress. Zrozumienie kosztów różnych zadań i wybór najefektywniejszych metod pozwoli ograniczyć wydatki na AI bez utraty wydajności.

Nasz zespół jest gotowy, aby pomóc Ci poruszać się po tych opcjach i zapewnić, że Twój bot dostarczy użytkownikom jak najlepsze doświadczenie przy najefektywniejszych kosztach. Odwiedź naszą stronę z cennikiem, aby uzyskać więcej informacji lub odwiedź nasz serwer Discord, jeśli potrzebujesz pomocy.

Aneks

Jak zapobiegać buforowaniu

Jeśli chcesz uniknąć buforowania i zawsze otrzymywać aktualne wyniki, możesz skorzystać z jednej z poniższych opcji:

- Aby trwale zapobiec buforowaniu: dodaj `And discard:{{Date.now()}}` do wszystkich kart związanych ze sztuczną inteligencją (np. w promptach zadań AI, w kontekście bazy wiedzy itp.).

- Aby tymczasowo zapobiec buforowaniu: opublikuj swojego bota i przetestuj go w oknie incognito.

Polecane kursy

- Inżynieria promptów ChatGPT dla programistów (mimo że tytuł sugeruje, że to dla programistów, osoby nietechniczne również skorzystają!)

- Budowanie systemów z API ChatGPT

.webp)