- 2025年8月7日にリリースされたGPT-5は、高度な推論、マルチモーダル入力、タスク実行を1つのシステムに統合し、専門モデルを切り替える必要をなくしました。

- GPT-5は複雑で多段階のワークフロー向けに設計されています。

- GPT-5は従来バージョンと比べて幻覚(誤情報)の発生を大幅に減らしています。

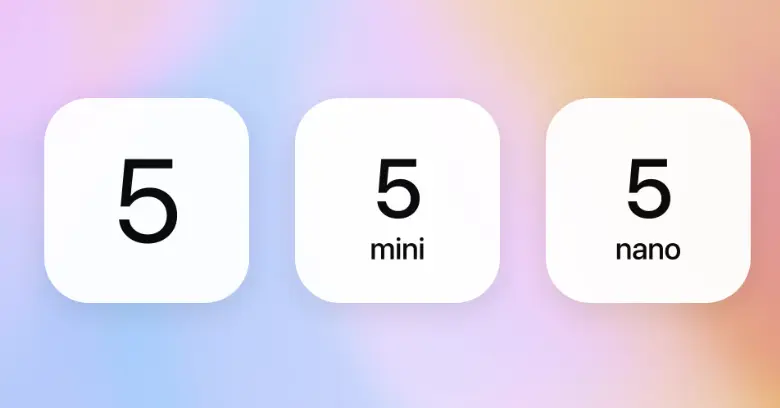

- GPT-5には、

gpt-5、gpt-5-mini、gpt-5-nano、gpt-5-chatのバリエーションがあります。

この1年でOpenAIはGPT-4o、o1、o3を発表し、それぞれAIの思考、推論、対話の質を向上させてきました。

これらのモデルはAIの応答をより速く、正確に、直感的にしましたが、いずれもより大きな進化への一歩に過ぎませんでした。

8月6日、OpenAIはGPT-5の近日公開を控え、控えめでない形で発表しました。

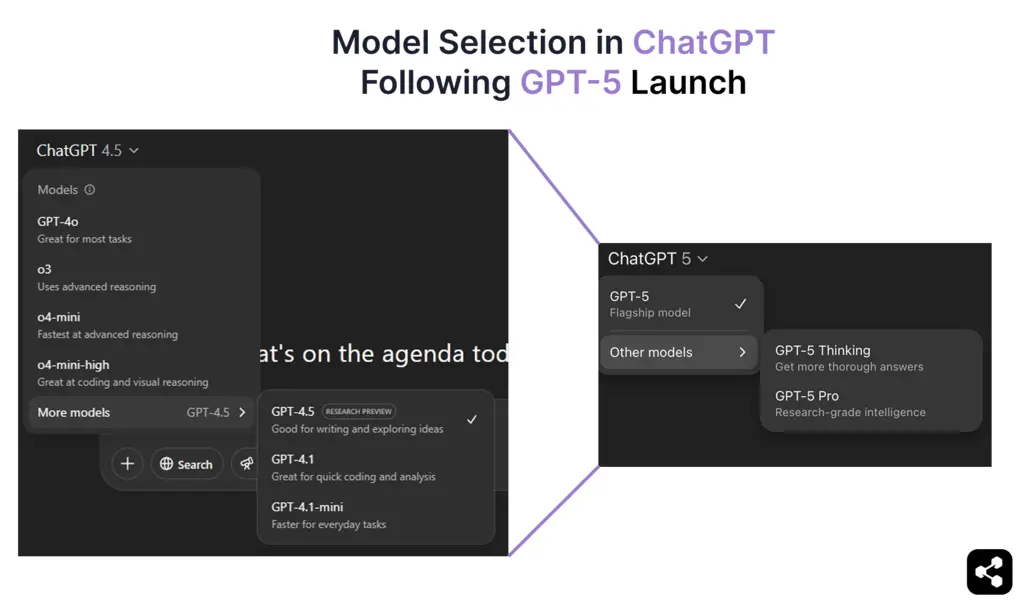

そして2025年8月7日、GPT-5が正式に登場。OpenAIの最先端の推論力とマルチモーダル機能を1つの統合モデルにまとめました。GPT-5はChatGPTの全ユーザー(無料・有料)でデフォルトモデルとなり、GPT-4oは完全に置き換えられました。

このガイドでは、GPT-5の機能、性能向上、学習プロセス、リリース時期、コストなど、確認されている情報をすべて解説します。

GPT-5とは?

GPT-5はOpenAIの最新世代の大規模言語モデルで、2025年8月7日に正式リリースされました。GPTアーキテクチャを基盤に、o1やo3のような推論重視モデルの進化も統合しています。

GPT-5以前、OpenAIはGPT-4.5(Orion)をChatGPTに導入。推論精度の向上、幻覚の減少、そしてGPT-5で標準となった深い思考プロセスの土台を築きました。

過去に示唆されていた段階的な論理処理、より良い文脈保持、スムーズなマルチモーダル切り替えなどの機能が、GPT-5で完全に実現・統合されています。

GPT-5は統合された適応型システムの一部として動作します。新しいリアルタイムルーターが、日常的な問い合わせには高速モデル、複雑な推論には“思考型”モデルを自動選択し、専門モデルの手動切り替えを不要にします。

GPT-5にはどんなモデルがある?

GPT-5は用途ごとに最適化されたバリエーションを持つモデル群で、ChatGPTの応用からAPIによる大規模展開まで幅広く対応します。

各GPT-5バリエーションは同じ統合アーキテクチャ上で動作しつつ、知識カットオフ、推論の深さ、速度、運用規模のバランスに合わせて調整されています。

これらのバリエーションはOpenAIの推論重視の方向性と性能チューニングを統合し、開発者がワークロードや展開規模に応じて最適なモデルを選べる柔軟性を提供します。

GPT-5の性能は?

2025年8月7日に正式リリースされたGPT-5は、推論・マルチモーダル・エージェント型タスク実行の実環境での動作が明らかになっています。

サム・アルトマンは以前、GPT-5は「より良いチャットボット」を超える存在になると示唆していましたが、初期の利用状況からもその通りの成果が見られます。

リアルタイムで適応する推論力

内蔵のルーティングシステムが即答すべきか、段階的に考えるべきかを判断します。複雑な質問には、GPT-5がチェーン・オブ・ソート処理とプロンプトチェーンを組み合わせ、中間ステップを整理してから最終回答を出します。

これにより、GPT-5を使ったチャットボットは、複数段階のコードデバッグや多層的なビジネス分析など、持続的な問題解決が得意になり、モデルやモードの切り替えも不要です。

大規模なコンテキスト処理

ChatGPTでは約256,000トークン、API経由では最大400,000トークンを記憶可能。これにより、書籍全体や数時間分の会議記録、大規模リポジトリも初期情報を失わずに扱えます。

長時間のセッションでもChatGPTの応答精度が大きく向上し、矛盾が減り、以前の文脈保持も強化されています。

グローバル市場向けの言語対応強化

GPT-5の統合アーキテクチャにより、多言語・音声対応が大幅に進化。ChatGPTはより多くの言語を高精度に翻訳し、長い会話でも文脈を失いにくくなりました。

この進化は音声対話にも及びます。さまざまなアクセントや話し方にも自然に応答でき、スペイン語、ヒンディー語、日本語、アラビア語など多言語の音声チャットボットもテキスト同様に滑らかです。

チャットボットからAIエージェントへ

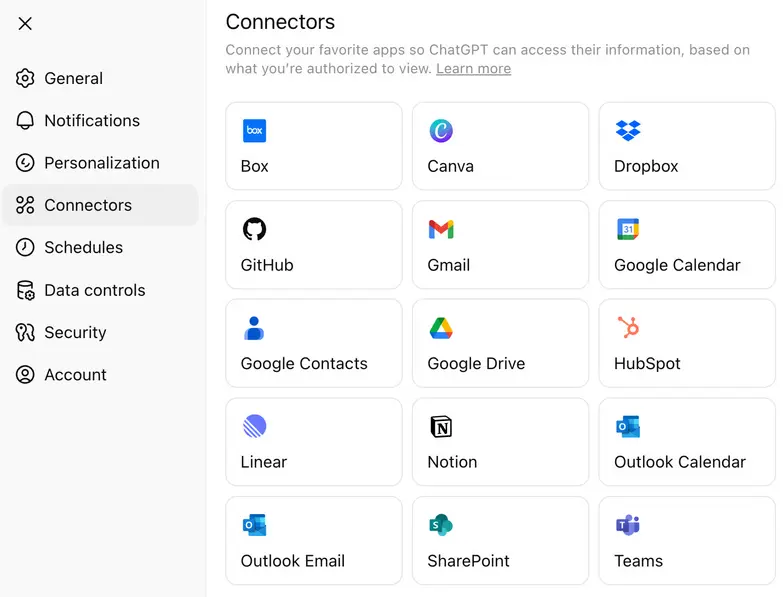

GPT-5では、外部ツールやCRM、データベース、業務アプリと直接連携できるアプリケーションコネクタ(ネイティブ統合)のアプローチが拡大されました。

高コストな推論呼び出しを毎回使うのではなく、軽量なコネクタにタスクを振り分けることで、複雑なロジックを必要な時だけ維持しつつAPIコストを抑えられます。

GPT-5の価格は?

GPT-5はChatGPTのサブスクリプションおよびOpenAI API経由で利用可能で、バリエーションごとに価格が異なります。API利用者向けにはgpt-5、gpt-5-mini、gpt-5-nanoが用意され、入力・出力トークン100万あたりで課金されます。

API価格とは別に、OpenAIはGPT-5が複数のChatGPTプランで利用可能であることを発表。無料ユーザーも使える一方、有料プランでは高度な機能が解放されます:

- 無料プラン – 標準的な推論機能と1日の利用制限付きでGPT-5を利用可能。

- Plusプラン – 利用上限が増え、推論性能も向上。

- Proプラン – GPT-5 Pro(高推論・“思考型”バリアント)にアクセスでき、拡張コンテキストウィンドウ、高速ルーティング、先進ツールの優先利用が可能。

OpenAIの価格体系により、開発者は用途に応じて最大推論深度、低遅延、コスト効率を選択できます。

GPT-5へのアクセス方法(やりたいことによって異なります)

GPT-5とチャットしたいだけなら、8月7日からChatGPTで直接利用できます。プランに応じて最適なバリアント(ProプランならGPT-5 Thinkingなど)が自動選択されます。設定不要で、アプリを開いて入力するだけです。

一方、自分のプロダクトやワークフローでGPT-5を使いたい場合はAPIアクセスが必要です。OpenAI APIへの主なアクセス方法は2つあります:

- OpenAI Platform – platform.openai.comでgpt-5、gpt-5-mini、gpt-5-nano、gpt-5-chatから用途に合わせて選択可能。コードからGPT-5にリクエストを送る最速の方法です。

- OpenAIのPython SDK(GitHub) – ローカル開発やスクリプト用途なら、公式のOpenAI Pythonクライアントをインストール。APIキーで各GPT-5バリアントにPython関数から簡単にアクセスできます。

モデルの挙動を試したいだけなら、GitHub Models Playgroundも利用可能。アプリを作らずプロンプトテストができます。

GPT-5でAIエージェントを構築する方法

GPT-5があなたのユースケースに合っているかを知る最良の方法は、実際に使ってみることです。実際の入力や複数ステップの推論、ライブ展開フローでどのように動作するかを確認しましょう。

この例ではBotpressを使います。Botpressは、GPT-5を手間なく連携できるAIエージェントのビジュアルビルダーです。

ステップ1:エージェントの役割を明確にする

エージェントの役割を具体的に定義しましょう。GPT-5は複雑なタスクの推論も可能ですが、明確な目的があると最良の結果が得られます。

まずは「製品に関する質問に答える」「ユーザーの予約を手伝う」「法的文書を要約する」など、1つの明確な機能から始めて、徐々に拡張しましょう。最初から複雑に作り込む必要はありません。

ステップ2:エージェントを作成し、指示を与える

Botpress Studio内で新しいボットプロジェクトを作成します。

で、GPT-5にその役割を正確に指示してください。

.webp)

例:「あなたはローンアドバイザーボットです。ユーザーがさまざまなローンの種類を理解できるようにし、入力内容に基づいて適格性を計算し、申請ページへの案内をしてください。」

GPT-5は詳細なタスク設定を理解できます。指示が具体的であるほど、より良いパフォーマンスを発揮します。

ステップ3:エージェントに業務内容を与える

ドキュメントをアップロードしたり、重要な内容を貼り付けたり、ナレッジベースにライブページをリンクしましょう。これがGPT-5が質問に答えたり判断したりする際の参照情報となります。

含めると良いコンテンツ例:

- 価格の内訳

- 製品やサービスの概要

- 主要ページ(デモ、トライアル、問い合わせフォームなど)

- 社内プロセス文書(社内エージェントの場合)

GPT-5は長文ドキュメントにも対応できるので、短くまとめる必要はありません。ただし、関連性と構造を意識しましょう。

ステップ4:LLMとしてGPT-5を選択する

.webp)

エージェントがGPT-5を使うようにするには、Botpress Studioの左サイドバーからBot Settingsに進みます。

- Bot Settingsをクリック

- LLM Providerセクションまでスクロール

- 以下の中から モデル、GPT-5のいずれかのバリアントを選択します:

gpt-5による本格的な推論や複数ステップのロジックgpt-5-miniで、より高速かつ軽量なやり取りを実現pt-5-nano:超低遅延タスク向け

モデルを選択すると、すべてのInstructions、ナレッジベースの回答、推論動作がGPT-5で動作します。コストや遅延、出力品質に応じていつでもバリアントを切り替えられます。

ステップ5:WhatsApp、Slack、Webサイトなどのチャネルに展開

GPT-5エージェントが期待通りに動作したら、次のようなプラットフォームにすぐに展開できます:

BotpressのようなAIエージェントプラットフォームが連携を担当するため、ユーザーはGPT-5の力を活用し、あらゆるチャネルに素早く展開できます。

GPT-5はGPT-4oと比べて何が優れているのか?

GPT-5はGPT-4以来最大のアーキテクチャ変更ですが、前世代のGPT-4oと直接比較すると、その違いがより明確になります。

以下の表で、開発者やユーザーが実際に体感している変化に入る前に、測定可能な違いを整理します。

理論上、GPT-5はコンテキストウィンドウが大幅に拡大し、同じ出力長でもトークン数が少なくなります。マルチモーダル応答もテキスト・画像・音声間でより一貫性があります。

とはいえ、開発者やユーザーコミュニティでの実際の評価は、スペック表以上に複雑です。

GPT-5リリースへのユーザーの反応

GPT-5のリリースはOpenAI史上最も賛否が分かれたアップデートの一つです。ベンチマークの数値を超えて、コミュニティはモデルの高度な推論力に期待する層と、GPT-4oの良さを惜しむ層にすぐに分かれました。

「4.oは必要なときに親友のような存在だった。今はもういなくなってしまって、誰かが亡くなったみたいな気分。」

— GPT-4oの突然の廃止に対する感情的な喪失感を表現したRedditユーザー。参考: Verge

技術面では:

「GPT-5の高度な性能は否定できないが、モデル選択肢がなくなったことで、多くの開発者が頼りにしていたシンプルなコントロールが失われた。」

— 柔軟性の喪失に関する広範な意見を要約したコメント。

参考: Tom's Guide

このような賛否両論の反応に対し、OpenAIチームはモデル選択や旧モデルの復活、利用制限の緩和などの新しいアップデートをSam AltmanがXで随時発信しています。

GPT-5はどのように訓練されたのか?

OpenAIはGPT-4.5の訓練方法について情報を公開しており、これがGPT-5の開発手法の手がかりとなります。GPT-4.5はGPT-4oを基盤に、事前学習を拡大しつつ汎用モデルとして設計されました。

訓練手法

従来モデルと同様、GPT-5も以下の手法を組み合わせて訓練されると考えられます:

- 教師ありファインチューニング(SFT)— 人手でラベル付けされたデータセットから学習

- 人間のフィードバックによる強化学習(RLHF)— 繰り返しのフィードバックループで応答を最適化

- 新しい監督技術 — o3の推論強化を発展させた手法の導入が予想されます。

これらの手法はGPT-4.5の整合性や意思決定の向上に重要であり、GPT-5ではさらに進化する見込みです。

GPT-5自体はOpenAIが大規模な教師あり学習と強化学習で訓練しましたが、現在は外部サービスを利用して独自データでGPTモデルを訓練し、特定分野向けにカスタマイズすることも可能です。

ハードウェアと計算能力

GPT-5の訓練はMicrosoftのAIインフラとNVIDIAの最新GPUによって支えられています。

- 2024年4月、OpenAIはNVIDIA H200 GPUの初回ロットを受領し、H100からの大きなアップグレードとなりました。

- NVIDIAのB100やB200 GPUは2025年まで本格稼働しないため、OpenAIは既存ハードウェアでの最適化を続けている可能性があります。

MicrosoftのAIスーパーコンピューティングクラスターもGPT-5の訓練に活用されています。詳細は限られていますが、OpenAIの次期モデルがMicrosoftの最新AIインフラ上で稼働していることは確認されています。

GPT-5リリース日

数か月にわたる憶測の末、OpenAIは2025年8月6日にGPT-5の正式リリースを発表し、X(旧Twitter)にて謎めいたティーザーを投稿しました:

ライブ配信タイトルの「5」が唯一の確証となり、GPT-5の登場が示されました。その24時間後、8月7日午前10時(PT)にOpenAIはChatGPT、API、GitHub Models PlaygroundでGPT-5の展開を開始しました。

このタイミングは、2025年2月にSam Altmanが「数か月以内にGPT-5が登場する」と発言したことや、GPT-4oイベントでMira Muratiが「18か月以内に博士号レベルの知能が現れる」と予測したこととも一致します。

GPT-5は現在稼働中で一般公開されており、OpenAIの最新「フロンティアモデル」として、移行版とされたGPT-4.5 Orionを大きく上回る進化を遂げています。

OpenAI LLMでAIエージェントを構築

複雑さを気にせず、OpenAIモデルを活用したAIエージェントを手軽に構築しましょう。Slack用チャットボット、Notion用スマートアシスタント、WhatsApp用カスタマーサポートボットなど、数クリックで簡単に展開できます。

柔軟な連携、自律的な推論、簡単なデプロイにより、Botpressは生産性とエンゲージメントを本当に高めるAIエージェントの構築を可能にします。

今すぐ始めましょう — 無料です。

よくある質問

1. GPT-5は私のデータを保存したり、学習に利用したりしますか?

いいえ、GPT-5はデフォルトであなたのデータを保存したり学習に利用したりしません。OpenAIは、ChatGPT(GPT-5を含む)のデータは明示的にオプトインしない限り学習に使われず、APIやエンタープライズ利用のデータも自動的に学習対象外であると明言しています。

2. OpenAIはGPT-5の安全性やセキュリティのためにどのような対策を講じていますか?

GPT-5がユーザーにとって安全で安心なものとなるよう、OpenAIは人間のフィードバックによる強化学習(RLHF)、敵対的テスト、ファインチューニングなどの手法を用いて有害な出力を減らしています。また、モデルの制限事項を公開する「システムカード」をリリースし、不正利用を検知するためのリアルタイム監視も導入しています。

3. GPT-5は、プログラミング経験がなくても自律型エージェントの構築に使えますか?

はい、GPT-5はBotpressやLangflowのようなノーコードプラットフォームを利用することで、プログラミング経験がなくても自律型エージェントの構築に活用できます。これらのツールでは、ワークフローの設計やAPIの接続、ロジックの追加をドラッグ&ドロップのインターフェースで行うことができ、内部でGPT-5が動作しています。

4. GPT-5はカスタマーサポート、教育、法律などの従来の仕事にどのような影響を与えますか?

GPT-5は、よくある質問への回答や採点、法的文書の要約などの反復作業を自動化するため、カスタマーサポート、教育、法律分野の初級職の需要が減少する可能性があります。一方で、AIの監督やワークフロー設計、戦略的アドバイザーなど新たな役割が生まれることも期待されています。

5. GPT-5は多言語対応ですか?さまざまな言語での性能はどうですか?

はい、GPT-5は多言語対応であり、非英語言語においてもGPT-4より性能が向上すると期待されています。英語で最も高いパフォーマンスを発揮しますが、主要な言語であれば高い流暢さで対応でき、リソースの少ない言語や特殊な言語では若干品質に差が出る場合があります。

.webp)

.webp)