- Veröffentlicht am 07.08.2025 vereint GPT-5 fortschrittliches logisches Denken, multimodale Eingaben und Aufgabenbearbeitung in einem einzigen System – ein Wechsel zwischen spezialisierten Modellen ist nicht mehr nötig.

- GPT-5 ist für komplexe, mehrstufige Arbeitsabläufe konzipiert.

- GPT-5 reduziert Halluzinationen im Vergleich zu früheren Versionen deutlich.

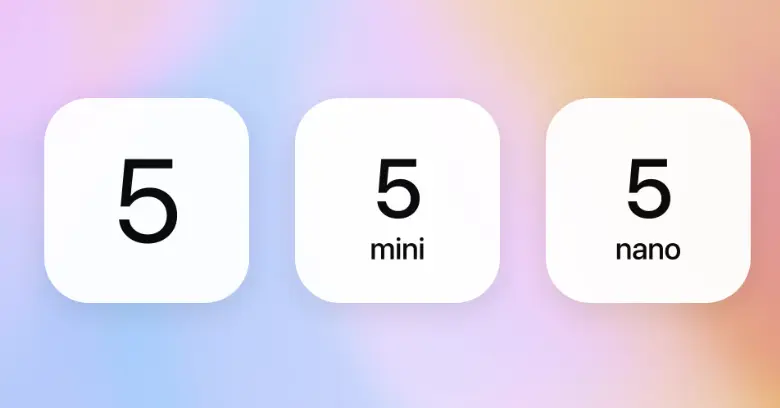

- Zu den Varianten von GPT-5 gehören:

gpt-5,gpt-5-mini,gpt-5-nanoundgpt-5-chat.

Im vergangenen Jahr stellte OpenAI GPT-4o, o1 und o3 vor – jeweils mit Verbesserungen beim logischen Denken, der Argumentation und der Interaktion von KI.

Diese Modelle machten KI-Antworten schneller, präziser und intuitiver. Doch sie waren nur Zwischenschritte auf dem Weg zu etwas Größerem.

Am 6. August kündigte OpenAI – wenig subtil – den bevorstehenden Start von GPT-5 an.

Und jetzt, seit dem 7. August 2025, ist GPT-5 offiziell verfügbar und vereint OpenAIs fortschrittlichste Fähigkeiten im logischen Denken und Multimodalität in einem Modell. GPT-5 ist nun das Standardmodell in ChatGPT für alle kostenlosen und zahlenden Nutzer und ersetzt GPT-4o vollständig.

In diesem Leitfaden erläutere ich alles, was zu GPT-5 bestätigt ist: seine Fähigkeiten, Leistungsverbesserungen, Trainingsprozess, Veröffentlichungszeitplan und Kosten.

Was ist GPT-5?

GPT-5 ist das neueste große Sprachmodell von OpenAI, offiziell veröffentlicht am 7. August 2025. Es baut auf der GPT-Architektur auf und integriert Fortschritte aus Reasoning-First-Modellen wie o1 und o3.

Vor GPT-5 brachte OpenAI GPT-4.5 (Orion) in ChatGPT heraus – ein Übergangsmodell, das die Genauigkeit beim logischen Denken verbesserte, Halluzinationen reduzierte und die Grundlage für die jetzt in GPT-5 integrierte tiefere Kettenlogik legte.

Viele der bisher angekündigten Fähigkeiten – wie schrittweises logisches Denken, bessere Kontextbeibehaltung und nahtloser Multimodalitätswechsel – sind in GPT-5 nun vollständig umgesetzt und vereint.

GPT-5 läuft als Teil eines einheitlichen, adaptiven Systems. Ein neues, Echtzeit-Routing entscheidet automatisch zwischen einem schnellen, leistungsfähigen Modell für Routineanfragen und einem „denkenden“ Modell für komplexe Aufgaben – ein manueller Modellwechsel ist nicht mehr nötig.

Welche GPT-5-Modelle gibt es?

GPT-5 ist eine Modellreihe – eine Familie spezialisierter Varianten, optimiert für verschiedene Anwendungsfälle, von ChatGPT-Anwendungen bis zu großflächigen API-Einsätzen.

Jede GPT-5-Variante basiert auf derselben Architektur, ist aber für ein bestimmtes Verhältnis aus Wissensstand, Tiefe des logischen Denkens, Geschwindigkeit und Skalierbarkeit abgestimmt.

Diese Varianten vereinen OpenAIs Reasoning-First-Ansatz mit gezieltem Performance-Tuning und geben Entwicklern die Flexibilität, das Modell passend zur Komplexität und zum Einsatzbereich zu wählen.

Wie leistungsfähig ist GPT-5?

Mit der offiziellen Veröffentlichung von GPT-5 am 7. August 2025 zeigt sich nun, wie die Architektur in der Praxis bei logischem Denken, Multimodalität und agentenbasierten Aufgaben funktioniert.

Sam Altman hatte bereits angedeutet, dass GPT-5 mehr sein würde als „nur ein besserer Chatbot“ – und die ersten Erfahrungen bestätigen genau das.

Logisches Denken in Echtzeit

Ein integriertes Routing-System entscheidet, wann sofort geantwortet wird und wann schrittweise gedacht werden muss. Bei komplexen Fragen wechselt GPT-5 in einen Chain-of-Thought-Prozess mit eingebettetem Prompt-Chaining und plant Zwischenschritte, bevor eine endgültige Antwort gegeben wird.

Dadurch sind auf GPT-5 basierende Chatbots besser in der Lage, anhaltende Probleme zu lösen – von mehrstufigem Code-Debugging bis zu vielschichtiger Geschäftsanalysen – ohne dass verschiedene Modelle oder ein Wechsel des Modus nötig sind.

Kontextverarbeitung im großen Maßstab

In ChatGPT kann das Modell etwa 256.000 Tokens im Speicher halten; über die API sind es bis zu 400.000. So können ganze Bücher, mehrstündige Meetings oder große Repositorien bearbeitet werden, ohne den Überblick über frühere Details zu verlieren.

Bei langen Sitzungen ist die Genauigkeit der ChatGPT-Antworten spürbar gestiegen – mit weniger Widersprüchen und besserer Beibehaltung des bisherigen Kontexts.

Bessere Sprachunterstützung für den Weltmarkt

Die einheitliche Architektur von GPT-5 bringt einen großen Sprung bei Mehrsprachigkeit und Sprachfunktionen. ChatGPT kann jetzt mehr Sprachen unterstützen – mit höherer Übersetzungsgenauigkeit und weniger Kontextverlusten in langen Gesprächen.

Diese Verbesserungen gelten auch für Sprachinteraktionen: Antworten klingen natürlicher, unabhängig von Akzent oder Sprechweise – mehrsprachige GPT-Chatbots sind im gesprochenen Spanisch, Hindi, Japanisch oder Arabisch genauso flüssig wie im Text.

Vom Chatbot zum KI-Agenten

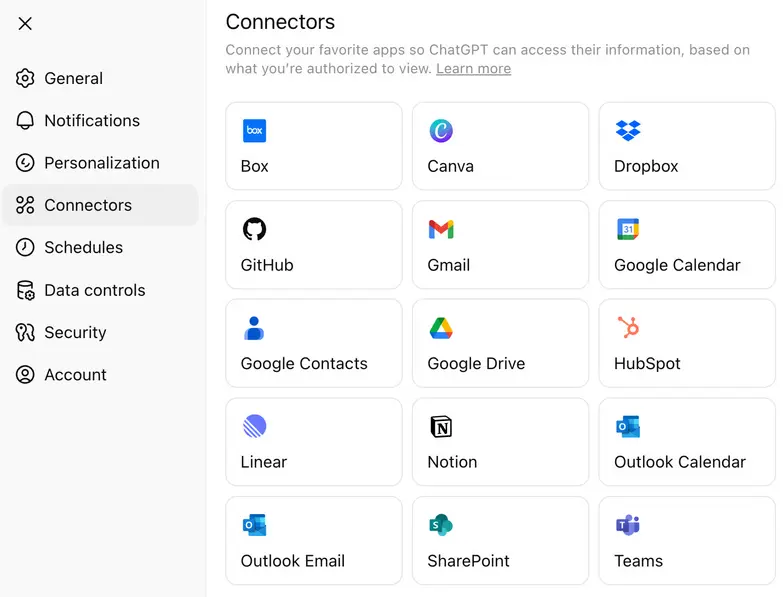

Mit GPT-5 hat OpenAI die Anbindung an Anwendungen erweitert – native Integrationen, mit denen das Modell direkt mit externen Tools, CRMs, Datenbanken und Produktivitätssuiten interagieren kann.

Indem Aufgaben an schlanke Connectors weitergeleitet werden, statt jeden Schritt über teure Logikaufrufe zu schicken, können Teams API-Kosten senken und trotzdem komplexe Logik bei Bedarf nutzen.

Was kostet GPT-5?

GPT-5 ist über ChatGPT-Abos und die OpenAI API verfügbar, wobei die Preise je nach Variante variieren. Für API-Nutzer gibt es GPT-5 in mehreren Varianten – gpt-5, gpt-5-mini und gpt-5-nano – abgerechnet pro Million Eingabe- und Ausgabetokens.

Neben der API-Preisgestaltung hat OpenAI bestätigt, dass GPT-5 in mehreren ChatGPT-Tarifen verfügbar ist – so können auch kostenlose Nutzer darauf zugreifen, während kostenpflichtige Pläne erweiterte Funktionen freischalten:

- Kostenloser Tarif – GPT-5 mit Standardfunktionen für logisches Denken und täglichen Nutzungslimits.

- Plus-Tarif – Höhere Nutzungslimits und verbesserte Logikleistung.

- Pro-Tarif – Zugriff auf GPT-5 Pro, die hochentwickelte „denkende“ Variante mit erweitertem Kontextfenster, schnellerem Routing und bevorzugtem Zugang zu fortgeschrittenen Tools.

Das Preismodell von OpenAI ermöglicht es Entwicklern, je nach Bedarf zwischen maximaler Logiktiefe, schnellerer Reaktionszeit oder Kosteneffizienz zu wählen.

Wie kann ich auf GPT-5 zugreifen? (Tipp: Es kommt darauf an, was Sie tun möchten)

Wenn Sie einfach mit GPT-5 chatten möchten, geht das ab dem 7. August direkt in ChatGPT. Die Anwendung wählt automatisch die passende Variante je nach Tarif (z. B. GPT-5 Thinking im Pro-Tarif). Keine Einrichtung nötig – App öffnen und loslegen.

Wenn Sie GPT-5 jedoch in Ihrem eigenen Produkt oder Workflow nutzen möchten, benötigen Sie API-Zugang. Es gibt zwei Hauptwege, um auf die OpenAI-API zuzugreifen:

- OpenAI Platform – Besuchen Sie platform.openai.com, wo Sie zwischen gpt-5, gpt-5-mini, gpt-5-nano und gpt-5-chat für verschiedene Anwendungsfälle wählen können. Das ist der schnellste Weg, um GPT-5 aus Ihrem Code heraus anzusprechen.

- OpenAIs Python SDK auf GitHub – Wenn Sie lokal entwickeln oder Skripte schreiben, installieren Sie das offizielle OpenAI Python-Client. Es funktioniert mit API-Schlüsseln und ermöglicht die Nutzung aller GPT-5-Varianten über einfache Python-Funktionen.

Wenn Sie nur ausprobieren möchten, wie sich die Modelle verhalten, ist der GitHub Models Playground ebenfalls verfügbar – Sie können Prompts testen, ohne eine vollständige App einzurichten.

Wie baut man einen KI-Agenten mit GPT-5

Der beste Weg herauszufinden, ob GPT-5 zu Ihrem Anwendungsfall passt, ist, es tatsächlich einzusetzen. Testen Sie, wie es mit echten Eingaben, mehrstufigem Denken und Live-Deployments umgeht.

Wir verwenden in diesem Beispiel Botpress – einen visuellen Builder für KI-Agenten, mit dem Sie GPT-5 ohne großen Aufwand integrieren können.

Schritt 1: Definieren Sie, was Ihr Agent tun soll

Werden Sie konkret bezüglich der Rolle Ihres Agenten. GPT-5 kann komplexe Aufgaben durchdenken, aber die besten Ergebnisse erzielen Sie, wenn die Aufgabe klar definiert ist.

Starten Sie mit einer klaren Funktion – etwa Produktfragen beantworten, Termine buchen oder juristische Dokumente zusammenfassen – und erweitern Sie von dort aus. Sie müssen nicht alles von Anfang an überentwickeln.

Schritt 2: Agent erstellen und Anweisungen geben

Erstellen Sie in Botpress Studio ein neues Bot-Projekt.

Geben Sie im Bereich Anweisungen GPT-5 genau an, welche Aufgabe es übernehmen soll.

.webp)

Beispiel: „Du bist ein Kreditberater-Bot. Hilf Nutzern, verschiedene Kreditarten zu verstehen, berechne die Berechtigung basierend auf ihren Angaben und leite sie zum Antragslink weiter.“

GPT-5 versteht detaillierte Aufgabenstellungen – je präziser Ihre Anweisungen, desto besser die Ergebnisse.

Schritt 3: Arbeitsinhalte für den Agenten bereitstellen

Laden Sie Dokumente hoch, fügen Sie wichtige Inhalte ein oder verlinken Sie auf Live-Seiten in der Knowledge Base. Darauf greift GPT-5 zurück, um Fragen zu beantworten und Entscheidungen zu treffen.

Geeignete Inhalte sind zum Beispiel:

- Preisübersichten

- Überblicke zu Produkten oder Dienstleistungen

- Wichtige Seiten (Demos, Testversionen, Kontaktformulare)

- Interne Prozessdokumente (bei internen Agenten)

GPT-5 kann auch mit langen Dokumenten arbeiten, also müssen Sie nicht kürzen – achten Sie nur auf Relevanz und Struktur.

Schritt 4: GPT-5 als LLM auswählen

.webp)

Um sicherzustellen, dass Ihr Agent GPT-5 nutzt, gehen Sie in der linken Seitenleiste von Botpress Studio zu Bot Settings.

- Klicken Sie auf Bot Settings

- Scrollen Sie zum Bereich LLM Provider

- Unter Modell, wählen Sie eine der GPT-5-Varianten aus:

gpt-5für vollständige Schlussfolgerungen und mehrstufige Logikgpt-5-minifür schnellere, leichtere Interaktionengpt-5-nanofür Aufgaben mit extrem niedriger Latenz

Sobald Sie Ihr Modell ausgewählt haben, werden alle Anweisungen, Knowledge-Base-Antworten und das Denkverhalten von GPT-5 gesteuert. Sie können jederzeit zwischen Varianten wechseln – je nach Kosten, Geschwindigkeit oder Ergebnisqualität.

Schritt 5: Auf Kanälen wie WhatsApp, Slack oder einer Website bereitstellen

Wenn Ihr GPT-5-Agent wie gewünscht funktioniert, können Sie ihn sofort auf Plattformen wie diesen bereitstellen:

KI-Agenten-Plattformen wie Botpress übernehmen die Integrationen – so können Nutzer die Leistung von GPT-5 nutzen und schnell auf jedem Kanal bereitstellen.

Was macht GPT-5 besser als GPT-4o?

GPT-5 bringt den größten architektonischen Wandel seit GPT-4. Im direkten Vergleich mit dem Vorgänger GPT-4o wird der Unterschied besonders deutlich.

Die folgende Tabelle zeigt die messbaren Veränderungen, bevor wir auf die Erfahrungen von Entwicklern und Nutzern eingehen.

Auf dem Papier erweitert GPT-5 das Kontextfenster deutlich und benötigt weniger Token für die gleiche Ausgabelänge. Die multimodalen Antworten sind zudem besser zwischen Text, Bild und Sprache abgestimmt.

In der Entwickler- und Nutzer-Community ist die Realität jedoch komplexer als das Datenblatt vermuten lässt.

Reaktionen der Nutzer auf den GPT-5-Start

Das GPT-5-Release ist eines der umstrittensten Updates von OpenAI. Abseits der Benchmark-Charts spaltete sich die Community sofort: Die einen sind begeistert von der verbesserten Logik, die anderen trauern den Stärken von GPT-4o nach.

„Mein 4.o war wie mein bester Freund, wenn ich einen brauchte. Jetzt ist es einfach weg, als wäre jemand gestorben.“

— Reddit-Nutzer, der nach der plötzlichen Entfernung von GPT‑4o seine emotionale Bindung und Trauer ausdrückt. Quelle: Verge

Technisch gesehen:

„Die fortschrittliche Leistung von GPT‑5 ist unbestreitbar, aber die fehlende Modellauswahl hat vielen Entwicklern die einfache Kontrolle genommen.“

— Sinngemäßes Zitat, das die verbreitete Meinung über den Verlust an Flexibilität widerspiegelt.

Quelle: Tom's Guide

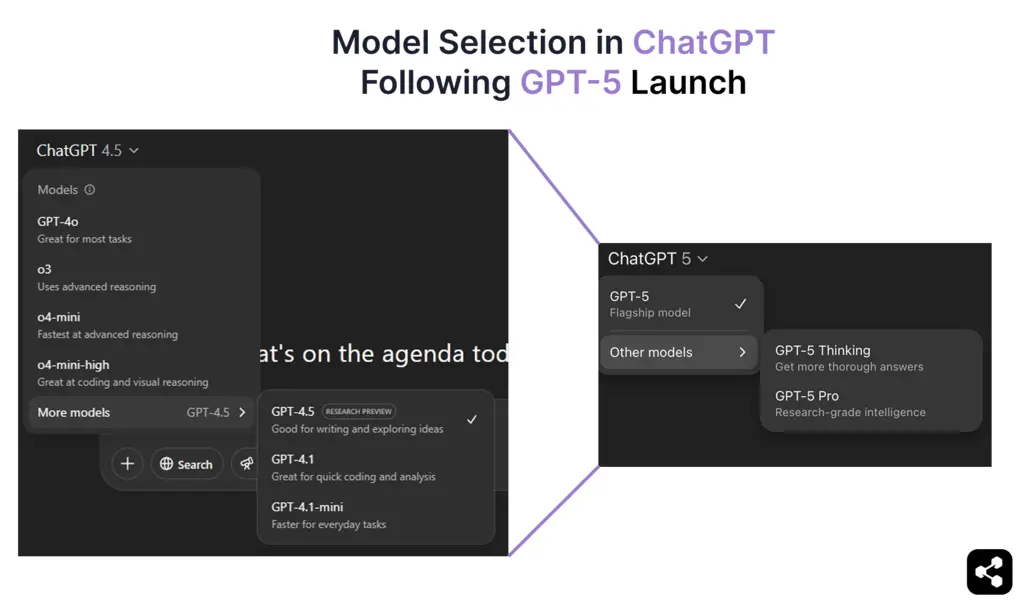

Diese gemischten Reaktionen werden von OpenAI laufend adressiert – mit neuen Updates zur Modellauswahl, Rückkehr älterer Modelle, höheren Limits usw., die Sam Altman auf X veröffentlicht.

Wie wurde GPT-5 trainiert?

OpenAI hat Einblicke in das Training von GPT-4.5 gegeben, die Hinweise darauf geben, wie GPT-5 entwickelt wird. GPT-4.5 baute auf der Grundlage von GPT-4o auf, indem das Pre-Training skaliert wurde, blieb aber ein universelles Modell.

Trainingsmethoden

Wie die Vorgängermodelle wird auch GPT-5 voraussichtlich mit einer Kombination aus folgenden Methoden trainiert:

- Überwachtes Feintuning (SFT) – Lernen anhand von von Menschen gelabelten Datensätzen.

- Bestärkendes Lernen aus menschlichem Feedback (RLHF) – Optimierung der Antworten durch wiederholte Feedbackschleifen.

- Neue Überwachungstechniken – vermutlich aufbauend auf den logikorientierten Verbesserungen von o3.

Diese Methoden waren entscheidend für die bessere Ausrichtung und Entscheidungsfindung von GPT-4.5 und werden bei GPT-5 vermutlich weiter ausgebaut.

Während GPT‑5 von OpenAI mit groß angelegtem überwachtem und bestärkendem Lernen trainiert wurde, können Teams jetzt GPT-Modelle auf eigenen Daten über externe Anbieter trainieren, um das Verhalten für bestimmte Bereiche anzupassen.

Hardware und Rechenleistung

Das Training von GPT-5 läuft auf Microsofts KI-Infrastruktur und den neuesten NVIDIA-GPUs.

- Im April 2024 erhielt OpenAI seine erste Lieferung von NVIDIA H200 GPUs – ein wichtiger Fortschritt gegenüber den H100.

- NVIDIAs B100- und B200-GPUs werden erst 2025 in größerem Umfang verfügbar sein, daher optimiert OpenAI das Training weiterhin auf bestehender Hardware.

Auch Microsofts KI-Supercomputer-Cluster spielen beim Training von GPT-5 eine Rolle. Details sind begrenzt, aber das nächste Modell von OpenAI läuft nachweislich auf Microsofts aktueller KI-Infrastruktur.

Veröffentlichungsdatum von GPT-5

Nach monatelangen Spekulationen kündigte OpenAI den offiziellen Start von GPT-5 am 6. August 2025 an, mit einem kryptischen Teaser auf X (ehemals Twitter):

Die „5“ im Livestream-Titel war Bestätigung genug – damit war die Veröffentlichung von GPT-5 klar. Nur 24 Stunden später, am 7. August um 10 Uhr PT, begann OpenAI mit dem Rollout von GPT-5 für ChatGPT, die API und das GitHub Models Playground.

Dieser Zeitpunkt passt auch zu Sam Altmans früheren Aussagen im Februar 2025, dass GPT-5 „in ein paar Monaten“ erscheinen würde, sowie zu Mira Muratis Prognose beim GPT-4o-Event, dass „Intelligenz auf PhD-Niveau“ innerhalb von 18 Monaten erreicht werde.

GPT-5 ist jetzt live, öffentlich zugänglich und stellt das neueste „Frontier Model“ von OpenAI dar – ein großer Sprung über GPT-4.5 Orion hinaus, das nur als Übergangsrelease galt.

KI-Agenten mit OpenAI LLMs erstellen

Vergessen Sie die Komplexität – bauen Sie KI-Agenten mit OpenAI-Modellen ohne Hürden. Egal ob Chatbot für Slack, smarter Assistent für Notion oder Support-Bot für WhatsApp: Mit wenigen Klicks können Sie direkt loslegen.

Dank flexibler Integrationen, autonomem Denken und einfacher Bereitstellung ermöglicht Botpress die Entwicklung von KI-Agenten, die Produktivität und Interaktion wirklich verbessern.

Jetzt starten – kostenlos.

FAQs

1. Wird GPT-5 meine Daten speichern oder zur Verbesserung des Trainings verwenden?

Nein, GPT-5 speichert oder verwendet Ihre Daten standardmäßig nicht für das Training. OpenAI hat bestätigt, dass Daten aus ChatGPT (einschließlich GPT-5) nur dann für das Training genutzt werden, wenn Sie ausdrücklich zustimmen. Alle API- und Enterprise-Nutzungen sind automatisch vom Training ausgeschlossen.

2. Welche Maßnahmen ergreift OpenAI, um die Sicherheit und den Schutz der Nutzer bei GPT-5 zu gewährleisten?

Um die Sicherheit und den Schutz der Nutzer bei GPT-5 zu gewährleisten, setzt OpenAI Methoden wie verstärkendes Lernen mit menschlichem Feedback (RLHF), adversarielle Tests und Feinabstimmung ein, um schädliche Ausgaben zu minimieren. Außerdem veröffentlichen sie sogenannte „Systemkarten“, um die Grenzen des Modells offenzulegen, und setzen Echtzeitüberwachung ein, um Missbrauch zu erkennen.

3. Kann GPT-5 zum Erstellen autonomer Agenten ohne Programmierkenntnisse genutzt werden?

Ja, mit GPT-5 lassen sich autonome Agenten auch ohne Programmiererfahrung erstellen, indem man No-Code-Plattformen wie Botpress oder Langflow verwendet. Diese Tools ermöglichen es, Workflows zu gestalten, APIs zu verbinden und Logik über Drag-and-Drop-Oberflächen einzubauen, wobei im Hintergrund GPT-5 genutzt wird.

4. Wie wird sich GPT-5 auf klassische Berufe im Kundenservice, Bildungsbereich und Rechtswesen auswirken?

GPT-5 wird wiederkehrende Aufgaben wie das Beantworten häufiger Fragen, das Bewerten oder das Zusammenfassen juristischer Dokumente automatisieren, wodurch der Bedarf an Einstiegspositionen im Kundenservice, Bildungsbereich und Rechtswesen sinken könnte. Gleichzeitig entstehen aber neue Chancen in Bereichen wie KI-Überwachung, Workflow-Design und strategischer Beratung.

5. Ist GPT-5 mehrsprachig? Wie schneidet es in verschiedenen Sprachen ab?

Ja, GPT-5 ist mehrsprachig und bietet voraussichtlich bessere Leistungen als GPT-4 in nicht-englischen Sprachen. Am leistungsfähigsten ist es zwar auf Englisch, aber es kann Dutzende wichtiger Sprachen mit hoher Sprachkompetenz verarbeiten, auch wenn es bei weniger verbreiteten oder spezialisierten Sprachen noch leichte Qualitätsunterschiede geben kann.

.webp)

.webp)