KI ist in aller Munde. Und es folgt immer die Frage: Wie sicher ist dieses neuartige KI-Tool eigentlich?

Wenn Sie einen Chatbot für ein Unternehmen einführen möchten, sollte die Sicherheit des Chatbots oberste Priorität haben.

In diesem Artikel führe ich Sie durch alle wichtigen Sicherheitsrisiken von Chatbots und zeige, welche Vorsichtsmaßnahmen Ihre Organisation beim Einsatz eines KI-Chatbots oder KI-Agenten treffen sollte.

Sind Chatbots sicher?

Nicht alle Chatbots sind sicher – man weiß nie, welche Sicherheitsvorkehrungen bei der Entwicklung getroffen wurden. Mit den richtigen Tools ist es jedoch möglich, einen sicheren Chatbot zu erstellen und bereitzustellen.

Chatbot-Sicherheit ist ein weitreichendes Thema, da es viele Möglichkeiten gibt, Chatbots oder KI-Agenten zu entwickeln und unzählige Anwendungsfälle existieren. Jede dieser Varianten bringt eigene Sicherheitsaspekte mit sich, die Sie berücksichtigen müssen.

Was kann ich tun, um Chatbot-Risiken zu vermeiden?

Sicherheit ist ein zentraler Bestandteil Ihres Chatbot-Projekts – Ihre Sicherheitsstrategie darf nicht halbherzig sein.

Wenn Sie sich unsicher fühlen, holen Sie sich einen Experten dazu. Die meisten Unternehmen, die Chatbots entwickeln und einsetzen, werden von KI-Partnern unterstützt: Organisationen mit Erfahrung in bestimmten KI-Projekten. Wenn Sie einen Chatbot bauen, werfen Sie einen Blick auf unsere Liste zertifizierter Experten – hier finden Sie Freelancer und Agenturen, die sich mit dem Aufbau, der Bereitstellung und Überwachung sicherer Chatbots auskennen.

Alternativ können Sie sich selbst über die relevanten Risiken informieren und alle notwendigen Schritte unternehmen, um unerwünschte Folgen zu verhindern.

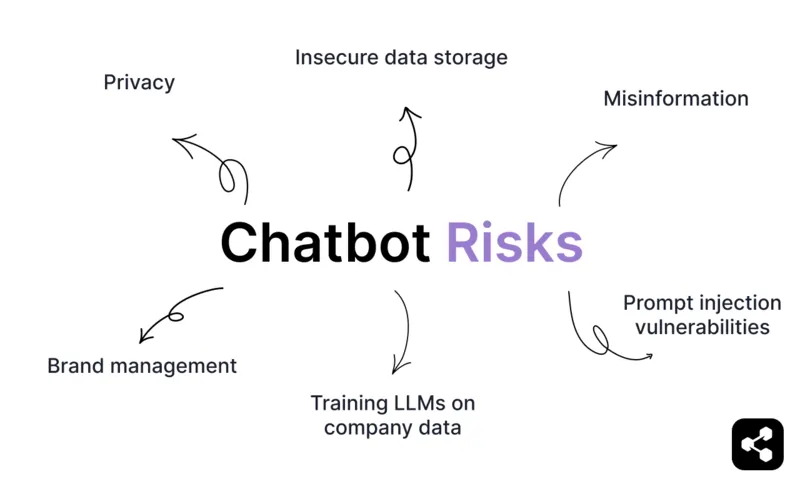

Ich habe es Ihnen etwas leichter gemacht und die häufigsten Sicherheitsrisiken von Chatbots zusammengestellt – inklusive Informationen, wie Sie jedes Risiko angehen können.

Chatbot-Risiken

Datenschutz & vertrauliche Informationen

Chatbots verarbeiten häufig persönliche Daten wie Namen, E-Mail-Adressen oder Finanzinformationen. Das bedeutet, sie stellen ein Datenschutzrisiko dar, wenn sie sensible Nutzerdaten ohne ausreichende Schutzmaßnahmen verarbeiten.

Dies ist besonders wichtig bei medizinischen Chatbots, Chatbots, die Zahlungen abwickeln, Finanz-Chatbots, Banking-Chatbots oder allen Unternehmens-Chatbots, die mit sensiblen Daten arbeiten.

Werden diese Daten unsicher gespeichert oder unverschlüsselt übertragen, sind sie anfällig für Datenlecks – und Unternehmen setzen sich erheblichen rechtlichen, finanziellen und Reputationsrisiken aus.

Fehlinformationen und Halluzinationen

Chatbots, die von LLMs betrieben werden, laufen – wenn sie nicht korrekt gebaut sind – Gefahr, Fehlinformationen zu verbreiten.

Ein Beispiel ist das berüchtigte Air Canada Chatbot-Fiasko. Ein Passagier erhielt vom Chatbot der Unternehmenswebsite die Information, dass er nach dem Tod seiner Großmutter einen Antrag auf Trauertarife für einen Flug stellen könne.

Als der Kunde die Erstattung beantragte, wurde ihm mitgeteilt, dass die Regelung nur für noch nicht angetretene Reisen gilt. Das Unternehmen gab zu, dass der Chatbot „irreführende Aussagen“ gemacht hatte, und der Fall landete vor Gericht.

Solche Halluzinationen sind nicht nur peinlich für Marken – sie kosten auch Geld.

Es ist jedoch möglich, Chatbots zu entwickeln, die beim Thema bleiben und die Marke korrekt repräsentieren. Einer unserer Kunden, eine Plattform für Gesundheitscoaching, konnte mit einem Chatbot den manuellen Support um 65 % reduzieren. In über 100.000 Gesprächen gab es keine Halluzinationen.

Wie das geht? Retrieval-augmented generation (RAG) spielt bei den meisten Unternehmens-Chatbots eine wichtige Rolle. Anstatt freie Antworten zu generieren, kombiniert RAG die generativen Fähigkeiten des Chatbots mit einer Datenbank aus geprüften, aktuellen Informationen. So sind die Antworten in der Realität verankert und beruhen nicht auf Annahmen oder Vermutungen.

Unternehmens-Chatbots verfügen über weitere Sicherheitsmechanismen, die vor dem öffentlichen Einsatz notwendig sind – dazu gleich mehr.

Unsichere Datenspeicherung

Wenn Ihr Chatbot Daten auf Servern oder in einer Cloud speichert, können unzureichende Sicherheitsprotokolle zu Datenlecks führen.

Veraltete Software, falsch konfigurierte Server oder unverschlüsselte Daten können von Angreifern ausgenutzt werden, um auf sensible Nutzerinformationen zuzugreifen.

Beispielsweise speichern manche Chatbots Datensicherungen ohne ausreichende Verschlüsselung, wodurch sie beim Transfer oder durch unbefugten Zugriff abgefangen werden können.

Prompt-Injection-Schwachstellen & schädliche Ausgaben

Ein schwacher Chatbot kann anfällig für schädliche Eingaben sein.

Wenn Ihr Chatbot zum Beispiel beim Autoverkauf hilft, möchten Sie nicht, dass er einen Truck für 1 Dollar verkauft. (Siehe den berüchtigten Chevy Tahoe-Vorfall.)

Chatbots können schädliche oder unsinnige Antworten liefern, wenn ihre Ausgaben nicht ausreichend kontrolliert werden. Solche Fehler entstehen durch fehlende Schutzmechanismen, mangelnde Validierungsprüfungen oder Manipulation durch Nutzer.

Dieses Risiko lässt sich jedoch relativ leicht vermeiden. Starke Chatbots nutzen Konversationsschutzmechanismen, um Off-Topic- oder markenfremde Gespräche schon im Vorfeld zu verhindern.

LLMs mit Unternehmensdaten trainieren

Das Training von Chatbots mit Unternehmensdaten kann Datenschutz- und Sicherheitsrisiken bergen, insbesondere bei allgemeinen Plattformen wie ChatGPT. Bei der Nutzung von Unternehmensinformationen mit solchen Chatbots besteht immer das Risiko eines Datenlecks.

Eigene Chatbots machen es hingegen deutlich einfacher, Ihre Daten zu schützen. Unternehmensgerechte Chatbot-Plattformen sind in der Regel mit Fokus auf Datenisolation und Sicherheit entwickelt. Diese Chatbots werden in kontrollierten Umgebungen trainiert, was das Risiko von Datenlecks erheblich reduziert.

Markenführung

Die größten öffentlichen Chatbot-Pannen drehen sich um Markenführung. Wie gut repräsentiert Ihr Chatbot Ihre Marke? Das ist ein zentraler Aspekt der Chatbot-Sicherheit.

Chatbots sind oft der erste Kontaktpunkt für Ihre Kunden. Sind die Antworten ungenau, unangemessen oder nicht im richtigen Ton, kann das dem Ruf Ihrer Marke schaden.

Auch dieses Risiko lässt sich mit Konversationsschutzmechanismen und durchdachtem Konversationsdesign vermeiden.

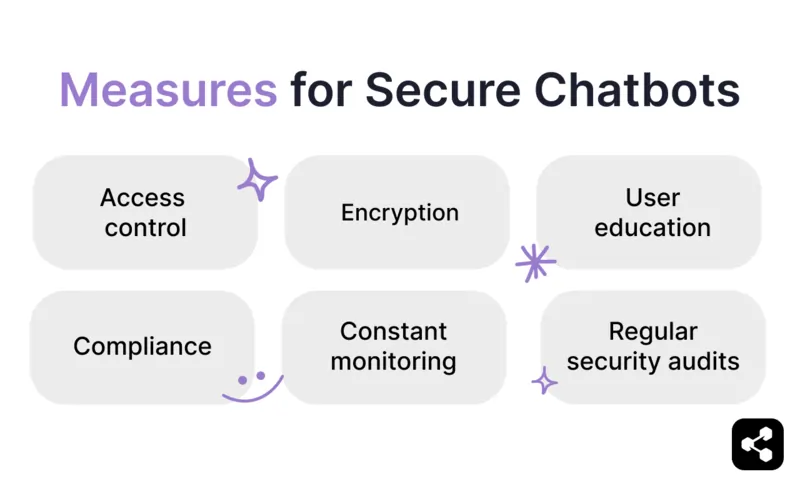

Notwendige Schutzmaßnahmen für sichere Chatbots

Zugriffskontrolle & sichere Nutzerzugänge

Wenn das Tool von vielen genutzt wird, sollen nicht alle denselben Zugriff haben.

Authentifizierung prüft, wer der Nutzer ist – so wird sichergestellt, dass nur berechtigte Personen sich anmelden können. Nach der Authentifizierung legt Autorisierung fest, was jeder Nutzer je nach Rolle oder Berechtigung tun darf.

Ein zentraler Bestandteil ist rollenbasierte Zugriffskontrolle (RBAC), die sicherstellt, dass Nutzer nur auf die Informationen und Funktionen zugreifen, die sie für ihre Aufgaben benötigen. Das bedeutet:

- Zugriff auf sensible Daten nur für autorisiertes Personal.

- Bearbeitungsrechte für den Chatbot nur für Administratoren.

- Klare und durchsetzbare Nutzerrollen mit definierten Berechtigungen.

Durch die Kombination von RBAC mit sicherer Authentifizierung und Autorisierungsprotokollen minimieren Sie Risiken wie unbefugten Zugriff, Datenlecks und versehentliche Fehlbedienung. Das ist eine einfache, aber essenzielle Schutzmaßnahme für den sicheren Einsatz von Chatbots.

Regelmäßige Sicherheitsüberprüfungen

Wie jede leistungsstarke Software sollte auch Chatbot-Software regelmäßig auf Sicherheit überprüft werden.

Regelmäßige Sicherheitsüberprüfungen sind umfassende Analysen der Architektur, Konfigurationen und Prozesse Ihres Chatbots, um sicherzustellen, dass sie den Sicherheitsstandards und Best Practices der Branche entsprechen.

Solche Überprüfungen beinhalten in der Regel das Testen auf Schwachstellen – wie schwache Authentifizierungsprotokolle, falsch konfigurierte Server oder offene APIs – sowie die Bewertung der Wirksamkeit bestehender Sicherheitsmaßnahmen wie Verschlüsselung und Zugriffskontrollen.

Überprüfungen bewerten auch die Einhaltung von Datenschutzvorschriften, sodass Ihr Chatbot beispielsweise den Vorgaben von DSGVO oder SOC 2 entspricht.

Zu diesem Prozess gehören oft:

- Penetrationstests zur Simulation möglicher Angriffe

- Code-Reviews zur Aufdeckung versteckter Schwachstellen

- Überwachung auf ungewöhnliche Aktivitäten

Sicherheitsüberprüfungen sind eine proaktive Maßnahme, um die Widerstandsfähigkeit Ihres Chatbots gegen Bedrohungen zu bewerten und seine Fähigkeit zum sicheren Umgang mit sensiblen Informationen zu überprüfen.

Verschlüsselung

Verschlüsselung ist der Prozess, Daten in ein sicheres Format umzuwandeln, um unbefugten Zugriff zu verhindern. Bei sensiblen Daten gibt es zwei Hauptarten: Verschlüsselung ruhender Daten, die gespeicherte Informationen schützt, und Verschlüsselung während der Übertragung, die Daten absichert, während sie übertragen werden.

Die Verwendung starker Verschlüsselungsprotokolle wie AES (Advanced Encryption Standard) stellt sicher, dass abgefangene Daten unlesbar bleiben.

Für Chatbots, die mit sensiblen Informationen arbeiten, ist Verschlüsselung eine unverzichtbare Schutzmaßnahme, um die Privatsphäre der Nutzer zu wahren und Sicherheitsstandards einzuhalten.

Ständige Überwachung

Unsere Platform-as-a-Service empfiehlt drei Phasen bei der Einführung eines Chatbots: Entwicklung, Bereitstellung und Überwachung.

Kunden vergessen bei der Planung oft die letzte Phase, dabei ist die Überwachung der wichtigste Schritt.

Dazu gehören:

- Überwachung von Leistungskennzahlen

- Erkennung von Schwachstellen

- Behebung von Problemen wie Halluzinationen oder Datenlecks

Regelmäßige Updates und Tests helfen, Ihren Chatbot an neue Bedrohungen anzupassen und die Einhaltung von Branchenvorschriften sicherzustellen.

Ohne angemessene Überwachung kann selbst der bestentwickelte Chatbot mit der Zeit zum Risiko werden.

Compliance

Wenn Ihr Chatbot mit sensiblen Daten arbeitet, müssen Sie eine Plattform wählen, die wichtige Compliance-Frameworks erfüllt.

Die gängigsten und relevantesten Compliance-Frameworks sind:

- GDPR: Datenschutz-Grundverordnung

- CCPA: California Consumer Privacy Act

- HIPAA: Health Insurance Portability and Accountability Act

- SOC 2: System and Organization Controls 2

Wenn Sie Daten von Personen aus der EU verarbeiten, benötigen Sie einen GDPR-konformen Chatbot.

Für vollständige Compliance benötigen Sie sowohl a) eine Plattform, die die entsprechenden Vorgaben einhält, als auch b) Maßnahmen Ihrer Chatbot-Entwickler (z. B. wie Sie mit den empfangenen Daten umgehen).

Nutzeraufklärung

Manchmal liegt das Problem nicht an der Technologie, sondern am fehlenden Verständnis der Nutzer.

Ein wichtiger Teil bei der Einführung von Chatbot-Technologie ist es, Ihre Mitarbeitenden angemessen auf neue Risiken und Herausforderungen vorzubereiten (neben den zahlreichen Vorteilen).

Schulen Sie Ihre Mitarbeitenden darin, wie sie den Chatbot sicher in ihre Arbeit integrieren, ohne das Ansehen Ihres Unternehmens zu gefährden. Im Idealfall ist Ihr Chatbot mit ausreichenden Schutzmechanismen ausgestattet, sodass eine Fehlanwendung nahezu ausgeschlossen ist.

Setzen Sie auf den sichersten Chatbot am Markt

Sicherheit sollte bei der Investition in einen Chatbot für Ihr Unternehmen oberste Priorität haben.

Botpress ist eine KI-Agenten- und Chatbot-Plattform, die von 35 % der Fortune 500-Unternehmen genutzt wird. Unsere hochmoderne Sicherheitslösung ermöglicht maximale Kontrolle über Ihre KI-Tools.

Unser privates LLM-Gateway, Privacy Shield, integrierter Sicherheitsagent und Framework zum Markenschutz sorgen dafür, dass unsere Kunden das sicherste Chatbot-Erlebnis am Markt erhalten.

Jetzt starten. Kostenlos.

Oder vereinbaren Sie ein Gespräch mit unserem Team, um loszulegen.

FAQs

1. Wie speichern Chatbots Daten?

Chatbots speichern Daten in sicheren, meist cloudbasierten Datenbanken – verschlüsselt sowohl im Ruhezustand als auch während der Übertragung. Die gespeicherten Daten können Gesprächsprotokolle und Metadaten umfassen und sind oft so strukturiert, dass sie Personalisierung oder regulatorische Anforderungen unterstützen.

2. Wie kann ich einen sicheren Chatbot gewährleisten?

Für einen sicheren Chatbot sollten Sie HTTPS für alle Verbindungen nutzen, gespeicherte Daten verschlüsseln, API-Aufrufe authentifizieren und Zugriffe mit rollenbasierten Berechtigungen einschränken. Außerdem sollten Sie das System regelmäßig prüfen und Datenschutzgesetze wie GDPR oder HIPAA einhalten.

3. Was bedeutet Chatbot-Sicherheit?

Chatbot-Sicherheit umfasst Maßnahmen, die Nutzer und Systeme vor Risiken wie Datenlecks, Fehlinformationen, Social-Engineering-Angriffen oder Missbrauch schützen. Dazu gehören Inhaltsfilter, gesicherte Datenkanäle, Eingabevalidierung und die Möglichkeit, bei Bedarf auf menschliche Unterstützung zurückzugreifen.

4. Was ist der sicherste Chatbot?

Der sicherste Chatbot ist einer, der mit Ende-zu-Ende-Verschlüsselung, strikten Zugriffskontrollen, On-Premise- oder Private-Cloud-Optionen und der Einhaltung von Zertifizierungen wie SOC 2, ISO 27001 oder HIPAA betrieben wird.

.webp)