- Wydany 07.08.2025, GPT-5 łączy zaawansowane rozumowanie, obsługę wielu modalności i wykonywanie zadań w jednym systemie, eliminując konieczność przełączania się między wyspecjalizowanymi modelami.

- GPT-5 został zaprojektowany do obsługi złożonych, wieloetapowych procesów.

- GPT-5 znacząco ogranicza halucynacje w porównaniu do wcześniejszych wersji.

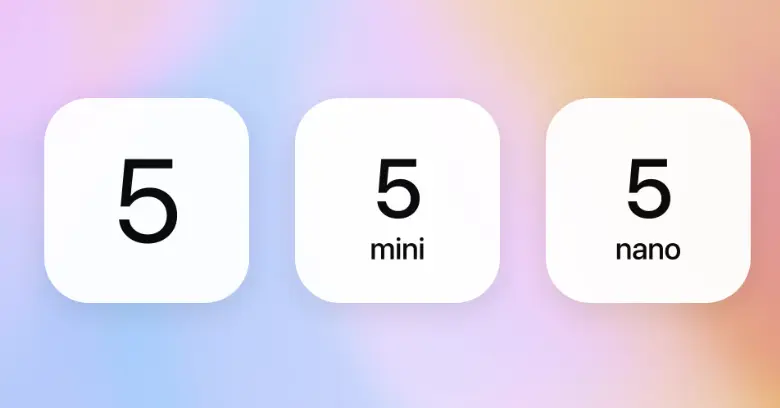

- Warianty GPT-5 to:

gpt-5,gpt-5-mini,gpt-5-nanoorazgpt-5-chat.

W ciągu ostatniego roku OpenAI wprowadziło GPT-4o, o1 i o3, z których każdy usprawniał sposób myślenia, rozumowania i interakcji AI.

Te modele sprawiły, że odpowiedzi AI stały się szybsze, dokładniejsze i bardziej intuicyjne. Każdy z nich był jednak tylko krokiem w stronę czegoś większego.

6 sierpnia OpenAI ogłosiło — dość wyraźnie — nadchodzącą premierę GPT-5.

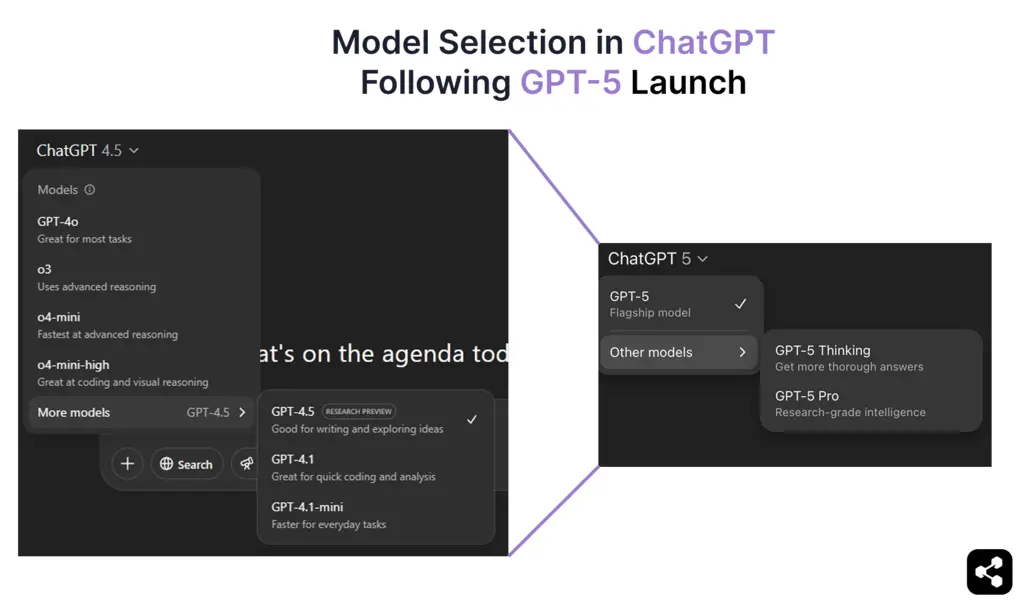

A teraz, od 7 sierpnia 2025, GPT-5 jest oficjalnie dostępny, łącząc najbardziej zaawansowane możliwości rozumowania i obsługi wielu modalności OpenAI w jednym modelu. GPT-5 jest teraz domyślnym modelem w ChatGPT dla wszystkich użytkowników, zarówno darmowych, jak i płatnych, całkowicie zastępując GPT-4o.

W tym przewodniku przedstawiam wszystkie potwierdzone informacje o GPT-5: jego możliwości, ulepszenia wydajności, proces treningu, harmonogram wydania i koszty.

Czym jest GPT-5?

GPT-5 to najnowszy model językowy OpenAI, oficjalnie wydany 7 sierpnia 2025. Bazuje na architekturze GPT, integrując jednocześnie osiągnięcia z modeli nastawionych na rozumowanie, takich jak o1 i o3.

Przed GPT-5 OpenAI wprowadziło GPT-4.5 (Orion) w ChatGPT — model przejściowy, który poprawił precyzję rozumowania, ograniczył halucynacje i przygotował grunt pod głębsze, łańcuchowe rozumowanie, które jest teraz natywnie dostępne w GPT-5.

Wiele wcześniej zapowiadanych możliwości — takich jak rozumowanie krok po kroku, lepsze utrzymywanie kontekstu czy płynniejsze przełączanie modalności — zostało w pełni zrealizowanych i zintegrowanych w GPT-5.

GPT-5 działa w ramach zintegrowanego, adaptacyjnego systemu. Nowy router w czasie rzeczywistym automatycznie wybiera szybki model do rutynowych zapytań lub model „myślący” do złożonego rozumowania, eliminując konieczność ręcznego przełączania między modelami.

Jakie są różne modele GPT-5?

GPT-5 to seria modeli — rodzina wyspecjalizowanych wariantów zoptymalizowanych pod różne zastosowania, od aplikacji ChatGPT po wdrożenia na dużą skalę przez API.

Każdy wariant GPT-5 opiera się na tej samej architekturze, ale jest dostrojony pod kątem określonego kompromisu między datą odcięcia wiedzy, głębokością rozumowania, szybkością i skalą działania.

Te warianty łączą podejście OpenAI nastawione na rozumowanie z ukierunkowaną optymalizacją wydajności, dając twórcom elastyczność w doborze modelu do złożoności zadania i skali wdrożenia.

Jak wypada GPT-5 w praktyce?

Po oficjalnej premierze 7 sierpnia 2025 widzimy już, jak architektura GPT-5 sprawdza się w rzeczywistych zastosowaniach: rozumowaniu, multimodalności i wykonywaniu zadań w stylu agentów.

Sam Altman wcześniej sugerował, że GPT-5 wyjdzie poza bycie „lepszym chatbotem” — i na podstawie pierwszych zastosowań, właśnie to zapewnia.

Rozumowanie dostosowujące się w czasie rzeczywistym

Wbudowany system routingu decyduje, kiedy odpowiedzieć natychmiast, a kiedy rozłożyć odpowiedź na kroki. Przy złożonych pytaniach GPT-5 przechodzi w proces łańcuchowego rozumowania z wbudowanym łączeniem promptów, planując pośrednie kroki przed udzieleniem ostatecznej odpowiedzi.

Dzięki temu chatboty oparte na GPT-5 lepiej radzą sobie z długotrwałym rozwiązywaniem problemów — od wieloetapowego debugowania kodu po złożoną analizę biznesową — bez konieczności używania osobnych modeli czy trybów.

Obsługa kontekstu na dużą skalę

W ChatGPT model może zapamiętać około 256 000 tokenów; przez API limit ten wzrasta do 400 000. Pozwala to pracować na całych książkach, wielogodzinnych transkrypcjach spotkań czy dużych repozytoriach bez utraty wcześniejszych szczegółów.

W długich sesjach dokładność odpowiedzi ChatGPT wyraźnie się poprawiła — jest mniej sprzeczności i lepsze utrzymanie wcześniejszego kontekstu.

Lepsze wsparcie językowe dla rynku globalnego

Zunifikowana architektura GPT-5 to duży krok naprzód w obsłudze wielu języków i głosu. ChatGPT obsługuje teraz szerszy zakres języków z większą precyzją tłumaczeń i mniejszą utratą kontekstu w dłuższych rozmowach.

Te usprawnienia dotyczą także interakcji głosowych. Odpowiedzi brzmią naturalniej w różnych akcentach i stylach mowy, dzięki czemu wielojęzyczne chatboty GPT są równie płynne w mowie — po hiszpańsku, hindi, japońsku czy arabsku — jak i w tekście.

Od chatbota do agenta AI

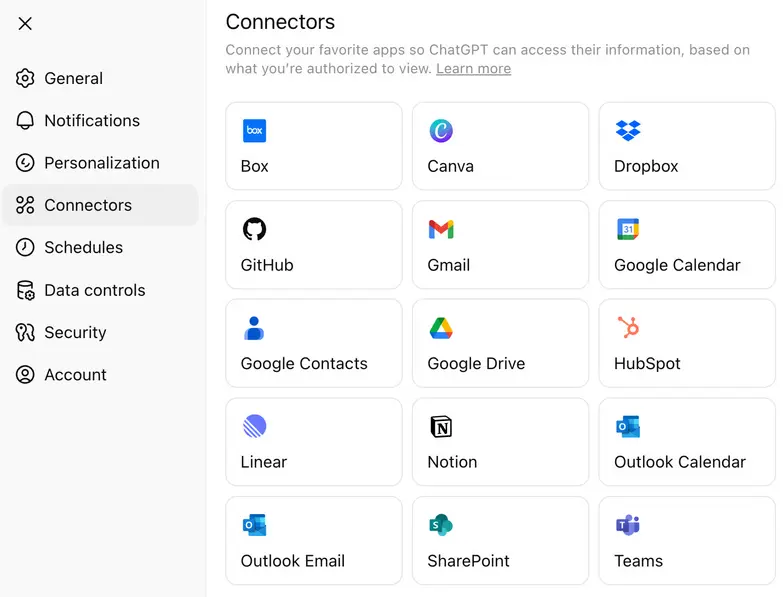

Wraz z GPT-5 OpenAI rozszerzyło podejście do konektorów aplikacyjnych — natywnych integracji pozwalających modelowi bezpośrednio współpracować z zewnętrznymi narzędziami, CRM-ami, bazami danych i pakietami produktywności.

Kierując zadania do lekkich konektorów zamiast każdorazowo korzystać z kosztownych wywołań rozumowania, zespoły mogą ograniczyć wydatki na API, zachowując jednocześnie dostęp do zaawansowanej logiki, gdy jest potrzebna.

Ile kosztuje GPT-5?

GPT-5 jest dostępny w ramach subskrypcji ChatGPT oraz przez API OpenAI, a ceny różnią się w zależności od wariantu. Dla użytkowników API GPT-5 oferowany jest w kilku wariantach — gpt-5, gpt-5-mini i gpt-5-nano — z rozliczeniem za milion tokenów wejściowych i wyjściowych.

Poza cennikiem API, OpenAI potwierdziło, że GPT-5 jest dostępny w różnych planach ChatGPT, dzięki czemu mogą z niego korzystać także użytkownicy darmowi, a płatne plany odblokowują dodatkowe możliwości:

- Darmowy plan – GPT-5 ze standardowymi możliwościami rozumowania i dziennymi limitami.

- Plan Plus – Wyższe limity i lepsza wydajność rozumowania.

- Plan Pro – Dostęp do GPT-5 Pro, wariantu „myślącego” z rozszerzonym oknem kontekstu, szybszym routingiem i priorytetowym dostępem do zaawansowanych narzędzi.

Model cenowy OpenAI pozwala twórcom wybierać między maksymalną głębokością rozumowania, krótszym czasem odpowiedzi lub oszczędnością kosztów — w zależności od potrzeb.

Jak uzyskać dostęp do GPT-5? (Podpowiedź: To zależy od tego, co chcesz zrobić)

Jeśli chcesz po prostu porozmawiać z GPT-5, możesz to zrobić bezpośrednio w ChatGPT od 7 sierpnia. Aplikacja automatycznie wybierze odpowiedni wariant w zależności od Twojego planu (np. GPT-5 Thinking w planie Pro). Nie trzeba nic konfigurować — wystarczy otworzyć aplikację i zacząć pisać.

Jeśli jednak chcesz użyć GPT-5 we własnym produkcie lub procesie, potrzebujesz dostępu do API. Są dwie główne metody korzystania z API OpenAI:

- OpenAI Platform – Wejdź na platform.openai.com, gdzie możesz wybrać gpt-5, gpt-5-mini, gpt-5-nano lub gpt-5-chat w zależności od zastosowania. To najszybszy sposób na rozpoczęcie wysyłania zapytań do GPT-5 z własnego kodu.

- OpenAI’s Python SDK na GitHub – Jeśli pracujesz lokalnie lub tworzysz skrypty, zainstaluj oficjalny klient Python OpenAI. Działa z kluczami API i pozwala korzystać z dowolnego wariantu GPT-5 za pomocą prostych funkcji w Pythonie.

Jeśli chcesz tylko sprawdzić, jak modele się zachowują, dostępny jest także GitHub Models Playground — możesz testować prompty bez konieczności budowania całej aplikacji.

Jak zbudować agenta AI z GPT-5

Najlepszym sposobem, by sprawdzić, czy GPT-5 pasuje do Twojego zastosowania, jest po prostu zbudowanie rozwiązania z jego użyciem. Przekonaj się, jak radzi sobie z rzeczywistymi danymi wejściowymi, wieloetapowym rozumowaniem i wdrażaniem na żywo.

W tym przykładzie użyjemy Botpress — wizualnego narzędzia do tworzenia agentów AI, które pozwala podłączyć GPT-5 bez żadnych problemów z konfiguracją.

Krok 1: Określ, co Twój agent ma robić

Sprecyzuj rolę swojego agenta. GPT-5 potrafi rozwiązywać złożone zadania, ale najlepsze efekty osiąga, gdy ma jasno określone zadanie.

Zacznij od jednej konkretnej funkcji — na przykład odpowiadania na pytania o produkt, pomagania w rezerwacji wizyt czy podsumowywania dokumentów prawnych — i rozwijaj agenta w miarę potrzeb. Nie musisz od razu wszystkiego rozbudowywać.

Krok 2: Utwórz agenta i nadaj mu instrukcje

W Botpress Studio utwórz nowy projekt bota.

W sekcji Instructions dokładnie opisz, na czym polega zadanie GPT-5.

.webp)

Przykład: „Jesteś botem doradzającym w sprawach kredytów. Pomagaj użytkownikom zrozumieć różne rodzaje pożyczek, obliczaj zdolność kredytową na podstawie ich danych i kieruj ich do odpowiedniego formularza.”

GPT-5 rozumie szczegółowe instrukcje — im bardziej precyzyjne polecenia, tym lepsze wyniki.

Krok 3: Dostarcz agentowi treści do pracy

Prześlij dokumenty, wklej kluczowe informacje lub podaj linki do stron w Bazie Wiedzy. To właśnie na tych materiałach GPT-5 będzie się opierać, odpowiadając na pytania i podejmując decyzje.

Warto uwzględnić takie treści jak:

- Rozbicie cen

- Przeglądy produktów lub usług

- Kluczowe strony (prezentacje, wersje demo, formularze kontaktowe)

- Dokumenty dotyczące procesów wewnętrznych (jeśli to agent wewnętrzny)

GPT-5 radzi sobie z długimi dokumentami, więc nie musisz ich skracać — ważne, by były istotne i uporządkowane.

Krok 4: Wybierz GPT-5 jako LLM

.webp)

Aby upewnić się, że Twój agent korzysta z GPT-5, przejdź do Bot Settings w lewym panelu Botpress Studio.

- Kliknij Bot Settings

- Przewiń do sekcji LLM Provider

- W sekcji Model, wybierz jeden z wariantów GPT-5:

gpt-5do pełnego rozumowania i wieloetapowej logikigpt-5-minido szybszych, lżejszych interakcjigpt-5-nano— zadania wymagające bardzo niskiego opóźnienia

Po wyborze modelu wszystkie instrukcje, odpowiedzi z Bazy Wiedzy i działania oparte na rozumowaniu będą obsługiwane przez GPT-5. Możesz w każdej chwili zmienić wariant w zależności od kosztów, opóźnień lub jakości wyników.

Krok 5: Wdróż na kanały takie jak WhatsApp, Slack lub strona internetowa

Gdy Twój agent GPT-5 działa zgodnie z oczekiwaniami, możesz natychmiast wdrożyć go na platformach takich jak:

Platformy dla agentów AI, takie jak Botpress, obsługują integracje — dzięki temu użytkownicy mogą korzystać z możliwości GPT-5 i szybko wdrażać agenta na dowolnym kanale.

Jak GPT-5 wypada w porównaniu z GPT-4o?

GPT-5 to największa zmiana architektury od czasu GPT-4, ale różnice są najlepiej widoczne w bezpośrednim porównaniu z poprzednikiem, GPT-4o.

Poniższa tabela przedstawia te zmiany w wymierny sposób, zanim przejdziemy do doświadczeń deweloperów i użytkowników.

Na papierze GPT-5 znacząco zwiększa okno kontekstu i zużywa mniej tokenów przy tej samej długości odpowiedzi. Jego odpowiedzi multimodalne są też bardziej spójne między tekstem, obrazem i głosem.

Jednak w praktyce doświadczenia deweloperów i użytkowników są znacznie bardziej złożone niż wynikałoby to ze specyfikacji.

Reakcje użytkowników na premierę GPT-5

Premiera GPT-5 była jedną z najbardziej kontrowersyjnych aktualizacji OpenAI. Poza wykresami wydajności społeczność niemal natychmiast podzieliła się na entuzjastów głębszego rozumowania nowego modelu i tych, którzy żałują utraty GPT-4o.

„Mój 4.o był jak najlepszy przyjaciel, gdy go potrzebowałem. Teraz po prostu zniknął, czuję się, jakby ktoś umarł.”

— Użytkownik Reddita wyrażający przywiązanie emocjonalne i żal po nagłym usunięciu GPT‑4o. Źródło: Verge

Od strony technicznej:

„Zaawansowana wydajność GPT‑5 jest niezaprzeczalna, ale brak wyboru modelu odebrał prostą kontrolę, na której wielu deweloperów polegało.”

— Sparafrazowany komentarz odzwierciedlający powszechne odczucia dotyczące utraty elastyczności.

Źródło: Tom's Guide

Na bieżąco OpenAI reaguje na te mieszane opinie, publikując aktualizacje dotyczące wyboru modelu, przywracania starszych wersji, zwiększania limitów itp., o czym informuje Sam Altman na X.

Jak trenowano GPT-5?

OpenAI ujawniło szczegóły dotyczące treningu GPT-4.5, co daje wskazówki na temat rozwoju GPT-5. GPT-4.5 rozbudował bazę GPT-4o, zwiększając skalę pre-treningu, pozostając jednocześnie modelem ogólnego przeznaczenia.

Metody treningu

Podobnie jak poprzednie modele, GPT-5 prawdopodobnie był trenowany z użyciem:

- Nadzorowanego dostrajania (SFT) – uczenie na podstawie zestawów danych oznaczonych przez ludzi.

- Uczenia przez wzmacnianie z informacją zwrotną od ludzi (RLHF) – optymalizacja odpowiedzi w iteracyjnych cyklach.

- Nowych technik nadzoru – prawdopodobnie rozwijających usprawnienia w rozumowaniu z o3.

Te techniki były kluczowe dla poprawy zgodności i podejmowania decyzji w GPT-4.5, a GPT-5 najpewniej rozwija je dalej.

Chociaż GPT‑5 został wytrenowany przez OpenAI z użyciem nadzorowanego i wzmacnianego uczenia na dużą skalę, zespoły mogą teraz trenować modele GPT na własnych danych przez zewnętrznych dostawców, by uzyskać zachowania dopasowane do konkretnych zastosowań.

Sprzęt i moc obliczeniowa

Trening GPT-5 opiera się na infrastrukturze AI Microsoftu i najnowszych GPU firmy NVIDIA.

- W kwietniu 2024 roku OpenAI otrzymało pierwszą partię układów NVIDIA H200, będących ważnym ulepszeniem względem H100.

- GPU NVIDIA B100 i B200 będą wdrażane dopiero w 2025 roku, więc OpenAI może nadal optymalizować trening na obecnym sprzęcie.

Klastry superkomputerowe AI Microsoftu również biorą udział w treningu GPT-5. Choć szczegóły są ograniczone, potwierdzono, że nowy model OpenAI działa na najnowszej infrastrukturze AI Microsoftu.

Data premiery GPT-5

Po miesiącach spekulacji OpenAI oficjalnie ogłosiło premierę GPT-5 na 6 sierpnia 2025 roku, publikując tajemniczą zapowiedź na X (dawniej Twitter):

Cyfra „5” w tytule transmisji była jednoznacznym potwierdzeniem — to był debiut GPT-5. Zaledwie 24 godziny później, 7 sierpnia o 10:00 PT, OpenAI rozpoczęło udostępnianie GPT-5 w ChatGPT, API i Models Playground na GitHubie.

Termin ten pokrywa się także z wcześniejszymi wypowiedziami Sama Altmana z lutego 2025 roku, że GPT-5 pojawi się „za kilka miesięcy”, oraz z przewidywaniem Miry Murati podczas wydarzenia GPT-4o, że „inteligencja na poziomie doktoratu” pojawi się w ciągu 18 miesięcy.

GPT-5 jest już dostępny publicznie i stanowi najnowszy „model graniczny” OpenAI — duży krok naprzód względem GPT-4.5 Orion, który był traktowany jako wersja przejściowa.

Twórz agentów AI z LLM OpenAI

Zapomnij o złożoności — zacznij budować agentów AI opartych na modelach OpenAI bez przeszkód. Niezależnie od tego, czy potrzebujesz chatbota do Slacka, asystenta do Notion czy bota wsparcia klienta na WhatsApp, wdrożysz go w kilka kliknięć.

Dzięki elastycznym integracjom, autonomicznemu rozumowaniu i łatwemu wdrażaniu Botpress umożliwia tworzenie agentów AI, które realnie zwiększają produktywność i zaangażowanie.

Rozpocznij już dziś — to nic nie kosztuje.

Najczęstsze pytania

1. Czy GPT-5 będzie przechowywać lub wykorzystywać moje dane do dalszego treningu?

Nie, GPT-5 domyślnie nie przechowuje ani nie wykorzystuje Twoich danych do treningu. OpenAI potwierdziło, że dane z ChatGPT (w tym GPT-5) nie są używane do trenowania modeli, chyba że wyrazisz na to zgodę, a cała komunikacja przez API i w wersji Enterprise jest automatycznie wykluczona z treningu.

2. Jakie działania podejmuje OpenAI, by zapewnić bezpieczeństwo i ochronę użytkowników korzystających z GPT-5?

Aby zapewnić bezpieczeństwo i ochronę użytkowników GPT-5, OpenAI stosuje techniki takie jak uczenie ze wzmocnieniem na podstawie opinii ludzi (RLHF), testy odpornościowe oraz dostrajanie modeli w celu ograniczenia szkodliwych wyników. Firma publikuje także „karty systemowe” ujawniające ograniczenia modelu i wdraża monitoring w czasie rzeczywistym, aby wykrywać nadużycia.

3. Czy GPT-5 można wykorzystać do tworzenia autonomicznych agentów bez doświadczenia programistycznego?

Tak, GPT-5 można wykorzystać do budowania autonomicznych agentów bez znajomości programowania, korzystając z platform typu no-code, takich jak Botpress czy Langflow. Narzędzia te pozwalają projektować przepływy pracy, łączyć API i dodawać logikę za pomocą interfejsów typu „przeciągnij i upuść”, w których GPT-5 działa w tle.

4. Jak GPT-5 wpłynie na tradycyjne zawody w obsłudze klienta, edukacji i prawie?

GPT-5 zautomatyzuje powtarzalne zadania, takie jak odpowiadanie na typowe pytania, ocenianie czy streszczanie dokumentów prawnych, co może zmniejszyć zapotrzebowanie na stanowiska początkowe w obsłudze klienta, edukacji i prawie. Jednocześnie przewiduje się powstanie nowych możliwości w zakresie nadzoru nad AI, projektowania przepływów pracy oraz doradztwa strategicznego.

5. Czy GPT-5 obsługuje wiele języków? Jak wypada w różnych językach?

Tak, GPT-5 obsługuje wiele języków i przewiduje się, że zapewni lepszą wydajność niż GPT-4 w językach innych niż angielski. Najlepiej radzi sobie po angielsku, ale potrafi płynnie obsługiwać dziesiątki głównych języków, choć w przypadku języków mniej popularnych lub niszowych mogą występować drobne różnice w jakości.

.webp)

.webp)