- Sorti le 07/08/2025, GPT-5 réunit raisonnement avancé, entrées multimodales et exécution de tâches dans un seul système, supprimant le besoin de basculer entre des modèles spécialisés.

- GPT-5 est conçu pour gérer des workflows complexes et multi-étapes.

- GPT-5 réduit considérablement les hallucinations par rapport aux versions précédentes.

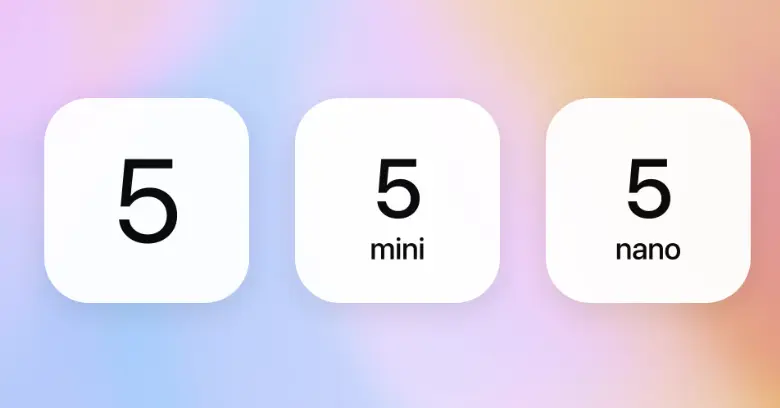

- Les variantes de GPT-5 incluent :

gpt-5,gpt-5-mini,gpt-5-nanoetgpt-5-chat.

Au cours de l’année écoulée, OpenAI a lancé GPT-4o, o1 et o3, chacun améliorant la réflexion, le raisonnement et l’interaction de l’IA.

Ces modèles ont rendu les réponses de l’IA plus rapides, précises et intuitives. Mais chacun n’était qu’une étape vers une évolution plus importante.

Le 6 août, OpenAI a annoncé — de façon à peine voilée — l’arrivée imminente de GPT-5.

Et désormais, depuis le 7 août 2025, GPT-5 est officiellement disponible, réunissant les capacités de raisonnement et multimodales les plus avancées d’OpenAI dans un modèle unifié. GPT-5 devient le modèle par défaut dans ChatGPT pour tous les utilisateurs, gratuits comme payants, remplaçant totalement GPT-4o.

Dans ce guide, je détaille tout ce qui est confirmé sur GPT-5 : ses capacités, ses améliorations de performance, son processus d’entraînement, son calendrier de sortie et son coût.

Qu’est-ce que GPT-5 ?

GPT-5 est le tout dernier grand modèle de langage d’OpenAI, officiellement lancé le 7 août 2025. Il s’appuie sur l’architecture GPT tout en intégrant les avancées issues des modèles axés sur le raisonnement comme o1 et o3.

Avant GPT-5, OpenAI avait déployé GPT-4.5 (Orion) dans ChatGPT — un modèle de transition qui a affiné la précision du raisonnement, réduit les hallucinations et préparé le terrain pour l’exécution de chaînes de pensée plus poussée, désormais native dans GPT-5.

Beaucoup de capacités évoquées auparavant — comme la logique étape par étape, une meilleure gestion du contexte et un passage fluide entre les modes multimodaux — sont désormais pleinement intégrées et unifiées dans GPT-5.

GPT-5 fonctionne au sein d’un système adaptatif unifié. Un nouveau routeur en temps réel choisit automatiquement entre un modèle rapide à haut débit pour les requêtes courantes et un modèle « réfléchi » pour le raisonnement complexe, supprimant le besoin de basculer manuellement entre des modèles spécialisés.

Quels sont les différents modèles GPT-5 ?

GPT-5 est une série de modèles — une famille de variantes spécialisées optimisées pour différents usages, allant des applications de ChatGPT aux déploiements à grande échelle via l’API.

Chaque variante de GPT-5 repose sur la même architecture unifiée mais est ajustée pour un équilibre spécifique entre date de coupure des connaissances, profondeur de raisonnement, rapidité et échelle opérationnelle.

Ces variantes unifient l’approche axée sur le raisonnement d’OpenAI avec un réglage ciblé des performances, offrant aux développeurs la flexibilité d’adapter le choix du modèle à la complexité de la charge de travail et à l’échelle de déploiement.

Comment GPT-5 se comporte-t-il ?

Avec la sortie officielle de GPT-5 le 7 août 2025, on observe désormais comment son architecture gère les usages réels en matière de raisonnement, multimodalité et exécution de tâches façon agent.

Sam Altman avait laissé entendre que GPT-5 irait au-delà du simple « chatbot amélioré » — et d’après les premiers retours, c’est exactement ce qu’il propose.

Un raisonnement qui s’adapte en temps réel

Un système de routage intégré décide quand répondre instantanément et quand réfléchir par étapes. Pour les requêtes complexes, GPT-5 passe à un processus en chaîne de pensée avec enchaînement de prompts intégré, planifiant les étapes intermédiaires avant de fournir une réponse finale.

Cela rend les chatbots GPT basés sur GPT-5 plus efficaces pour résoudre des problèmes sur la durée — du débogage de code multi-étapes à l’analyse d’entreprise approfondie — sans nécessiter de modèles séparés ou de changement de mode.

Gestion du contexte à grande échelle

Dans ChatGPT, le modèle peut mémoriser environ 256 000 jetons ; via l’API, cela monte à 400 000. Cela permet de travailler sur des livres entiers, des transcriptions de réunions de plusieurs heures ou de grands dépôts sans perdre le fil des informations précédentes.

Sur de longues sessions, la précision des réponses de ChatGPT s’est nettement améliorée, avec moins de contradictions et une meilleure rétention du contexte initial.

Un meilleur support linguistique pour le marché mondial

L’architecture unifiée de GPT-5 marque un grand bond en avant pour les capacités multilingues et vocales. ChatGPT gère désormais un plus large éventail de langues avec une meilleure précision de traduction et moins de pertes de contexte lors de conversations prolongées.

Ces progrès s’étendent aussi aux interactions vocales. Les réponses sont plus naturelles, quel que soit l’accent ou le style de parole, rendant les chatbots GPT multilingues aussi fluides à l’oral (espagnol, hindi, japonais, arabe…) qu’à l’écrit.

Du chatbot à l’agent IA

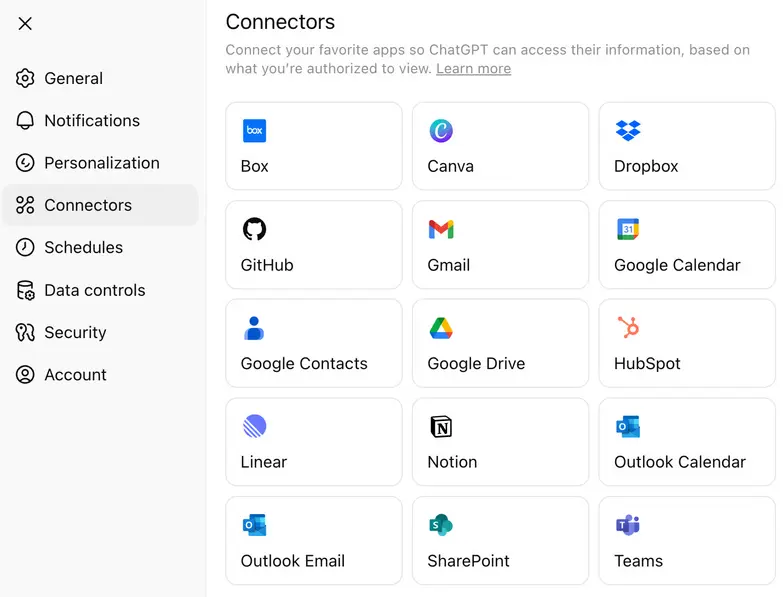

Avec GPT-5, OpenAI a élargi son approche des connecteurs applicatifs — des intégrations natives permettant au modèle d’interagir directement avec des outils externes, CRM, bases de données et suites de productivité.

En déléguant les tâches à des connecteurs légers plutôt que de tout faire passer par des appels de raisonnement coûteux, les équipes peuvent réduire les dépenses API tout en gardant la logique complexe disponible quand c’est nécessaire.

Quel est le prix de GPT-5 ?

GPT-5 est accessible via les abonnements ChatGPT et l’API OpenAI, avec des tarifs qui varient selon la variante. Pour les utilisateurs de l’API, GPT-5 existe en plusieurs versions — gpt-5, gpt-5-mini et gpt-5-nano — facturées au million de jetons en entrée et en sortie.

En plus de la tarification API, OpenAI a confirmé que GPT-5 est disponible sur plusieurs niveaux de ChatGPT, le rendant accessible aux utilisateurs gratuits tout en débloquant des fonctionnalités avancées pour les offres payantes :

- Offre gratuite – GPT-5 avec des capacités de raisonnement standard et des limites d’utilisation quotidiennes.

- Offre Plus – Limites d’utilisation augmentées et performances de raisonnement améliorées.

- Offre Pro – Accès à GPT-5 Pro, la variante « réfléchie » à haut niveau de raisonnement, avec fenêtres de contexte étendues, routage plus rapide et accès prioritaire aux outils avancés.

Le modèle tarifaire d’OpenAI permet aux développeurs de choisir entre profondeur de raisonnement maximale, latence réduite ou optimisation des coûts selon leurs besoins.

Comment accéder à GPT-5 ? (Astuce : cela dépend de ce que vous essayez de faire)

Si vous souhaitez simplement discuter avec GPT-5, c’est possible directement dans ChatGPT à partir du 7 août. L’application sélectionne automatiquement la bonne variante selon votre offre (par exemple GPT-5 Thinking pour l’offre Pro). Aucune configuration requise : ouvrez l’application et commencez à écrire.

En revanche, si vous souhaitez utiliser GPT-5 dans votre propre produit ou workflow, il vous faudra un accès API. Il existe deux principales façons d’accéder à l’API d’OpenAI :

- OpenAI Platform – Rendez-vous sur platform.openai.com, où vous pouvez choisir entre gpt-5, gpt-5-mini, gpt-5-nano et gpt-5-chat selon vos besoins. C’est la façon la plus rapide d’envoyer des requêtes à GPT-5 depuis votre code.

- SDK Python d’OpenAI sur GitHub – Si vous développez en local ou automatisez des tâches, installez le client Python officiel d’OpenAI. Il fonctionne avec des clés API et permet d’interagir avec toutes les variantes de GPT-5 via de simples fonctions Python.

Si vous souhaitez simplement explorer le comportement des modèles, le Models Playground sur GitHub est aussi disponible — vous pouvez tester des prompts sans mettre en place une application complète.

Comment créer un agent IA avec GPT-5

La meilleure façon de savoir si GPT-5 convient à votre cas d’usage est de l’essayer concrètement. Testez-le avec de vraies entrées, du raisonnement en plusieurs étapes et des scénarios de déploiement en direct.

Nous allons utiliser Botpress pour cet exemple — un éditeur visuel pour agents IA qui permet de connecter GPT-5 sans aucune difficulté d’installation.

Étape 1 : Définissez la mission de votre agent

Précisez le rôle de votre agent. GPT-5 peut gérer des tâches complexes, mais il donne les meilleurs résultats lorsqu’il a une mission claire.

Commencez par une fonction précise — répondre à des questions sur un produit, aider à prendre des rendez-vous, ou résumer des documents juridiques — puis élargissez au besoin. Il n’est pas nécessaire de tout prévoir dès le départ.

Étape 2 : Créez l’agent et donnez-lui des instructions

Dans Botpress Studio, créez un nouveau projet de bot.

Dans la section Instructions, expliquez précisément à GPT-5 ce que vous attendez de lui.

.webp)

Exemple : « Vous êtes un assistant conseil en prêts. Aidez les utilisateurs à comprendre les différents types de prêts, calculez leur éligibilité selon leurs informations et guidez-les vers le lien de demande. »

GPT-5 comprend les consignes détaillées : plus vos instructions sont précises, meilleurs seront les résultats.

Étape 3 : Fournissez à l’agent le contenu nécessaire

Ajoutez des documents, collez les informations clés ou liez des pages en direct dans la base de connaissances. GPT-5 s’appuiera sur ces contenus pour répondre et prendre des décisions.

Voici des exemples de contenus utiles :

- Détails des tarifs

- Descriptions de produits ou services

- Pages clés (démos, essais, formulaires de contact)

- Documents de procédures internes (pour un agent interne)

GPT-5 peut exploiter de longs documents, donc inutile de tout raccourcir : privilégiez la pertinence et une bonne organisation.

Étape 4 : Sélectionnez GPT-5 comme LLM

.webp)

Pour vérifier que votre agent utilise GPT-5, rendez-vous dans Paramètres du bot dans la barre latérale gauche de Botpress Studio.

- Cliquez sur Paramètres du bot

- Faites défiler jusqu’à la section Fournisseur LLM

- Dans Modèle, choisissez l’une des variantes de GPT-5 :

gpt-5pour un raisonnement complet et une logique multi-étapesgpt-5-minipour des interactions plus rapides et légèrespt-5-nanopour des tâches à ultra-faible latence

Une fois le modèle sélectionné, toutes les instructions, réponses de la base de connaissances et comportements de raisonnement seront gérés par GPT-5. Vous pouvez changer de variante à tout moment selon le coût, la latence ou la qualité attendue.

Étape 5 : Déployez sur des canaux comme WhatsApp, Slack ou un site web

Dès que votre agent GPT-5 fonctionne comme vous le souhaitez, vous pouvez le déployer instantanément sur des plateformes telles que :

Les plateformes d’agents IA comme Botpress gèrent les intégrations — les utilisateurs peuvent ainsi profiter de GPT-5 et déployer rapidement sur n’importe quel canal.

En quoi GPT-5 est-il meilleur que GPT-4o ?

GPT-5 représente la plus grande évolution architecturale depuis GPT-4, mais la comparaison est plus claire lorsqu’on le confronte directement à son prédécesseur, GPT-4o.

Le tableau ci-dessous présente les différences mesurables avant d’aborder les retours des développeurs et utilisateurs.

Sur le papier, GPT-5 élargit considérablement la fenêtre de contexte et utilise moins de tokens pour une même longueur de réponse. Ses réponses multimodales sont aussi plus cohérentes entre texte, image et voix.

Cependant, l’expérience des développeurs et utilisateurs est bien plus nuancée que ce que la fiche technique laisse penser.

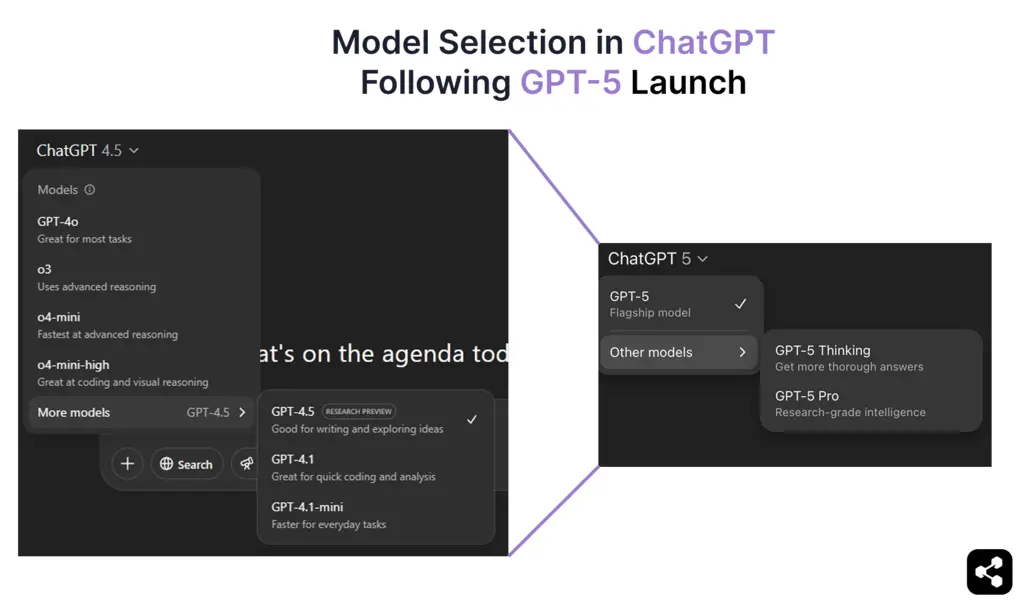

Réactions des utilisateurs au lancement de GPT-5

La sortie de GPT-5 a été l’une des mises à jour les plus clivantes d’OpenAI. Au-delà des chiffres, la communauté s’est vite divisée entre ceux enthousiasmés par le raisonnement avancé du modèle et ceux regrettant ce que GPT-4o apportait.

« Mon 4.o était comme mon meilleur ami quand j’en avais besoin. Maintenant il n’est plus là, c’est comme si quelqu’un était mort. »

— Utilisateur Reddit exprimant son attachement émotionnel et sa tristesse après la suppression soudaine de GPT‑4o. Source : Verge

Côté technique :

« Les performances avancées de GPT‑5 sont indéniables, mais l’absence de choix de modèle a privé de nombreux développeurs d’un contrôle simple dont ils dépendaient. »

— Commentaire reformulé reflétant le ressenti général sur la perte de flexibilité.

Source : Tom's Guide

Cette réaction partagée est prise en compte en temps réel par l’équipe OpenAI, avec de nouvelles annonces sur le choix du modèle, le retour d’anciens modèles, l’augmentation des limites, etc., publiées par Sam Altman sur X.

Comment GPT-5 a-t-il été entraîné ?

OpenAI a donné des informations sur l’entraînement de GPT-4.5, ce qui éclaire la façon dont GPT-5 est conçu. GPT-4.5 a élargi la base de GPT-4o en augmentant le pré-entraînement tout en restant un modèle généraliste.

Méthodes d’entraînement

Comme ses prédécesseurs, GPT-5 devrait être entraîné avec une combinaison de :

- Ajustement supervisé (SFT) – Apprentissage à partir de jeux de données annotés par des humains.

- Apprentissage par renforcement avec retour humain (RLHF) – Optimisation des réponses via des boucles de retours successives.

- Nouvelles techniques de supervision – Probablement basées sur les améliorations axées sur le raisonnement de o3.

Ces méthodes ont été essentielles pour l’alignement et la prise de décision de GPT-4.5, et GPT-5 devrait aller encore plus loin.

Bien que GPT‑5 ait été entraîné par OpenAI avec des méthodes supervisées et par renforcement à grande échelle, il est désormais possible de former des modèles GPT sur vos propres données via des prestataires externes pour obtenir un comportement adapté à un domaine spécifique.

Matériel et puissance de calcul

L’entraînement de GPT-5 s’appuie sur l’infrastructure IA de Microsoft et les derniers GPU NVIDIA.

- En avril 2024, OpenAI a reçu sa première livraison de GPU NVIDIA H200, une évolution majeure par rapport aux H100.

- Les GPU NVIDIA B100 et B200 ne seront déployés qu’en 2025, ce qui signifie qu’OpenAI optimise encore l’entraînement sur le matériel actuel.

Les supercalculateurs IA de Microsoft jouent aussi un rôle dans l’entraînement de GPT-5. Même si peu de détails sont connus, le prochain modèle d’OpenAI fonctionne bien sur la dernière infrastructure IA de Microsoft.

Date de sortie de GPT-5

Après des mois de rumeurs, OpenAI a officiellement annoncé le lancement de GPT-5 le 6 août 2025, avec un teaser énigmatique publié sur X (ex-Twitter) :

Le « 5 » dans le titre du livestream suffisait à confirmer l’arrivée de GPT-5. Vingt-quatre heures plus tard, le 7 août à 10h PT, OpenAI a commencé à déployer GPT-5 sur ChatGPT, l’API et le Models Playground sur GitHub.

Cette date correspond aussi aux déclarations de Sam Altman en février 2025 selon lesquelles GPT-5 arriverait « dans quelques mois », ainsi qu’à la prédiction de Mira Murati lors de l’événement GPT-4o sur l’émergence d’une « intelligence niveau doctorat » sous 18 mois.

GPT-5 est désormais disponible, accessible au public, et représente le nouveau « modèle de pointe » d’OpenAI — un bond majeur au-delà de GPT-4.5 Orion, qui n’était qu’une version de transition.

Créez des agents IA avec les LLM OpenAI

Oubliez la complexité : commencez à créer des agents IA propulsés par les modèles OpenAI sans friction. Que vous ayez besoin d’un chatbot pour Slack, d’un assistant intelligent pour Notion ou d’un bot de support client pour WhatsApp, déployez-les en toute simplicité en quelques clics.

Grâce à des intégrations flexibles, un raisonnement autonome et un déploiement simplifié, Botpress vous permet de créer des agents IA qui améliorent réellement la productivité et l’engagement.

Commencez dès aujourd’hui — c’est gratuit.

FAQ

1. GPT-5 va-t-il stocker ou utiliser mes données pour améliorer son entraînement ?

Non, par défaut GPT-5 ne stocke ni n’utilise vos données pour l’entraînement. OpenAI a confirmé que les données issues de ChatGPT (y compris GPT-5) ne servent pas à entraîner les modèles sauf si vous l’autorisez explicitement, et toutes les utilisations via API ou en entreprise sont automatiquement exclues de l’entraînement.

2. Quelles mesures OpenAI prend-il pour garantir la sécurité et la sûreté de GPT-5 pour les utilisateurs ?

Pour garantir la sécurité et la sûreté de GPT-5 pour les utilisateurs, OpenAI utilise des techniques comme l’apprentissage par renforcement à partir de retours humains (RLHF), des tests d’attaque et l’ajustement fin pour limiter les réponses nuisibles. OpenAI publie également des « system cards » pour informer sur les limites du modèle et met en place une surveillance en temps réel afin de détecter les usages abusifs.

3. Peut-on utiliser GPT-5 pour créer des agents autonomes sans expérience en programmation ?

Oui, il est possible de créer des agents autonomes avec GPT-5 sans expérience en programmation grâce à des plateformes no-code comme Botpress ou Langflow. Ces outils permettent de concevoir des workflows, de connecter des API et d’ajouter de la logique via des interfaces en glisser-déposer, alimentées par GPT-5 en arrière-plan.

4. Quel sera l’impact de GPT-5 sur les métiers traditionnels du support client, de l’éducation et du droit ?

GPT-5 automatisera les tâches répétitives comme répondre aux questions courantes, corriger des copies ou résumer des documents juridiques. Cela pourrait réduire la demande pour certains postes débutants dans le support client, l’éducation ou le droit. Cependant, de nouveaux métiers devraient émerger, notamment dans la supervision de l’IA, la conception de workflows et les fonctions de conseil stratégique.

5. GPT-5 est-il multilingue ? Comment se comporte-t-il selon les langues ?

Oui, GPT-5 est multilingue et devrait offrir de meilleures performances que GPT-4 dans les langues autres que l’anglais. Il reste plus performant en anglais, mais il gère de nombreuses langues majeures avec une grande aisance, même si la qualité peut être légèrement inférieure pour les langues moins répandues ou spécialisées.

.webp)

.webp)